深度学习---反向传播算法BP

BP神经网络的数学原理及其算法实现: http://blog.csdn.net/zhongkejingwang/article/details/44514073

脉络清晰的BP神经网络讲解:http://www.cnblogs.com/wengzilin/archive/2013/04/24/3041019.html

BP神经网络模型与学习算法:http://www.cnblogs.com/wentingtu/archive/2012/06/05/2536425.html

BP算法之一种直观的解释:http://www.cnblogs.com/daniel-D/archive/2013/06/03/3116278.html

梁斌博士BP算法浅谈:http://blog.csdn.net/pennyliang/article/details/

这个BP算法可以多看几遍,条理清晰

神经网络BP算法简单推导:http://liuli1735.github.io/2014/09/21/Neural-networks.html

Stanford机器学习---第五讲. 神经网络的学习 Neural Networks learning

http://blog.csdn.net/abcjennifer/article/details/7758797

如何直观的解释back propagation算法? : https://www.zhihu.com/question/27239198

关于第5周反向传播算法的一些争论与思考http://mooc.guokr.com/note/16702/

推导过程:

重点参考必看:

https://blog.csdn.net/fendouaini/article/details/79789440

https://blog.csdn.net/zhongkejingwang/article/details/44514073

https://zhuanlan.zhihu.com/p/24801814

在学习深度学习相关知识,无疑都是从神经网络开始入手,在神经网络对参数的学习算法bp算法,接触了很多次,每一次查找资料学习,都有着似懂非懂的感觉,这次趁着思路比较清楚,也为了能够让一些像我一样疲于各种查找资料,却依然懵懵懂懂的孩子们理解,参考了梁斌老师的博客BP算法浅谈(Error Back-propagation)(为了验证梁老师的结果和自己是否正确,自己python实现的初始数据和梁老师定义为一样!),进行了梳理和python代码实现,一步一步的帮助大家理解bp算法!

为了方便起见,这里我定义了三层网络,输入层(第0层),隐藏层(第1层),输出层(第二层)。并且每个结点没有偏置(有偏置原理完全一样),激活函数为sigmod函数(不同的激活函数,求导不同),符号说明如下:

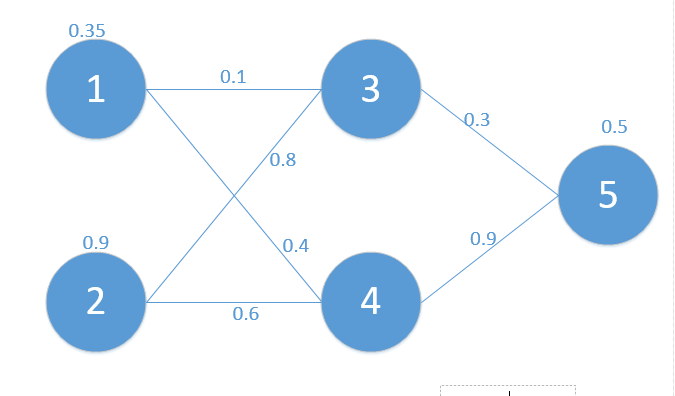

对应网络如下:

其中对应的矩阵表示如下:

其中对应的矩阵表示如下:

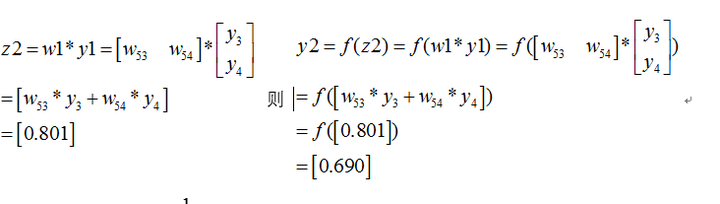

首先我们先走一遍正向传播,公式与相应的数据对应如下:

首先我们先走一遍正向传播,公式与相应的数据对应如下:

那么:

同理可以得到

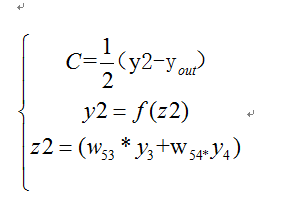

那么最终的损失为

那么最终的损失为

我们当然是希望这个值越小越好。这也是我们为什么要进行训练,调节参数,使得最终的损失最小。这就用到了我们的反向传播算法,实际上反向传播就是梯度下降法中(为什么需要用到梯度下降法,也就是为什么梯度的反方向一定是下降最快的方向,我会再写一篇文章解释,这里假设是对的,关注bp算法)链式法则的使用。

下面我们看如何反向传播

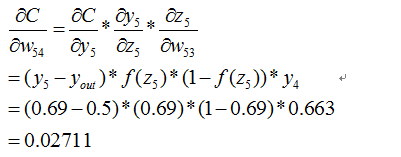

根据公式,我们有:

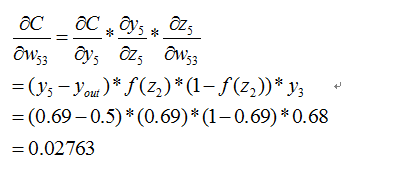

这个时候我们需要求出C对w的偏导,则根据链式法则有

这个时候我们需要求出C对w的偏导,则根据链式法则有

上面插入sigmod函数求导公式:

(在这里我们可以看到不同激活函数求导是不同的,所谓的梯度消失,梯度爆炸如果了解bp算法的原理,也是非常容易理解的!)

(在这里我们可以看到不同激活函数求导是不同的,所谓的梯度消失,梯度爆炸如果了解bp算法的原理,也是非常容易理解的!)

同理有

到此我们已经算出了最后一层的参数偏导了.我们继续往前面链式推导:

我们现在还需要求

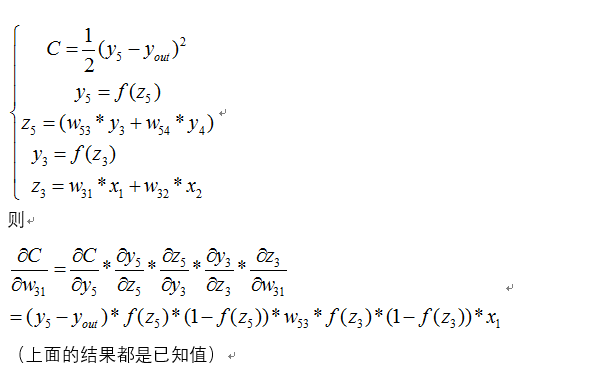

下面给出其中的一个推到,其它完全类似

下面给出其中的一个推到,其它完全类似  同理可得到其它几个式子:

同理可得到其它几个式子:

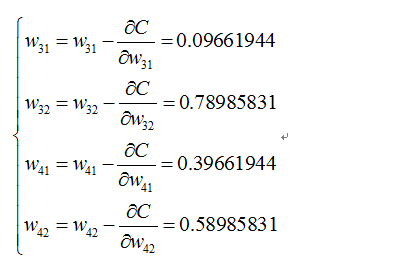

则最终的结果为:

再按照这个权重参数进行一遍正向传播得出来的Error为0.165

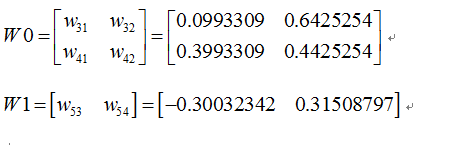

而这个值比原来的0.19要小,则继续迭代,不断修正权值,使得代价函数越来越小,预测值不断逼近0.5.我迭代了100次的结果,Error为5.92944818e-07(已经很小了,说明预测值与真实值非常接近了),最后的权值为:

好了,bp过程可能差不多就是这样了,可能此文需要你以前接触过bp算法,只是还有疑惑,一步步推导后,会有较深的理解。

好了,bp过程可能差不多就是这样了,可能此文需要你以前接触过bp算法,只是还有疑惑,一步步推导后,会有较深的理解。

中文版资料:链接:http://pan.baidu.com/s/1mi8YVri 密码:e7do

下面给出我学习bp时候的好的博客

Backpropagation (里面的插图非常棒,不过好像有点错误,欢迎讨论~)

A Neural Network in 11 lines of Python (Part 1)(非常赞的博客,每个代码一行一行解释)

Neural networks and deep learning (很好的深度学习入门书籍,实验室力推!我有中文翻译版,欢迎留言)

上面实现的python代码如下:

import numpy as npdef nonlin(x, deriv=False):if (deriv == True):return x * (1 - x) #如果deriv为true,求导数return 1 / (1 + np.exp(-x))X = np.array([[0.35],[0.9]]) #输入层

y = np.array([[0.5]]) #输出值np.random.seed(1)W0 = np.array([[0.1,0.8],[0.4,0.6]])

W1 = np.array([[0.3,0.9]])

print 'original ',W0,'\n',W1

for j in xrange(100):l0 = X #相当于文章中x0l1 = nonlin(np.dot(W0,l0)) #相当于文章中y1l2 = nonlin(np.dot(W1,l1)) #相当于文章中y2l2_error = y - l2Error = 1/2.0*(y-l2)**2print "Error:",Errorl2_delta = l2_error * nonlin(l2, deriv=True) #this will backpack#print 'l2_delta=',l2_deltal1_error = l2_delta*W1; #反向传播l1_delta = l1_error * nonlin(l1, deriv=True)W1 += l2_delta*l1.T; #修改权值W0 += l0.T.dot(l1_delta)print W0,'\n',W1推导过程2:

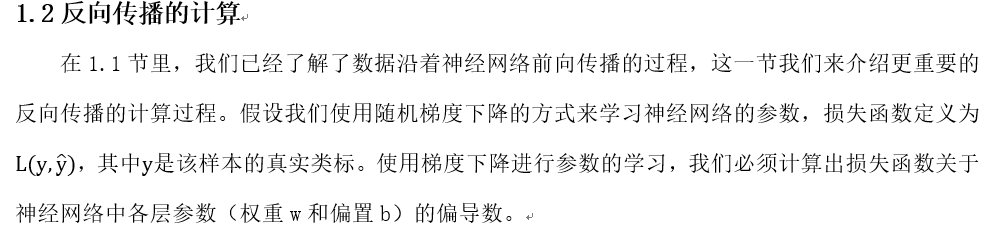

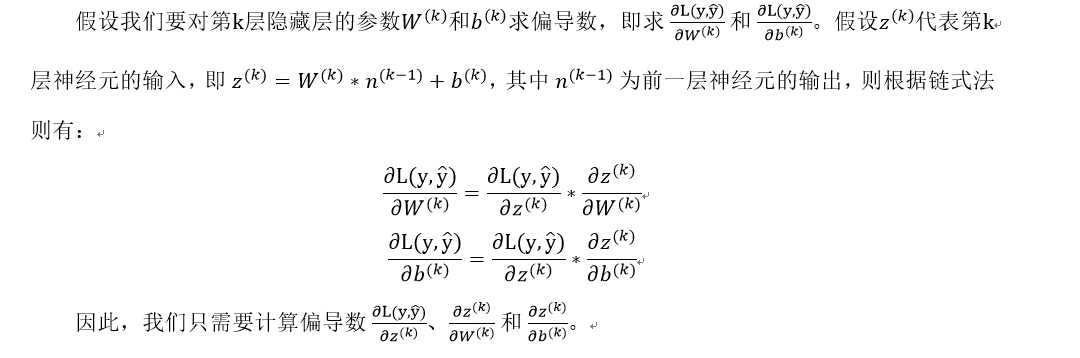

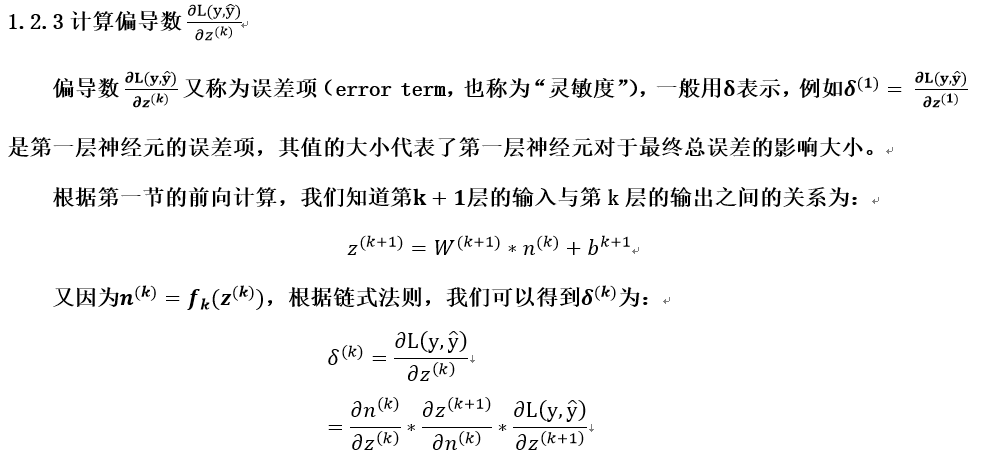

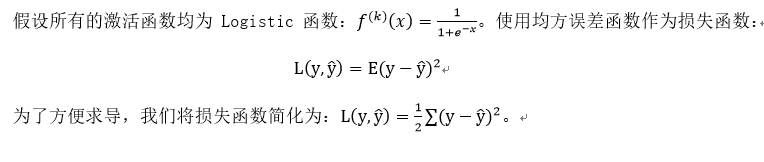

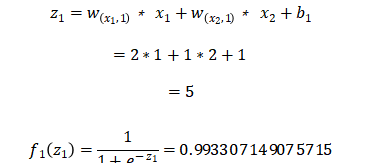

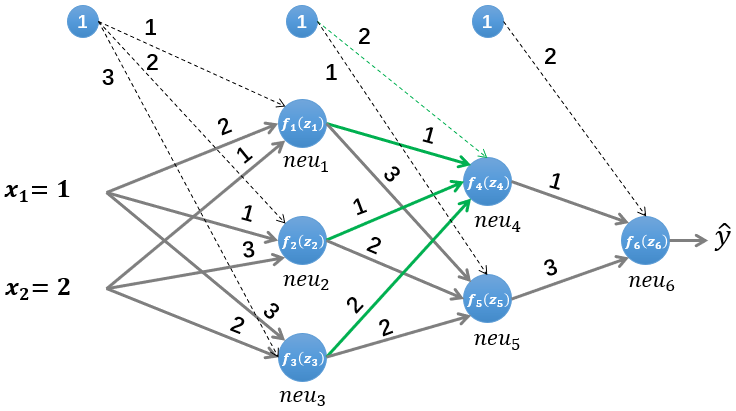

反向传播算法(Backpropagation Algorithm,简称BP算法)是深度学习的重要思想基础,对于初学者来说也是必须要掌握的基础知识!本文希望以一个清晰的脉络和详细的说明,来让读者彻底明白BP算法的原理和计算过程。

全文分为上下两篇,上篇主要介绍BP算法的原理(即公式的推导),介绍完原理之后,我们会将一些具体的数据带入一个简单的三层神经网络中,去完整的体验一遍BP算法的计算过程;下篇是一个项目实战,我们将带着读者一起亲手实现一个BP神经网络(不适用任何第三方的深度学习框架)来解决一个具体的问题。

读者在学习的过程中,有任何的疑问,欢迎加入我们的交流群(扫描文章最后的二维码即可加入),和大家一起讨论!

1.BP算法的推导

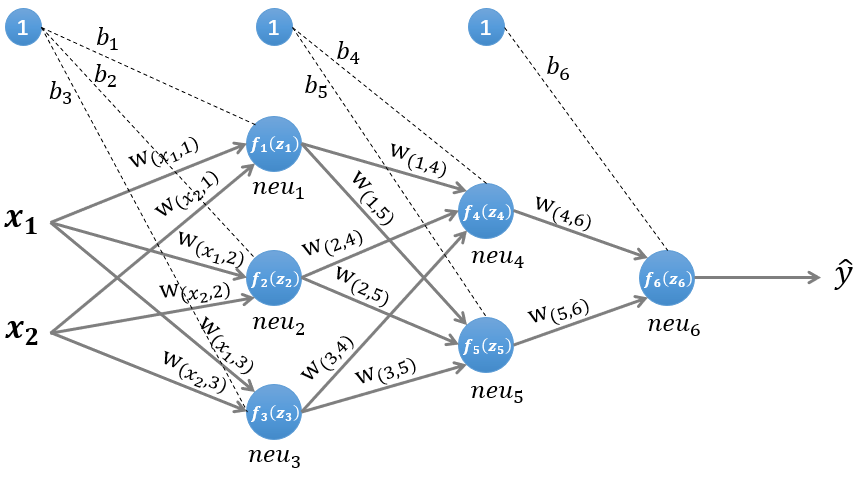

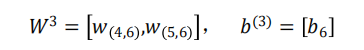

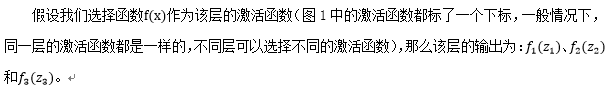

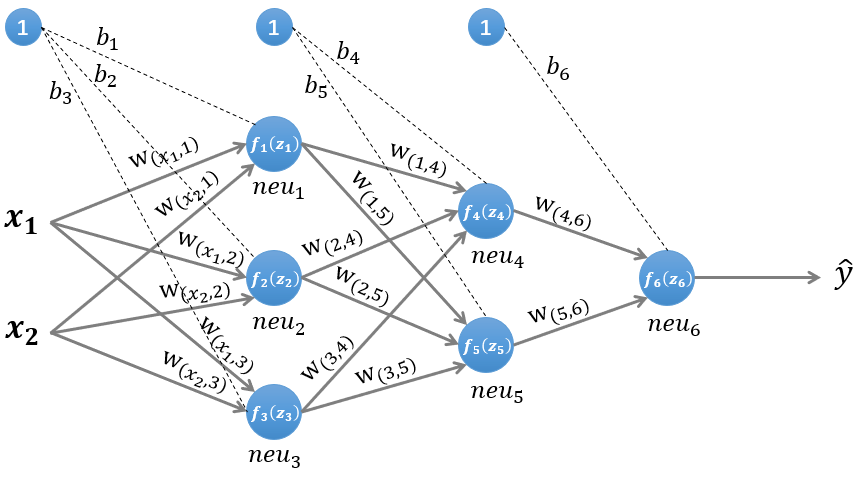

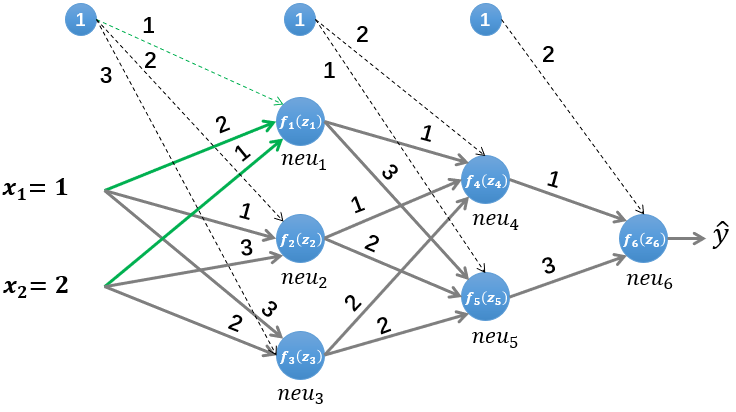

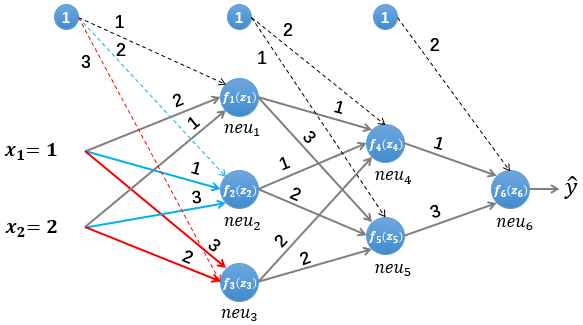

图1 一个简单的三层神经网络

图1所示是一个简单的三层(两个隐藏层,一个输出层)神经网络结构,假设我们使用这个神经网络来解决二分类问题,我们给这个网络一个输入样本 ,通过前向运算得到输出 。输出值 的值域为 ,例如 的值越接近0,代表该样本是“0”类的可能性越大,反之是“1”类的可能性大。

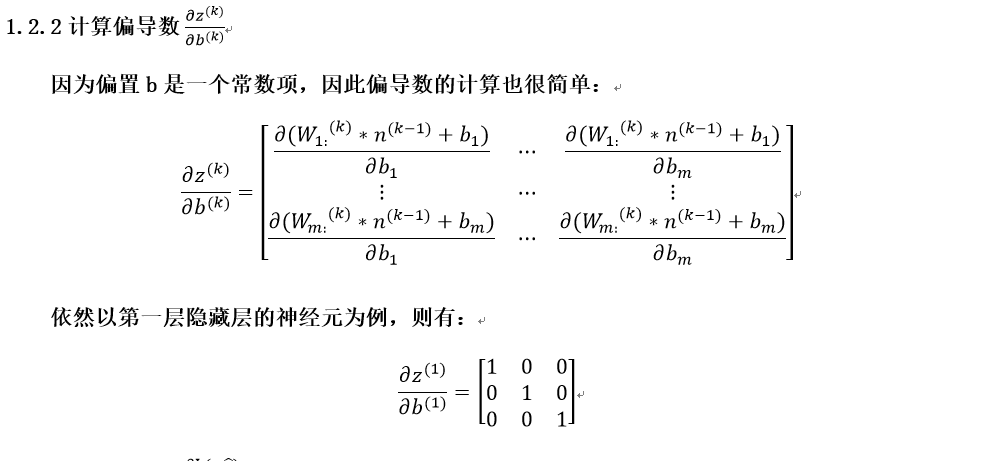

1.1前向传播的计算

为了便于理解后续的内容,我们需要先搞清楚前向传播的计算过程,以图1所示的内容为例:

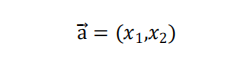

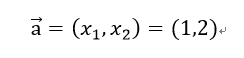

输入的样本为:

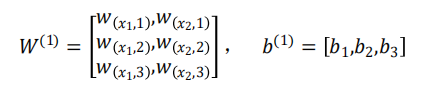

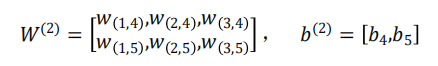

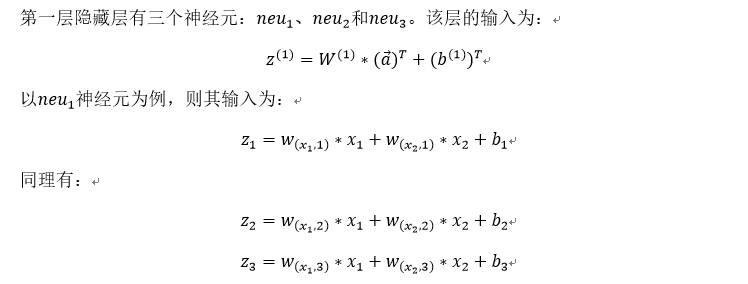

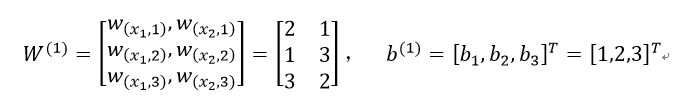

第一层网络的参数为:

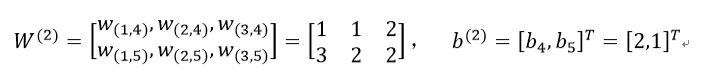

第二层网络的参数为:

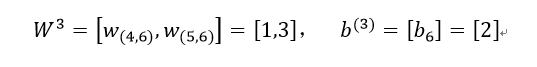

第三层网络的参数为:

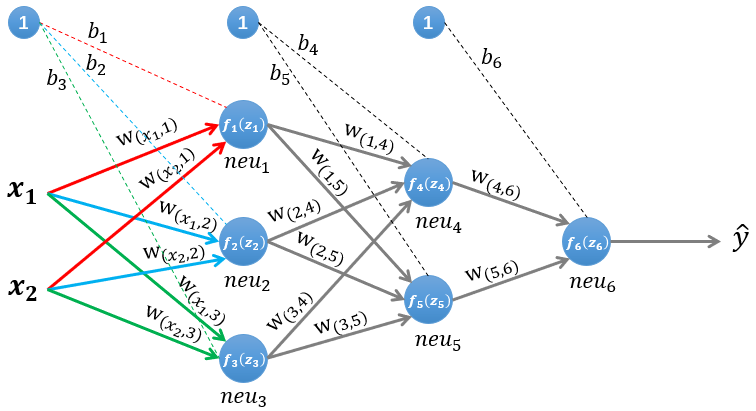

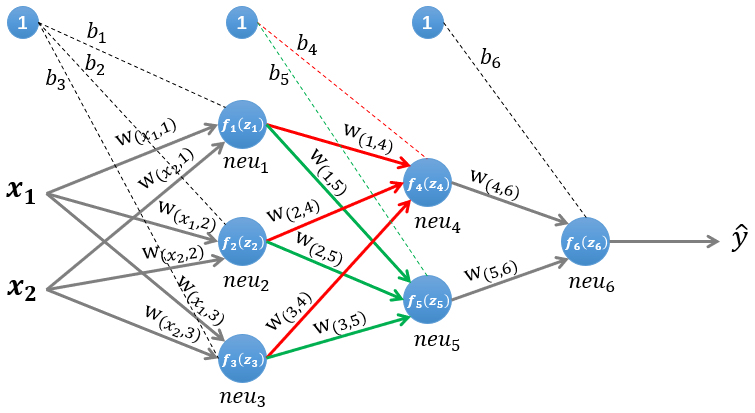

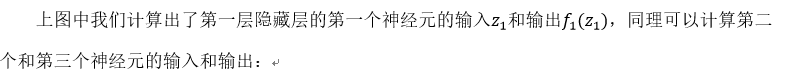

1.1.1第一层隐藏层的计算

图2 计算第一层隐藏层

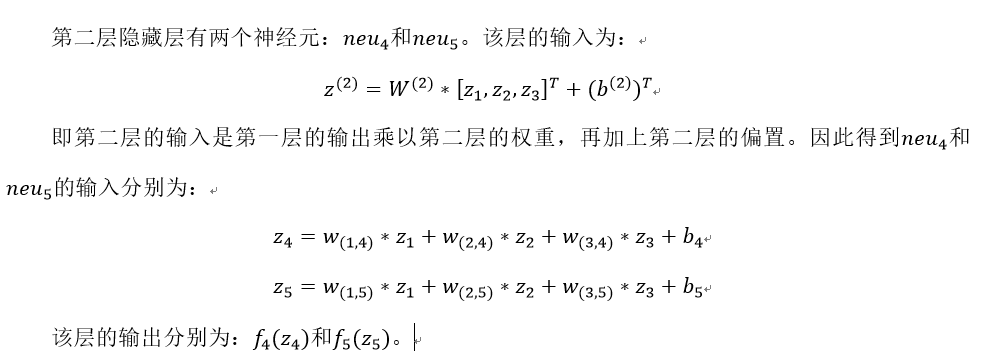

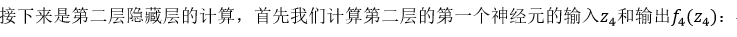

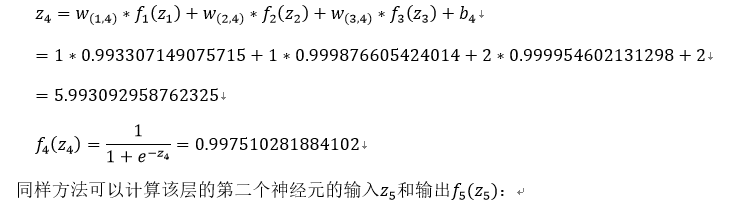

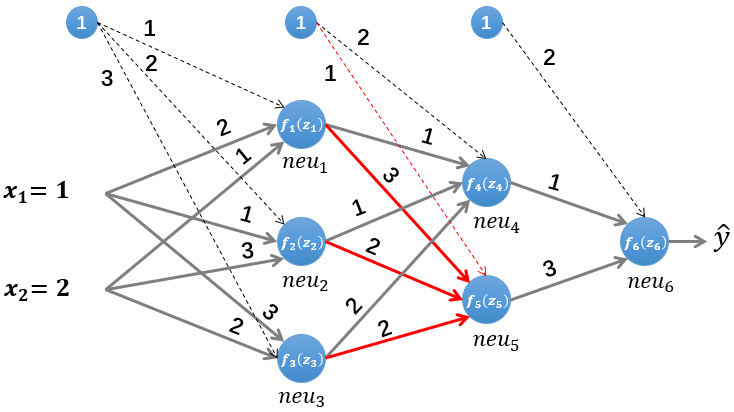

1.1.2第二层隐藏层的计算

图3 计算第二层隐藏层

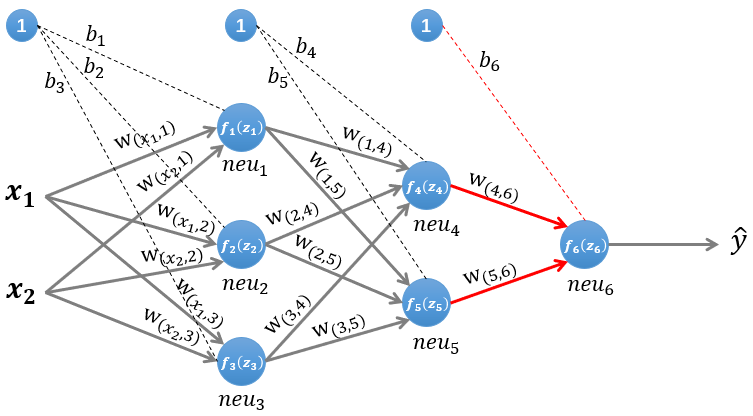

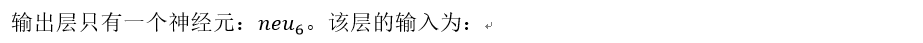

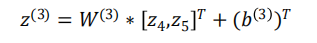

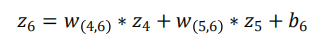

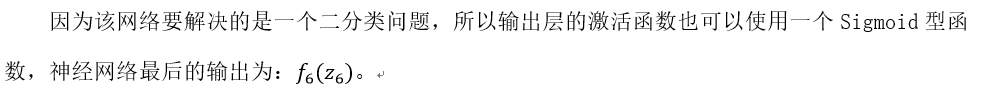

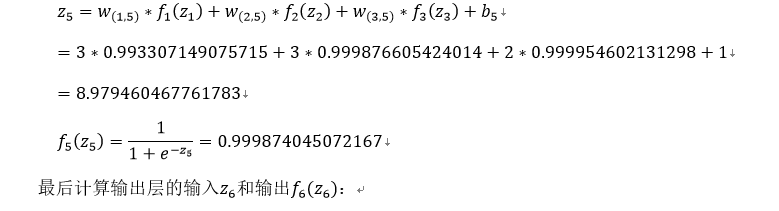

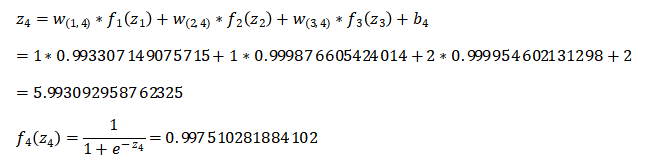

1.1.3输出层的计算

图4 计算输出层

即:

单纯的公式推导看起来有些枯燥,下面我们将实际的数据带入图1所示的神经网络中,完整的计算一遍。

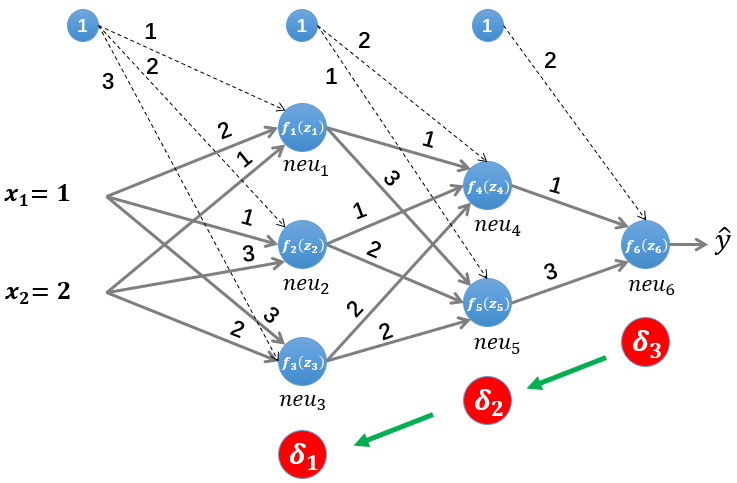

2.图解BP算法

图5 图解BP算法

我们依然使用如图5所示的简单的神经网络,其中所有参数的初始值如下:

输入的样本为(假设其真实类标为“1”):

第一层网络的参数为:

第二层网络的参数为:

第三层网络的参数为:

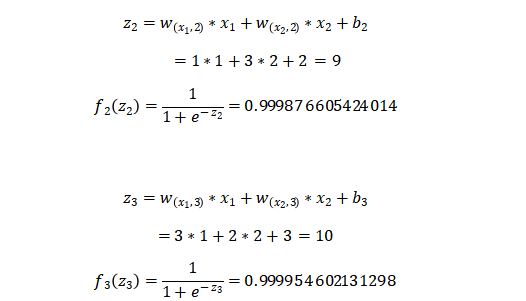

2.1前向传播

我们首先初始化神经网络的参数,计算第一层神经元:

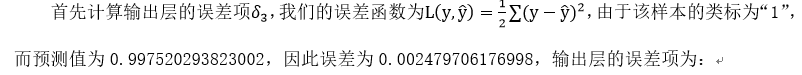

2.2误差反向传播

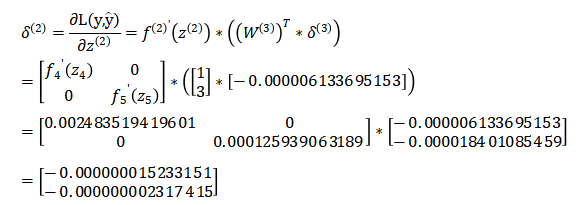

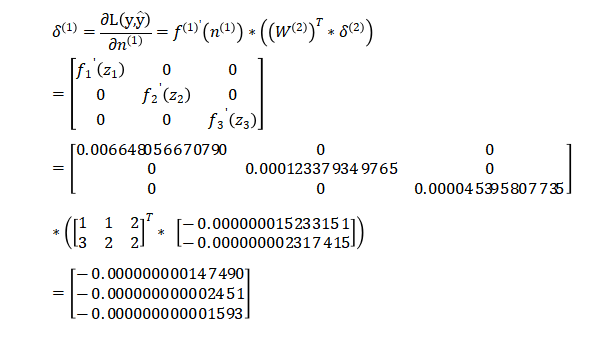

接着计算第二层隐藏层的误差项,根据误差项的计算公式有:

最后是计算第一层隐藏层的误差项:

最后是计算第一层隐藏层的误差项:

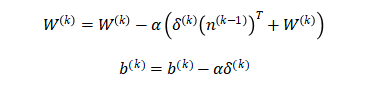

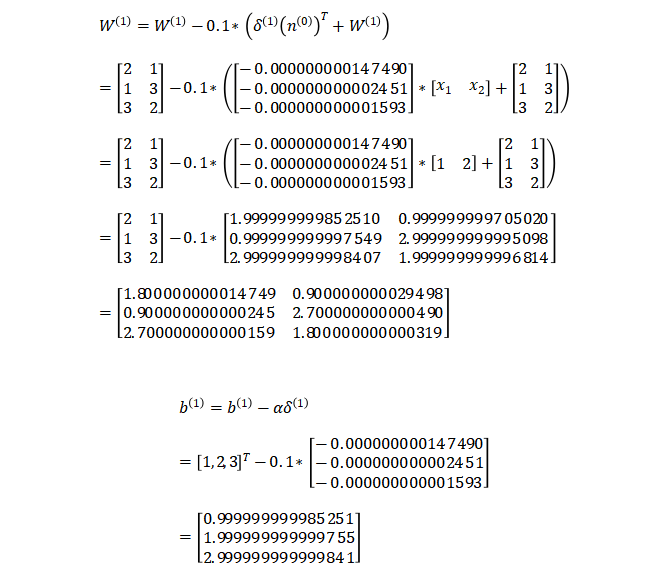

2.3更新参数

上一小节中我们已经计算出了每一层的误差项,现在我们要利用每一层的误差项和梯度来更新每一层的参数,权重W和偏置b的更新公式如下:

通常权重W的更新会加上一个正则化项来避免过拟合,这里为了简化计算,我们省去了正则化项。上式中的 是学习率,我们设其值为0.1。参数更新的计算相对简单,每一层的计算方式都相同,因此本文仅演示第一层隐藏层的参数更新:

3.小结

至此,我们已经完整介绍了BP算法的原理,并使用具体的数值做了计算。在下篇中,我们将带着读者一起亲手实现一个BP神经网络(不适用任何第三方的深度学习框架),敬请期待!有任何疑问,欢迎加入我们一起交流!

深度学习---反向传播算法BP相关推荐

- 深度学习---反向传播算法

装载原文:https://www.cnblogs.com/yeluzi/p/7418291.html 一. 一种基于矩阵运算快速计算神经网络输出的方法 在介绍反向传播之前,先介绍怎么利用矩阵运算快速的 ...

- 深度神经网络(DNN)反向传播算法(BP)

在深度神经网络(DNN)模型与前向传播算法中,我们对DNN的模型和前向传播算法做了总结,这里我们更进一步,对DNN的反向传播算法(Back Propagation,BP)做一个总结. 1. DNN反向 ...

- 神经网络与机器学习 笔记—反向传播算法(BP)

先看下面信号流图,L=2和M0=M1=M2=M3=3的情况,上面是前向通过,下面部分是反向通过. 1.初始化.假设没有先验知识可用,可以以一个一致分布来随机的挑选突触权值和阈值,这个分布选择为均值等于 ...

- [深度学习]反向传播的微分原理

目录 1.反向传播的定义 2.简单网络的反向传播实例 1.反向传播的定义 前面的文章<什么叫梯度学习>,介绍了梯度学习的原理,本文将介绍神经网络"自动学习"的核心算法: ...

- 李宏毅《机器学习》笔记 DAY4 深度学习反向传播

目录 深度学习的三个步骤 Step1:神经网络(Neural network) 完全连接前馈神经网络 全链接前馈网络 矩阵计算(Matrix Operation) Step2:模型评估(Goodnes ...

- 深度学习之 神经网络算法原理

深度学习之 神经网络算法原理 什么是神经网络算法? 初中映射 神经网络 求映射? 求解参数 图解求参 参考文献 什么是神经网络算法? 初中映射 初中的时候 y = f(x) 老师进过 映射 . 通过 ...

- 卷积神经网络(CNN)反向传播算法

在卷积神经网络(CNN)前向传播算法中,我们对CNN的前向传播算法做了总结,基于CNN前向传播算法的基础,我们下面就对CNN的反向传播算法做一个总结.在阅读本文前,建议先研究DNN的反向传播算法:深度 ...

- 前向传播算法和反向传播算法

最近在看神经网络中的前向传播算法(FP)和反向传播算法(BP),特地进行总结一下,方便以后理解. 1.基本概念 上图是一张自己画的神经网络的图.假设每一层都添加了偏度单元(即值为1的神经元), ...

- 反向传播算法的详细解释(上)

最近在看NG的视频的时候,学习反向传播算法时遇到了不小的困难.一是因为NG并没有把太多的精力放在讲解反向传播原理上,可能NG自己也觉得这部分如果要细讲,真的会耗费不少时间.二是NG在开课初就很照顾数学 ...

最新文章

- spring中的事务配置

- 贝佐斯明抢马斯克太空生意:数十亿美元组卫星互联网,5年内发射3236颗卫星...

- 关于JQUERY动态加载页面时的JS失效的问题

- SLAM的评价指标、真实值、估计值及误差分析(转)

- mybatis中的查询

- [PY3]——字符串的分割、匹配、搜索方法总结

- POJ 1742 Coins ( 经典多重部分和问题 DP || 多重背包 )

- Python之异常追踪模块:traceback

- Java 蓝桥杯 分解质因数

- pytorch torch.nn.TransformerEncoderLayer

- openssl pkeyutl执行SM2椭圆曲线数字签名

- 使用腾讯云部署war包

- 微带贴片天线的分析方法-空腔模型法

- TPC-H和TPC-DS

- 离职,见人品,显格局

- 源代码防泄密加密介绍

- Java数据类型问题

- AutoSAR实验视频讲解:相关资料下载

- 常用传感器讲解八--土壤湿度传感器(XH-M214)

- Office Open XML——从底层出发,自定义你的Office组件