多分类问题中每一类的Precision-Recall Curve曲线以及ROC的Matlab画法

这两天写论文中,本来设计的是要画这个Precision-Recall Curve的,因为PRC是从信息检索中来的,而且我又做的类似一个检索,所以要画这个图,但是我靠,竟然发现不好画,找了很多资料等。最后也没画好,多么重要好看实用的图啊,可惜了。

今天就花了一点功夫,专门为自己弄了个工具包,用来计算多分类问题中的Precision-Recall Curve、混淆矩阵Confusion Matrix并且进行可视化输出。

不过Precision-Recall Curve对于每一类的画法还是很有讲究的,我们知道对于二类问题,像是检索中的问题,最后的查全率、查准率基本都是最后计算一对值就行了,但是就一对值,一个点是画不出曲线来的,所以在实际的曲线过程中,是这样的:

1、首先得分为正负两类,多类问题真对每一类都可以映射过去

2、按照决策值(分类问题每一个样本肯定会有一个支持分类的概率或者置信度等等,像是libsvm的dec_values的矩阵),按照从小到大的顺序进行排序

3、然后分别计算全部样本、全本样本-1、全部样本-2、...........、一直计算完毕,每一次都会有查全率查准率,就可以曲线了,这里我说的很粗糙,详细的可以查看我的代码,当然也有函数参考的别人的,也做了说明。

| correct result / classification | |||

|---|---|---|---|

| E1 | E2 | ||

|

obtained result / classification |

E1 |

tp (true positive) |

fp (false positive) |

| E2 |

fn (false negative) |

tn (true negative) |

|

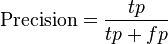

Precision and recall are then defined as:

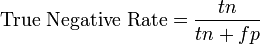

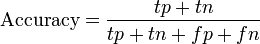

Recall in this context is also referred to as the True Positive Rate, other related measures used in classification include True Negative Rate and Accuracy:[1]. True Negative Rate is also called Specificity.

------------------

我的计算这些东西的代码包:

PG_Curve.zip: Matlab code for computing and visualization: Confusion Matrix, Precision/Recall Curve, ROC, Accuracy, F-Measure etc. for Classification.

红色的跳跃的就是最原始的曲线,绿色的是一个人的平滑算法。

from: http://www.zhizhihu.com/html/y2010/2447.html

多分类问题中每一类的Precision-Recall Curve曲线以及ROC的Matlab画法相关推荐

- [转载] numpy.bincount介绍以及巧妙计算分类结果中每一类预测正确的个数

参考链接: Python中的numpy.bincount 之前接触到bincount这个函数,简单的以为它就是计算分类结果中每一类的数量,如下: import numpy as np a = np.a ...

- PR(precision recall curve)曲线是什么?PR曲线如何绘制?为什么Precision和Recall是矛盾体、此消彼长?为什么提出F1指标?

PR(precision recall curve)曲线是什么?PR曲线如何绘制?为什么PR是矛盾体.此消彼长?为什么提出F1指标? sklearn.metrics.precision_recall_ ...

- 分类问题的评价及matrix , precision, recall

参考: https://github.com/Ana-Shi/helloworld/blob/master/coursera/machine_learning/classfication_metric ...

- 多分类模型Accuracy, Precision, Recall和F1-score的超级无敌深入探讨

https://zhuanlan.zhihu.com/p/147663370?from_voters_page=true 众所周知,机器学习分类模型常用评价指标有Accuracy, Precision ...

- 多分类问题中混淆矩阵(Confusion Matrix)的Matlab画法

在多分类问题中,有一种很实用的分类问题结果统计图. 比如说多类别文类问题,那么每一个类别分到其他类别都有一些数据,但是分到自己类别的毕竟多,这样计算百分比之后就形成了一个矩阵,如果分类正确率高的话,那 ...

- 二分类最优阈值确定_一文搞懂分类算法中常用的评估指标

导读 通常我们在解决某个问题的时候,会设计多种分类算法在训练的时候我们还会调节各种超参以及使用各种trick以获取最优的分类模型,那这时候我们应该如何来衡量这个最优呢? 分类算法的评估指标有很多种,选 ...

- 机器学习模型常用评价指标(Accuracy, Precision, Recall、F1-score、MSE、RMSE、MAE、R方)

前言 众所周知,机器学习分类模型常用评价指标有Accuracy, Precision, Recall和F1-score,而回归模型最常用指标有MAE和RMSE.但是我们真正了解这些评价指标的意义吗? ...

- 算法模型评价详解:confusion matrix Accuracy Precision Recall F1 调和平均 加权F1 Micro-F1 Macro-F1 PRC ROC AUC

目录 问题定义 confusion matrix Accuracy Precision和Recall和PRC F1和调和平均 加权F1 Micro-F1和Macro-F1 ROC和AUC PRC对比R ...

- 目标检测模型的评价指标(Acc, Precision, Recall, AP, mAP, RoI)

目标检测模型的评价指标(Acc, Precision, Recall, AP, mAP, RoI) 对于一个目标检测模型的好坏,总的来说可以从以下三个方面来评估: 分类的精度如何.一般可以用准确度(A ...

最新文章

- putty php环境搭建,centos7(linux)系统下php搭建环境和创建laravel项目

- 屏幕编程 F4的帮组用法

- spring 之 property-placeholder 分析

- ubuntu之在ubuntu16.04中搭建gitlab服务器

- 编译报错:make: *** No rule to make target (例如:starg.h)解决

- Spring Data + Thymeleaf 3 + Bootstrap 4 实现分页器

- pyqt5 tablewidget 设置行高_Python+PyQt5基础开发(10)

- android 9坚果r1,坚果R1、小米MIX2S、一加6对比评测 骁龙845旗舰怎么选?

- Flash MX 2004的Alpha Fader

- HbuilderX 自有证书生成

- 人人看得懂的ChatGPT技术原理解析

- 网站有上传后门木马的漏洞怎么解决

- css实现三角形对话框,三角形图案

- kafka 0.10.0.0 版本

- FFmpeg命令行工具系列二---转码流程及过滤器

- 网络工程师必备知识不间断路由NSR概述 -ielab

- 硬核小学生:玩自己写的游戏,未来想造机器人

- 铂德发布换弹型电子烟新琥珀,3.5ml超大容量创行业纪录

- 如何配置一台支持6块RTX3090静音级深度学习工作站

- Python和Google AppEngine开发基于Google架构的应用软件