从 Linux 源码看 Socket 的阻塞和非阻塞

转载自 从 Linux 源码看 Socket 的阻塞和非阻塞

笔者一直觉得如果能知道从应用到框架再到操作系统的每一处代码,是一件Exciting的事情。

大部分高性能网络框架采用的是非阻塞模式。笔者这次就从linux源码的角度来阐述socket阻塞(block)和非阻塞(non_block)的区别。 本文源码均来自采用Linux-2.6.24内核版本。

一个TCP非阻塞client端简单的例子

如果我们要产生一个非阻塞的socket,在C语言中如下代码所示:

// 创建socket

int sock_fd = socket(AF_INET, SOCK_STREAM, 0);

...

// 更改socket为nonblock

fcntl(sock_fd, F_SETFL, fdflags | O_NONBLOCK);

// connect

....

while(1) { int recvlen = recv(sock_fd, recvbuf, RECV_BUF_SIZE) ; ......

}

...

由于网络协议非常复杂,内核里面用到了大量的面向对象的技巧,所以我们从创建连接开始,一步一步追述到最后代码的调用点。

socket的创建

很明显,内核的第一步应该是通过AF_INET、SOCK_STREAM以及最后一个参数0定位到需要创建一个TCP的socket,如下图绿线所示:

我们跟踪源码调用

socket(AF_INET, SOCK_STREAM, 0)|->sys_socket 进入系统调用|->sock_create|->__sock_create

进一步分析__sock_create的代码判断:

const struct net_proto_family *pf;

// RCU(Read-Copy Update)是linux的一种内核同步方法,在此不阐述

// family=INET

pf = rcu_dereference(net_families[family]);

err = pf->create(net, sock, protocol);

由于family是AF_INET协议,注意在操作系统里面定义了PF_INET等于AF_INET, 内核通过函数指针实现了对pf(net_proto_family)的重载。如下图所示:

则通过源码可知,由于是AF_INET(PF_INET),所以net_families[PF_INET].create=inet_create(以后我们都用PF_INET表示),即

pf->create = inet_create; 进一步追溯调用:

inet_create(struct net *net, struct socket *sock, int protocol){Sock* sock;......// 此处是寻找对应协议处理器的过程

lookup_protocol:// 迭代寻找protocol==answer->protocol的情况list_for_each_rcu(p, &inetsw[sock->type]) answer = list_entry(p, struct inet_protosw, list);/* Check the non-wild match. */if (protocol == answer->protocol) {if (protocol != IPPROTO_IP)break;}......// 这边answer指的是SOCK_STREAMsock->ops = answer->ops;answer_no_check = answer->no_check;// 这边sk->prot就是answer_prot=>tcp_protsk = sk_alloc(net, PF_INET, GFP_KERNEL, answer_prot);sock_init_data(sock, sk);......

}

上面的代码就是在INET中寻找SOCK_STREAM的过程了 我们再看一下inetsw[SOCK_STREAM]的具体配置:

static struct inet_protosw inetsw_array[] =

{{.type = SOCK_STREAM,.protocol = IPPROTO_TCP,.prot = &tcp_prot,.ops = &inet_stream_ops,.capability = -1,.no_check = 0,.flags = INET_PROTOSW_PERMANENT |INET_PROTOSW_ICSK,},......

}

这边也用了重载,AF_INET有TCP、UDP以及Raw三种:

从上述代码,我们可以清楚的发现sock->ops=&inet_stream_ops;

const struct proto_ops inet_stream_ops = {.family = PF_INET,.owner = THIS_MODULE,.......sendmsg = tcp_sendmsg,.recvmsg = sock_common_recvmsg,......

}

即sock->ops->recvmsg = sock_common_recvmsg;

同时sock->sk->sk_prot = tcp_prot;

我们再看下tcp_prot中的各个函数重载的定义:

struct proto tcp_prot = {.name = "TCP",.close = tcp_close,.connect = tcp_v4_connect,.disconnect = tcp_disconnect,.accept = inet_csk_accept,......// 我们重点考察tcp的读.recvmsg = tcp_recvmsg,......

}

fcntl控制socket的阻塞\非阻塞状态

我们用fcntl修改socket的阻塞\非阻塞状态。 事实上: fcntl的作用就是将O_NONBLOCK标志位存储在sock_fd对应的filp结构的f_lags里,如下图所示。

fcntl(sock_fd, F_SETFL, fdflags | O_NONBLOCK);|->setfl

追踪setfl代码:

static int setfl(int fd, struct file * filp, unsigned long arg) {......filp->f_flags = (arg & SETFL_MASK) | (filp->f_flags & ~SETFL_MASK);......

}

上图中,由sock_fd在task_struct(进程结构体)->files_struct->fd_array中找到对应的socket的file描述符,再修改file->flags

在调用socket.recv的时候

我们跟踪源码调用:

socket.recv|->sys_recv|->sys_recvfrom|->sock_recvmsg|->__sock_recvmsg|->sock->ops->recvmsg

由上文可知: sock->ops->recvmsg = sock_common_recvmsg;

sock

值得注意的是,在sock_recmsg中,有对标识O_NONBLOCK的处理

if (sock->file->f_flags & O_NONBLOCK)flags |= MSG_DONTWAIT;

上述代码中sock关联的file中获取其f_flags,如果flags有O_NONBLOCK标识,那么就设置msg_flags为MSG_DONTWAIT(不等待)。

fcntl与socket就是通过其共同操作File结构关联起来的。

继续跟踪调用

sock_common_recvmsg

int sock_common_recvmsg(struct kiocb *iocb, struct socket *sock,struct msghdr *msg, size_t size, int flags) {......// 如果flags的MSG_DONTWAIT标识置位,则传给recvmsg的第5个参数为正,否则为0err = sk->sk_prot->recvmsg(iocb, sk, msg, size, flags & MSG_DONTWAIT,flags & ~MSG_DONTWAIT, &addr_len);.....

}

由上文可知: sk->sk_prot->recvmsg 其中sk_prot=tcp_prot,即最终调用的是tcp_prot->tcp_recvmsg,

上面的代码可以看出,如果fcntl(O_NONBLOCK)=>MSG_DONTWAIT置位=>(flags & MSG_DONTWAIT)>0, 再结合tcp_recvmsg的函数签名,即如果设置了O_NONBLOCK的话,设置给tcp_recvmsg的nonblock参数>0,关系如下图所示:

最终的调用逻辑tcp_recvmsg

首先我们看下tcp_recvmsg的函数签名:

int tcp_recvmsg(struct kiocb *iocb, struct sock *sk, struct msghdr *msg,size_t len, int nonblock, int flags, int *addr_len)

显然我们关注焦点在(int nonblock这个参数上):

int tcp_recvmsg(struct kiocb *iocb, struct sock *sk, struct msghdr *msg,size_t len, int nonblock, int flags, int *addr_len){...... // copied是指向用户空间拷贝了多少字节,即读了多少int copied;// target指的是期望多少字节int target;// 等效为timo = noblock ? 0 : sk->sk_rcvtimeo;timeo = sock_rcvtimeo(sk, nonblock);...... // 如果设置了MSG_WAITALL标识target=需要读的长度// 如果未设置,则为最低低水位值target = sock_rcvlowat(sk, flags & MSG_WAITALL, len);......do{// 表明读到数据if (copied) {// 注意,这边只要!timeo,即nonblock设置了就会跳出循环if (sk->sk_err ||sk->sk_state == TCP_CLOSE ||(sk->sk_shutdown & RCV_SHUTDOWN) ||!timeo ||signal_pending(current) ||(flags & MSG_PEEK))break;}else{// 到这里,表明没有读到任何数据// 且nonblock设置了导致timeo=0,则返回-EAGAIN,符合我们的预期if (!timeo) {copied = -EAGAIN;break;}// 这边如果堵到了期望的数据,继续,否则当前进程阻塞在sk_wait_data上if (copied >= target) {/* Do not sleep, just process backlog. */release_sock(sk);lock_sock(sk);} elsesk_wait_data(sk, &timeo);} while (len > 0); ......return copied

}

上面的逻辑归结起来就是:

(1)在设置了nonblock的时候,如果copied>0,则返回读了多少字节,如果copied=0,则返回-EAGAIN,提示应用重复调用。

(2)如果没有设置nonblock,如果读取的数据>=期望,则返回读取了多少字节。如果没有则用sk_wait_data将当前进程等待。

如下流程图所示:

阻塞函数sk_wait_data

sk_wait_data代码-函数为:

// 将进程状态设置为可打断INTERRUPTIBLEprepare_to_wait(sk->sk_sleep, &wait, TASK_INTERRUPTIBLE);set_bit(SOCK_ASYNC_WAITDATA, &sk->sk_socket->flags);// 通过调用schedule_timeout让出CPU,然后进行睡眠rc = sk_wait_event(sk, timeo, !skb_queue_empty(&sk->sk_receive_queue));// 到这里的时候,有网络事件或超时事件唤醒了此进程,继续运行clear_bit(SOCK_ASYNC_WAITDATA, &sk->sk_socket->flags);finish_wait(sk->sk_sleep, &wait);

该函数调用schedule_timeout进入睡眠,其进一步调用了schedule函数,首先从运行队列删除,其次加入到等待队列,最后调用和体系结构相关的switch_to宏来完成进程间的切换。

如下图所示:

阻塞后什么时候恢复运行呢

情况1:有对应的网络数据到来

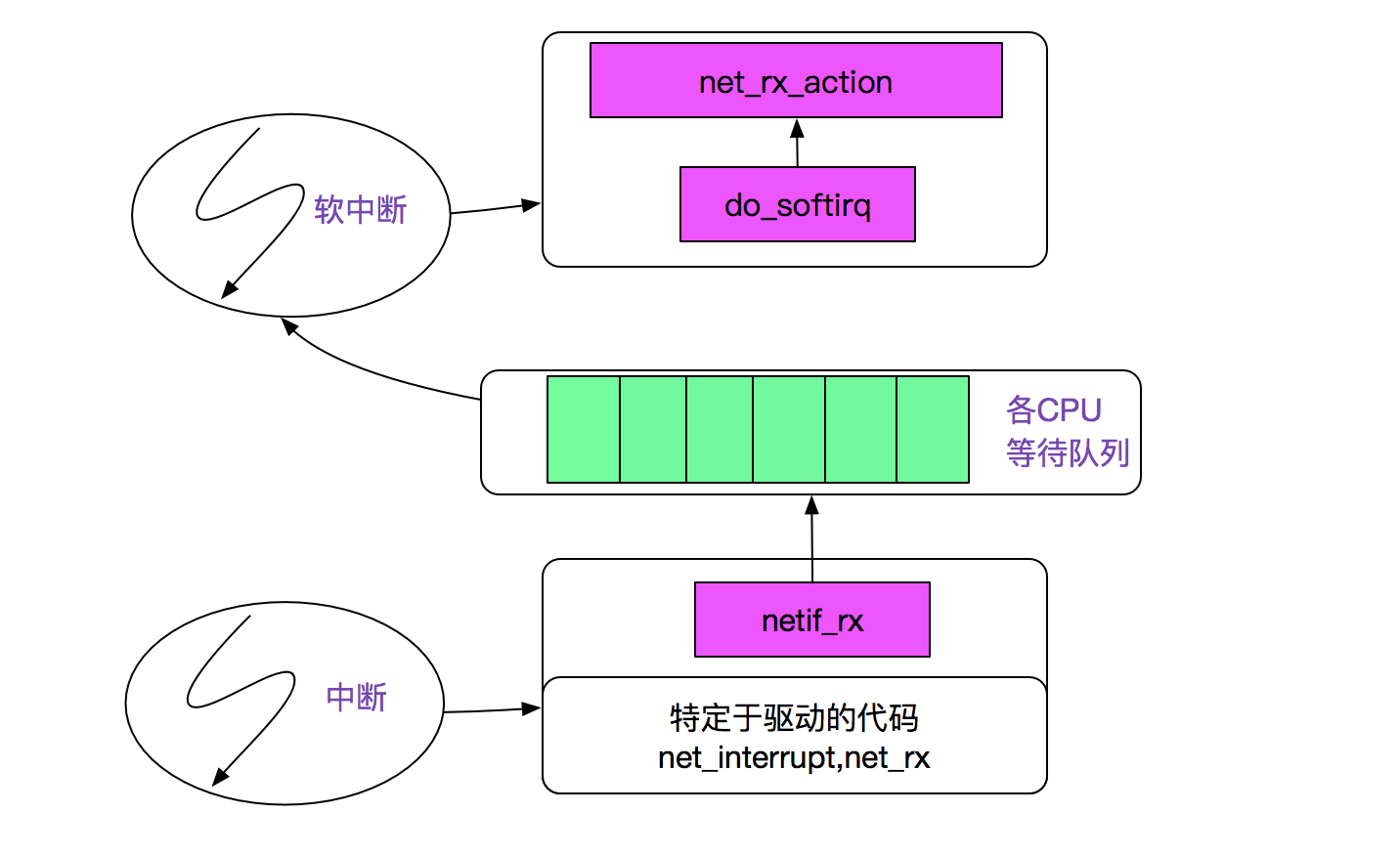

首先我们看下网络分组到来的内核路径,网卡发起中断后调用netif_rx将事件挂入CPU的等待队列,并唤起软中断(soft_irq),再通过linux的软中断机制调用net_rx_action,如下图所示:

注:上图来自PLKA(<<深入Linux内核架构>>)

紧接着跟踪next_rx_action

next_rx_action|-process_backlog......|->packet_type->func 在这里我们考虑ip_rcv|->ipprot->handler 在这里ipprot重载为tcp_protocol(handler 即为tcp_v4_rcv)

紧接着tcp_v4_rcv:

tcp_input.c

tcp_v4_rcv|-tcp_v4_do_rcv|-tcp_rcv_state_process|-tcp_data_queue|-sk->sk_data_ready=sock_def_readable|-wake_up_interruptible|-__wake_up|-__wake_up_common

在这里__wake_up_common将停在当前wait_queue_head_t中的进程唤醒,即状态改为task_running,等待CFS调度以进行下一步的动作,如下图所示。

情况2:设定的超时时间到来

在前面调用sk_wait_event中调用了schedule_timeout

fastcall signed long __sched schedule_timeout(signed long timeout) {......// 设定超时的回掉函数为process_timeoutsetup_timer(&timer, process_timeout, (unsigned long)current);__mod_timer(&timer, expire);// 这边让出CPUschedule();del_singleshot_timer_sync(&timer);timeout = expire - jiffies;out:// 返回经过了多长事件return timeout < 0 ? 0 : timeout;

}

process_timeout函数即是将此进程重新唤醒

static void process_timeout(unsigned long __data)

{wake_up_process((struct task_struct *)__data);

}

总结

linux内核源代码博大精深,阅读其代码很费周折。希望笔者这篇文章能帮助到阅读linux网络协议栈代码的人。

从 Linux 源码看 Socket 的阻塞和非阻塞相关推荐

- linux内核线程socket,从Linux源码看Socket(TCP)的accept

从Linux源码看Socket(TCP)的accept 前言 笔者一直以为若是能知道从应用到框架再到操做系统的每一处代码,是一件Exciting的事情. 今天笔者就从Linux源码的角度看下Serve ...

- java linux 调用32位so_从linux源码看socket(tcp)的timeout

从linux源码看socket(tcp)的timeout 前言 网络编程中超时时间是一个重要但又容易被忽略的问题,对其的设置需要仔细斟酌.在经历了数次物理机宕机之后,笔者详细的考察了在网络编程(tcp ...

- codeblock socket 编译错误_从Linux源码看Socket(TCP)Client端的Connect

从Linux源码看Socket(TCP)Client端的Connect 前言 笔者一直觉得如果能知道从应用到框架再到操作系统的每一处代码,是一件Exciting的事情. 今天笔者就来从Linux源码的 ...

- 从Linux源码看Socket(TCP)的listen及连接队列

从Linux源码看Socket(TCP)的listen及连接队列 前言 笔者一直觉得如果能知道从应用到框架再到操作系统的每一处代码,是一件Exciting的事情. 今天笔者就来从Linux源码的角度看 ...

- 从Linux源码看Socket(TCP)的bind

从Linux源码看Socket(TCP)的bind 前言 笔者一直觉得如果能知道从应用到框架再到操作系统的每一处代码,是一件Exciting的事情. 今天笔者就来从Linux源码的角度看下Server ...

- java sotimeout tcp_从linux源码看socket(tcp)的timeout

前言 网络编程中超时时间是一个重要但又容易被忽略的问题,对其的设置需要仔细斟酌.在经历了数次物理机宕机之后,笔者详细的考察了在网络编程(tcp)中的各种超时设置,于是就有了本篇博文.本文大部分讨论的是 ...

- linux源码_从linux源码看epoll及epoll实战揭秘

从linux源码看epoll 前言 在linux的高性能网络编程中,绕不开的就是epoll.和select.poll等系统调用相比,epoll在需要监视大量文件描述符并且其中只有少数活跃的时候,表现出 ...

- ip受限 linux_从linux源码看epoll及epoll实战揭秘

从linux源码看epoll 前言 在linux的高性能网络编程中,绕不开的就是epoll.和select.poll等系统调用相比,epoll在需要监视大量文件描述符并且其中只有少数活跃的时候,表现出 ...

- 从linux源码看epoll及epoll实战揭秘

从linux源码看epoll 前言 在linux的高性能网络编程中,绕不开的就是epoll.和select.poll等系统调用相比,epoll在需要监视大量文件描述符并且其中只有少数活跃的时候,表现出 ...

最新文章

- JavaScript 慢慢移动的海绵宝宝

- RDKit | 可视化官能团, 分子聚类, 相似图, 化合物高亮和骨架网络

- 秋招面经来了,收藏!

- python---memcache使用操作

- python eel 多线程_利用Eel使JavaScript调用Python程序

- SaltStack配置文件

- Docker镜像由于代理问题导致不能下载的解决办法

- Linux文件系统与日志

- UVA 11426 GCD-Extreme(II) ★ (欧拉函数)

- 华为大数据中心山西_任正非:华为愿与山西一道建立“煤矿人工智能创新实验室”...

- 使用Angular Router导航基础

- iOS表示图下拉刷新控件

- 水系图一般在哪里找得到_腾远带你了解:虹吸排水系统原理、组成及应用优势...

- 高通msm8909/msm8953 Linux支持双卡双待

- Vue脚手架创建项目报错 ERROR command failed: npm install --loglevel error --legacy-peer-deps

- 怎样使用css动画animation实现静态箭头图片上下摆动

- 数模国赛备赛(1)元胞自动机CA 生命游戏 森林火灾 传染病模型 MATLAB版资源整理

- 左右滑屏设置_王者荣耀怎么滑屏操作 滑屏手法详解[多图]

- 【写博客常用】参考文献一定要按顺序标么

- windows 本地搭建git仓库_Windows平台下Github远程仓库的搭建-Go语言中文社区

热门文章

- [JavaWeb-HTML]HTML标签_块标签

- [蓝桥杯2016初赛]方格填数-next_permutation

- eclipse中tomcat启动不了_Eclipse怎样与Tomcat集成

- 准确率、召回率、F1、mAP、ROC、AUC

- 2019-03-09-算法-进化(买卖股票的最佳时机 II)

- Codeforces Round #651 (Div. 2) D

- 牛客题霸 [ 在二叉树中找到两个节点的最近公共祖先] C++题解/答案

- YBTOJ:采矿战略(线段树维护dp、树链剖分)

- Loj#6503-「雅礼集训 2018 Day4」Magic【分治NTT】

- P2257-YY的GCD【莫比乌斯反演】