利用 MapReduce分析明星微博数据实战

互联网时代的到来,使得名人的形象变得更加鲜活,也拉近了明星和粉丝之间的距离。歌星、影星、体育明星、作家等名人通过互联网能够轻易实现和粉丝的互动,赚钱也变得前所未有的简单。同时,互联网的飞速发展本身也造就了一批互联网明星,这些人借助新的手段,最大程度发挥了粉丝经济的能量和作用,在互联网时代赚得盆满钵满。

正是基于这样一个大背景,今天我们做一个分析明星微博数据的小项目。

1、项目需求

自定义输入格式,将明星微博数据排序后按粉丝数关注数 微博数分别输出到不同文件中。

2、数据集

明星 明星微博名称 粉丝数 关注数 微博数

俞灏明 俞灏明 10591367 206 558

李敏镐 李敏镐 22898071 11 268

林心如 林心如 57488649 214 5940

黄晓明 黄晓明 22616497 506 2011

张靓颖 张靓颖 27878708 238 3846

李娜 李娜 23309493 81 631

徐小平 徐小平 11659926 1929 13795

唐嫣 唐嫣 24301532 200 2391

有斐君 有斐君 8779383 577 4251

3、分析

自定义InputFormat读取明星微博数据,通过自定义getSortedHashtableByValue方法分别对明星的fan、followers、microblogs数据进行排序,然后利用MultipleOutputs输出不同项到不同的文件中

4、实现

1)、定义WeiBo实体类,实现WritableComparable接口

- package com.buaa;

- import java.io.DataInput;

- import java.io.DataOutput;

- import java.io.IOException;

- import org.apache.hadoop.io.WritableComparable;

- /**

- * @ProjectName MicroblogStar

- * @PackageName com.buaa

- * @ClassName WeiBo

- * @Description TODO

- * @Author 刘吉超

- * @Date 2016-05-07 14:54:29

- */

- public class WeiBo implements WritableComparable<Object> {

- // 粉丝

- private int fan;

- // 关注

- private int followers;

- // 微博数

- private int microblogs;

- public WeiBo(){};

- public WeiBo(int fan,int followers,int microblogs){

- this.fan = fan;

- this.followers = followers;

- this.microblogs = microblogs;

- }

- public void set(int fan,int followers,int microblogs){

- this.fan = fan;

- this.followers = followers;

- this.microblogs = microblogs;

- }

- // 实现WritableComparable的readFields()方法,以便该数据能被序列化后完成网络传输或文件输入

- @Override

- public void readFields(DataInput in) throws IOException {

- fan = in.readInt();

- followers = in.readInt();

- microblogs = in.readInt();

- }

- // 实现WritableComparable的write()方法,以便该数据能被序列化后完成网络传输或文件输出

- @Override

- public void write(DataOutput out) throws IOException {

- out.writeInt(fan);

- out.writeInt(followers);

- out.writeInt(microblogs);

- }

- @Override

- public int compareTo(Object o) {

- // TODO Auto-generated method stub

- return 0;

- }

- public int getFan() {

- return fan;

- }

- public void setFan(int fan) {

- this.fan = fan;

- }

- public int getFollowers() {

- return followers;

- }

- public void setFollowers(int followers) {

- this.followers = followers;

- }

- public int getMicroblogs() {

- return microblogs;

- }

- public void setMicroblogs(int microblogs) {

- this.microblogs = microblogs;

- }

- }

2)、自定义WeiboInputFormat,继承FileInputFormat抽象类

- package com.buaa;

- import java.io.IOException;

- import org.apache.hadoop.conf.Configuration;

- import org.apache.hadoop.fs.FSDataInputStream;

- import org.apache.hadoop.fs.FileSystem;

- import org.apache.hadoop.fs.Path;

- import org.apache.hadoop.io.Text;

- import org.apache.hadoop.mapreduce.InputSplit;

- import org.apache.hadoop.mapreduce.RecordReader;

- import org.apache.hadoop.mapreduce.TaskAttemptContext;

- import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

- import org.apache.hadoop.mapreduce.lib.input.FileSplit;

- import org.apache.hadoop.util.LineReader;

- /**

- * @ProjectName MicroblogStar

- * @PackageName com.buaa

- * @ClassName WeiboInputFormat

- * @Description TODO

- * @Author 刘吉超

- * @Date 2016-05-07 10:23:28

- */

- public class WeiboInputFormat extends FileInputFormat<Text,WeiBo>{

- @Override

- public RecordReader<Text, WeiBo> createRecordReader(InputSplit arg0, TaskAttemptContext arg1) throws IOException, InterruptedException {

- // 自定义WeiboRecordReader类,按行读取

- return new WeiboRecordReader();

- }

- public class WeiboRecordReader extends RecordReader<Text, WeiBo>{

- public LineReader in;

- // 声明key类型

- public Text lineKey = new Text();

- // 声明 value类型

- public WeiBo lineValue = new WeiBo();

- @Override

- public void initialize(InputSplit input, TaskAttemptContext context) throws IOException, InterruptedException {

- // 获取split

- FileSplit split = (FileSplit)input;

- // 获取配置

- Configuration job = context.getConfiguration();

- // 分片路径

- Path file = split.getPath();

- FileSystem fs = file.getFileSystem(job);

- // 打开文件

- FSDataInputStream filein = fs.open(file);

- in = new LineReader(filein,job);

- }

- @Override

- public boolean nextKeyValue() throws IOException, InterruptedException {

- // 一行数据

- Text line = new Text();

- int linesize = in.readLine(line);

- if(linesize == 0)

- return false;

- // 通过分隔符'\t',将每行的数据解析成数组

- String[] pieces = line.toString().split("\t");

- if(pieces.length != 5){

- throw new IOException("Invalid record received");

- }

- int a,b,c;

- try{

- // 粉丝

- a = Integer.parseInt(pieces[2].trim());

- // 关注

- b = Integer.parseInt(pieces[3].trim());

- // 微博数

- c = Integer.parseInt(pieces[4].trim());

- }catch(NumberFormatException nfe){

- throw new IOException("Error parsing floating poing value in record");

- }

- //自定义key和value值

- lineKey.set(pieces[0]);

- lineValue.set(a, b, c);

- return true;

- }

- @Override

- public void close() throws IOException {

- if(in != null){

- in.close();

- }

- }

- @Override

- public Text getCurrentKey() throws IOException, InterruptedException {

- return lineKey;

- }

- @Override

- public WeiBo getCurrentValue() throws IOException, InterruptedException {

- return lineValue;

- }

- @Override

- public float getProgress() throws IOException, InterruptedException {

- return 0;

- }

- }

- }

3)、编写mr程序

- package com.buaa;

- import java.io.IOException;

- import java.util.Arrays;

- import java.util.Comparator;

- import java.util.HashMap;

- import java.util.Map;

- import java.util.Map.Entry;

- import org.apache.hadoop.conf.Configuration;

- import org.apache.hadoop.conf.Configured;

- import org.apache.hadoop.fs.FileSystem;

- import org.apache.hadoop.fs.Path;

- import org.apache.hadoop.io.IntWritable;

- import org.apache.hadoop.io.Text;

- import org.apache.hadoop.mapreduce.Job;

- import org.apache.hadoop.mapreduce.Mapper;

- import org.apache.hadoop.mapreduce.Reducer;

- import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

- import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

- import org.apache.hadoop.mapreduce.lib.output.LazyOutputFormat;

- import org.apache.hadoop.mapreduce.lib.output.MultipleOutputs;

- import org.apache.hadoop.mapreduce.lib.output.TextOutputFormat;

- import org.apache.hadoop.util.Tool;

- import org.apache.hadoop.util.ToolRunner;

- /**

- * @ProjectName MicroblogStar

- * @PackageName com.buaa

- * @ClassName WeiboCount

- * @Description TODO

- * @Author 刘吉超

- * @Date 2016-05-07 09:07:36

- */

- public class WeiboCount extends Configured implements Tool {

- // tab分隔符

- private static String TAB_SEPARATOR = "\t";

- // 粉丝

- private static String FAN = "fan";

- // 关注

- private static String FOLLOWERS = "followers";

- // 微博数

- private static String MICROBLOGS = "microblogs";

- public static class WeiBoMapper extends Mapper<Text, WeiBo, Text, Text> {

- @Override

- protected void map(Text key, WeiBo value, Context context) throws IOException, InterruptedException {

- // 粉丝

- context.write(new Text(FAN), new Text(key.toString() + TAB_SEPARATOR + value.getFan()));

- // 关注

- context.write(new Text(FOLLOWERS), new Text(key.toString() + TAB_SEPARATOR + value.getFollowers()));

- // 微博数

- context.write(new Text(MICROBLOGS), new Text(key.toString() + TAB_SEPARATOR + value.getMicroblogs()));

- }

- }

- public static class WeiBoReducer extends Reducer<Text, Text, Text, IntWritable> {

- private MultipleOutputs<Text, IntWritable> mos;

- protected void setup(Context context) throws IOException, InterruptedException {

- mos = new MultipleOutputs<Text, IntWritable>(context);

- }

- protected void reduce(Text Key, Iterable<Text> Values,Context context) throws IOException, InterruptedException {

- Map<String,Integer> map = new HashMap< String,Integer>();

- for(Text value : Values){

- // value = 名称 + (粉丝数 或 关注数 或 微博数)

- String[] records = value.toString().split(TAB_SEPARATOR);

- map.put(records[0], Integer.parseInt(records[1].toString()));

- }

- // 对Map内的数据进行排序

- Map.Entry<String, Integer>[] entries = getSortedHashtableByValue(map);

- for(int i = 0; i < entries.length;i++){

- mos.write(Key.toString(),entries[i].getKey(), entries[i].getValue());

- }

- }

- protected void cleanup(Context context) throws IOException, InterruptedException {

- mos.close();

- }

- }

- @SuppressWarnings("deprecation")

- @Override

- public int run(String[] args) throws Exception {

- // 配置文件对象

- Configuration conf = new Configuration();

- // 判断路径是否存在,如果存在,则删除

- Path mypath = new Path(args[1]);

- FileSystem hdfs = mypath.getFileSystem(conf);

- if (hdfs.isDirectory(mypath)) {

- hdfs.delete(mypath, true);

- }

- // 构造任务

- Job job = new Job(conf, "weibo");

- // 主类

- job.setJarByClass(WeiboCount.class);

- // Mapper

- job.setMapperClass(WeiBoMapper.class);

- // Mapper key输出类型

- job.setMapOutputKeyClass(Text.class);

- // Mapper value输出类型

- job.setMapOutputValueClass(Text.class);

- // Reducer

- job.setReducerClass(WeiBoReducer.class);

- // Reducer key输出类型

- job.setOutputKeyClass(Text.class);

- // Reducer value输出类型

- job.setOutputValueClass(IntWritable.class);

- // 输入路径

- FileInputFormat.addInputPath(job, new Path(args[0]));

- // 输出路径

- FileOutputFormat.setOutputPath(job, new Path(args[1]));

- // 自定义输入格式

- job.setInputFormatClass(WeiboInputFormat.class) ;

- //自定义文件输出类别

- MultipleOutputs.addNamedOutput(job, FAN, TextOutputFormat.class, Text.class, IntWritable.class);

- MultipleOutputs.addNamedOutput(job, FOLLOWERS, TextOutputFormat.class, Text.class, IntWritable.class);

- MultipleOutputs.addNamedOutput(job, MICROBLOGS, TextOutputFormat.class, Text.class, IntWritable.class);

- // 去掉job设置outputFormatClass,改为通过LazyOutputFormat设置

- LazyOutputFormat.setOutputFormatClass(job, TextOutputFormat.class);

- //提交任务

- return job.waitForCompletion(true)?0:1;

- }

- // 对Map内的数据进行排序(只适合小数据量)

- @SuppressWarnings("unchecked")

- public static Entry<String, Integer>[] getSortedHashtableByValue(Map<String, Integer> h) {

- Entry<String, Integer>[] entries = (Entry<String, Integer>[]) h.entrySet().toArray(new Entry[0]);

- // 排序

- Arrays.sort(entries, new Comparator<Entry<String, Integer>>() {

- public int compare(Entry<String, Integer> entry1, Entry<String, Integer> entry2) {

- return entry2.getValue().compareTo(entry1.getValue());

- }

- });

- return entries;

- }

- public static void main(String[] args) throws Exception {

- String[] args0 = {

- "hdfs://ljc:9000/buaa/microblog/weibo.txt",

- "hdfs://ljc:9000/buaa/microblog/out/"

- };

- int ec = ToolRunner.run(new Configuration(), new WeiboCount(), args0);

- System.exit(ec);

- }

- }

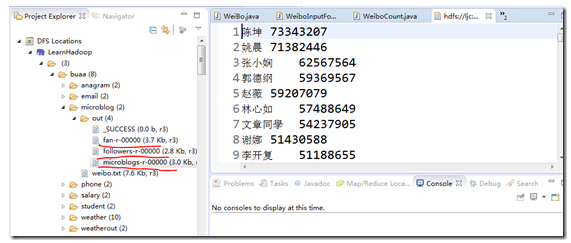

5、运行结果

本文作者:刘超ljc

来源:51CTO

利用 MapReduce分析明星微博数据实战相关推荐

- MapReduce分析明星微博数据

互联网时代的到来,使得名人的形象变得更加鲜活,也拉近了明星和粉丝之间的距离.歌星.影星.体育明星.作家等名人通过互联网能够轻易实现和粉丝的互动,赚钱也变得前所未有的简单.同时,互联网的飞速发展本身也造 ...

- Hadoop实战系列之MapReduce 分析 Youtube视频数据

Hadoop实战系列之MapReduce 分析 Youtube视频数据 一.实战介绍 MapReduce 是 Hadoop 的计算框架. 在运行一个 MR 程序时,任务过程被分为两个阶段:Map 阶段 ...

- 利用ELK分析Nginx日志生产实战(高清多图)

本文以api.mingongge.com.cn域名为测试对象进行统计,日志为crm.mingongge.com.cn和risk.mingongge.com.cn请求之和(此二者域名不具生产换环境统计意 ...

- 利用机器学习分析脑电数据(原理分析+示例代码+快速上手)

由于本人对于脑机接口以及脑电技术的极度爱好(其实目的是:是把U盘插到大脑里,然后就不用学习了哈哈哈哈),近几月看了较多这方面的内容,变打算写下博客总结分析一下. 目录 一. 机器学习分析简介 二.机 ...

- 爬虫实例 利用Ajax爬取微博数据

随着代理IP技术的普及,爬虫的使用也变得简单起来,许多企业和个人都开始用爬虫技术来抓取数据.那么今天就来分享一个爬虫实例,帮助你们更好的理解爬虫.下面我们用程序模拟Ajax请求,将我的前10页微博全部 ...

- 进阶分享 | 7000字,利用Python分析泰坦尼克数据

目录 排名 数据探索 导入库 导入数据 字段信息 字段分类 缺失值 数据假设 删除字段 修改.增加字段 猜想 统计分析 可视化分析 年龄与生还 舱位与生还 登船地点.性别与生还的关系 票价.舱位与生还 ...

- 利用Spring Boot处理JSON数据实战(包括jQuery,html,ajax)附源码 超详细

在Spring Boot的Web应用中 内置了JSON数据的解析功能,默认使用Jackson自动完成解析(不需要解析加载Jackson依赖包)当控制器返回一个Java对象或集合数据时 Spring B ...

- CentOS 7.2下ELK分析Nginx日志生产实战(高清多图)

注:本文系原创投稿 本文以api.mingongge.com.cn域名为测试对象进行统计,日志为crm.mingongge.com.cn和risk.mingongge.com.cn请求之和(此二者域名 ...

- python处理excel表格数据-利用Python处理和分析Excel表中数据实战.doc

利用Python处理和分析Excel表中数据实战 [利用python进行数据分析--基础篇]利用Python处理和分析Excel表中数据实战 原创 2017年06月28日 15:09:32 标签: p ...

最新文章

- odoo pivot中去掉求和_一文读懂深度学习中的卷积运算与图像处理

- linux kernel 三次握手建立TCP链接的实现

- Python基础教程笔记——条件,循环和其他语句

- 命令行重启Oracle数据库

- 部份API学习笔记(Math,System,Object,Date,SimpleDateFormat)

- 辽宁计算机专业院校排名2015,liaoning高校排行榜_辽宁高校排名 2015年辽宁省最佳大学排行榜...

- Python Logging Loggers

- Chrome浏览器插件之---AdBlock和Adblock Plus

- 一些牛人博客,值得收藏和学习

- HD地址批量生成 java

- 便利蜂创始人数字化经验分享:如何用全链路数字化 重塑零售业

- 案例:微博传播引爆点

- 2022年度Top9的任务管理系统

- win10“我们找不到你的相机“,错误代码0xA00F4244<NoCamerasAttached>解决方法

- 升平,景玉军.计算机虚拟技术在高职汽车维修教学中的应用研究[j].,汽车新技术教学方法探讨...

- ocx 加载 页面卡死

- JS(五):JS的window对象之window相关方法、定时器

- XP电脑桌面图标文字带上颜色不透明 解决办法

- IOI2018退役记 + NOIP2018游记

- java动态代理(AOP)