用JAVA爬虫爬网站的图片

首先,没有HTML和CSS和JS和AJAX经验的建议先去W3C(点我点我)小小的了解一下。

说到HTML,这里就涉及到一个GET访问和POST访问的问题。

如果对这个方面缺乏了解可以阅读W3C的这篇:《GET对比POST》。

啊哈,在此不再赘述。

然后咧,接下来我们需要用Java来爬取一个网页的内容。

这时候,我们的百度就要派上用场了。

没错,他不再是那个默默无闻的网速测试器了,他即将成为我们的爬虫小白鼠!~

我们先来看看百度的首页:

相信大家都知道,现在这样的一个页面,是HTML和CSS共同工作的结果。

我们在浏览器中右击页面,选择“查看页面源代码”:

没错,就是这一坨翔一样的东西。这就是百度页面的源代码。

接下来我们的任务,就是使用我们的爬虫也获取到一样的东西。

先来看一段简单的源码:

import java.io.*;

import java.net.*;

public class Main {public static void main(String[] args) {// 定义即将访问的链接String url = "http://www.baidu.com";// 定义一个字符串用来存储网页内容String result = "";// 定义一个缓冲字符输入流BufferedReader in = null;try {// 将string转成url对象URL realUrl = new URL(url);// 初始化一个链接到那个url的连接URLConnection connection = realUrl.openConnection();// 开始实际的连接connection.connect();// 初始化 BufferedReader输入流来读取URL的响应in = new BufferedReader(new InputStreamReader(connection.getInputStream()));// 用来临时存储抓取到的每一行的数据String line;while ((line = in.readLine()) != null) {//遍历抓取到的每一行并将其存储到result里面result += line;}} catch (Exception e) {System.out.println("发送GET请求出现异常!" + e);e.printStackTrace();}// 使用finally来关闭输入流finally {try {if (in != null) {in.close();}} catch (Exception e2) {e2.printStackTrace();}}System.out.println(result);}

}以上就是Java模拟Get访问百度的Main方法,

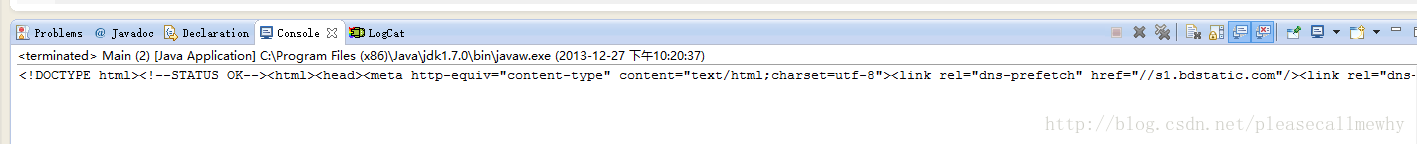

可以运行一下看看结果:

啊哈,和我们前面用浏览器看到的一模一样。至此,一个最最简单的爬虫就算是做好了。

但是这么一大坨东西未必都是我想要的啊,怎么从中抓取出我想要的东西呢?

以百度的大爪子Logo为例。

临时需求:

获取百度Logo的大爪子的图片链接。

先说一下浏览器的查看方法。

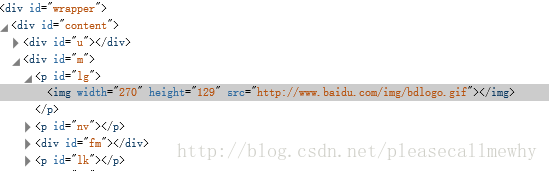

鼠标对图片右击,选择审查元素(火狐,谷歌,IE11,均有此功能,只是名字不太一样):

啊哈,可以看到在一大堆div的围攻下的可怜的img标签。

这个src就是图像的链接了。

那么在java中我们怎么搞呢?

事先说明,为了方便演示代码,所有代码均未作类封装,还请谅解。

我们先把前面的代码封装成一个sendGet函数:

import java.io.*;

import java.net.*;

public class Main {static String sendGet(String url) {// 定义一个字符串用来存储网页内容String result = "";// 定义一个缓冲字符输入流BufferedReader in = null;try {// 将string转成url对象URL realUrl = new URL(url);// 初始化一个链接到那个url的连接URLConnection connection = realUrl.openConnection();// 开始实际的连接connection.connect();// 初始化 BufferedReader输入流来读取URL的响应in = new BufferedReader(new InputStreamReader(connection.getInputStream()));// 用来临时存储抓取到的每一行的数据String line;while ((line = in.readLine()) != null) {// 遍历抓取到的每一行并将其存储到result里面result += line;}} catch (Exception e) {System.out.println("发送GET请求出现异常!" + e);e.printStackTrace();}// 使用finally来关闭输入流finally {try {if (in != null) {in.close();}} catch (Exception e2) {e2.printStackTrace();}}return result;}public static void main(String[] args) {// 定义即将访问的链接String url = "http://www.baidu.com";// 访问链接并获取页面内容String result = sendGet(url);System.out.println(result);}

}这样看起来稍微整洁了一点,请原谅我这个强迫症。

接下来的任务,就是从获取到的一大堆东西里面找到那个图片的链接。

我们首先可以想到的方法,是对页面源码的字符串result使用indexof函数进行String的子串搜索。

没错这个方法是可以慢慢解决这个问题,比如直接indexOf("src")找到开始的序号,然后再稀里哗啦的搞到结束的序号。

不过我们不能一直使用这种方法,毕竟草鞋只适合出门走走,后期还是需要切假腿来拿人头的。

请原谅我的乱入,继续。

那么我们用什么方式来寻找这张图片的src呢?

没错,正如下面观众所说,正则匹配。

如果有同学不太清楚正则,可以参照这篇文章:[Python]网络爬虫(七):Python中的正则表达式教程。

简单来说,正则就像是匹配。

比如三个胖子站在这里,分别穿着红衣服,蓝衣服,绿衣服。

正则就是:抓住那个穿绿衣服的!

然后把绿胖子单独抓了出来。

就是这么简单。

但是正则的语法却还是博大精深的,刚接触的时候难免有点摸不着头脑,

向大家推荐一个正则的在线测试工具:正则表达式在线测试。

有了正则这个神兵利器,那么怎么在java里面使用正则呢?

先来看个简单的小李子吧。

啊错了,小栗子。

// 定义一个样式模板,此中使用正则表达式,括号中是要抓的内容// 相当于埋好了陷阱匹配的地方就会掉下去Pattern pattern = Pattern.compile("href=\"(.+?)\"");// 定义一个matcher用来做匹配Matcher matcher = pattern.matcher("<a href=\"index.html\">我的主页</a>");// 如果找到了if (matcher.find()) {// 打印出结果System.out.println(matcher.group(1));}运行结果:

index.html

没错,这就是我们的第一个正则代码。

这样应用的抓取图片的链接想必也是信手拈来了。

我们将正则匹配封装成一个函数,然后将代码作如下修改:

import java.io.*;

import java.net.*;

import java.util.regex.*;

public class Main {static String SendGet(String url) {// 定义一个字符串用来存储网页内容String result = "";// 定义一个缓冲字符输入流BufferedReader in = null;try {// 将string转成url对象URL realUrl = new URL(url);// 初始化一个链接到那个url的连接URLConnection connection = realUrl.openConnection();// 开始实际的连接connection.connect();// 初始化 BufferedReader输入流来读取URL的响应in = new BufferedReader(new InputStreamReader(connection.getInputStream()));// 用来临时存储抓取到的每一行的数据String line;while ((line = in.readLine()) != null) {// 遍历抓取到的每一行并将其存储到result里面result += line;}} catch (Exception e) {System.out.println("发送GET请求出现异常!" + e);e.printStackTrace();}// 使用finally来关闭输入流finally {try {if (in != null) {in.close();}} catch (Exception e2) {e2.printStackTrace();}}return result;}static String RegexString(String targetStr, String patternStr) {// 定义一个样式模板,此中使用正则表达式,括号中是要抓的内容// 相当于埋好了陷阱匹配的地方就会掉下去Pattern pattern = Pattern.compile(patternStr);// 定义一个matcher用来做匹配Matcher matcher = pattern.matcher(targetStr);// 如果找到了if (matcher.find()) {// 打印出结果return matcher.group(1);}return "";}public static void main(String[] args) {// 定义即将访问的链接String url = "http://www.baidu.com";// 访问链接并获取页面内容String result = SendGet(url);// 使用正则匹配图片的src内容String imgSrc = RegexString(result, "即将的正则语法");// 打印结果System.out.println(imgSrc);}

}好的,现在万事俱备,只差一个正则语法了!

那么用什么正则语句比较合适呢?

我们发现只要抓住了src="xxxxxx"这个字符串,就能抓出整个src链接,

所以简单的正则语句:src=\"(.+?)\"

完整代码如下:

import java.io.*;

import java.net.*;

import java.util.regex.*;

public class Main {static String SendGet(String url) {// 定义一个字符串用来存储网页内容String result = "";// 定义一个缓冲字符输入流BufferedReader in = null;try {// 将string转成url对象URL realUrl = new URL(url);// 初始化一个链接到那个url的连接URLConnection connection = realUrl.openConnection();// 开始实际的连接connection.connect();// 初始化 BufferedReader输入流来读取URL的响应in = new BufferedReader(new InputStreamReader(connection.getInputStream()));// 用来临时存储抓取到的每一行的数据String line;while ((line = in.readLine()) != null) {// 遍历抓取到的每一行并将其存储到result里面result += line;}} catch (Exception e) {System.out.println("发送GET请求出现异常!" + e);e.printStackTrace();}// 使用finally来关闭输入流finally {try {if (in != null) {in.close();}} catch (Exception e2) {e2.printStackTrace();}}return result;}static String RegexString(String targetStr, String patternStr) {// 定义一个样式模板,此中使用正则表达式,括号中是要抓的内容// 相当于埋好了陷阱匹配的地方就会掉下去Pattern pattern = Pattern.compile(patternStr);// 定义一个matcher用来做匹配Matcher matcher = pattern.matcher(targetStr);// 如果找到了if (matcher.find()) {// 打印出结果return matcher.group(1);}return "Nothing";}public static void main(String[] args) {// 定义即将访问的链接String url = "http://www.baidu.com";// 访问链接并获取页面内容String result = SendGet(url);// 使用正则匹配图片的src内容String imgSrc = RegexString(result, "src=\"(.+?)\"");// 打印结果System.out.println(imgSrc);}

}这样我们就能用java抓出百度LOGO的链接了。

好吧虽然花了很多时间讲百度,但是基础要打扎实啦,下次我们正式开始抓知乎咯!~

这里一定要看:

上述只是在控制台显示图片的路径,并咩有保存到本地,那么我们继续往下走,

java根据图片的url地址下载图片到本地

- package demo;

- import java.io.ByteArrayOutputStream;

- import java.io.DataInputStream;

- import java.io.File;

- import java.io.FileOutputStream;

- import java.io.IOException;

- import java.net.MalformedURLException;

- import java.net.URL;

- public class DownloadPicFromURL {

- public static void main(String[] args) {

- String url = "http://192.168.1.158/estun_cs/banner_img/head_pic.jpg";

- String path="d:/test/pic.jpg";

- downloadPicture(url,path);

- }

- //链接url下载图片

- private static void downloadPicture(String urlList,String path) {

- URL url = null;

- try {

- url = new URL(urlList);

- DataInputStream dataInputStream = new DataInputStream(url.openStream());

- FileOutputStream fileOutputStream = new FileOutputStream(new File(path));

- ByteArrayOutputStream output = new ByteArrayOutputStream();

- byte[] buffer = new byte[1024];

- int length;

- while ((length = dataInputStream.read(buffer)) > 0) {

- output.write(buffer, 0, length);

- }

- fileOutputStream.write(output.toByteArray());

- dataInputStream.close();

- fileOutputStream.close();

- } catch (MalformedURLException e) {

- e.printStackTrace();

- } catch (IOException e) {

- e.printStackTrace();

- }

- }

- }

那么综上所述:完整代码:

import java.io.*;

import java.net.*;

import java.util.regex.*;

public class Main {static String SendGet(String url) {// 定义一个字符串用来存储网页内容

String result = "";// 定义一个缓冲字符输入流

BufferedReader in = null;try {// 将string转成url对象

URL realUrl = new URL(url);// 初始化一个链接到那个url的连接

URLConnection connection = realUrl.openConnection();// 开始实际的连接

connection.connect();// 初始化 BufferedReader输入流来读取URL的响应

in = new BufferedReader(new InputStreamReader(connection.getInputStream()));// 用来临时存储抓取到的每一行的数据

String line;while ((line = in.readLine()) != null) {// 遍历抓取到的每一行并将其存储到result里面

result += line;}} catch (Exception e) {System.out.println("发送GET请求出现异常!" + e);e.printStackTrace();}// 使用finally来关闭输入流

finally {try {if (in != null) {in.close();}} catch (Exception e2) {e2.printStackTrace();}}return result;}//链接url下载图片

private static void downloadPicture(String urlList,String path) {URL url = null;try {url = new URL(urlList);DataInputStream dataInputStream = new DataInputStream(url.openStream());FileOutputStream fileOutputStream = new FileOutputStream(new File(path));ByteArrayOutputStream output = new ByteArrayOutputStream();byte[] buffer = new byte[999999999];int length;while ((length = dataInputStream.read(buffer)) > 0) {output.write(buffer, 0, length);}fileOutputStream.write(output.toByteArray());dataInputStream.close();fileOutputStream.close();} catch (MalformedURLException e) {e.printStackTrace();} catch (IOException e) {e.printStackTrace();}}static String RegexString(String targetStr, String patternStr) {// 定义一个样式模板,此中使用正则表达式,括号中是要抓的内容

// 相当于埋好了陷阱匹配的地方就会掉下去

Pattern pattern = Pattern.compile(patternStr);// 定义一个matcher用来做匹配

Matcher matcher = pattern.matcher(targetStr);// 如果找到了

if (matcher.find()) {// 打印出结果

return matcher.group(1);}return "Nothing";}public static void main(String[] args) {// 定义即将访问的链接

String url = "http://www.baidu.com";// 访问链接并获取页面内容

String result = SendGet(url);System.out.println(result);// 使用正则匹配图片的src内容

String imgSrc = RegexString(result, "src=//(.+?) width");// 打印结果

String isUrl = String.format("http://%s",imgSrc);System.out.println(isUrl);//路径

String path="D:/upload/1111.png";downloadPicture(isUrl,path);}

}有不懂的地方留言,我会一一解答

用JAVA爬虫爬网站的图片相关推荐

- Java爬虫爬取wallhaven的图片

Java爬虫爬取wallhaven的图片 参考文章:JAVA Jsoup爬取网页图片下载到本地 需要的jar包:jsuop wallhaven网站拒绝java程序访问,所以要伪装报头. 发送请求时 C ...

- Java爬虫 --- 爬取王者荣耀英雄图片

Java爬虫 - 爬取王者荣耀英雄图片 import org.jsoup.Connection; import org.jsoup.Jsoup; import org.jsoup.nodes.Docu ...

- Java爬虫 爬取某招聘网站招聘信息

Java爬虫 爬取某招聘网站招聘信息 一.系统介绍 二.功能展示 1.需求爬取的网站内容 2.实现流程 2.1数据采集 2.2页面解析 2.3数据存储 三.获取源码 一.系统介绍 系统主要功能:本项目 ...

- java爬虫爬某个网站的所有内容

java爬虫爬某个网站的所有内容 ***首先,先看一下项目的结构 我们先从link包开始: sorry,还有pom.xml文件: <?xml version="1.0" en ...

- Java爬虫爬取 天猫 淘宝 京东 搜索页和 商品详情

Java爬虫爬取 天猫 淘宝 京东 搜索页和 商品详情 先识别商品url,区分平台提取商品编号,再根据平台带着商品编号爬取数据. 1.导包 <!-- 爬虫相关Jar包依赖 --><d ...

- python java 爬数据_如何用java爬虫爬取网页上的数据

当我们使用浏览器处理网页的时候,有时候是不需要浏览的,例如使用PhantomJS适用于无头浏览器,进行爬取网页数据操作.最近在进行java爬虫学习的小伙伴们有没有想过如何爬取js生成的网络页面吗?别急 ...

- 我的第一个开源项目:Java爬虫爬取旧版正方教务系统课程表、成绩表

Java爬虫爬取旧版正方教务系统课程表.成绩表 一.项目展示 1.正方教务系统 首页 2.爬虫系统 首页: 成绩查询: 课表查询: 二.项目实现 1.爬取思路描述 无论是成绩查询或课表查询亦或者其它的 ...

- python爬虫,爬取下载图片

python爬虫,爬取下载图片 分别引入以下三个包 from urllib.request import urlopen from bs4 import BeautifulSoup import re ...

- node:爬虫爬取网页图片 1

代码地址如下: http://www.demodashi.com/demo/13845.html 前言 周末自己在家闲着没事,刷着微信,玩着手机,发现自己的微信头像该换了,就去网上找了一下头像,看着图 ...

- 小爬虫爬取小猫咪图片并存入本地文件夹

小爬虫爬取小猫咪图片并存入本地文件夹 本人是安徽工业大学电气与信息工程学院研一学生,最近还不能开学真的是很糟心哦,由于自己比较笨吧,起步较晚还要忙着学习机器学习还有计算机视觉,但是总学这个感觉很闷也没 ...

最新文章

- 《Engineering》评选2021年全球十大工程成就 | 中国工程院院刊

- Intellij IDEA调试功能使用总结

- 【VC基础】 4、变式表(Variant Table)

- 为一个优秀的C++程序员

- mysql aggregate_SQL语句之Aggregate函数

- 设置访问权限_【新思考教学者思】李世松:不要对经典设置访问权限

- 基于jQuery/zepto的单页应用(SPA)搭建方案

- “东数西算”,全国一体化算力网络八大枢纽节点批复函+图解

- Kylin, Mondrian, Saiku系统的整合

- ul 响应式 布局_HTML5中响应式布局怎么弄??

- [工具] CuteMarkEd

- 一条长为L的绳子,一面靠墙,另外三边组成矩形,问此矩形最大面积能是多少?...

- 电池pack结构_锂电池pack性能测试标准,电池测试模组就选弹片微针模组

- 博为峰Java技术文章 ——JavaSE Swing JInternalFrame内部窗体面板II

- 山东大学软件学院计算机组成原理课程设计实验四

- 2022最新高级java面试题

- 推荐一本 Bulma 的书《使用Bulma来创建用户界面》

- 第二人生的源码分析(101)脚本的初步知识

- java 菱形继承_菱形继承与菱形虚拟继承

- Phython环境搭建

热门文章

- docker 自动签到模板制作

- java中的String和ArrayList类

- 饭饭的Selenium+xlwt笔记

- 两个int类型数据交换的神级操作

- 半闲居士视觉SLAM十四讲笔记(3)三维空间刚体运动 - part 3 旋转向量、欧拉角、四元数

- idea的英文是什么意思_idea,是什么意思

- buildroot学习(七)——at91sam9g45软件平台更新

- python爬取虾米音乐_【个人】爬虫实践,利用xpath方式爬取数据之爬取虾米音乐排行榜...

- 【踩坑日记】python3.9安装paddlepaddle-tiny的时候报错ERROR: Could not find a version

- python输出奇数个数_Python实践|输出0-7组成八位奇数总数