node:爬虫爬取网页图片 1

代码地址如下:

http://www.demodashi.com/demo/13845.html

前言

周末自己在家闲着没事,刷着微信,玩着手机,发现自己的微信头像该换了,就去网上找了一下头像,看着图片,自己就想着作为一个码农,可以把这些图片都爬取下来做成一个微信小程序,说干就干,了解一下基本都知道怎么做了,整理分享一波给大家。

目录:

- 安装node,并下载依赖

- 搭建服务

- 请求我们要爬取的页面,返回json

安装node

我们开始安装node,可以去node官网下载node下载地址,下载完成后运行node使用,

node -v

安装成功后会出现你所安装的版本号。

接下来我们使用node, 打印出hello world,新建一个名为index.js文件输入

console.log('hello world')

运行这个文件

node index.js

就会在控制面板上输出hello world

搭建服务器

新建一个·名为node的文件夹

首先你需要下载express依赖

npm install express

在新建一个名为demo.js的文件

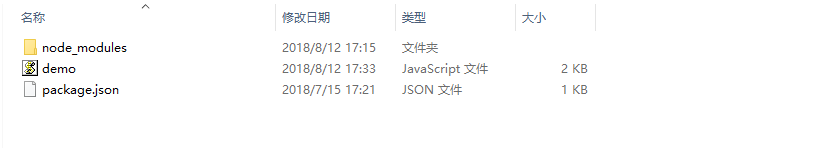

###项目目录结构

如图:

在demo.js引入下载的express

const express = require('express');

const app = express();

app.get('/index', function(req, res) {

res.end('111')

})

var server = app.listen(8081, function() {var host = server.address().addressvar port = server.address().portconsole.log("应用实例,访问地址为 http://%s:%s", host, port)})

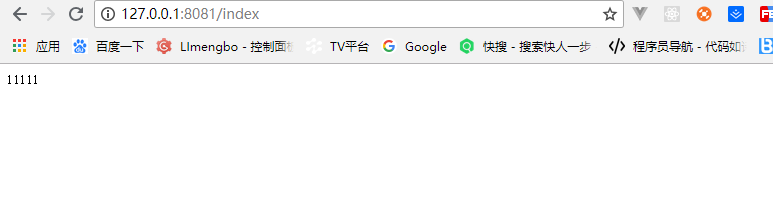

运行效果

运行node demo.js简单的服务就搭起来了,如图:

请求我们要爬取的页面

首先下载需要的依赖

npm install superagent

npm install superagent-charset

npm install cheerio

superagent 是用来发起请求的,是一个轻量的,渐进式的ajax api,可读性好,学习曲线低,内部依赖nodejs原生的请求api,适用于nodejs环境下.,也可以使用http发起请求

superagent-charset防止爬取下来的数据乱码,更改字符格式

cheerio为服务器特别定制的,快速、灵活、实施的jQuery核心实现.。

安装完依赖就可以引入了

var superagent = require('superagent');

var charset = require('superagent-charset');

charset(superagent);

const cheerio = require('cheerio');

引入之后就请求我们的地址,https://www.qqtn.com/tx/weixintx_1.html

const baseUrl = 'https://www.qqtn.com/'

这些设置完之后就是发请求了,接下来请看完整代码demo.js

var superagent = require('superagent');

var charset = require('superagent-charset');

charset(superagent);

var express = require('express');

var baseUrl = 'https://www.qqtn.com/'; //输入任何网址都可以

const cheerio = require('cheerio');

var app = express();

app.get('/index', function(req, res) {//设置请求头res.header("Access-Control-Allow-Origin", "*");res.header('Access-Control-Allow-Methods', 'PUT, GET, POST, DELETE, OPTIONS');res.header("Access-Control-Allow-Headers", "X-Requested-With");res.header('Access-Control-Allow-Headers', 'Content-Type');//类型var type = req.query.type;//页码var page = req.query.page;type = type || 'weixin';page = page || '1';var route = `tx/${type}tx_${page}.html`//网页页面信息是gb2312,所以chaeset应该为.charset('gb2312'),一般网页则为utf-8,可以直接使用.charset('utf-8')superagent.get(baseUrl + route).charset('gb2312').end(function(err, sres) {var items = [];if (err) {console.log('ERR: ' + err);res.json({ code: 400, msg: err, sets: items });return;}var $ = cheerio.load(sres.text);$('div.g-main-bg ul.g-gxlist-imgbox li a').each(function(idx, element) {var $element = $(element);var $subElement = $element.find('img');var thumbImgSrc = $subElement.attr('src');items.push({title: $(element).attr('title'),href: $element.attr('href'),thumbSrc: thumbImgSrc});});res.json({ code: 200, msg: "", data: items });});

});

var server = app.listen(8081, function() {var host = server.address().addressvar port = server.address().portconsole.log("应用实例,访问地址为 http://%s:%s", host, port)})

运行demo.js就会返回我们拿到的数据,一个简单的node爬虫就完成了。希望可以到 项目node爬虫 上点一个 star 作为你对这个项目的认可与支持,谢谢。

node:爬虫爬取网页图片

代码地址如下:

http://www.demodashi.com/demo/13845.html

注:本文著作权归作者,由demo大师发表,拒绝转载,转载需要作者授权

node:爬虫爬取网页图片 1相关推荐

- 上手快!!福利局!新手如何使用python爬虫爬取网页图片(使用正则进行数据解析)当然这个新手是我自己

作为一个python新入门小白,突然就想发个博客,一方面为了记录学习历程,一方面能分享给新入门的同学经验,更多的是想和大家一起学习和交流.以下是我以小白的角度分享的爬虫的相关知识和一个简单的爬取网页图 ...

- python爬虫爬取网页图片_Python爬虫:爬取网页图片

先分析查找要爬取图片的路径 在浏览器F12 审查元素 整体实现代码 # -- coding:UTF-8 -- import requests from bs4 import BeautifulSoup ...

- node:爬虫爬取网页图片

前言 周末自己在家闲着没事,刷着微信,玩着手机,发现自己的微信头像该换了,就去网上找了一下头像,看着图片,自己就想着作为一个码农,可以把这些图片都爬取下来做成一个微信小程序,说干就干,了解一下基本都知 ...

- python爬虫爬取网页图片_Python爬虫实现抓取网页图片

在逛贴吧的时候看见贴吧里面漂亮的图片,或有漂亮妹纸的图片,是不是想保存下来? 但是有的网页的图片比较多,一个个保存下来比较麻烦. 最近在学Python,所以用Python来抓取网页内容还是比较方便的: ...

- LSP是第一生产力 深夜开车,图片不够了怎么办?爪巴就完事了(爬虫爬取网页图片)

标题很明确了吧,我们如何才能在网页上爬取图片呢? 首先,打开一个网址:(就用这个举例子吧) http://www.win4000.com/wallpaper_2285_0_0_1.html 那么,ur ...

- python多线程爬取某网站全部h漫画_Python多线程爬虫爬取网页图片

'''基于多页面多线程''' import os #引入文件模块 import re #正则表达式 importurllib.requestimportthreading#连接网页并返回源码 defo ...

- python爬虫获取的网页数据为什么要加[0-python3爬虫爬取网页思路及常见问题(原创)...

学习爬虫有一段时间了,对遇到的一些问题进行一下总结. 爬虫流程可大致分为:请求网页(request),获取响应(response),解析(parse),保存(save). 下面分别说下这几个过程中可以 ...

- python爬取网页图片详解

文章目录 什么是爬虫 爬取网页图片实现步骤 第一步:打开所操作的网站(任意一个网站) 第二步:通过python访问这个网站 第三步:点击F12查询相关信息 第四步:爬取图片,下载到本地 第五步:显示测 ...

- node.js 爬虫 实现爬取网页图片并保存到本地

node.js 爬虫 实现爬取网页图片并保存到本地 没有废话直接看代码 /*** 请求网站数据* 将数据保存本地文件*/ //不同协议引用不同模块,http https const http = re ...

最新文章

- django学习笔记--数据库中的多表操作

- 【 FPGA 】状态机,FPGA的灵魂

- 组合模式java怎么获取钥匙_java中组合模式详解和使用方法

- python字符串反转方法_Python程序使用堆栈和反转方法反转字符串

- Linux下 查找大文件

- pdo_mysql未安装_php pdo_mysql未安装问题解决方法

- 七.(一)oc通知-NSNotification(通知中心-NSNotificationCenter)

- php获取laydate,laydate日历控件使用方法实例分享

- C++《STL和泛型编程》容器不带/带有成员函数总结

- java开发的windows程序工作机制_Windows程序运行原理及程序编写流程

- 扑克牌自定义排序,使用集合TreeSet实现实体对象排序,通过实现Comparable接口,重写compareTo比较器;

- 使用Redis构建全局并发锁

- 【九度OJ】题目1084:整数拆分

- LeetCode:18. 4Sum(Medium)

- celery 4.1下报kombu.exceptions.EncodeError: Object of type 'bytes' is not JSON serializable 处理方式...

- 想自学HCIE,有什么好的书籍推荐吗?

- Learning Music Notation 学习音乐符号 Lynda课程中文字幕

- oracle数据库报01033,oracle数据库报ORA-01033错误

- HTML5 全局属性

- div 自定义拉宽_纯Css实现Div高度根据自适应宽度(百分比)调整