【飞桨PaddleSpeech语音技术课程】— 语音唤醒

(以下内容搬运自飞桨PaddleSpeech语音技术课程,点击链接可直接运行源码)

1. KWS 概述

随着人工智能的飞速发展,市场上推出了各式各样的智能设备,AI 语音的发展更是使得语音助手成为各大智能终端设备必不可少的软件。语音是人类与设备最直接的交互方式,不需要和实物接触,可远程操控,对于人们来说是最方便自然的交流方式。

自动语音识别(Automatic Speech Recognition, ASR)是一种将语音转化为文字的技术,是人与机器、人与人自然交流的关键技术之一。ASR 是人与智能设备交互的入口,它的功能就是让设备”听懂“人类的语言,从而能够根据识别到的内容去完成人类想要让它做的事情。

语音唤醒(Keyword Spotting, KWS)是语音识别的入口,如何高效、准确地对用户指令给出反应成为这一技术的最重要的目标。

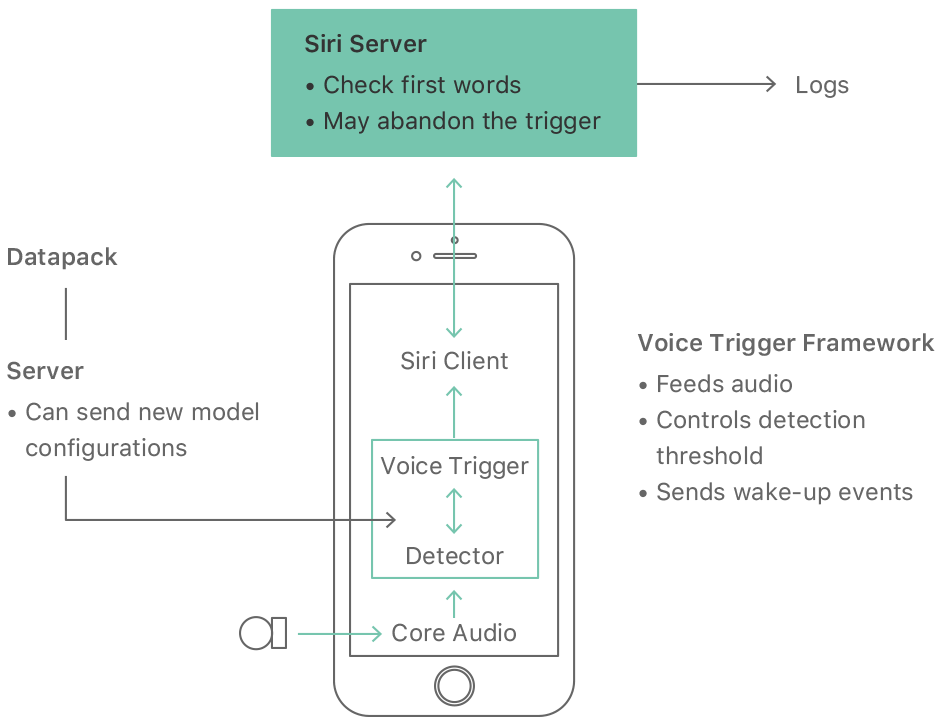

下图是 IPhone 中 Siri 语音助手的交互示意图,总体上可分为以下三个步骤:

- 麦克风持续检测声音信号

- 逐帧对声音信号进行特征提取和模型预测

- 当接收到一个完整的 “Hey Siri” 的语音时,此刻模型的得分达到最大值,触发唤醒事件

图片来源:https://machinelearning.apple.com/research/hey-siri

图片来源:https://machinelearning.apple.com/research/hey-siri  图片来源:https://machinelearning.apple.com/research/hey-siri

图片来源:https://machinelearning.apple.com/research/hey-siri

1.1 产品应用

Apple 广告中 Siri 语音助手的交互演示视频。

点击播放

1.2 KWS、ASR 和声音检测

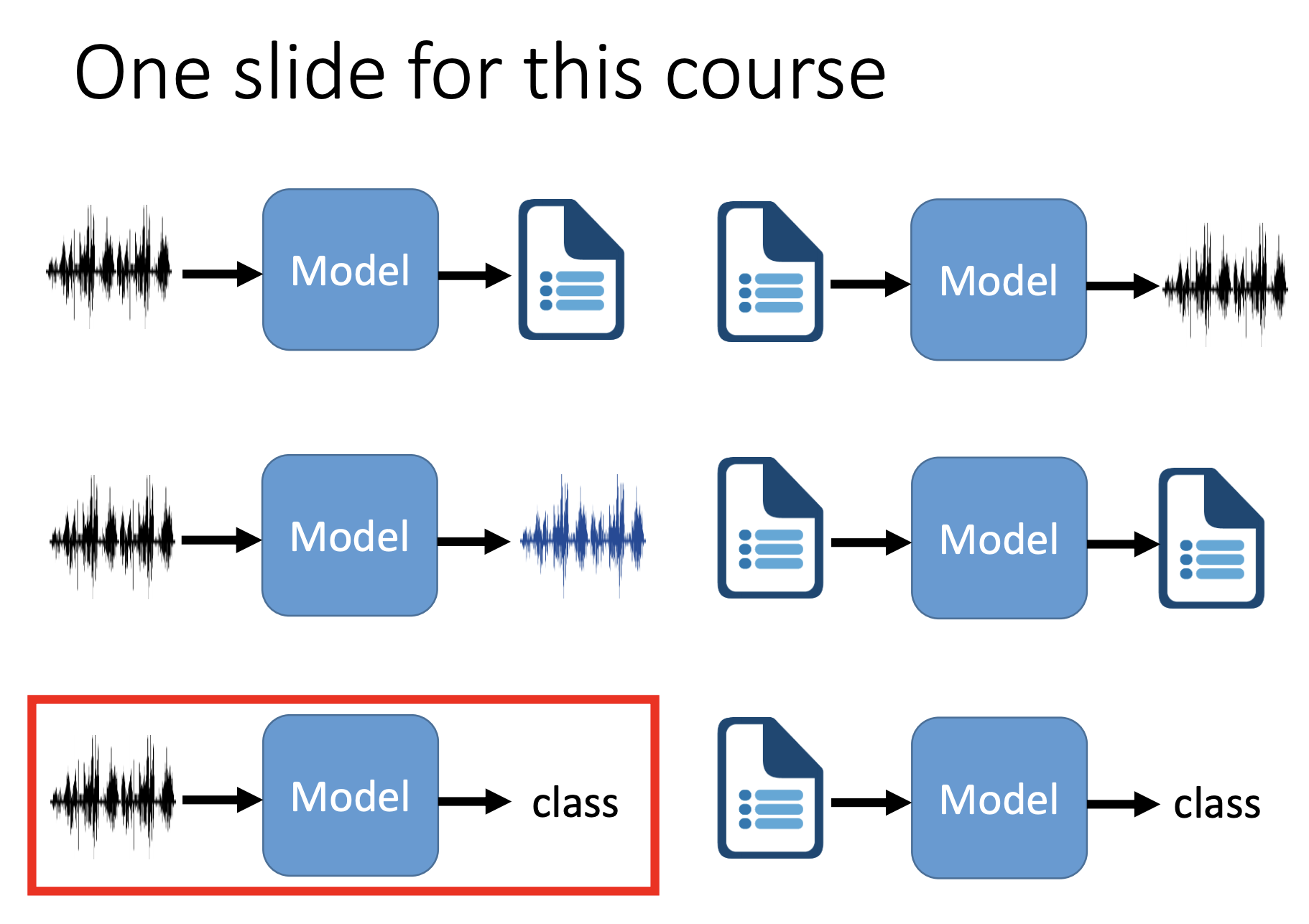

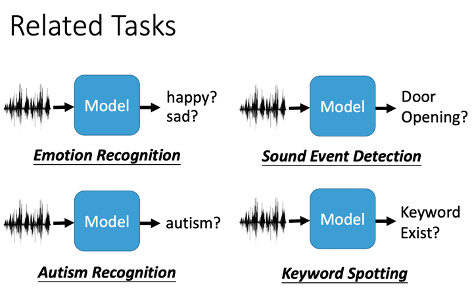

KWS、ASR 和声音检测的关系:

- KWS VS ASR:KWS 可以看作是一类特殊的 ASR,他只识别声音中的固定的关键词。ASR 需要语言模型来理解一段声音中的文字,而 KWS 仅需关注固定样式的发音。从模型输入输出的角度看,KWS 输入音频,输出是判别结果;ASR 输入音频,输出是文字序列。

- KWS VS 声音检测:KWS 和声音检测都是捕获特定的声音,KWS 注重语音中的关键词,而声音检测的范围更为宽泛,可以是自然界中的语音,工业领域里机器产生的声音,人类的哭声,尖叫声等异常声音。从模型输入输出的角度看,KWS 和声音检测都是输入音频,输出判别结果。

图片来源:http://speech.ee.ntu.edu.tw/~tlkagk/courses/DLHLP20/Speaker%20(v3).pdf

图片来源:http://speech.ee.ntu.edu.tw/~tlkagk/courses/DLHLP20/Speaker%20(v3).pdf

2. 适用于 KWS 的模型

2.1 传统 HMM 模型

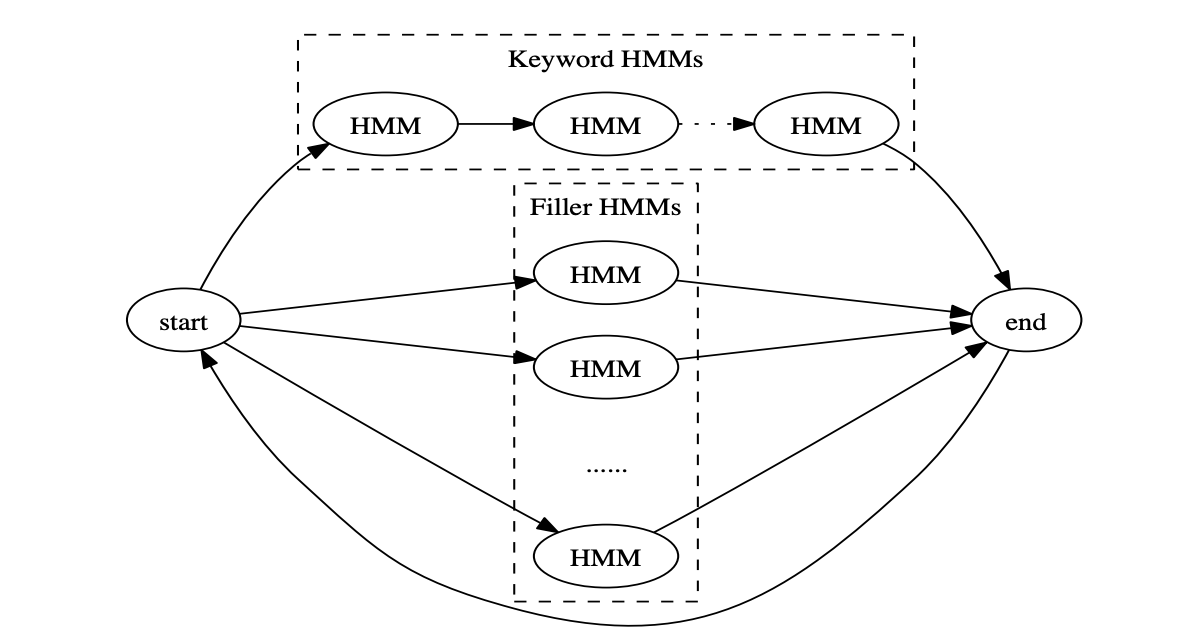

与语音识别 ASR 类似,KWS 可以用传统的 HMM 模型完成建模和识别,模型结构上是也是声学模型加解码器。

基于 HMM 的 KWS 模型和传统 ASR 模型的区别:

- 声学模型:KWS 只需关注少量的音素,对于其他发音可以当作 Filler 处理,因此声学模型的类别数可以做到很低,譬如在单音素建模下只需要 10 个以内;而 ASR 面向所有的发音,音素全,因此声学模型类别数会大很多。

- 解码器:ASR 的解码器是一个 FST,输入声学模型的结果输出文字序列;而 KWS 的解码器是一个 FSA,如果到达最终状态可以给出一个得分作为唤醒词的分数,解码图的大小相对于 ASR 会小很多。

图片来源:https://developer.nvidia.com/blog/how-to-build-domain-specific-automatic-speech-recognition-models-on-gpus

图片来源:https://developer.nvidia.com/blog/how-to-build-domain-specific-automatic-speech-recognition-models-on-gpus  图片来源:https://static.googleusercontent.com/media/research.google.com/zh-CN//pubs/archive/42537.pdf

图片来源:https://static.googleusercontent.com/media/research.google.com/zh-CN//pubs/archive/42537.pdf

2.2 端到端模型

2.2.1 基于后验概率平滑的模型

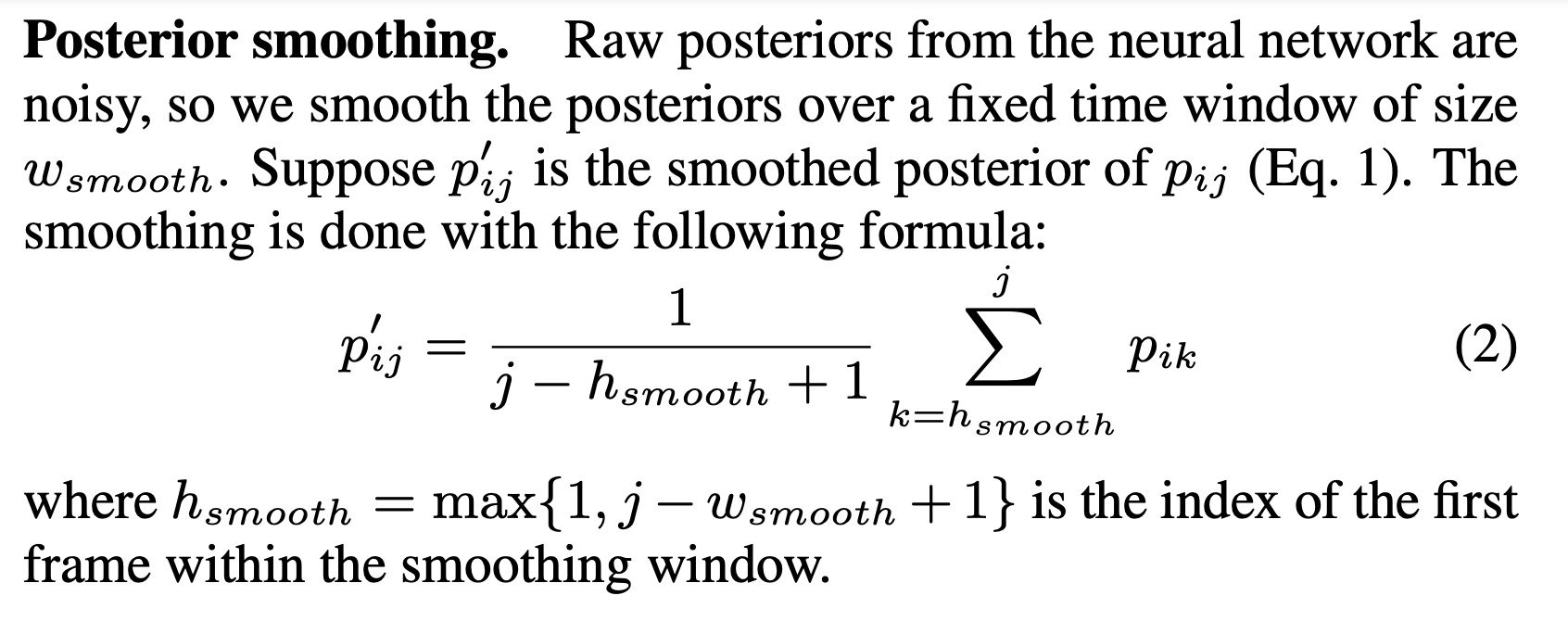

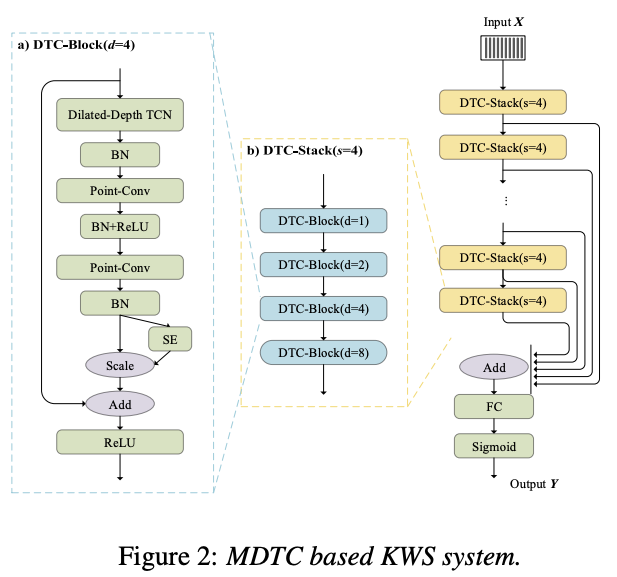

在 2014 年的文章 Small-footprint keyword spotting using deep neural networks 中,作者提出了一种基于神经网络加后验概率平滑的 KWS 方法,该方法利用词粒度来建模声学模型,可分为以下四个执行步骤:

- 特征提取和重叠:对音频信号进行逐帧的特征提取,预测每一帧的声学概率分布时,加入了上下文信息(前30帧+后10帧)后作为模型输入。

- 声学模型:对叠加了上下文信息的频域特征进行声学概率分布的预测,模型总共有 N 个标签,其中标签 0 为 Filler,将与唤醒词的发音无关的归类至此。

- 后验概率平滑:从声学模型得到整段音频的声学概率分布后,采用滑窗的进行后验概率平滑的计算,这么做可以去除一些噪音,增强鲁棒性。

- 唤醒词得分计算:引入一个得分窗口,在窗口内统计除 Filler 外的所有声学概率的最大值,通过累乘和开方的计算方式得到最终得分。

图片来源:https://ieeexplore.ieee.org/document/6854370

图片来源:https://ieeexplore.ieee.org/document/6854370

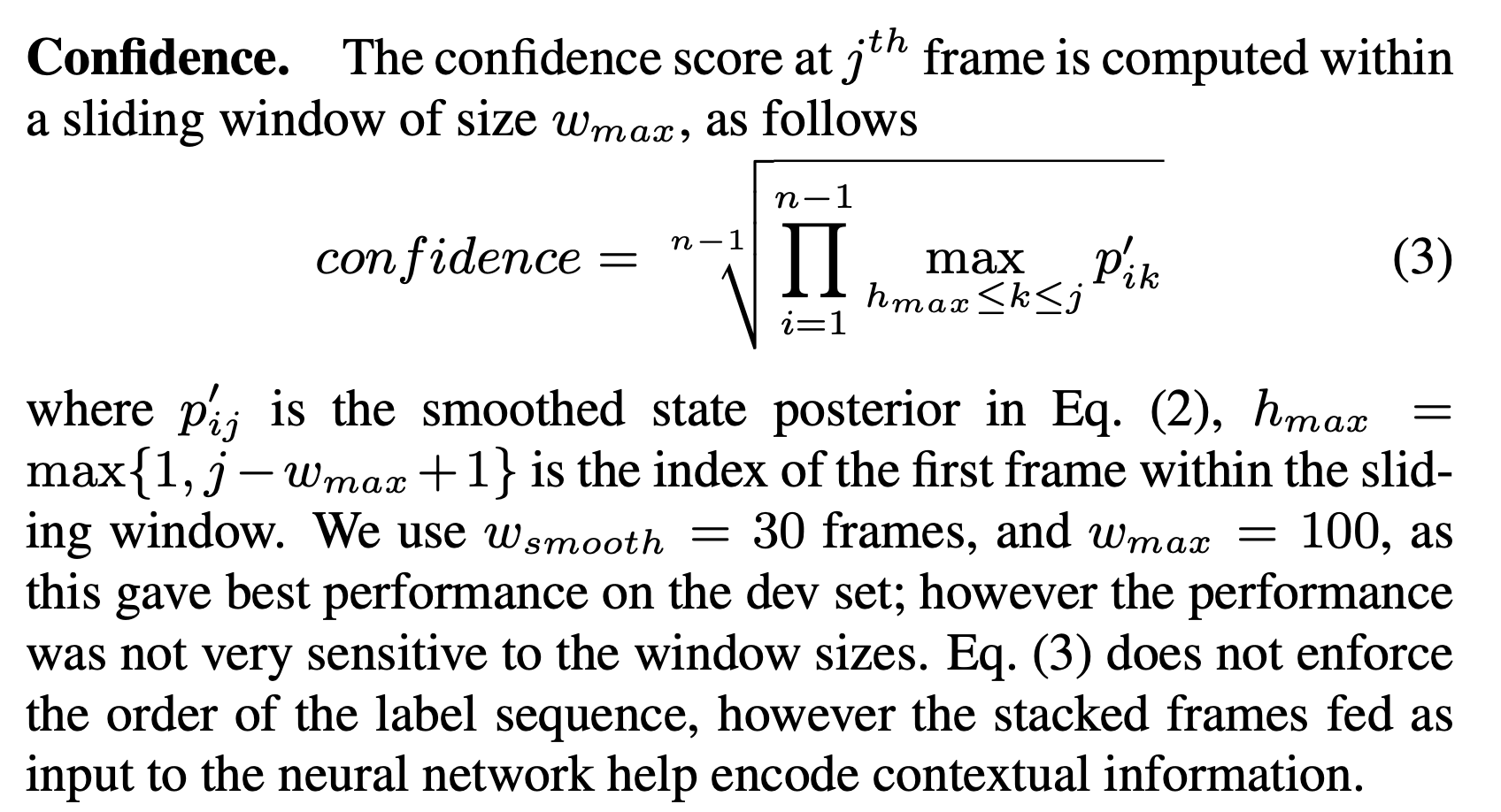

2.2.2 基于 Max-Pooling Loss 的模型

在 2017 年的文章 Max-Pooling Loss Training of Long Short-Term Memory Networks for Small-Footprint Keyword Spotting 中,作者提出了一种基于 Max-Pooling Loss 的 KWS 模型训练方法。

这种方法可以看作是从帧级别的训练方式转向段级别的训练方式,如下图所示,蓝色填充的帧是唤醒词,在训练阶段,模型对于唤醒词片段的得分取决于某一帧中的最高的得分;而非唤醒词片段,为了保证所有帧的得分都足够低,则需要关注所有的帧。这种得分可以看作是基于声学得分的 Max-Pooling。

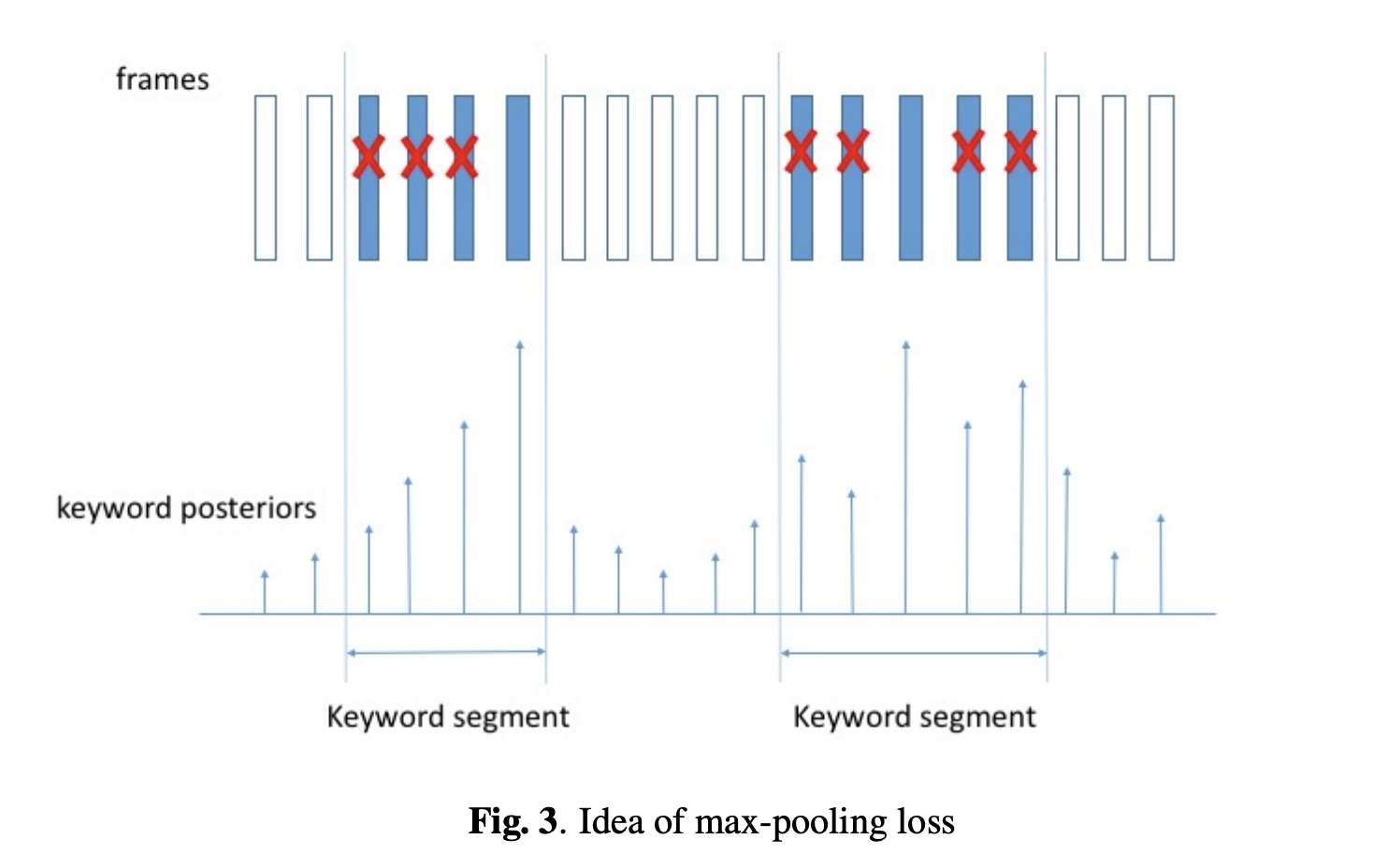

有了这个训练方式,我们直接地对唤醒词进行端到端的建模,具体模型可以采取 RNN-based、CNN-based 和 Attention-based 可对音频特征序列建模的模型。PaddleSpeech 中的 examples/hey_snips 采用了

Multi-scale Dilated Temporal Convolutional 模型,通过 Max-Pooling Loss 的训练方法实现了在 Snips 数据集上的训练和评估。

图片来源:https://arxiv.org/pdf/1705.02411.pdf

图片来源:https://arxiv.org/pdf/1705.02411.pdf  图片来源:https://arxiv.org/pdf/2102.13552.pdf

图片来源:https://arxiv.org/pdf/2102.13552.pdf

3. 实践:KWS模型训练和评估

PaddleSpeech 提供了 MDTC 模型在 Snips 数据集上的从训练到评估的全流程脚本,在此章节中将对一些重要步骤做讲解,如需完整执行训练和评估,可以根据 example 中的文档提示运行脚本,详情请参考:examples/hey_snips/kws0

3.1 环境准备

下载 PaddleSpeech 代码并安装所需依赖:

本教程要求paddlepaddle >= 2.2.2的环境,并需要 Clone PaddleSpeech Repo的代码(因网络访问问题可能需要等待较长时间,此处直接提供 PaddleSpeech r1.0 分支的代码压缩包):

!unzip work/PaddleSpeech-r1.0.zip

额外依赖:

!pip install scipy resampy soundfile tqdm colorlog pathos dtaidistance sklearn yacs loguru matplotlib

进入 example 目录:

%cd PaddleSpeech-r1.0/examples/hey_snips/kws0/

3.1 数据集准备

Snips 数据集需要用户自行申请下载:keyword-spotting-research-datasets

该数据集包含不同英语口音的约 11,000 “Hey Sinips” 的关键词的音频和 86,500(约96小时) 的其他发音的负样本。正负样本的音频均在相同的说话人、录音设备和环境噪音等条件下录制的,防止模型在训练的过程中关注非关键词相关的特征。数据集的切分和具体数量由下表所示:

| Train | Dev | Test | ||

|---|---|---|---|---|

| Positive | Utterances | 5,876 | 2,504 | 25,88 |

| Speakers | 1,179 | 516 | 520 | |

| max / speaker | 10 | 10 | 10 | |

| Negative | Utterances | 45,344 | 20,321 | 20,821 |

| Speakers | 3,330 | 1,474 | 1,469 | |

| max / speaker | 30 | 30 | 30 |

数据集下载完成后,解压至/PATH/TO/DATA/hey_snips_research_6k_en_train_eval_clean_ter目录。

3.2 训练

修改conf/mdtc.yaml中的data_dir为'/PATH/TO/DATA/hey_snips_research_6k_en_train_eval_clean_ter' ,只想数据集目录,配置CUDA_VISIBLE_DEVICES启动 CPU/单卡/多卡训练。

CUDA_VISIBLE_DEVICES=0,1 ./run.sh conf/mdtc.yaml

3.3 指标

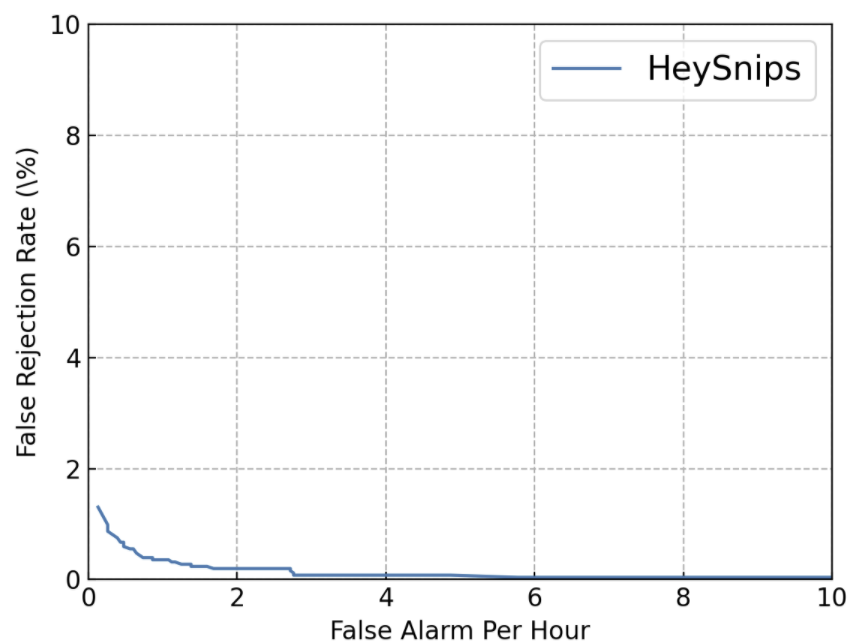

针对使用场景和训练样本不均衡问题,通常对 KWS 模型通常关注 False Reject 和 False Alarm 指标。在测试集中,通过对不同的唤醒得分阈值下,对模型的指标进行考察。得到每个阈值的样本判别结果后,可以绘制 DET(Detection Error Tradeoff) 曲线:

在此 example 中,我们考察模型在 False Reject 为每小时1次的前提下,False Alarm 的情况,该数值越小则表示模型越好。在下图的结果中,可以确定唤醒阈值为 0.83,此时的 False Alarm Rate为 0.003559(数据由 example 中训练后的模型得到,重新跑后可能会有细微不同):

## 3.4 预测

## 3.4 预测

通过上述的训练后得到模型的 checkpoint,并确定了唤醒阈值为 0.83,在此通过正负样本两段音频的输入进行预测,感兴趣的朋友也可以尝试自己提供录音音频进行预测(采样率为 16000 的单通道 wave 文件)。

3.4.1 音频预览

keyword.wav: 正样本,包含唤醒词 Hey Snips 的发音。non-keyword.wav: 负样本。

import IPython

IPython.display.Audio('/home/aistudio/work/keyword.wav')

IPython.display.Audio('/home/aistudio/work/non-keyword.wav')

3.4.2 模型加载

加载从上述训练过程中得到的模型参数文件,完成预测模型的加载。

加入 Python Package 的搜索路径。

import os

import syssys.path.insert(0, os.path.abspath('../../..'))

sys.path.insert(0, os.path.abspath('../../../audio'))

加载 MDTC 模型,模型结构的参数与 /examples/hey_snips/kws0/conf/mdtc.yaml 保持一致。

import paddle

from paddlespeech.kws.models import MDTC

from paddlespeech.kws.models.mdtc import KWSModel# Model

backbone = MDTC(stack_num=3,stack_size=4,in_channels=80,res_channels=32,kernel_size=5,

)

model = KWSModel(backbone=backbone, num_keywords=1)

kws_checkpoint = '/home/aistudio/work/kws.pdparams'

model.set_state_dict(paddle.load(kws_checkpoint))

model.eval()

3.4.3 获取预测结果

通过对测试音频进行特征提取和模型前向计算,获取唤醒得分,并通过对比唤醒阈值得到判别结果。

特征提取的参数与 /examples/hey_snips/kws0/conf/mdtc.yaml 保持一致。

音频加载和特征计算:

import paddleaudio

from paddleaudio.compliance.kaldi import fbankfeat_func = lambda waveform, sr: fbank(waveform=paddle.to_tensor(waveform).unsqueeze(0), sr=sr, frame_shift=10, frame_length=25, n_mels=80)keyword_feat = feat_func(*paddleaudio.load('/home/aistudio/work/keyword.wav'))

non_keyword_feat = feat_func(*paddleaudio.load('/home/aistudio/work/non-keyword.wav'))print(keyword_feat.shape, non_keyword_feat.shape)

获取音频的预测得分:

keyword_logits = model(keyword_feat.unsqueeze(0))

keyword_score = paddle.max(keyword_logits).numpy().item()

print(keyword_score)

non_keyword_logits = model(non_keyword_feat.unsqueeze(0))

non_keyword_score = paddle.max(non_keyword_logits).numpy().item()

print(non_keyword_score)

从阈值( 0.83)和音频的预测得分的比较重容易看出,keyword.wav 判别为唤醒,而 non-keyword.wav 为非唤醒。

4. 参考文献

[1] https://machinelearning.apple.com/research/hey-siri

[2] Chen, Guoguo et al. “Small-footprint keyword spotting using deep neural networks.” 2014 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) (2014): 4087-4091.

[3] Wang, Zhiming et al. “Small-footprint Keyword Spotting Using Deep Neural Network and Connectionist Temporal Classifier.” ArXiv abs/1709.03665 (2017): n. pag.

[4] Coucke, Alice et al. “Efficient Keyword Spotting Using Dilated Convolutions and Gating.” ICASSP 2019 - 2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) (2019): 6351-6355.

[5] Hou, Jingyong et al. “The NPU System for the 2020 Personalized Voice Trigger Challenge.” ArXiv abs/2102.13552 (2021): n. pag.

[6] Sun, Ming et al. “Max-pooling loss training of long short-term memory networks for small-footprint keyword spotting.” 2016 IEEE Spoken Language Technology Workshop (SLT) (2016): 474-480.

请点击此处查看本环境基本用法.

Please click here for more detailed instructions.

5. 关注 PaddleSpeech

请关注我们的 Github Repo,非常欢迎加入以下微信群参与讨论:

- 扫描二维码

- 添加运营小姐姐微信

- 通过后回复【语音】

- 系统自动邀请加入技术群

P.S. 欢迎关注我们的 github repo PaddleSpeech, 是基于飞桨 PaddlePaddle 的语音方向的开源模型库,用于语音和音频中的各种关键任务的开发,包含大量基于深度学习前沿和有影响力的模型。

【飞桨PaddleSpeech语音技术课程】— 语音唤醒相关推荐

- 【飞桨PaddleSpeech语音技术课程】— 语音识别-定制化识别

(以下内容搬运自飞桨PaddleSpeech语音技术课程,点击链接可直接运行源码) 定制化语音识别 1. 背景 在一些特定场景下,要求ASR系统对某些固定句式的关键词准确识别. 打车报销单场景,要求日 ...

- 【飞桨PaddleSpeech语音技术课程】— 一句话语音合成全流程实践

(以下内容搬运自飞桨PaddleSpeech语音技术课程,点击链接可直接运行源码) 一句话语音合成全流程实践 点击播放视频 1 声音克隆介绍 & 语音合成基本概念回顾 语音合成(Speech ...

- 【飞桨PaddleSpeech语音技术课程】— 语音合成

(以下内容搬运自飞桨PaddleSpeech语音技术课程,点击链接可直接运行源码) 『听』和『说』 人类通过听觉获取的信息大约占所有感知信息的 20% ~ 30%.声音存储了丰富的语义以及时序信息,由 ...

- 【飞桨PaddleSpeech语音技术课程】— 语音识别-Deepspeech2

(以下内容搬运自飞桨PaddleSpeech语音技术课程,点击链接可直接运行源码) 语音识别--DeepSpeech2 0. 视频理解与字幕 # 下载demo视频 !test -f work/sour ...

- 【飞桨PaddleSpeech语音技术课程】— 声音分类

(以下内容搬运自飞桨PaddleSpeech语音技术课程,点击链接可直接运行源码) 1. 识别声音 通过声音,人的大脑会获取到大量的信息,其中的一个场景是:识别和归类.如:识别熟悉的亲人或朋友的声音. ...

- 【飞桨PaddleSpeech语音技术课程】— 流式语音合成技术揭秘与实践

(以下内容搬运自飞桨PaddleSpeech语音技术课程,点击链接可直接运行源码) PP-TTS:流式语音合成原理及服务部署 1 流式语音合成服务的场景与产业应用 语音合成(Speech Sysnth ...

- 【飞桨PaddleSpeech语音技术课程】— 语音翻译

(以下内容搬运自飞桨PaddleSpeech语音技术课程,点击链接可直接运行源码) End-to-End Speech (to Text) Translation 前言 背景知识 语音翻译(ST, S ...

- AI:百度飞桨EasyDL多门视频课程,手把手教你如何定制高精度AI模型

AI:百度飞桨EasyDL多门视频课程,手把手教你如何定制高精度AI模型 目录 百度飞桨EasyDL多门视频课程,手把手教你如何定制高精度AI模型 百度飞桨EasyDL多门视频课程,手把手教你如何定制 ...

- 飞桨亮相GTLC技术领导力峰会,共话 AI 技术的落地实践

点击左上方蓝字关注我们 在新产业革命的浪潮下,AI已经连续多年成为热门,大量互联网公司和传统行业内开始在产品中引入AI技术,或投入AI的研发,技术侧和行业侧开始共同推动AI的行业应用.但技术局限.行业 ...

最新文章

- python网络爬虫的基本步骤-Python网络爬虫学习手记(1)——爬虫基础

- 交互神器 Facebook Origami

- tensorflow与numpy的版本兼容性问题(亲测)

- 二叉树构建及双向链表

- Java高级特性 第10节 IDEA和Eclipse整合JUnit测试框架

- error LNK2001: unresolved external symbol QtCored.lib using staic Qt lib

- akka kafka java_当使用websocket连接时,使用akka-stream-kafka从kafka主题获取最后一条消息...

- android 结束if循环_(第五讲)if 分支语句和 while 循环

- pythonの鉴黄之路(四)——urllib模块批量下载

- 清华大学刘知远教授:如何写一篇合格的NLP论文

- Java程序员从笨鸟到菜鸟之(四十八)细谈struts2(十)ognl概念和原理详解

- Centos 7 telnet 详解

- Mac电脑设置鼠标主按钮的方法?

- Python类的私有属性

- 装x玩法:插上你的专有U盘才能开机

- Django 项目部署

- 在ios10+的safair中实现视频的自动播放

- 5个流行的开源HIDS系统介绍

- 【概率论与数理统计】猴博士 笔记 p36-37 协方差、相关系数、不相关、相互独立时的期望和方差

- python中time什么意思_python中time包是什么?