机器阅读(一)--整体概述

https://plmsmile.github.io/2019/03/30/54-mrc-models/

主要包含:机器阅读的起因和发展历史;MRC数学形式;MRC与QA的区别;MRC的常见数据集和关键模型

发展动机

传统NLP任务

1) 词性分析 part-of-speech tagging :判断词性

2) 命名实体识别 named entity recognition 识别实体

3) 句法依存 sytactic parsing 找到词间关系、语法结构信息

4) 指代消解 coreference resolution

阅读理解动机

让机器理解人类语言是AI领域长期存在的问题

阅读理解能综合评估各项NLP任务,是一个综合性任务

阅读理解探索更加深层次的理解

回答问题是检测机器是否读懂文章最好的办法

历史发展

早期系统

1. QUALM系统 Lehnert,1977年

2. 早期数据集 Hirschman,1999年

- 小学文章,3年级-6年级

- 60篇 - 60篇:dev - test

- 只需要返回包含正确答案的句子即可

- who what when where why

3. Deep Read系统 Hirschman,1999年

rule-based bag-of-words,基于规则的词袋模型- 浅层语言处理:词干提取、语义类识别、指代消解

4. QUARC系统 Riloff and Thelen,2000年

- rule-based

- 基于词汇和语义对应

还有3和4的结合(Charniak,2000年),准确率在30%-40%左右。

机器学习时代

1. 三元组

(文章,问题,答案)

2. 两个数据集

MCTest:四选一;660篇科幻小说

ProcessBank:二分类;585问题,200个段落;生物类型文章;需要理解实体关系和事件

3. 传统规则方法

不使用训练数据集

1)启发式的滑动窗口方法

计算word overlap、distance information

2)文本蕴含方法

用现有的文本蕴含系统,把(问题,答案)对转化为一个statement。

3)max-margin 学习框架,使用了很多语言特征:

句法依存、semantic frames、 指代消解、 discourse relation和 词向量等特征。

4. 机器学习方法

机器学习方法比规则方法好,但是任然有很多不足:

1)依赖于现有语言特征工具

- 许多NLP任务没有得到有效解决

- 任务泛化性差,一般在单一领域训练

- 语言特征任务添加了噪声

2)很难模拟人类阅读,难以构建有效特征

3)标记数据太少,难以训练出效果好的统计模型

深度学习时代

深度学习火热于2015年,DeepMind的Hermann大佬提出了一种新型低成本构建大规模监督数据的方法,同时提出了attention-based LSTM。

神经网络效果较好,能更好地在词/句子上做match。

1) CNN/Daily-Mail数据集

- 把文章标题/摘要中的名词mask掉,再提问这个名词

- 使用NER和指代消解等技术

- 半合成的数据集,存在误差,影响发展

2) SQuAD数据集

- 107785问答数据,546文章

- 第一个大规模机器阅读理解数据集

- 推动了很多机器阅读模型的发展

3) 深度学习的优点

- 不依赖于语言特征工具,避免了噪声误差等

- 传统NLP方法特征稀少、难以泛化

- 不用去手动构建特征, 工作重心在模型设计上

任务形式

阅读理解任务看作是一种监督学习任务,目的是学习一种映射关系: f:(p,q)→af:(p,q)→a

自然形式

自然语言回答,没有固定的形式free-form answer。没有明确统一的评估指标。有如下几个:

- BLEU(注意看新文章,好像说这个评测不是很好)

- Meteor

- ROUGE

MRC和QA的比较

机器阅读理解是Question Answering的一个特例。

1) 相同点:问题形式、解决方法和评估方法

2) 不同点

问答系统在于:

- 旨在构建问答系统,依赖于各种资源

- 资源包括:结构化数据、非结构化文本、半结构化表格和其他形式的资源

- QA致力于:寻找和识别有用资源;集成各种资源的信息;研究人们常问的问题

机器阅读在于:

- 文本问答

- 需要去理解文本信息

- 答案只依赖于文章

- 会设计不同类型问题去测试机器对文章不同方面的理解

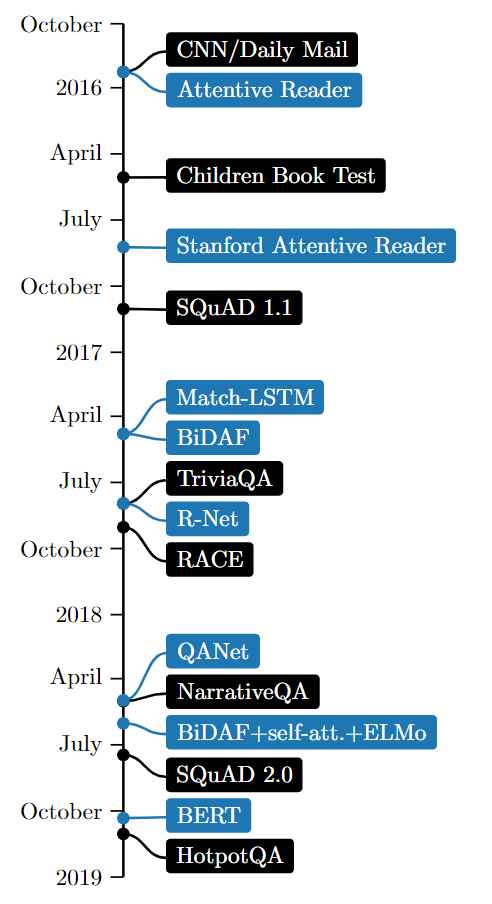

数据集和模型

机器阅读的发展原因:大规模数据和端到端神经网络模型的出现。

数据集促进了模型,模型又进一步促进了数据集的发展。

主要模型

- Attentive Reader

- Stanford Attentive Reader

- Match-LSTM

- BiDAF

- R-Net

- QANet

- BiDAF+self-attn+ELMo

- BERT

CNN/Daily Mail

完型填空,名词

MCTest

四选一,MCTest论文

SQuAD 1.1

span预测。SQuAD1.1有如下缺点:

- 问题是根据文章提出的,降低了回答问题的难度

- 答案缺少yes/no、计数、why、how等问题类型

- 答案很短,只有span类型

- 缺少多句推理,SQuAD只需要一个句子便能回答

TriviaQA

span预测。TriviaQA和数据集论文

- 从web和维基百科中构建,先收集QA,再收集P;更容易构建大规模数据集

- 650k (p, q, a),文章p很长,20倍SQuAD

优点:解决了SQuAD问题依赖于文章的问题缺点:不能保证文章一定包含该问题,这影响训练数据质量

RACE

四选一。中国初高中试题。RACE和数据集论文

NarrativeQA

free-form答案形式。NarrativeQA和数据集论文

- 书籍/电影:原文和摘要

- 摘要问答和原文问答,平均长度分别是659和62528

- 如果是原文,需要IR提取相关片段

- free-form 难以评估

SQuAD 2.0

Span预测。加入no-answer。SQuAD 2.0和数据集论文

HotpotQA

113k问答数据,可解释的多步推理问答。HotpotQA和数据集论文

- 要对多个文档进行查找和推理才能回答问题

- 问题多样化,不局限于已有知识库和知识模式

- 提供句子级别的支持推理线索

supporting fact,系统能利用强大的监督知识去推理回答,并对结果作出解释 - 提供了新型模拟比较型问题,来测试 QA 系统提取相关线索、执行必要对比的能力

- 评估方法1:给10个片2个相关,8个不相关;自行识别相关片段并进行回答

- 评估方法2:利用整个维基百科去进行回答

参考文献

- NEURAL READING COMPREHENSION AND BEYOND

</div>

机器阅读(一)--整体概述相关推荐

- 机器阅读理解首次超越人类!云从刷新自然语言处理新纪录

媒体动态发展历程资质荣誉人才招聘 机器阅读理解首次超越人类!云从刷新自然语言处理新纪录 2019-03-11 10:06 浏览:454 近日,云从科技和上海交通大学在自然语言处理领域取得重大突破,在卡 ...

- 机器阅读理解 | (2) 文本问答概述

本篇博客主要基于微软亚洲研究院段楠老师的<智能问答>第七章 文本问答 进行整理. 随着互联网的普及和搜索引擎的发展,人们可以越来越方便地从海量信息中检索到大量相关的文本. 而海量的信息也催 ...

- ACL 2020 | 基于机器阅读理解框架的命名实体识别方法

论文标题: A Unified MRC Framework for Named Entity Recognition 论文作者: Xiaoya Li, Jingrong Feng, Jiwei Li ...

- 句法引导的机器阅读理解

SG-Net: Syntax-Guided Machine Reading Comprehension 句法引导的机器阅读理解 1. Abstract 对于机器阅读理解来说,从冗长的细节中有效地对语言 ...

- 谷歌AI论文BERT双向编码器表征模型:机器阅读理解NLP基准11种最优(公号回复“谷歌BERT论文”下载彩标PDF论文)

谷歌AI论文BERT双向编码器表征模型:机器阅读理解NLP基准11种最优(公号回复"谷歌BERT论文"下载彩标PDF论文) 原创: 秦陇纪 数据简化DataSimp 今天 数据简化 ...

- NLP-阅读理解-2015:MRC模型-指导机器去阅读并理解【开篇之作】【完形填空任务】【第一次构建大批量有监督机器阅读理解训练语料】【三种模型结构:LSTM、Attention、Impatient】

<原始论文:Teaching Machines to Read and Comprehend> 作者想要研究的问题是什么?一一在当下神经网络迅速发展的时代,如何针对机器阅读理解提出一个网络 ...

- NLP-阅读理解:“阅读理解”综述(Machine Reading Comprehension, MRC)【完形填空、多项选择、抽取式(答案片段抽取)、生成式(自由作答)】《机器阅读理解数据集》

<原始论文:Neural Machine Reading Comprehension: Methods and Trends> 一.阅读理解概述 所谓的机器阅读理解(Machine Rea ...

- SIGIR 2019 | 基于人类阅读行为模式的机器阅读理解

作者丨张琨 学校丨中国科学技术大学博士生 研究方向丨自然语言处理 论文动机 机器阅读理解一直是自然语言处理领域的一个非常重要的研究方向,目前虽然在一些给定条件下,机器学习的方法可以取得和人类类似甚至好 ...

- 机器阅读理解中文章和问题的深度学习表示方法

/*版权声明:可以任意转载,转载时请标明文章原始出处和作者信息.*/ author: 张俊林 注:本文是<深度学习解决机器阅读理解任务的研究进展>节选,该文将于近期在"深度学习大 ...

最新文章

- 程序员开发进度太慢被告上法庭!公司索赔90万,拿出百度词条当证据

- snabbdom源码解析(七) 事件处理

- 如何有效防止DEDE织梦系统被挂木马安全设置(仅供参考)

- Solr集群搭建,zookeeper集群搭建,Solr分片管理,Solr集群下的DataImport,分词配置。...

- 计算机控制系统脉冲传递函数,第6.2课 (理解)计算机控制系统理论基础—脉冲传递函数.pdf...

- CSS样式如何解决IE浏览器不同版本的兼容问题

- 2017.4.16 车站 思考记录

- 【clickhouse】clickhouse强大智能的 Projection (投影) 功能

- Server-U文件名中文乱码问题解决方法

- 全用户态网络开发套件F-Stack架构分析

- java系统源代码_JAVA学生管理系统源代码

- 世界顶级音响品牌排名

- python调用openapi_eleme.openapi.python.sdk · PyPI

- Ubuntu下载速度慢的解决方法

- 使用elasticsearch文件搜索系统助力亚马逊解决方案架构师认证考试

- 咖啡店管理系统设计与实现C语言,答粉丝问|GUI编程实例化之咖啡店点单系统

- Java求两点的中点坐标_计算两点坐标距离与中点坐标

- bulldog2 靶机渗透

- Zepto课程-张晓飞-专题视频课程

- 整了半天终于把五笔整出来了

热门文章

- sql 为什么要用where 1=1或者where 1 =0 ?

- multi-line comment In file

- STM32F4 HAL 库开发报错:Hal_StatusTypeDef is undefined的解决办法

- mysql为什么不驼峰_为什么不用驼峰命名创建表名和字段?

- sketchup边线设置_春天花花天桥,SketchUp草图大师快速建模!

- excel记账本模板_原来这才是老板最喜欢看的财务报表!这些模板送你,录入自动生成...

- LeetCode 87. 扰乱字符串(记忆化递归 / DP)

- LeetCode 1007. 行相等的最少多米诺旋转

- 程序员面试金典 - 面试题 17.25. 单词矩阵(Trie树+DFS回溯,hard)

- 隐马尔科夫模型(HMM)笔记(公式+代码)