斯坦福大学深度学习与自然语言处理第三讲:高级的词向量表示

斯坦福大学在三月份开设了一门“深度学习与自然语言处理”的课程:CS224d: Deep Learning for Natural Language Processing,授课老师是青年才俊 Richard Socher,以下为相关的课程笔记。

第三讲:高级的词向量表示(Advanced word vector representations: language models, softmax, single layer networks)

推荐阅读材料:

- Paper1:[GloVe: Global Vectors for Word Representation]

- Paper2:[Improving Word Representations via Global Context and Multiple Word Prototypes]

- Notes:[Lecture Notes 2]

- 第三讲Slides [slides]

- 第三讲视频 [video]

以下是第三讲的相关笔记,主要参考自课程的slides,视频和其他相关资料。

回顾:简单的word2vec模型

- 代价函数J

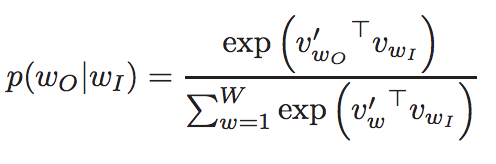

- 其中的概率函数定义为:

- 我们主要从内部向量(internal vector)vwI导出梯度

计算所有的梯度

- 我们需要遍历每一个窗口内的中心向量(center vector)的梯度

- 我们同时需要每一个外部向量(external vectors)v′的梯度

- 通常的话在每一个窗口内我们将更新计算所有用到的参数

- 例如在一个窗口长度为1的句子里:I like learning

- 第一个窗口里计算的梯度包括:内部向量vlike, 外部向量v′I及v′learning

- 同理更新计算句子的下一个窗口里的参数

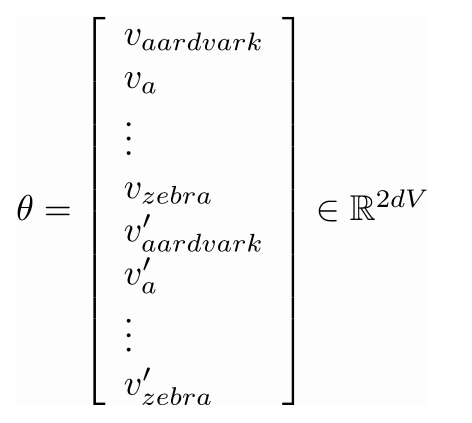

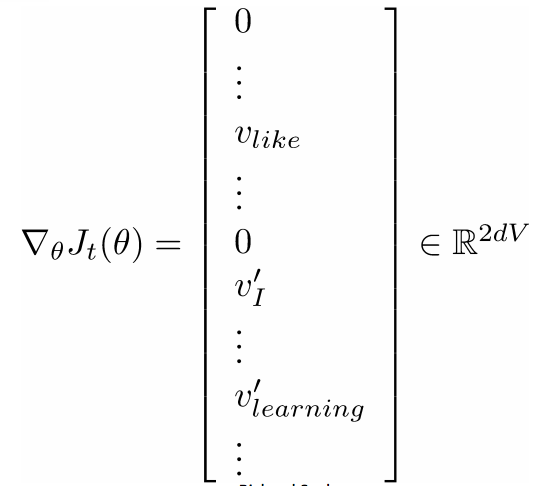

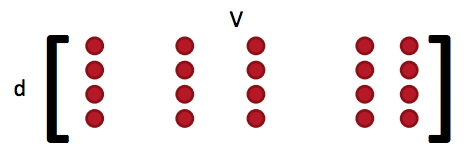

计算所有的向量梯度

- 我们经常在一个模型里把所有的参数集合都定义在一个长的向量θ里

- 在我们的例子里是一个d维度的向量及一个长度为V的词汇集:

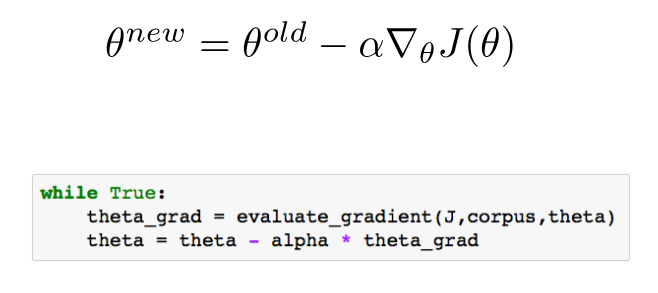

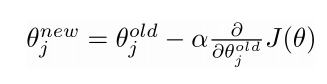

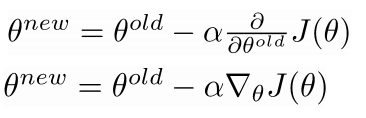

梯度下降

- 要在整个训练集上最小化代价函数J(θ)需要计算所有窗口里的参数梯度

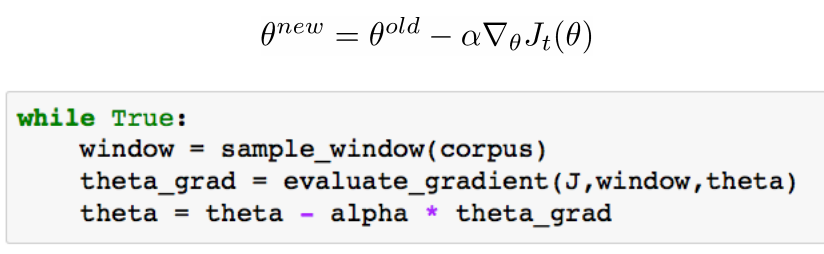

- 对于参数向量θ来说需要更新其中每一个元素:

- 这里α是步长

- 从矩阵的角度来看参数更新:

梯度下降相关代码

随机梯度下降(SGD)

- 对于上述梯度下降的方法,训练集语料库有可能有400亿(40B)的token和窗口

- 一轮迭代更新需要等待很长的时间

- 对于非常多的神经网络节点来说这不是一个好方法

- 所以这里我们使用随机梯度下降(SGD):在每一个窗口计算完毕后更新所有的参数

词向量的随机梯度下降

- 但是在每一个窗口里,我们仅有2c-1个词,这样的话δθJt(θ)非常稀疏

- 我们也许仅仅应该只更新那些确实存在的词向量

- 解决方案:或者保留词向量的哈稀或者更新词嵌入矩阵L和L′的固定列

- 很重要的一点是如果你有上百万个词向量并且在做分布式训练的话就不需要发送大量的更新信息了

PSet1

- 归一化因子的计算代价很大

- 因此在PSet1你们将实现skip-gram模型

- 主要的思路:对一对实际的词对(一个中心词及一个窗口内的其他词)和一些随机的词对(一个中心词及一个随机词)训练二元逻辑回归模型

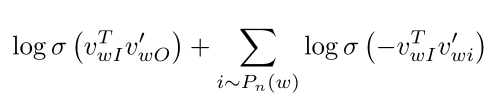

PSet1: The skip-gram model and negative sampling

- 来源论文:Distributed Representations of Words and Phrases and their Compositionality(Mikolov et al. 2013)

- 这里k是我们所使用的负例采样(negative sampling)的样本数

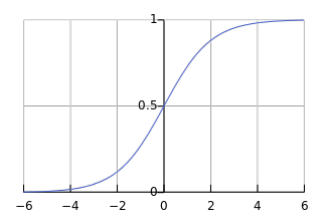

- Sigmoid函数:

- 所以我们最大化第一个log处两个词的共现概率

- 更进一步比较清晰的公式:

- 最大化在中心词周边真实词对的概率;最小化中心词周边随机词对的概率

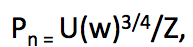

- 这里unigram分布U(w)被赋予了3/4幂次方,这样可以保证一些出现比较少的词可以被尽可能多的抽样

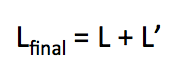

What to do with the two sets of vectors?

- 我们从所有的向量v和v′中得到了L和L′

- 这两个都获得了相似的共现信息,如何有效的利用着两个向量集?一个简单有效的方法,对它们进行加和

- 在GloVe中对许多超参数进行了探究: Global Vectors for Word Representation(Pennington et al. (2014))

如何评测词向量

- 和一般的NLP评测任务相似:内部 vs 外部(Intrinsic vs extrinsic)

- 内部评测:

- 在一个特定的子任务中进行评测

- 计算迅速

- 有助于理解相关的系统

- 不太清楚是否有助于真实任务除非和实际的NLP任务的相关性已经建立起来

- 外部评测:

- 在一个真实任务中进行评测

- 需要花很长的实际来计算精度

- 不太清楚是否是这个子系统或者其他子系统引起的问题

- 如果用这个子系统替换原有的系统后获得精度提升–>有效(Winning!)

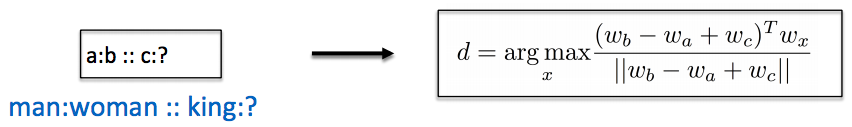

词向量的内部评测:

- 词向量类比:语法和语义

- 通过评测模型在一些语义或语法类比问题上的余弦相似度距离的表现来评测词向量

- 去除一些来自于搜索的输入词

- 问题:如果信息符合但不是线性的怎么办?

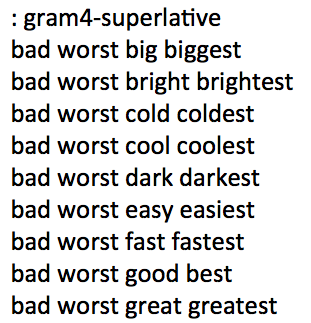

词向量的内部评测例一

- 词向量类比:以下语法和语义例子来源于:https://code.google.com/p/word2vec/source/browse/trunk/questions-words.txt

- 存在的问题:不同的城市可能存在相同的名字

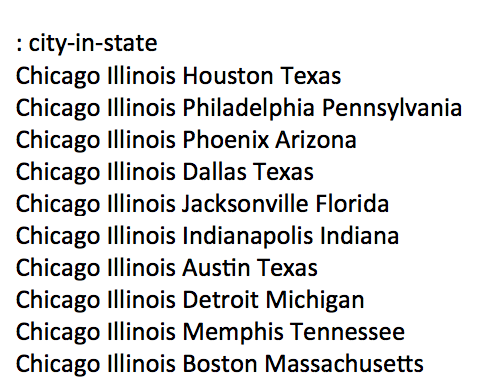

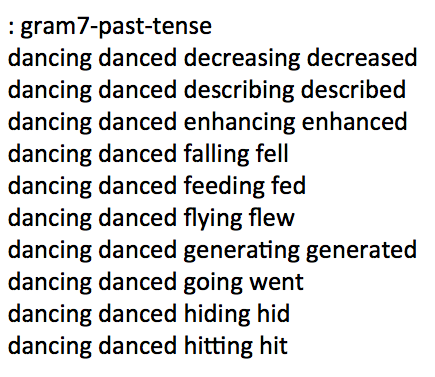

词向量的内部评测例二

- 词向量类比:以下语法和语义例子来源于:https://code.google.com/p/word2vec/source/browse/trunk/questions-words.txt

词向量的内部评测例三

- 词向量类比:以下语法和语义例子来源于:https://code.google.com/p/word2vec/source/browse/trunk/questions-words.txt

词向量的内部评测例四

- 词向量类比:以下语法和语义例子来源于:https://code.google.com/p/word2vec/source/browse/trunk/questions-words.txt

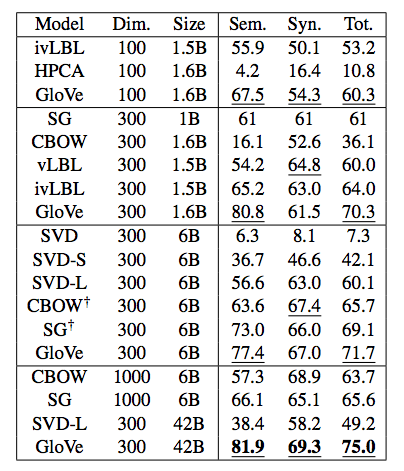

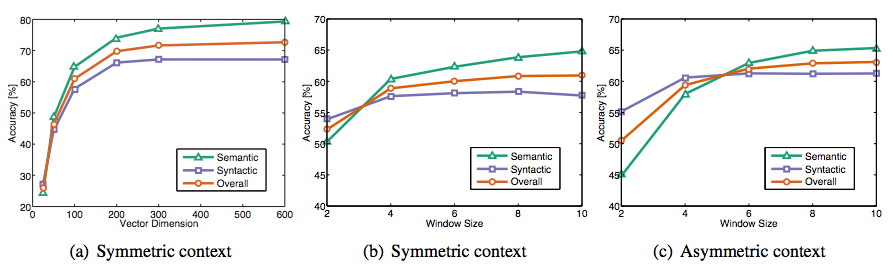

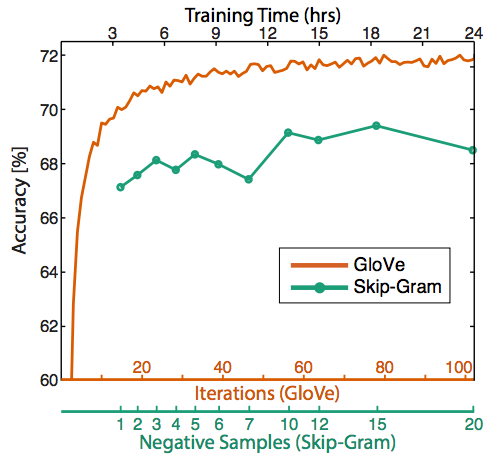

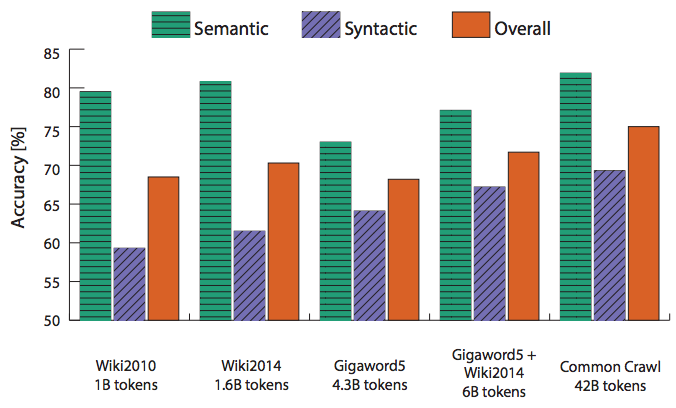

类比评测和超参数

- 目前为止最细致的评测: GloVe 词向量

- 非对称上下文(仅有左侧的单词)并不是很好

- 最佳的向量维度:300左右,之后变化比较轻微

- 但是对于不同的“下游”任务来说最佳的维度也会不同

- 对于GloVe向量来说最佳的窗口长度是8

- 训练的时间约长是否有帮助:对于GloVe来说确实有助于

- 更多的数据是否有帮助?维基百科的数据比新闻数据更相关

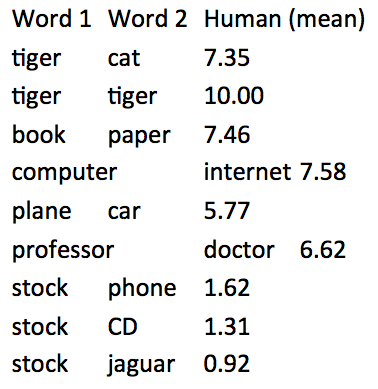

词向量的内部评价

- 评测任务:词向量距离以及和人工评价的相关性

- 评测集:WordSim353(http://www.cs.technion.ac.il/~gabr/resources/data/wordsim353/)

- 相关性评测结果:

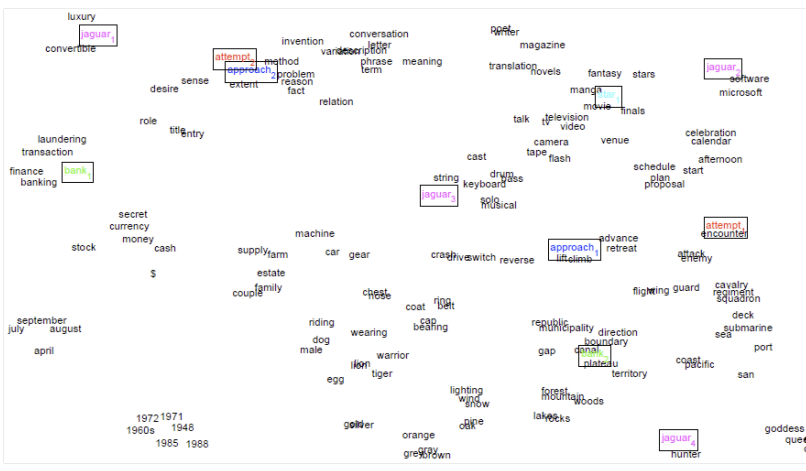

如何应对歧义问题(But what about ambiguity?)

- 也许你寄希望于一个词向量能捕获所有的语义信息(例如run即是动车也是名词),但是这样的话词向量会被辣向两个方向

- 这篇论文对此有相应的描述:Improving Word Representations Via Global Context And Multiple Word Prototypes(Huang et al. 2012)

- 解决思路:对词窗口进行聚类,并对每个单词词保留聚类标签,例如bank1, bank2等

词向量的外部评价

- 一个例子NER(named entity recognition):好的词向量会对实际任务有直接的帮助

- 命名实体识别(NER):找到人名,地名和机构名

- 命名实体识别(NER):找到人名,地名和机构名

- 下一步:如何在神经网络模型中使用词向量

简单的单个词的分类问题

- 从深度学习的词向量中最大的获益是什么?

- 有能力对单词进行精确的分类

- 国家类的单词可以聚和到一起–>因此可以通过词向量将地名类的单词区分出来

- 可以在其他的任务中将单词的任意信息融合进来

- 可以将情感分析(Sentiment)问题映射到单词分类中:在语料库中寻找最具代表性的正/负例单词

- 有能力对单词进行精确的分类

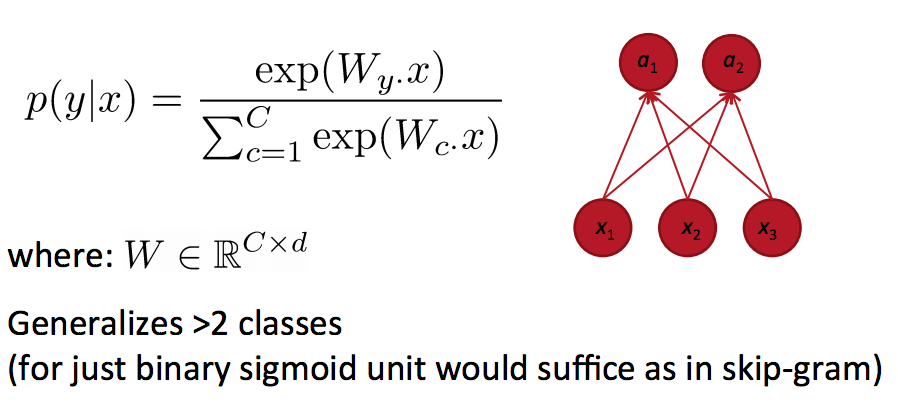

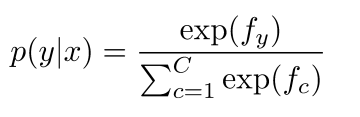

The Softmax

- 逻辑回归 = Softmax分类在给定词向量x的情况下获得y类的概率

The Softmax – 细节

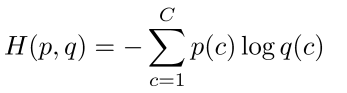

- 术语:损失函数(Loss function) = 代价函数(Cost function) = 目标函数(Objective function)

- Softmax的损失(Loss): 交叉熵(Cross Entropy)

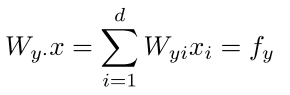

- 如何计算p(y|x): 取W的y′行乘以含x的行

- 计算所有的fc, c = 1, 2, … , C

- 归一化计算Softmax函数的概率

Softmax和交叉熵误差

- 目标是最大化正确分类y的概率

- 因此,我们可以最小化改函数负的对数概率

- 因此,如果有多个类别我们可以在总的误差函数中叠加多个交叉熵误差

背景:交叉熵 & KL散度

- 假设分布是:p = [0,…,0,1,0,…0], 对应计算的概率分布是q,则交叉熵是:

- 因为p是one-hot的缘故,则上述公式剩余的则是真实类的负的对数概率

- 交叉熵可以写成熵和两个分布的KL散度之和

- 在我们的case里p是0(即使不是0也会因为它是固定的对梯度没有固定),最小化交叉熵等价于最小化KL散度

- KL散度并非是一个距离函数而是一个对于两个概率分布差异的非对称的度量

- 维基百科:KL散度是两个概率分布P和Q差别的非对称性的度量。 KL散度是用来 度量使用基于Q的编码来编码来自P的样本平均所需的额外的位元数。 典型情况下,P表示数据的真实分布,Q表示数据的理论分布,模型分布,或P的近似分布。

简单的单个单词分类

- 例子:情感分析

- 两个选择:仅仅训练softmax权重W或者同时训练词向量

- 问题:训练词向量的优点和缺点是什么

- Pro: 更好的适应训练数据

- Con: 更差的泛化能力

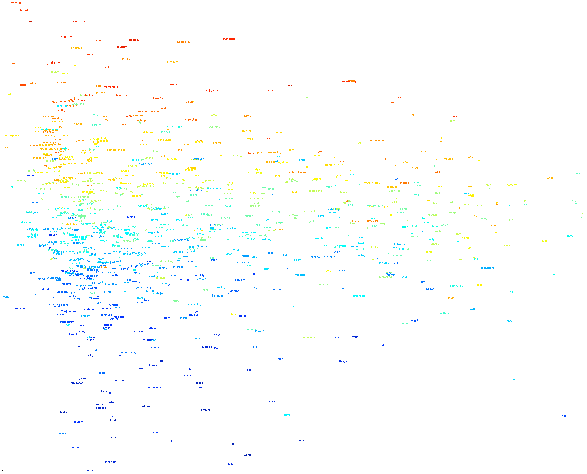

训练的词向量的情感分享可视化

继续“打怪升级”:窗口分类(Window classification)

- 单个的单词没有上下文信息

- 通过对窗口中的中心词进行分类同时考虑窗口中的上下文

- 可能性:Softmax 和 交叉熵误差 或者 最大边界损失(max-margin loss)

- 我们将在下一讲中探索这些问题(next class)

注:原创文章,转载请注明出处及保留链接“我爱自然语言处理”:http://www.52nlp.cn

本文链接地址:斯坦福大学深度学习与自然语言处理第三讲:高级的词向量表示

斯坦福大学深度学习与自然语言处理第三讲:高级的词向量表示相关推荐

- 斯坦福大学深度学习与自然语言处理第四讲:词窗口分类和神经网络

斯坦福大学在三月份开设了一门"深度学习与自然语言处理"的课程:CS224d: Deep Learning for Natural Language Processing,授课老师是 ...

- 斯坦福大学深度学习与自然语言处理第二讲:词向量

斯坦福大学在三月份开设了一门"深度学习与自然语言处理"的课程:CS224d: Deep Learning for Natural Language Processing,授课老师是 ...

- 斯坦福大学深度学习与自然语言处理第一讲:引言

斯坦福大学在三月份开设了一门"深度学习与自然语言处理"的课程:CS224d: Deep Learning for Natural Language Processing,授课老师是 ...

- 斯坦福大学深度学习与自然语言处理第一讲引言

http://www.52nlp.cn/%E6%96%AF%E5%9D%A6%E7%A6%8F%E5%A4%A7%E5%AD%A6%E6%B7%B1%E5%BA%A6%E5%AD%A6%E4%B9%A ...

- 【CS224n】2斯坦福大学深度学习自然语言处理课程笔记——词向量、词义和神经分类器

Natural Language Processing with Deep Learning 课程笔记2 1. 词向量和word2vec 2. 优化基础知识 3. 我们能否通过计数更有效地抓住词义的本 ...

- Deep Learning 9_深度学习UFLDL教程:linear decoder_exercise(斯坦福大学深度学习教程)...

前言 实验内容:Exercise:Learning color features with Sparse Autoencoders.即:利用线性解码器,从100000张8*8的RGB图像块中提取颜色特 ...

- Deep Learning 10_深度学习UFLDL教程:Convolution and Pooling_exercise(斯坦福大学深度学习教程)...

前言 理论知识:UFLDL教程和http://www.cnblogs.com/tornadomeet/archive/2013/04/09/3009830.html 实验环境:win7, matlab ...

- 深度学习与自然语言处理教程(2) - GloVe及词向量的训练与评估(NLP通关指南·完结)

作者:韩信子@ShowMeAI 教程地址:https://www.showmeai.tech/tutorials/36 本文地址:https://www.showmeai.tech/article-d ...

- 【双语字幕】斯坦福大学-深度学习分析

课程描述 深度学习是一种变革性的技术,在图像分类和语音识别方面取得了令人印象深刻的进步.许多研究人员正试图更好地理解如何提高预测性能,以及如何改进训练方法.有些研究人员使用实验技术,有人则使用理论方法 ...

最新文章

- CF338D GCD Table(拓展中国剩余定理,细节处理,2900分)

- linux stack

- 软件工程第一周-评论三部软件作品

- 最新天猫Java面试题(含总结):线程池+并发编程+分布式设计+中间件

- 双百双新产业项目是什么_投资380亿,广西38个“双百双新”产业项目开竣工

- java词汇速查手册_java 词汇表速查手册

- android权威指南十三章,《Android编程权威指南》第30~32以及第34章读书笔记

- 如何获取web视频数据流的传输?小姐姐的视频都被我爬下来了,这谁顶得住

- quartz spring 时间配置

- NumberFormat格式化数字

- Tomcat 调优之从 Linux 内核源码层面看 Tcp backlog

- Photoshop通道抠图

- 无法删除文件无法读源文件或磁盘的解决办法

- 奶油面膜行业调研报告 - 市场现状分析与发展前景预测

- 抛砖引玉,孢子,一种另类的WP7第三方应用数据交换方式

- 《学术研究,你的成功之道》 读书笔记

- 贾扬清分享_深度学习框架caffe

- 一维谐振子定态 Schrödinger 方程的数值解法

- 职业素养:如何管理好你的上级

- 三角定位PHP实现,算法 – 三角定位和定位点(x,y,z)

热门文章

- sklearn-GridSearchCV调节超参数

- python pandas dataframe 行列选择,切片操作 原创 2017年02月15日 21:43:18 标签: python 30760 python pandas dataframe

- 百度陆奇最新内部演讲:人工智能时代,给工程师的5个建议

- 思路+步骤+方法,三步教你如何快速构建用户画像?

- Linear Regression总结2

- 算法与数据结构(插入排序)

- Tomcat - 模拟Tomcat的webappClassLoader加载自己war包应用内不同版本类实现相互共存与隔离

- java 过滤掉相同请求_java并发访问重复请求过滤问题

- SpringBoot 45个注解

- c++ dump某个变量_linux内核调试之 crash分析dump文件