数据太大?你该了解Hadoop分布式文件系统

1、联网设备增加 数据量随之上升

大数据时代来了。当所有人都争吵着这件事情的时候,当所有企业都看好大数据的发展前景的时候,却都很少关注这些数据从哪儿来,我们有没有足够优秀的技术能力处理这些数据。

联网设备增加 数据量随之上升

网络的发展无疑为我们迎接大数据时代、智能计算时代铺好了路。根据研究公司的预测,全球联网设备正在增加,在部分国家,人均联网设备早已超过2台;如此大量的联网设备和不断提高的网络速度都在让社会的数据量快速增长,智慧城市、平安城市的实现也是以视频监控等视频数据为基础,成为大数据时代的重要组成部分。

机器人、AI、机器学习的研究让数据成为未来辅助我们生活的必要因素,无人车、机器人快递等形式的出现, 一方面体现了数据价值,另一方面也是在不断收集数据,反哺数据分析和应用。

数据体量太大 谁来处理?

数据产生后,意味着数据的采集工作已经完成,那么数据的输入与有效输出问题怎么破解?

自大数据时代到来之后,分布式存储、大文件的读写都成为热点话题,如何应对越来越多的大文件存储、分析与检索,成为企业需要攻克的难题。

而Hadoop的原型要从2002年开始说起。Hadoop的雏形始于2002年的Apache的Nutch,Nutch是一个开源Java 实现的搜索引擎。而后根据谷歌发表的学术沦为谷歌文件系统(GFS),实现了分布式文件存储系统名为NDFS。而后又根据Google发表的一篇技术学术论文MapReduce,在Nutch搜索引擎实现了用于大规模数据集(大于1TB)的并行分析运算。最后,雅虎雇用了Doug Cutting,Doug Cutting将NDFS和MapReduce升级命名为Hadoop,HDFS(Hadoop Distributed File System,Hadoop分布式文件系统)就此形成。

应该说Hadoop是针对大数据而存在的,HDFS能够提供高吞吐量的数据访问,适合有着超大规模数据集的应用程序。我们可以在Hadoop的设计中看到三大特点:适用于存储超大文件、适合运行在普通廉价的服务器上,同时,最搞笑的访问模式是一次写入、多次读取。

当然,HDFS也存在一些弊端,比如说不适用于有低延迟要求的应用场景。因为Hadoop是针对大数据传输的存在,是为高数据吞吐量应用而设计,这导致其必然要以高延迟作为代价。同时HDFS分布式存储不适用于小文件传输,在大量小文件传输过程中,namenode的内存就吃不消了。

2、Hadoop概念科普

Hadoop概念科普

在了解了Hadoop的身世和现在适合的应用场景之后,笔者要跟大家科普一下Hadoop的基础架构和主要概念。

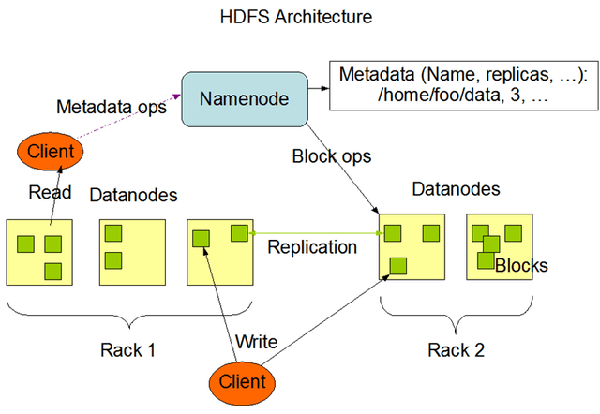

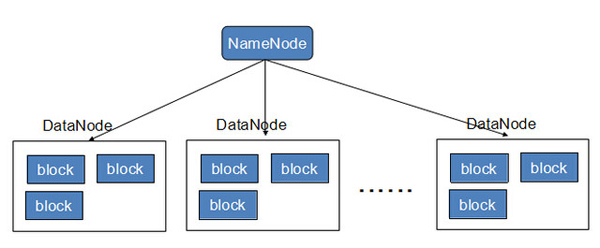

NameNode:namenode负责管理文件目录、文件和block的对应关系以及block和datanode的对应关系。这是由唯一一台主机专门保存,当然这台主机如果出错,NameNode就失效了,需要启动备用主机运行NameNode。

DataNode:负责存储,当然大部分容错机制都是在datanode上实现的。分布在廉价的计算机上,用于存储Block块文件。

MapReduce:通俗说MapReduce是一套从海量·源数据提取分析元素最后返回结果集的编程模型,将文件分布式存储到硬盘是第一步,而从海量数据中提取分析我们需要的内容就是MapReduce做的事了。

Block:也叫作数据块,默认大小为64MB。每一个block会在多个datanode上存储多份副本,默认是3份。

Rack:机柜,一个block的三个副本通常会保存到两个或者两个以上的机柜中。

本文作者:鲁畅

来源:51CTO

数据太大?你该了解Hadoop分布式文件系统相关推荐

- JAVA大数据(二) Hadoop 分布式文件系统HDFS 架构,MapReduce介绍,Yarn资源调度

文章目录 1.分布式文件系统HDFS 1.HDFS的来源 2.HDFS的架构图之基础架构 2.1 master/slave 架构 2.2 名字空间(NameSpace) 2.3 文件操作 2.4副本机 ...

- [python作业AI毕业设计博客]大数据Hadoop工具python教程1-HDFS Hadoop分布式文件系统...

Hadoop分布式文件系统(HDFS:Hadoop Distributed File System)是基于Java的分布式文件系统 分布式,可扩展和可移植的文件系统,旨在跨越大型商用服务器集群. HD ...

- 大数据技术之Hadoop分布式文件系统HDFS系统知识整理(从入门到熟练操作)

系列博客 1.大数据技术之Hadoop完全分布式集群搭建+Centos7配置连通外网和主机 2.大数据技术之Hadoop编译源码 3.大数据技术之Hadoop分布式文件系统HDFS系统知识整理(从入门 ...

- Hive数据导入——数据存储在Hadoop分布式文件系统中,往Hive表里面导入数据只是简单的将数据移动到表所在的目录中!...

转自:http://blog.csdn.net/lifuxiangcaohui/article/details/40588929 Hive是基于Hadoop分布式文件系统的,它的数据存储在Hadoop ...

- hdfs读写流程_深度探索Hadoop分布式文件系统(HDFS)数据读取流程

一.开篇 Hadoop分布式文件系统(HDFS)是Hadoop大数据生态最底层的数据存储设施.因其具备了海量数据分布式存储能力,针对不同批处理业务的大吞吐数据计算承载力,使其综合复杂度要远远高于其他数 ...

- excel连接mysql速度太慢,excel表格数据太大-excel太大,运行缓慢该怎么办

EXCEL表格为什么内容不多,但占用的空间特别大 原因:表格的空白行太多,占用表格容量. 解决方法: 1.打开excel,先选择其中一张表格. 2.下滑鼠标到表格内容结束的空白行处. 3.选中空白行整 ...

- 数据太大,记事本打不开怎么办?

当文本文件中保存的数据太大时,会出现文件太大,记事本等无法打开的现象,如下图: 此时我们可以采用超大文本文件打开工具LogViewPro 首先下载该工具,下载地址如下: http://download ...

- MySQL同步到hadoop工具_MySQL数据库实时同步数据到Hadoop分布式文件系统的工具Applier...

通过Map/Reduce进行批处理递送到Apache Hadoop仍然是中枢环节.,但随着要从"超思维速度"分析方面获取竞争优势的压力递增,因此Hadoop( 分布式文件系统 )自 ...

- MySQL同步到hadoop工具_MySQL数据库实时同步数据到Hadoop分布式文件系统的工具Applier(转)...

通过Map/Reduce进行批处理递送到Apache Hadoop仍然是中枢环节.,但随着要从"超思维速度"分析方面获取竞争优势的压力递增,因此Hadoop(分布式文件系统)自身经 ...

- ps保存切片遇到存储数据太大的问题和常用快捷键

为什么80%的码农都做不了架构师?>>> ps保存切片遇到存储数据太大的问题和常用快捷键 保存多个切片,选定多个切片快捷键Shift+单击 切片复制快捷键Ctrl+Alt+单击 ...

最新文章

- Linux 下UVCamp;V4L2技术简单介绍(二)

- 解读Cardinality Estimation算法(第三部分:LogLog Counting)

- Django框架(三)—— orm增删改查、Django生命周期

- 周末想找个地方敲代码_观看我们的代码游戏,全周末直播

- 寄存器指令MIPS 寄存器介绍

- Redis 6.0 源码阅读笔记(11) -- 主从复制 Slave 节点流程分析

- iptables介绍与实践

- 概率论基础——组合分析

- SQL--“索引超出了数组界限”

- 宏基 Acer 4741G ubuntu10.10 GT 330M显卡驱动

- asp+access实现增删改查

- android 倒水动画,Android 模拟圆形水杯倒水的效果

- iphone 价格的秘密

- Kafka:分布式消息系统

- 51单片机码表c语言编程,分享自写码表单片机程序(共阴极数码管显示)

- Revo Uninstaller快捷键命令

- Datawhale | 高级算法梳理第六期 Task3【XGB算法梳理】3天

- 中文实时语音识别引擎

- ReactJS Start/build内存溢出

- PAT乙级C语言 1028 人口普查