Ian Goodfellow等提出自注意力GAN,ImageNet图像合成获最优结果!

图像合成(Image synthesis)是计算机视觉中的一个重要问题。随着生成对抗网络(GAN)的出现,这个方向取得了显著进展。基于深度卷积网络的GAN尤其成功。但是,通过仔细检查这些模型生成的样本,可以观察到,在ImageNet这类的有许多图像类别的数据集上训练时,卷积GAN合成的图像不尽如人意。

针对这个问题,谷歌大脑的Ian Goodfellow和Augustus Odena,以及罗格斯大学的Han Zhang和Dimitris Metaxas等人在他们的最新研究中提出“自注意力生成对抗网络”(SAGAN),将自注意力机制(self-attention mechanism)引入到卷积GAN中,作为卷积的补充,取得了最优的结果。

摘要

在这篇论文中,我们提出自注意力生成对抗网络( Self-Attention Generative Adversarial Network ,SAGAN)。SAGAN允许对图像生成任务进行注意力驱动、长相关性的建模。传统的卷积GAN生成的高分辨率细节仅作为在低分辨率特征图上的空间局部点的函数。在SAGAN中,可以使用来自所有特征位置的线索来生成细节。此外,鉴别器可以检查图像的远端部分的高度详细的特征彼此一致。此外,最近的研究表明,生成器条件会影响GAN的性能。利用这些发现,我们将谱归一化到GAN生成器中,并发现这改进了训练动态。我们提出的SAGAN达到了state-of-the-art的结果,将Inception score从当前最高的36.8提高到52.52,并且在具有挑战性的ImageNet数据集上将Frechet Inception distance从27.62降低到18.65。注意力层的可视化表明,生成器利用与对象形状相对应的邻域,而不是固定形状的局部区域。

SAGAN:将自注意力机制引入GAN

尽管最先进的ImageNet GAN模型 [17] 擅长合成几乎没有结构性限制的图像类别(例如,海洋、天空和景观类,它们的区别更多在于纹理而不是几何结构),但它无法捕获在某些类别中经常出现的几何模式或结构模式(例如,狗通常有逼真的皮毛纹理,但没有明确区分的脚)。

一种可能的解释是,以前的模型严重依赖于卷积来建模不同图像区域之间的依赖关系。由于卷积运算符具有一个局部感受域,所以在经过几个卷积层之后,只能处理长距离的相关性。

由于各种原因,这可能会阻止学习长相关性(long-term dependencies):小的模型可能无法表示它们,优化算法可能无法发现参数值,这些参数值仔细协调多个层,以捕获这些相关性,并且这些参数化在统计学上可能相当脆弱,当应用于以前未见过的输入时容易失败。增加卷积核的大小可以提高网络的表征能力,但这样做也会失去利用局部卷积结构获得的计算和统计效率。

另一方面,自注意力(Self-attention)可以更好地平衡模型的长相关性和计算与统计效率。self-attention模块以所有位置的特征加权和来计算响应,其中权重(或attention vectors)只以很小的计算成本来计算。

图 1:我们提出的SAGAN通过利用图像远端部分的互补特征来生成图像,而不是固定形状的局部区域,从而可以生成一致的对象/场景。图中每一行的第一个图像显示了带颜色编码点的五个代表性查询位置。其他五个图像是针对这些查询位置的 attention maps,其中对应的颜色编码的箭头概括了最受关注的区域。

在这项工作中,我们提出了自注意力生成对抗网络(SAGAN),它将自注意力机制(self-attention mechanism)引入到卷积GAN中。自注意力模块(self-attention module)是对卷积的补充,有助于模拟跨越图像区域的长距离、多层的依赖关系。通过self-attention,生成器可以绘制图像,所绘制图像中每个位置的精细细节都与图像远端的精细细节充分协调。此外,鉴别器还可以更准确地对全局图像结构执行复杂的几何约束。

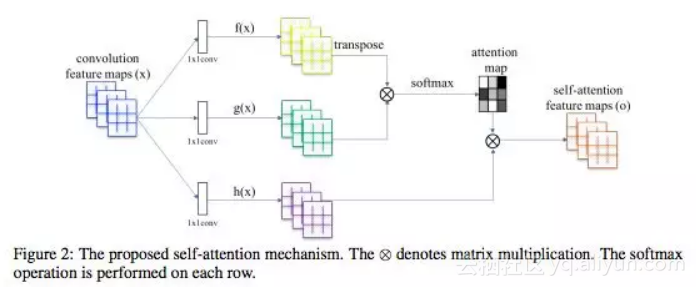

图2:所提出的self-attention机制。⊗表示矩阵乘法,在每一行上执行softmax操作。

除了self-attention之外,我们还将最近关于网络调节(network conditioning)的见解与GAN的性能结合起来。A. Odena等人的研究[18]表明,调节良好的生成器往往表现更好。我们建议使用以前仅应用于鉴别器的谱归一化技术(spectral normalization)来加强GAN生成器器的调节。

我们在ImageNet数据集上进行了大量的实验,以验证所提出的self-attention机制和稳定技术的有效性。SAGAN在图像合成方面的表现远远超过了state-of-the-art的表现,将此前报告的最高Inception score从36.8提高到52.52,将Fréchet初始距离(Fréchet Inception distance,FID)从27.62降低到18.65。attention层的可视化显示,生成器利用与对象形状相对应的区域,而不是固定形状的局部区域。

ImageNet上的图像合成实验

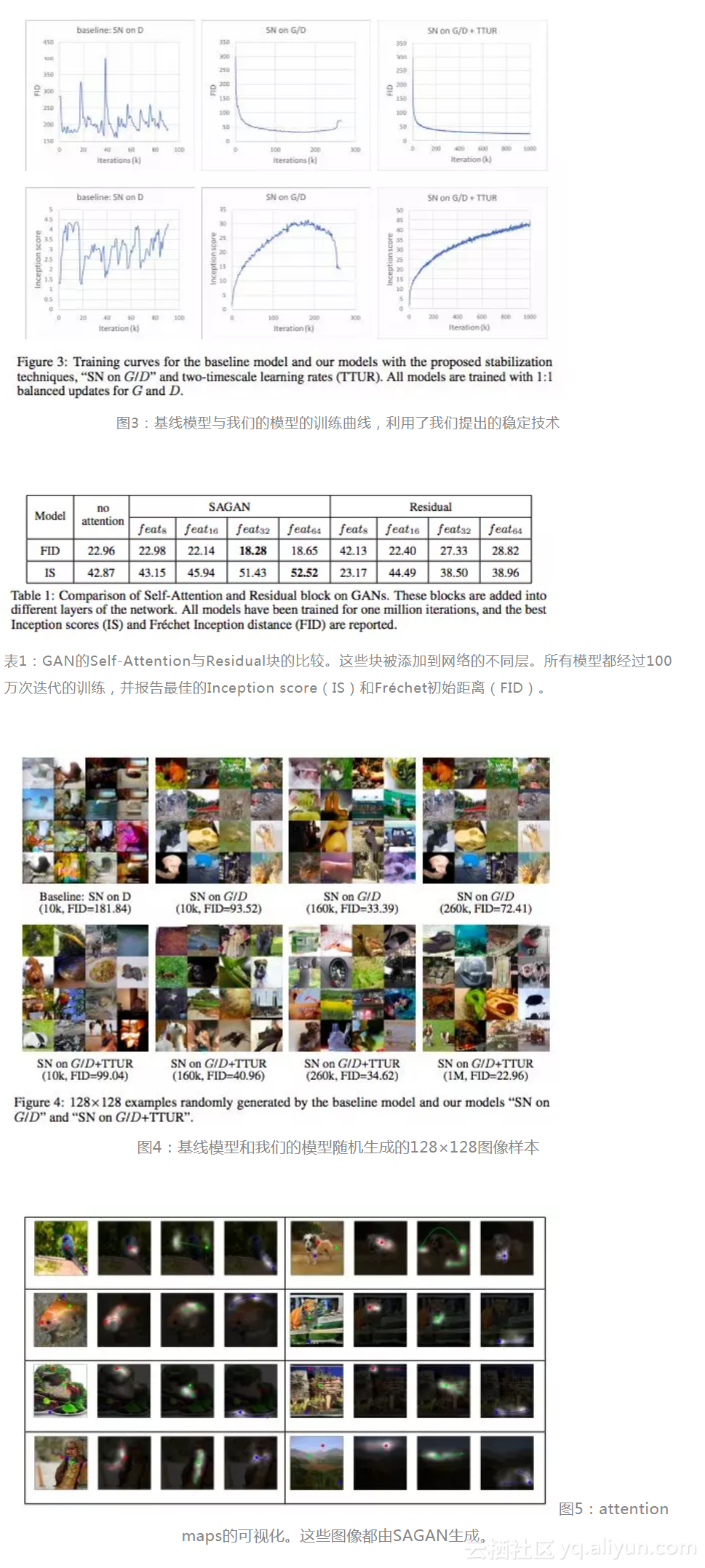

为了评价所提出的方法,我们在LSVRC 2012 (ImageNet)上数据集进行了大量的实验。首先,我们对评估所提出的两种稳定GAN训练的技术进行有效性实验。其次,对所提出的self-attention mechanism进行了研究。最后,将SAGAN与其他state-of-the-art的图像生成方法进行了比较。

评估指标

我们使用Inception score(IS)和Fréchet初始距离(FID)进行定量评估。Inception score越高,表示图像质量越好。 FID是一个更加基于规则和综合性的指标,并且在评估生成的样本的真实性和变异性方面已被证明与人类的评估更加一致。越低的FID值意味着合成数据分布与真实数据分布之间的距离更近。

与state-of-the-art模型的比较

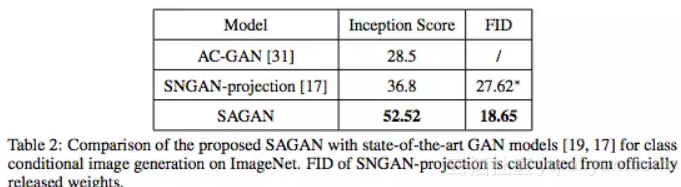

在ImageNet上,SAGAN与最先进的GAN模型[19,17]进行了比较。如表2所示,我们提出的SAGAN得到了Inception score和FID。Inception score方面,SAGAN将此前0最高的36.8提高到52.52;FID(18.65)也表明,SAGAN可以通过使用self-attention模块对图像区域之间的全局依赖关系进行建模,从而更好地模拟原始图像的分布。图6展示了由SAGAN生成的一些示例图像。

表2: 将所提出的SAGAN与最先进GAN模型进行比较,任务是ImageNet上的类别条件图像生成。

图6:SAGAN 生成的不同类别的128×128分辨率示例图像。每行展示一个类别的示例。

总结

在本研究中,我们提出自注意力生成对抗网络(SAGAN),它将self-attention机制引入到GAN的框架。 self-attention 模块在建模长相关性( long-range dependencies)方面很有效。另外,我们证明了应用于生成器的谱归一化可以稳定GAN的训练,并且TTUR加速了正则化鉴别器的训练。SAGAN在ImageNet的分类条件图像生成任务上达到最先进的性能。

原文发布时间为:2018-05-24

本文来自云栖社区合作伙伴新智元,了解相关信息可以关注“AI_era”。

原文链接:Ian Goodfellow等提出自注意力GAN,ImageNet图像合成获最优结果!

Ian Goodfellow等提出自注意力GAN,ImageNet图像合成获最优结果!相关推荐

- Ian Goodfellow 生成对抗网络(GAN)论文解析

原文:Generative Adversarial Nets 作者:Adit Deshpande 编译:KK4SBB 欢迎人工智能领域技术投稿.约稿.给文章纠错,请发送邮件至heyc@csdn.net ...

- 【Ian Goodfellow 强推】GAN 进展跟踪 10 大论文(附下载)

1. Progressive Growing of GANs for Improved Quality, Stability, and Variation Tero Karras, Timo Aila ...

- 详细解读Ian Goodfellow ICCV2017演讲PPT《解读GAN的原理与应用》

详细解读Ian Goodfellow ICCV2017演讲PPT<解读GAN的原理与应用> 转自: @TOChttps://blog.csdn.net/qq_40667584/articl ...

- ICCV2017 | 一文详解GAN之父Ian Goodfellow 演讲《生成对抗网络的原理与应用》(附完整PPT)

当地时间 10月 22 日到10月29日,两年一度的计算机视觉国际顶级会议 International Conference on Computer Vision(ICCV 2017)在意大利威尼斯开 ...

- GAN之父Ian Goodfellow离职苹果:不想重返办公室工作

转载自:机器之心 对苹果来说,Ian Goodfellow 的离开对公司损失相当大. 据 The Verge 报道,苹果机器学习总监 Ian Goodfellow 在加入公司三年后辞职,部分原因是苹果 ...

- GAN之父Ian Goodfellow回归谷歌!将在DeepMind远程办公

点击下方卡片,关注"CVer"公众号 AI/CV重磅干货,第一时间送达 转载自:机器之心 | 编辑:泽南.蛋酱 Goodfellow 跳槽,真的是因为不想回办公室上班吗? 加入苹果 ...

- 「GAN之父」回归!Ian Goodfellow正式入职Deepmind

来源:新智元 终于官宣了! 7月6日,Ian Goodfellow在推特上宣布正式加入DeepMind,并将成为Oriol Vinyals深度学习团队的一名研究科学家. 之前大家一直关注的Goodfe ...

- Ian Goodfellow回忆GAN诞生故事:几杯啤酒喝出“20年来最酷的深度学习想法”

当Ian Goodfellow解释他在谷歌大脑所做的研究时,他引用了原子物理学家.加州理工学院教授兼畅销书作家的这句格言.但是,Goodfellow不是指自己,也不是Google内的任何其他人.他谈论 ...

- ICLR2018论文投稿抢先看:Ian Goodfellow由衷赞赏的训练稳定方法SN-GANs

大家都知道,ICLR 2018的论文投稿已经截止,现在正在评审当中.虽然OpenReview上这届ICLR论文的评审过程已经放弃了往届的双方身份公开,但仍然比其它会议"open"得 ...

最新文章

- php不同用户显示不同表单_php 实现接收多个name相同但Value不相同表单数据实例...

- Webkit Flex伸缩盒模型属性备忘

- Delphi 中自定义异常及异常处理的一般方法

- visual studio 2010常用快捷键

- 跟我学AI建模:分子动力学仿真模拟之DeepMD-kit框架

- linux的awk命令如何用?

- iptraf:一个实用的TCP/UDP网络监控工具

- 【Android 界面效果43】Android LayoutInflater的inflate方法中attachToRoot的作用

- 空字符串(“”)和null的区别

- C语言:查找数组中最小的元素

- 软考——IP计算问题那点事

- 搞一下SOA | 11 SOA 系统建模

- ctfshow 网络迷踪-初窥门径

- 飞腾服务器通过KunLun BIOS 对JBOD模式的系统盘进行格式化,删除系统盘中残留数据的操作方法

- 安卓Socket与pc端c#服务器的通信 附完整代码

- 《食品真相大揭秘》摘录

- Functional Programming in C++

- JavaScript 基础学习(三)

- 一周AI看点 | AI界的体操运动员Atlas上线,第一家金融AI公司纽交所上市

- Element UI + Vue 批量上传图片(只请求一次)