机器学习实战之决策树

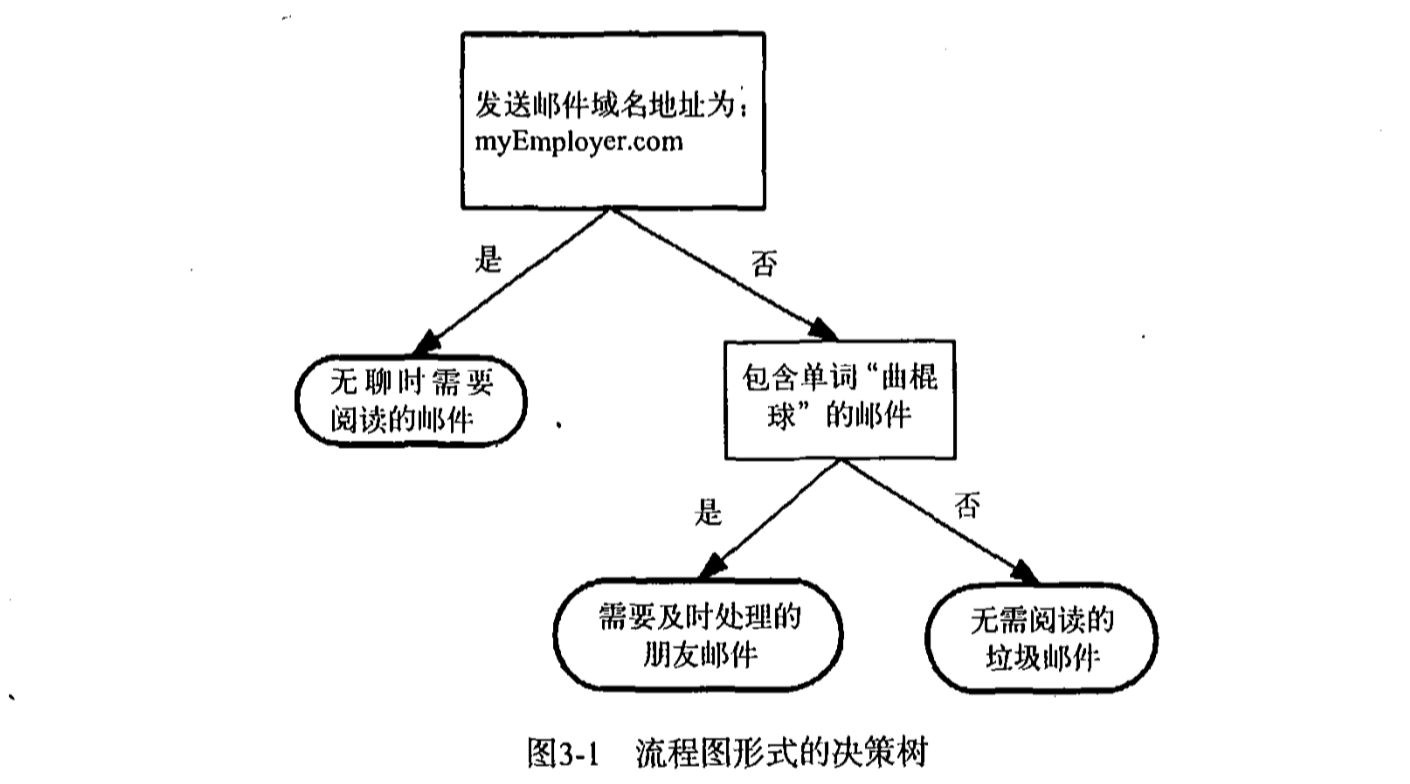

你是否玩过二十个问题的游戏,游戏的规则很简单:参与游戏的一方在脑海里想某个事物,其他参与者向他提问题,只允许提20个问题,问题的答案也只能用对或错回答。问问题的人通过 推断分解,逐步缩小待猜测事物的范围。决策树的工作原理与20个问题类似,用户输人一系列数 据,然后给出游戏的答案。

现在我们已经大致了解了决策树可以完成哪些任务,接下来我们将学习如何从一堆原始数据中构造决策树。首先我们讨论构造决策树的方法,以及如何编写构造树的python代码;接着提出 一些度量算法成功率的方法;最后使用递归建立分类器,并且使用matplotlib绘制决策树图。构造完成决策树分类器之后,我们将输人一些隐形眼镜的处方数据,并由决策树分类器预测需要的 镜片类型。

决策树的构造

优点:计算复杂度不高,输出结果易于理解,对中间值的缺失不敏感,可以处理不相关特 征数据。

缺 点 :可能会产生过度匹配问题。

适用数据类型:数值型和标称型.

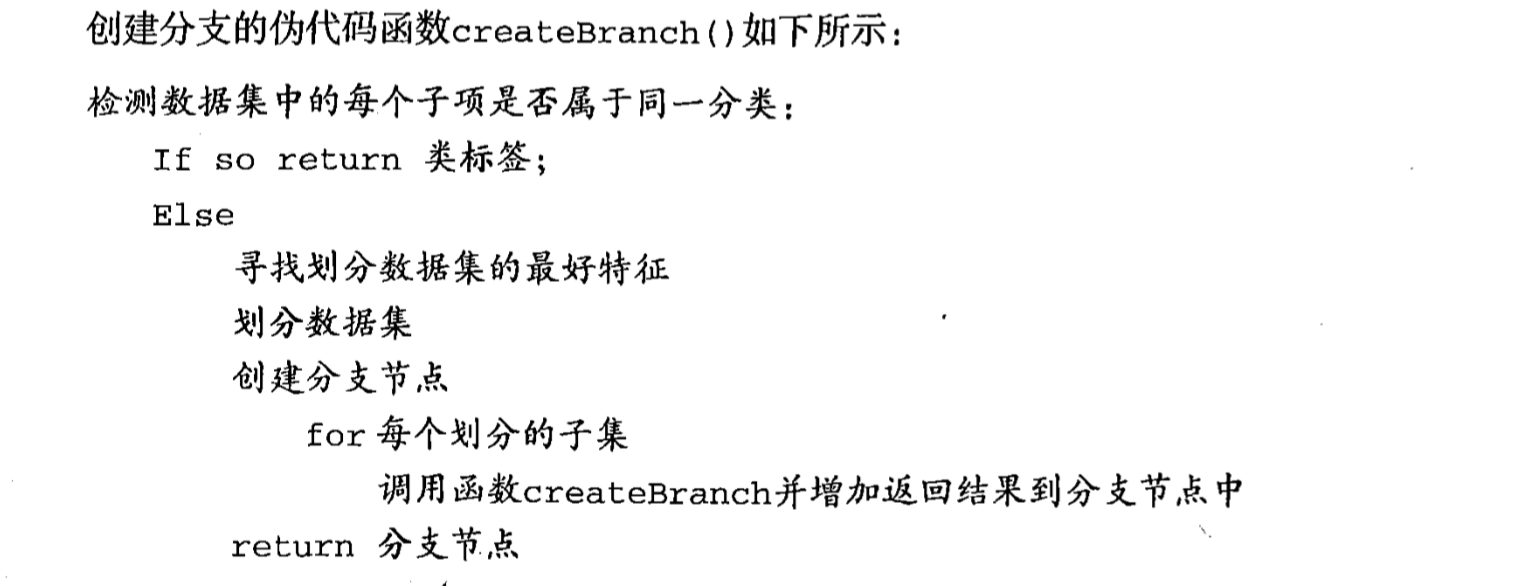

在构造决策树时,我们需要解决的第一个问题就是,当前数据集上哪个特征在划分数据分类时起决定性作用。为了找到决定性的特征,划分出最好的结果,我们必须评估每个特征。完成测 试之后,原始数据集就被划分为几个数据子集。这些数据子集会分布在第一个决策点的所有分支上。如果某个分支下的数据属于同一类型,则

表示已经正确分类,如果数据子集内的数据不属于同一类型,则需要重复划分数据子集的过程。如何划分数据子集的算法与划分原始数据集的方法相同,直到所有具

有相同类型的数据均在一个数据子集内。

决策树一般流程

(1)收集数据:可以使用任何方法。

(2)准备数据:树构造算法只适用于标称型数据,因此数值型数据必须离散化。

(3)分析数据:可以使用任何方法,构造树完成之后,我们应该检查图形是否符合预期。

(4)训练算法:构造树的数据结构。

(5)测试算法:使用经验树计算错误率。

(6)使用算法:此步骤可以适用于任何监督学习算法,而使用决策树可以更好地理解数据的内在含义

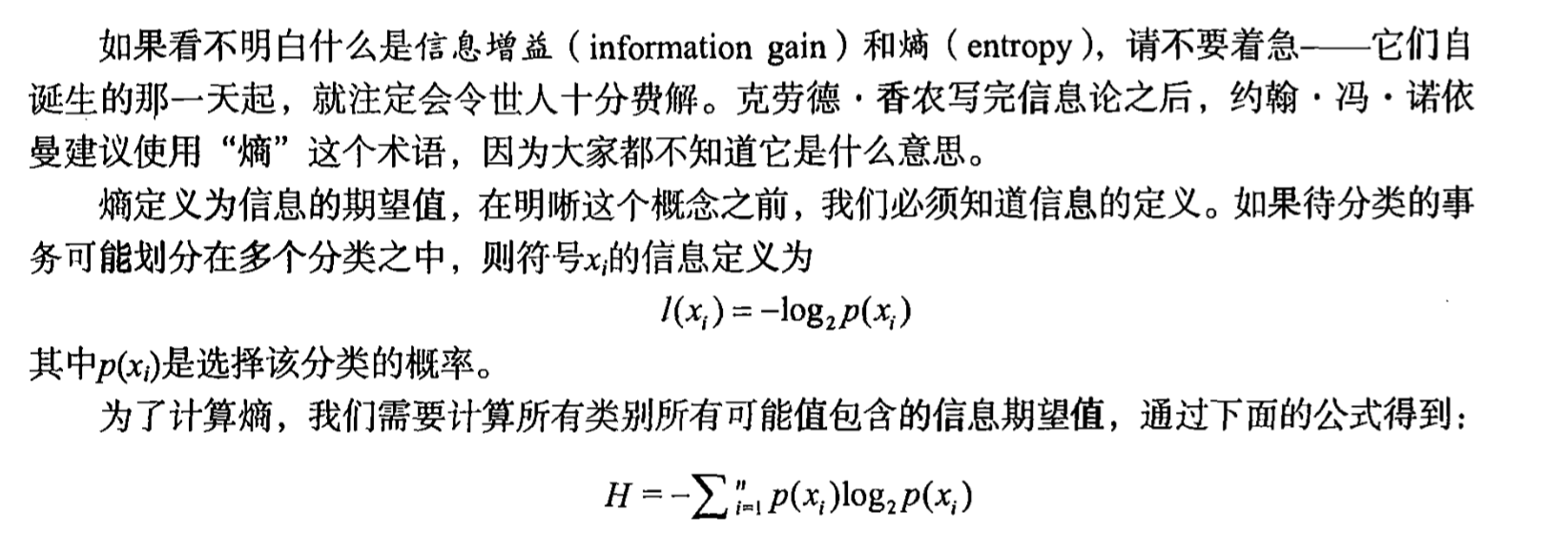

信息增益

划分数据集的大原则是:将无序的数据变得更加有序。我们可以使用多种方法划分数据集,但是每种方法都有各自的优缺点。组织杂乱无章数据的一种方法就是使用信息论度量信息,信息 论是量化处理信息的分支科学。我们可以在划分数据之前使用信息论量化度量信息的内容。

在划分数据集之前之后信息发生的变化称为信息增益,知道如何计算信息增益,我们就可以计算每个特征值划分数据集获得的信息增益,获得信息增益最高的特征就是最好的选择。

在可以评测哪种数据划分方式是最好的数据划分之前,我们必须学习如何计算信息增益。集合信息的度量方式称为香农熵或者简称为熵,这个名字来源于信息论之父克劳德•香农。

下面我们用python计算信息熵,此代码的功能是计算给定数据集的熵

def calcShannonEnt(dataSet):numEntries = len(dataSet)labelCounts = {}for featVec in dataSet: # the the number of unique elements and their occurancecurrentLabel = featVec[-1]if currentLabel not in labelCounts.keys(): labelCounts[currentLabel] = 0labelCounts[currentLabel] += 1shannonEnt = 0.0for key in labelCounts:prob = float(labelCounts[key]) / numEntriesshannonEnt -= prob * log(prob, 2) # log base 2return shannonEnt得到熵之后,我们就可以按照获取最大信息增益的方法划分数据集,下一节我们将具体学习 如何划分数据集以及如何度量信息增益。

划分数据集

分类算法除了需要测量信息熵,还需要划分数 据集,度量花费数据集的熵,以便判断当前是否正确地划分了数据集。我们将对每个特征划分数据集的结果计算一次信息熵,然后判断按照哪个特征划分数据集是最好的划分方式。想象一个分布在二维空间的数据散点图,需要在数据之间划条线,将它们分成两部分,我们应该按照x轴还 是y轴划线呢?

def splitDataSet(dataSet, axis, value):retDataSet = []for featVec in dataSet:if featVec[axis] == value:reducedFeatVec = featVec[:axis] # chop out axis used for splittingreducedFeatVec.extend(featVec[axis + 1:])retDataSet.append(reducedFeatVec)return retDataSet接下来我们遍历整个数据集,循环计算香农熵和splitDataSet()函数,找到最好的特征划分方式。熵计算会告诉我们如何划分数据集是最好的数据组织方式。

def chooseBestFeatureToSplit(dataSet):numFeatures = len(dataSet[0]) - 1 # the last column is used for the labelsbaseEntropy = calcShannonEnt(dataSet)bestInfoGain = 0.0;bestFeature = -1for i in range(numFeatures): # iterate over all the featuresfeatList = [example[i] for example in dataSet] # create a list of all the examples of this featureuniqueVals = set(featList) # get a set of unique valuesnewEntropy = 0.0for value in uniqueVals:subDataSet = splitDataSet(dataSet, i, value)prob = len(subDataSet) / float(len(dataSet))newEntropy += prob * calcShannonEnt(subDataSet)infoGain = baseEntropy - newEntropy # calculate the info gain; ie reduction in entropyif (infoGain > bestInfoGain): # compare this to the best gain so farbestInfoGain = infoGain # if better than current best, set to bestbestFeature = ireturn bestFeature # returns an integer遍历当前特征中的所有唯一属性值,对每个特征划分一次数据集,然后计算数据集的新熵值,并对所有唯一特征值得到的熵求和。信息增益是熵的减少或者是数据无序度的减少,大家肯 定对于将熵用于度量数据无序度的减少更容易理解。最后,比较所有特征中的信息增益,返回最 好特征划分的索引值

递归构建决策树

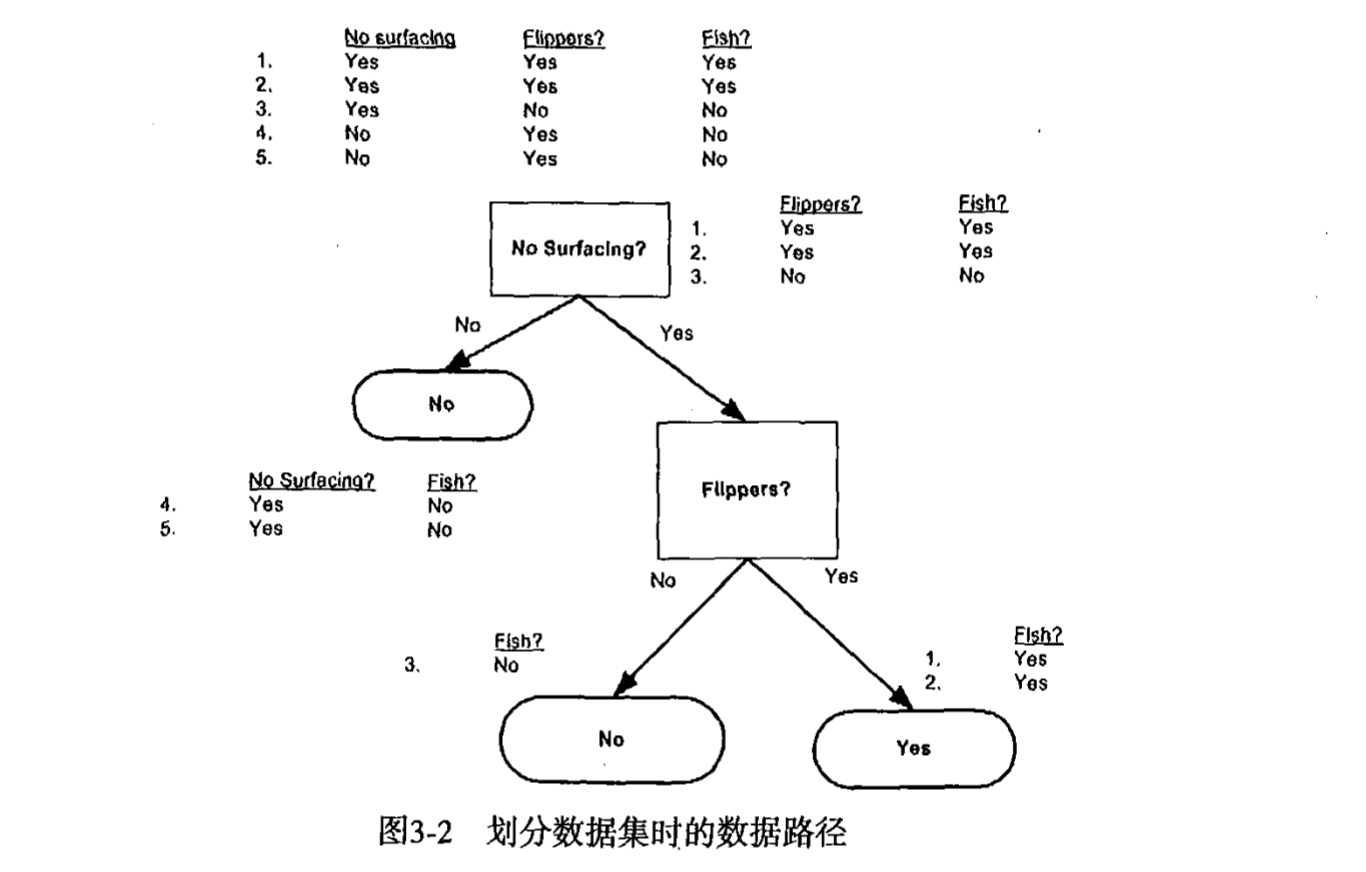

目前我们已经学习了从数据集构造决策树算法所需要的子功能模块,其工作原理如下:得到原始数据集,然后基于最好的属性值划分数据集,由于特征值可能多于两个,因此可能存在大于两个分支的数据集划分。第一次划分后,数据将被向下传递到树分支的下一个节点,在这个节点上,我们可以再次划分数据,因此我们可以采用递归的原则处理数据集。

递归结束的条件是:程序遍历完所有划分数据集的属性,或者每个分支下的所有实例都具有相同的分类。如果所有实例具有相同的分类,则得到一个叶子节点或者终止块。任何到达叶子结点的数据必然属于叶子节点的分类。

如果数据集已经处理了所有属性,但是类标签依然不是唯一的,此时我们需要决定如何定义该叶子节点,在这种情况下,我们通常采用多数表决的方法来决定该叶子节点的分类。

def majorityCnt(classList):classCount = {}for vote in classList:if vote not in classCount.keys(): classCount[vote] = 0classCount[vote] += 1sortedClassCount = sorted(classCount.iteritems(), key=operator.itemgetter(1), reverse=True)return sortedClassCount[0][0]接下来创建树的代码

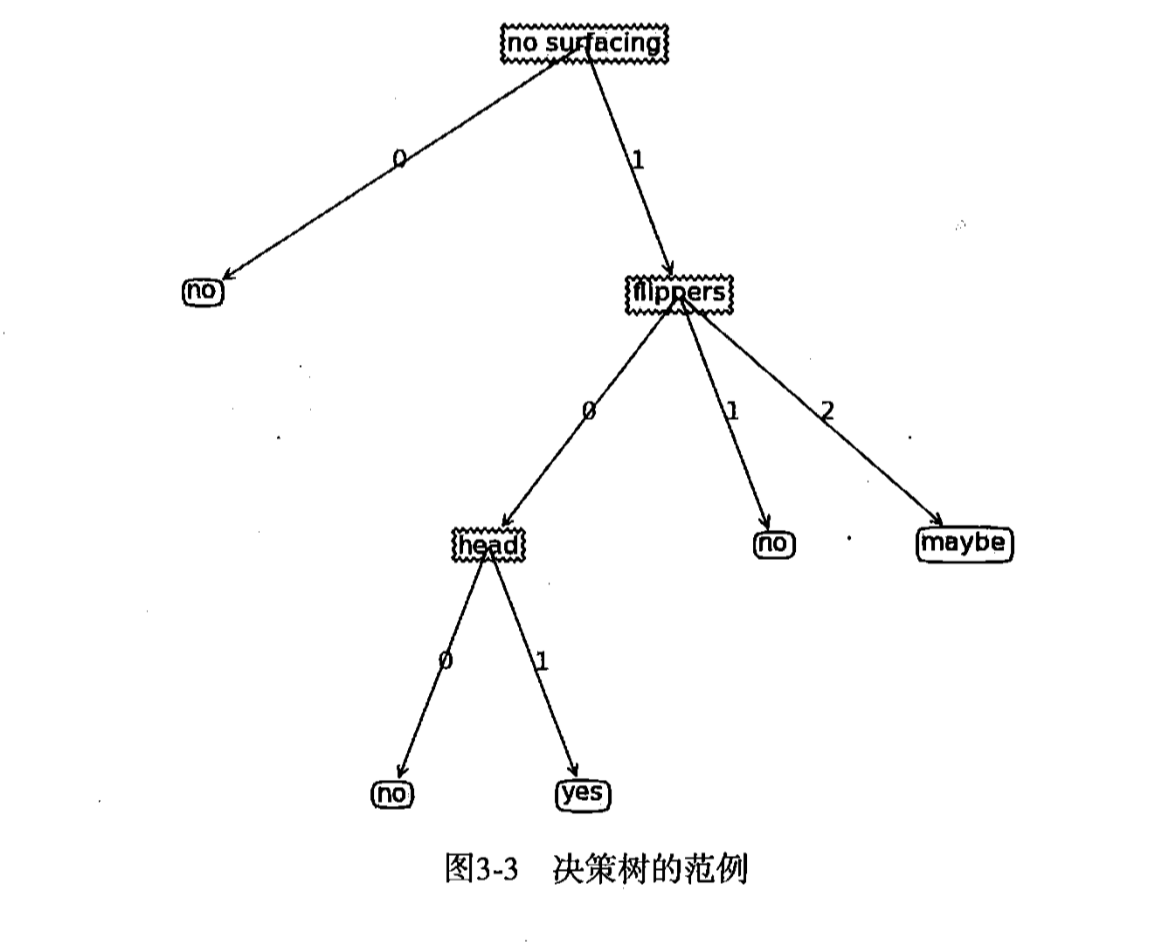

def createTree(dataSet, labels):classList = [example[-1] for example in dataSet]if classList.count(classList[0]) == len(classList):return classList[0] # stop splitting when all of the classes are equalif len(dataSet[0]) == 1: # stop splitting when there are no more features in dataSetreturn majorityCnt(classList)bestFeat = chooseBestFeatureToSplit(dataSet)bestFeatLabel = labels[bestFeat]myTree = {bestFeatLabel: {}}del (labels[bestFeat])featValues = [example[bestFeat] for example in dataSet]uniqueVals = set(featValues)for value in uniqueVals:subLabels = labels[:] # copy all of labels, so trees don't mess up existing labelsmyTree[bestFeatLabel][value] = createTree(splitDataSet(dataSet, bestFeat, value), subLabels)return myTree变量卿myTree包含了很多代表树结构信息的嵌套字典,从左边开始,第一个关键字nosurfaCing是第一个划分数据集的特征名称,该关键字的值也是另一个数据字典。第二个关键字 是nosurfaCinf特征划分的数据集,这些关键字的值是nosurfaCing节点的子节点。这些值可能是类标签,也可能是另一个数据字典。如果值是类标签,则该子节点是叶子节点;如果值是另一个数据字典,则子节点是一个判断节点,这种格式结构不断重复就构成了整棵树。本节的例子中,这棵树包含了3个叶子节点以及2个判断节点.

python中使用matplotlib绘制树

matplotlib注解

matplotlib提供了一个注解工具annotion,非常有用,它可以在数据图形上添加文本注释。注解通常用于解释数据的内容。由于数据上面直接存在文本描述非常丑陋,因此工具内嵌支 持带箭头的划线工具,使得我们可以在其他恰当的地方指向数据位置,并在此处添加描述信息, 解 释 数 据 内 容.

使用文本注解绘制树结点

decisionNode = dict(boxstyle="sawtooth", fc="0.8")

leafNode = dict(boxstyle="round4", fc="0.8")

arrow_args = dict(arrowstyle="<-")def plotNode(nodeTxt, centerPt, parentPt, nodeType):createPlot.ax1.annotate(nodeTxt, xy=parentPt, xycoords='axes fraction',xytext=centerPt, textcoords='axes fraction',va="center", ha="center", bbox=nodeType, arrowprops=arrow_args)def createPlot():fig = plt.figure(1, facecolor='white')fig.clf()createPlot.ax1 = plt.subplot(111, frameon=False) #ticks for demo puropsesplotNode('a decision node', (0.5, 0.1), (0.1, 0.5), decisionNode)plotNode('a leaf node', (0.8, 0.1), (0.3, 0.8), leafNode)plt.show()构造注解树

绘制一棵完整的树需要一些技巧,需要了解有多少叶结点,以确定x轴的长度,同时要知道共有多少层,以便可以确定y轴的高度。

获取叶结点的数目与树的层次

def getNumLeafs(myTree):numLeafs = 0firstStr = myTree.keys()[0]secondDict = myTree[firstStr]for key in secondDict.keys():if type(secondDict[key]).__name__ == 'dict': # test to see if the nodes are dictonaires, if not they are leaf nodesnumLeafs += getNumLeafs(secondDict[key])else:numLeafs += 1return numLeafsdef getTreeDepth(myTree):maxDepth = 0firstStr = myTree.keys()[0]secondDict = myTree[firstStr]for key in secondDict.keys():if type(secondDict[key]).__name__ == 'dict': # test to see if the nodes are dictonaires, if not they are leaf nodesthisDepth = 1 + getTreeDepth(secondDict[key])else:thisDepth = 1if thisDepth > maxDepth: maxDepth = thisDepthreturn maxDepth开始绘制树

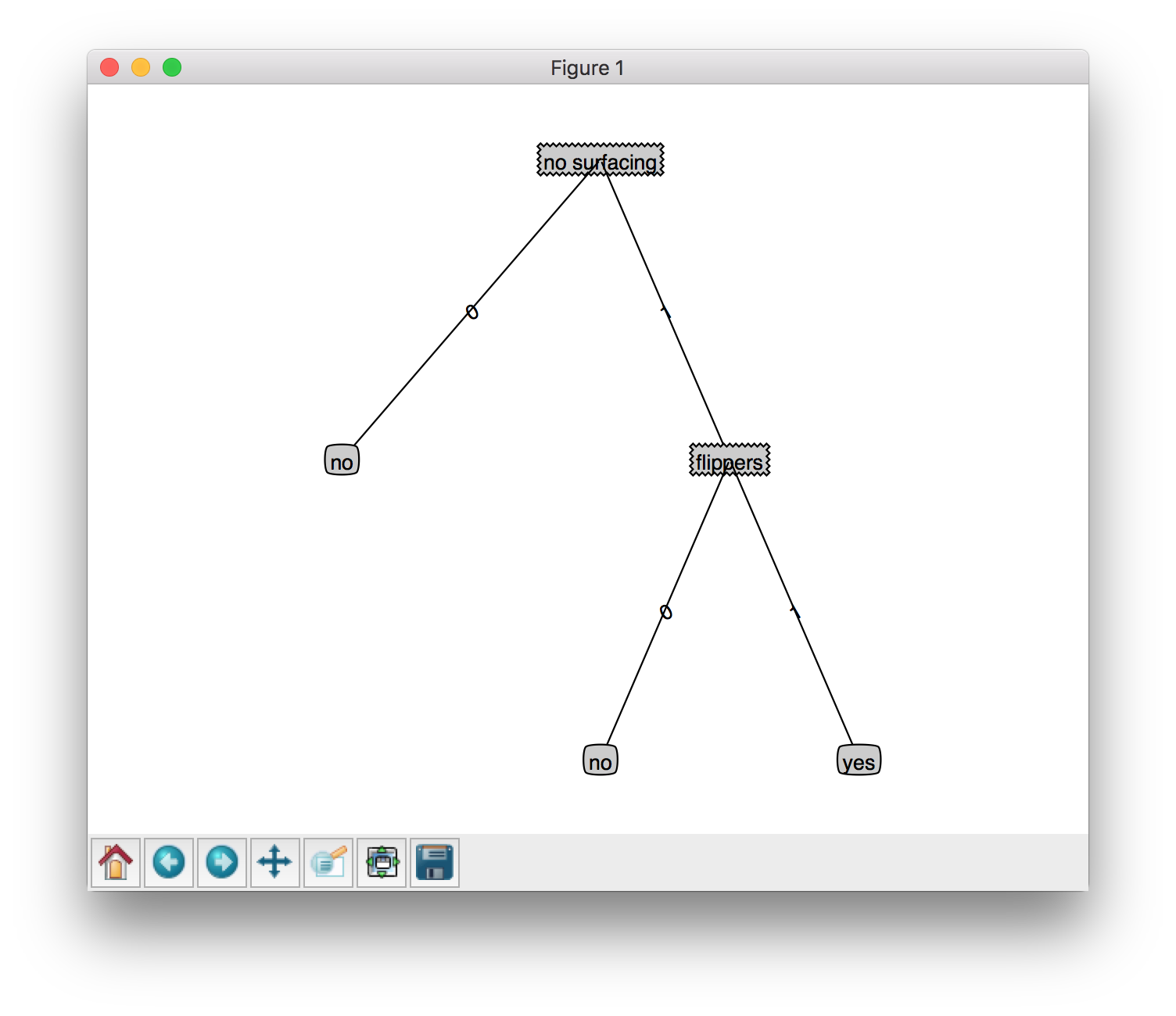

def plotTree(myTree, parentPt, nodeTxt): # if the first key tells you what feat was split onnumLeafs = getNumLeafs(myTree) # this determines the x width of this treedepth = getTreeDepth(myTree)firstStr = myTree.keys()[0] # the text label for this node should be thiscntrPt = (plotTree.xOff + (1.0 + float(numLeafs)) / 2.0 / plotTree.totalW, plotTree.yOff)plotMidText(cntrPt, parentPt, nodeTxt)plotNode(firstStr, cntrPt, parentPt, decisionNode)secondDict = myTree[firstStr]plotTree.yOff = plotTree.yOff - 1.0 / plotTree.totalDfor key in secondDict.keys():if type(secondDict[key]).__name__ == 'dict': # test to see if the nodes are dictonaires, if not they are leaf nodesplotTree(secondDict[key], cntrPt, str(key)) # recursionelse: # it's a leaf node print the leaf nodeplotTree.xOff = plotTree.xOff + 1.0 / plotTree.totalWplotNode(secondDict[key], (plotTree.xOff, plotTree.yOff), cntrPt, leafNode)plotMidText((plotTree.xOff, plotTree.yOff), cntrPt, str(key))plotTree.yOff = plotTree.yOff + 1.0 / plotTree.totalD# if you do get a dictonary you know it's a tree, and the first element will be another dictdef createPlot(inTree):fig = plt.figure(1, facecolor='white')fig.clf()axprops = dict(xticks=[], yticks=[])createPlot.ax1 = plt.subplot(111, frameon=False, **axprops) # no ticks# createPlot.ax1 = plt.subplot(111, frameon=False) #ticks for demo puropsesplotTree.totalW = float(getNumLeafs(inTree))plotTree.totalD = float(getTreeDepth(inTree))plotTree.xOff = -0.5 / plotTree.totalW;plotTree.yOff = 1.0;plotTree(inTree, (0.5, 1.0), '')plt.show()

测试与存储分类器

测试算法,使用决策树执行分类

依靠训练数据构造了决策树之后,我们可以将它用于实际数据的分类。在执行数据分类时, 需要决策树以及用于构造树的标签向量。然 后 ,程序比较测试数据与决策树上的数值,递归执行 该过程直到进人叶子节点;最后将测试数据定义为叶子节点所属的类型。

def classify(inputTree, featLabels, testVec):firstStr = inputTree.keys()[0]secondDict = inputTree[firstStr]featIndex = featLabels.index(firstStr)key = testVec[featIndex]valueOfFeat = secondDict[key]if isinstance(valueOfFeat, dict):classLabel = classify(valueOfFeat, featLabels, testVec)else:classLabel = valueOfFeatreturn classLabel定义的函数也是一个递归函数,在存储带有特征的数据会面临一个问题:程序无法确定特征在数据集中的位置,例如前面例子的第一个用于划分数据集的特征是nosurfacing属 性 ,但是在实际数据集中该属性存储在哪个位置?是第一个属性还是第二个属性? 特征标签列表将帮助程序处理这个问题

现在我们已经创建了使用决策树的分类器,但是每次使用分类器时,必须重新构造决策树,下一节我们将介绍如何在硬盘上存储决策树分类器。

决策树的存储

构建决策树是一项很费时的操作,即使处理很小的数据量,如果数据量很大,将会耗费许多时间,如果用创建好的决策树,则可以解决这个问题。为了解决这个问题,需要用到python的pickle序列化对象。

def storeTree(inputTree, filename):import picklefw = open(filename, 'w')pickle.dump(inputTree, fw)fw.close()def grabTree(filename):import picklefr = open(filename)return pickle.load(fr)通过上述代码,可以将决策树存储在硬盘上,这也是决策树的优点之一。

使用决策树预测隐形眼镜类型

决策树预测患者需要佩戴的眼镜类型。

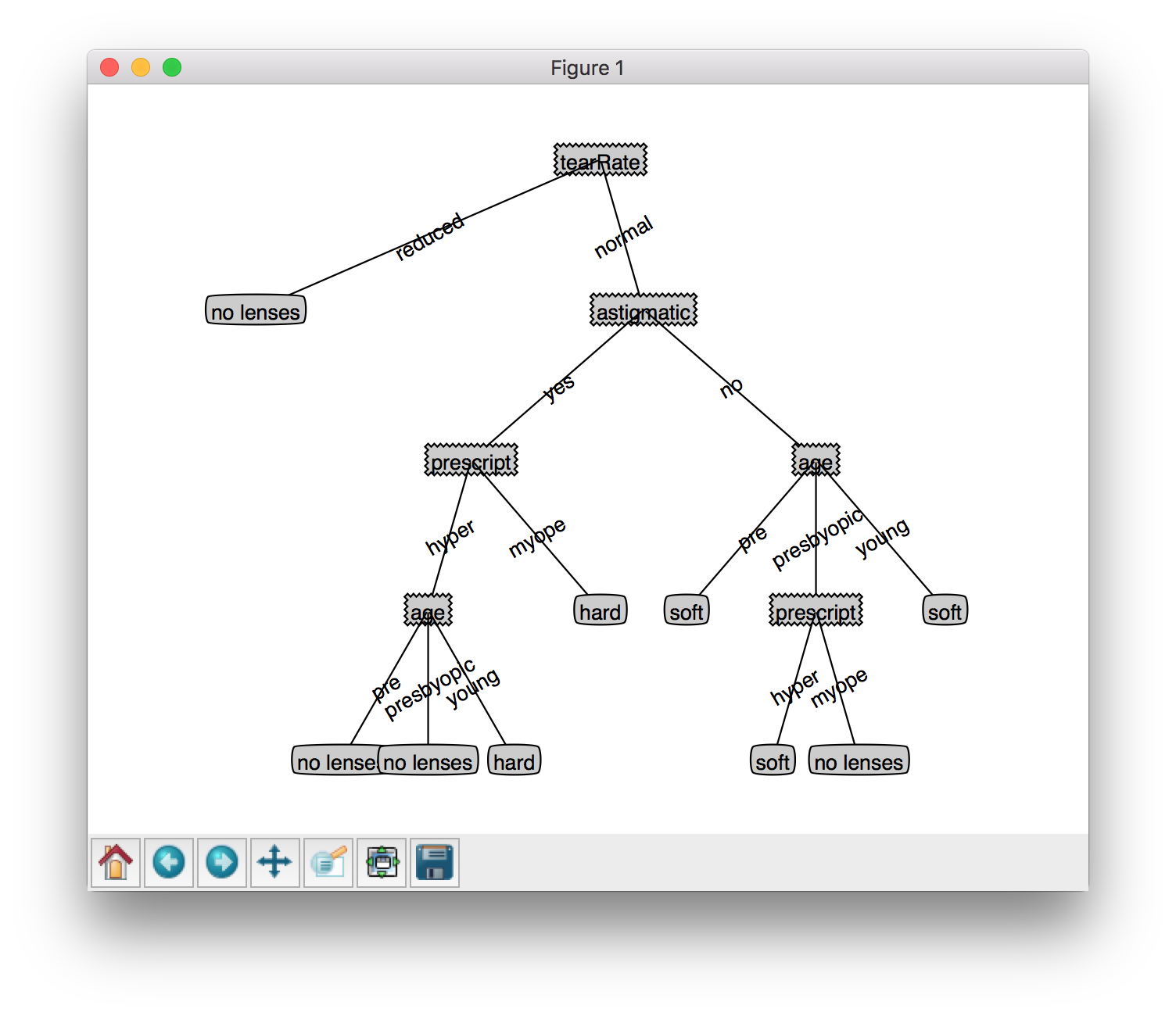

隐形眼镜数据集是很著名的数据集,它包含许多患者的眼部观察情况与医生推荐的隐形眼镜类型。隐形眼镜类型包括硬材质,软材质,不适合佩戴隐形眼镜3种。

def glassTest():fr = open('lenses.txt')lenses = [inst.strip().split('\t') for inst in fr.readlines()]lensesLabels = ['age','prescript','astigmatic','tearRate']lensesTree = createTree(lenses,lensesLabels)treePlot.createPlot(lensesTree)

图3-8所示的决策树非常好地匹配了实验数据,然而这些匹配选项可能太多了。我们将这种问题称之为过度匹配。为了减少过度匹配问题,我们可以裁剪决策树,去掉一些不 必要的叶子节点。如果叶子节点只能增加少许信息,则可以删除该节点,将它并人到其他叶子节 点中.

本章的算法称为ID3算法,无法直接处理数值型数值,还有一个流行的决策树构造算法CART

小结

决策树分类器就像带有终止块的流程图,终止块表示分类结果。开始处理数据集时,我们首先需要测量集合中数据的不一致性,也就是熵,然后寻找最优方案划分数据集,直到数据集中的 所有数据属于同一分类。ID3算法可以用于划分标称型数据集。构建决策树时,我们通常采用递归的方法将数据集转化为决策树。一般我们并不构造新的数据结构,而是使用python语言内嵌的 数据结构字典存储树节点信息。

使用matplotlib的注解功能,我们可以将存储的树结构转化为容易理解的图形。python语言的pickle模块可用于存储决策树的结构。隐形眼镜的例子表明决策树可能会产生过多的数据集划分, 从而产生过度匹配数据集的问题。我们可以通过裁剪决策树,合并相邻的无法产生大量信息增益的叶节点,消除过度匹配问题。

机器学习实战之决策树相关推荐

- 机器学习实战之决策树熵的概述

机器学习实战之决策树熵的概述 一.决策树简介 二.决策树的一般流程 三.决策树构建的准备工作 1.特征选择 (1)香农熵 (2)编写代码计算经验熵 (3)信息增益 (4)编写代码计算信息增益 2.决策 ...

- 机器学习实战——绘制决策树(代码)

最近在学习Peter Harrington的<机器学习实战>,代码与书中的略有不同,但可以顺利运行. import matplotlib.pyplot as plt# 定义文本框和箭头格式 ...

- 机器学习实战之决策树(一)构造决策树

决策树(一)构造决策树 1.简介 1.1 优缺点 1.2 流程 1.3 决策树的构造 1.4 海洋生物数据 2.信息增益 2.1 几个概念 2.2 计算给定数据集的熵 3 划分数据集 3.1 按照给定 ...

- 刻意练习:机器学习实战 -- Task01. 决策树

背景 这是我们为拥有 Python 基础的同学推出的精进技能的"机器学习实战" 刻意练习活动,这也是我们本学期推出的第三次活动了. 我们准备利用8周时间,夯实机器学习常用算法,完成 ...

- 《机器学习实战》—— 决策树

目录 一.决策树的构造 1. 信息增益 2. 划分数据集 3. 递归构建决策树 二.在 Python 中使用 Matplotlib 注解绘制树形图 1. Matplotlib 2. 构造注解树 三.测 ...

- 《机器学习实战》——决策树

一 决策树 决策树是什么?决策树(decision tree)是一种基本的分类与回归方法.举个通俗易懂的例子,如下图所示的流程图就是一个决策树,长方形代表判断模块(decision block),椭圆 ...

- 《机器学习实战》决策树的应用

课本中给出的是一个预测隐形眼镜的例子. 数据集样式如下: young myope no reduced no lenses young myope no no ...

- 机器学习实战之决策树(四)示例:预测隐形眼镜类型(含数据集)

决策树(四)示例:预测隐形眼镜类型 流程 代码 决策树小结 转载请注明作者和出处:https://blog.csdn.net/weixin_45814668 微信公众号:qiongjian0427 知 ...

- 机器学习实战(二)决策树DT(Decision Tree、ID3算法)

目录 0. 前言 1. 信息增益(ID3) 2. 决策树(Decision Tree) 3. 实战案例 3.1. 隐形眼镜案例 3.2. 存储决策树 3.3. 决策树画图表示 学习完机器学习实战的决策 ...

最新文章

- tomcat cpu占用过高,系统负载高问题跟踪

- H5中canvas和svg绘图方式介绍

- 开源python-文档撰写

- lambda表达式_Lambda表达式详解

- Java抓取淘宝/天猫商品详情

- python学习笔记(五)缩进

- 【英语学习】【WOTD】animadversion 释义/词源/示例

- php解析json里的hson_这种json字符串PHP如何解析?

- mac远程连接linux 服务器桌面by VNC

- CAD文件零基础批量转换DWG格式

- matlab中几种取整函数的用法(fix, floor, ceil, round)

- 中国银联Apple Pay 支付集成

- Android桌面图标快捷方式

- 伯特兰·阿瑟·威廉·罗素

- SpringCloud02Nacos Discovery--服务治理

- 微信如何解绑小程序_微信小程序解绑事件,微信小程序解除绑定

- Android应用开发中,第三方集成新浪微博(sinaWeiboSDK)的过程记录

- 信号相角位移量的计算与信号位移计算-附Matlab代码

- 《快递查询-您身边的快递助手-技术支持》

- BackTrack 5RC3为Firefox安装Flash Player失败的解决办法