MLPClassifier 隐藏层不包括输入和输出

多层感知机(MLP)原理简介

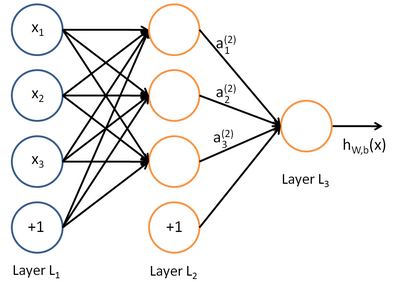

多层感知机(MLP,Multilayer Perceptron)也叫人工神经网络(ANN,Artificial Neural Network),除了输入输出层,它中间可以有多个隐层,最简单的MLP只含一个隐层,即三层的结构,如下图:

从上图可以看到,多层感知机层与层之间是全连接的(全连接的意思就是:上一层的任何一个神经元与下一层的所有神经元都有连接)。多层感知机最底层是输入层,中间是隐藏层,最后是输出层。

输入层没什么好说,你输入什么就是什么,比如输入是一个n维向量,就有n个神经元。

隐藏层的神经元怎么得来?首先它与输入层是全连接的,假设输入层用向量X表示,则隐藏层的输出就是

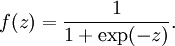

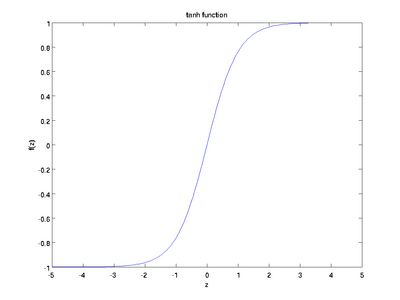

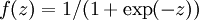

f(W1X+b1),W1是权重(也叫连接系数),b1是偏置,函数f 可以是常用的sigmoid函数或者tanh函数:

最后就是输出层,输出层与隐藏层是什么关系?其实隐藏层到输出层可以看成是一个多类别的逻辑回归,也即softmax回归,所以输出层的输出就是softmax(W2X1+b2),X1表示隐藏层的输出f(W1X+b1)。

sklearn.neural_network.MLPClassifier

-

class

sklearn.neural_network.MLPClassifier(hidden_layer_sizes=(100, ), activation=’relu’, solver=’adam’, alpha=0.0001, batch_size=’auto’, learning_rate=’constant’, learning_rate_init=0.001, power_t=0.5, max_iter=200, shuffle=True, random_state=None, tol=0.0001, verbose=False, warm_start=False, momentum=0.9, nesterovs_momentum=True, early_stopping=False, validation_fraction=0.1, beta_1=0.9, beta_2=0.999, epsilon=1e-08, n_iter_no_change=10)[source] -

Multi-layer Perceptron classifier.

This model optimizes the log-loss function using LBFGS or stochastic gradient descent.

New in version 0.18.

Parameters: - hidden_layer_sizes : tuple, length = n_layers - 2, default (100,)

-

The ith element represents the number of neurons in the ith hidden layer.

- activation : {‘identity’, ‘logistic’, ‘tanh’, ‘relu’}, default ‘relu’

-

Activation function for the hidden layer.

- ‘identity’, no-op activation, useful to implement linear bottleneck, returns f(x) = x

- ‘logistic’, the logistic sigmoid function, returns f(x) = 1 / (1 + exp(-x)).

- ‘tanh’, the hyperbolic tan function, returns f(x) = tanh(x).

- ‘relu’, the rectified linear unit function, returns f(x) = max(0, x)

- solver : {‘lbfgs’, ‘sgd’, ‘adam’}, default ‘adam’

-

The solver for weight optimization.

- ‘lbfgs’ is an optimizer in the family of quasi-Newton methods.

- ‘sgd’ refers to stochastic gradient descent.

- ‘adam’ refers to a stochastic gradient-based optimizer proposed by Kingma, Diederik, and Jimmy Ba

Note: The default solver ‘adam’ works pretty well on relatively large datasets (with thousands of training samples or more) in terms of both training time and validation score. For small datasets, however, ‘lbfgs’ can converge faster and perform better.

- alpha : float, optional, default 0.0001

-

L2 penalty (regularization term) parameter.

- batch_size : int, optional, default ‘auto’

-

Size of minibatches for stochastic optimizers. If the solver is ‘lbfgs’, the classifier will not use minibatch. When set to “auto”, batch_size=min(200, n_samples)

- learning_rate : {‘constant’, ‘invscaling’, ‘adaptive’}, default ‘constant’

-

Learning rate schedule for weight updates.

- ‘constant’ is a constant learning rate given by ‘learning_rate_init’.

- ‘invscaling’ gradually decreases the learning rate

learning_rate_at each time step ‘t’ using an inverse scaling exponent of ‘power_t’. effective_learning_rate = learning_rate_init / pow(t, power_t) - ‘adaptive’ keeps the learning rate constant to ‘learning_rate_init’ as long as training loss keeps decreasing. Each time two consecutive epochs fail to decrease training loss by at least tol, or fail to increase validation score by at least tol if ‘early_stopping’ is on, the current learning rate is divided by 5.

Only used when

solver='sgd'. - learning_rate_init : double, optional, default 0.001

-

The initial learning rate used. It controls the step-size in updating the weights. Only used when solver=’sgd’ or ‘adam’.

- power_t : double, optional, default 0.5

-

The exponent for inverse scaling learning rate. It is used in updating effective learning rate when the learning_rate is set to ‘invscaling’. Only used when solver=’sgd’.

概述

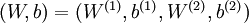

以监督学习为例,假设我们有训练样本集  ,那么神经网络算法能够提供一种复杂且非线性的假设模型

,那么神经网络算法能够提供一种复杂且非线性的假设模型  ,它具有参数

,它具有参数  ,可以以此参数来拟合我们的数据。

,可以以此参数来拟合我们的数据。

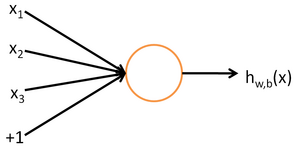

为了描述神经网络,我们先从最简单的神经网络讲起,这个神经网络仅由一个“神经元”构成,以下即是这个“神经元”的图示:

这个“神经元”是一个以  及截距

及截距  为输入值的运算单元,其输出为

为输入值的运算单元,其输出为  ,其中函数

,其中函数  被称为“激活函数”。在本教程中,我们选用sigmoid函数作为激活函数

被称为“激活函数”。在本教程中,我们选用sigmoid函数作为激活函数

可以看出,这个单一“神经元”的输入-输出映射关系其实就是一个逻辑回归(logistic regression)。

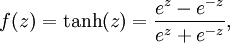

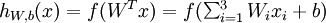

虽然本系列教程采用sigmoid函数,但你也可以选择双曲正切函数(tanh):

以下分别是sigmoid及tanh的函数图像

函数是sigmoid函数的一种变体,它的取值范围为

函数是sigmoid函数的一种变体,它的取值范围为  ,而不是sigmoid函数的

,而不是sigmoid函数的  。

。

注意,与其它地方(包括OpenClassroom公开课以及斯坦福大学CS229课程)不同的是,这里我们不再令  。取而代之,我们用单独的参数

。取而代之,我们用单独的参数  来表示截距。

来表示截距。

最后要说明的是,有一个等式我们以后会经常用到:如果选择  ,也就是sigmoid函数,那么它的导数就是

,也就是sigmoid函数,那么它的导数就是  (如果选择tanh函数,那它的导数就是

(如果选择tanh函数,那它的导数就是  ,你可以根据sigmoid(或tanh)函数的定义自行推导这个等式。

,你可以根据sigmoid(或tanh)函数的定义自行推导这个等式。

神经网络模型

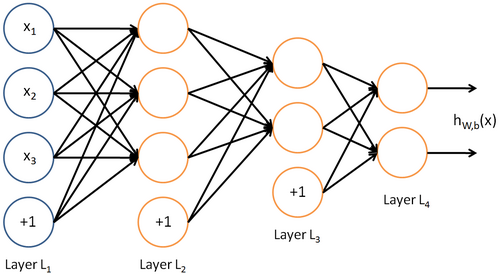

所谓神经网络就是将许多个单一“神经元”联结在一起,这样,一个“神经元”的输出就可以是另一个“神经元”的输入。例如,下图就是一个简单的神经网络:

我们使用圆圈来表示神经网络的输入,标上“ ”的圆圈被称为偏置节点,也就是截距项。神经网络最左边的一层叫做输入层,最右的一层叫做输出层(本例中,输出层只有一个节点)。中间所有节点组成的一层叫做隐藏层,因为我们不能在训练样本集中观测到它们的值。同时可以看到,以上神经网络的例子中有3个输入单元(偏置单元不计在内),3个隐藏单元及一个输出单元。

”的圆圈被称为偏置节点,也就是截距项。神经网络最左边的一层叫做输入层,最右的一层叫做输出层(本例中,输出层只有一个节点)。中间所有节点组成的一层叫做隐藏层,因为我们不能在训练样本集中观测到它们的值。同时可以看到,以上神经网络的例子中有3个输入单元(偏置单元不计在内),3个隐藏单元及一个输出单元。

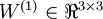

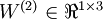

我们用  来表示网络的层数,本例中

来表示网络的层数,本例中  ,我们将第

,我们将第  层记为

层记为  ,于是

,于是  是输入层,输出层是

是输入层,输出层是  。本例神经网络有参数

。本例神经网络有参数  ,其中

,其中  (下面的式子中用到)是第

(下面的式子中用到)是第  层第

层第  单元与第

单元与第  层第

层第  单元之间的联接参数(其实就是连接线上的权重,注意标号顺序),

单元之间的联接参数(其实就是连接线上的权重,注意标号顺序),  是第

是第  层第

层第  单元的偏置项。因此在本例中,

单元的偏置项。因此在本例中,  ,

,  。注意,没有其他单元连向偏置单元(即偏置单元没有输入),因为它们总是输出

。注意,没有其他单元连向偏置单元(即偏置单元没有输入),因为它们总是输出  。同时,我们用

。同时,我们用  表示第

表示第  层的节点数(偏置单元不计在内)。

层的节点数(偏置单元不计在内)。

我们用  表示第

表示第  层第

层第  单元的激活值(输出值)。当

单元的激活值(输出值)。当  时,

时,  ,也就是第

,也就是第  个输入值(输入值的第

个输入值(输入值的第  个特征)。对于给定参数集合

个特征)。对于给定参数集合  ,我们的神经网络就可以按照函数

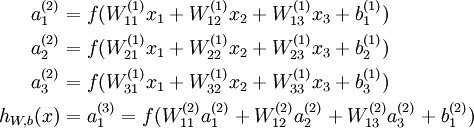

,我们的神经网络就可以按照函数  来计算输出结果。本例神经网络的计算步骤如下:

来计算输出结果。本例神经网络的计算步骤如下:

我们用  表示第

表示第  层第

层第  单元输入加权和(包括偏置单元),比如,

单元输入加权和(包括偏置单元),比如,  ,则

,则  。

。

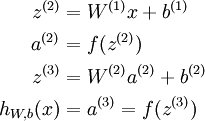

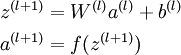

这样我们就可以得到一种更简洁的表示法。这里我们将激活函数  扩展为用向量(分量的形式)来表示,即

扩展为用向量(分量的形式)来表示,即  ,那么,上面的等式可以更简洁地表示为:

,那么,上面的等式可以更简洁地表示为:

我们将上面的计算步骤叫作前向传播。回想一下,之前我们用  表示输入层的激活值,那么给定第

表示输入层的激活值,那么给定第  层的激活值

层的激活值  后,第

后,第  层的激活值

层的激活值  就可以按照下面步骤计算得到:

就可以按照下面步骤计算得到:

将参数矩阵化,使用矩阵-向量运算方式,我们就可以利用线性代数的优势对神经网络进行快速求解。

目前为止,我们讨论了一种神经网络,我们也可以构建另一种结构的神经网络(这里结构指的是神经元之间的联接模式),也就是包含多个隐藏层的神经网络。最常见的一个例子是  层的神经网络,第

层的神经网络,第  层是输入层,第

层是输入层,第  层是输出层,中间的每个层

层是输出层,中间的每个层  与层

与层  紧密相联。这种模式下,要计算神经网络的输出结果,我们可以按照之前描述的等式,按部就班,进行前向传播,逐一计算第

紧密相联。这种模式下,要计算神经网络的输出结果,我们可以按照之前描述的等式,按部就班,进行前向传播,逐一计算第  层的所有激活值,然后是第

层的所有激活值,然后是第  层的激活值,以此类推,直到第

层的激活值,以此类推,直到第  层。这是一个前馈神经网络的例子,因为这种联接图没有闭环或回路。

层。这是一个前馈神经网络的例子,因为这种联接图没有闭环或回路。

神经网络也可以有多个输出单元。比如,下面的神经网络有两层隐藏层:  及

及  ,输出层

,输出层  有两个输出单元。

有两个输出单元。

要求解这样的神经网络,需要样本集  ,其中

,其中  。如果你想预测的输出是多个的,那这种神经网络很适用。(比如,在医疗诊断应用中,患者的体征指标就可以作为向量的输入值,而不同的输出值

。如果你想预测的输出是多个的,那这种神经网络很适用。(比如,在医疗诊断应用中,患者的体征指标就可以作为向量的输入值,而不同的输出值  可以表示不同的疾病存在与否。)

可以表示不同的疾病存在与否。)

中英文对照

neural networks 神经网络

activation function 激活函数

hyperbolic tangent 双曲正切函数

bias units 偏置项

activation 激活值

forward propagation 前向传播

feedforward neural network 前馈神经网络(参照Mitchell的《机器学习》的翻译)

转载于:https://www.cnblogs.com/bonelee/p/9092080.html

MLPClassifier 隐藏层不包括输入和输出相关推荐

- BP神经网络隐藏层的作用,bp神经网络输出层函数

matlab bp神经网络只能输入一组预测一组吗 可以用前面很多数据建立网络后预测下几组数据吗 当然可以,这就是输入模式和输出模式的制定,可以自由设置,多输入多输出.但要注意如果预测多组,输入必须要提 ...

- Tensorflow--tutorial--建造神经网络(输入层,隐藏层,输出层)

建造一个完整的神经网络,包括添加神经层,计算误差,训练步骤,判断是否在学习. 代码如下:(我把注释写的非常详细,不用怕看不懂) from __future__ import print_functio ...

- 【数据挖掘】神经网络 后向传播算法 向前传播输入 案例计算分析 ( 网络拓扑 | 输入层计算 | 隐藏层计算 | 输出层计算 )

文章目录 I . 神经网络 后向传播算法 计算 隐藏层 与 输出层 的输入输出实例分析 II . 神经网络 后向传播算法 输入层公式 III. 神经网络 后向传播算法 输入层计算 IV . 神经网络 ...

- 神经网络的输出层有哪些_深度学习的数学-神经网络、输入层、隐藏层、输出层...

前言 前文中了解到,神经网络由多个神经单元组成,而本篇博客将会了解到深度学习由多个神经网络组成,并且分为 输入层.隐藏层和输出层,隐藏层涉及到的知识点最多,是本文的重点 正文 阶层型的神经网络主要结构 ...

- pytorch_lesson13.2 模型拟合度概念介绍+模型欠拟合实例+单隐藏层激活函数性能比较+相同激活函数不同隐藏层数结果对比+神经网络结构选择策略

提示:仅仅是学习记录笔记,搬运了学习课程的ppt内容,本意不是抄袭!望大家不要误解!纯属学习记录笔记!!!!!! 文章目录 前言 一.模型拟合度概念介绍与实验 1.测试集的"不可知" ...

- 2-神经网络起源-demo3-共享单车__小批量多隐藏层_答案

import numpy as np import pandas as pd import matplotlib.pyplot as plt# 解决pd中print中间省略的问题 pd.set_opt ...

- hidden layer隐藏层的自我理解

在学习深层神经网络的时候在思考隐藏层的明确的定义和到底为什么要它,它到底能起到什么作用 一下见解仅代表个人和收集到的网上的观点,仅此记录 隐藏层的定义是:除输入层和输出层以外的其他各层叫做隐藏层.隐藏 ...

- DL之DNN:基于自定义数据集利用深度神经网络(输入层(10个unit)→2个隐藏层(10个unit)→输出层1个unit)实现回归预测实现代码

DL之DNN:基于自定义数据集利用深度神经网络(输入层(10个unit)→2个隐藏层(10个unit)→输出层1个unit)实现回归预测实现代码 目录 基于自定义数据集利用深度神经网络(输入层(10个 ...

- 【数据挖掘】神经网络 后向传播算法( 向后传播误差 | 输出层误差公式 | 隐藏层误差公式 | 单元连接权值更新公式 | 单元偏置更新公式 | 反向传播 | 损失函数 | 误差平方和 | 交叉熵 )

文章目录 I . 向后传播误差 简介 II . 输出层误差计算公式 III . 隐藏层层误差计算公式 IV . 使用误差更新 连接权值 V . 使用误差更新 单元偏置 VI . 反向传播 过程 VII ...

最新文章

- 杭电多校(二)2019.7.24--暑假集训

- 论文解读 | 基于正则化图神经网络的脑电情绪识别

- emq数据储存到mysql_EMQ X 规则引擎系列(三)存储消息到 InfluxDB 时序数据库

- mfc在调整界面时左边的控件会丢失_Qt项目中如何完成一个漂亮的界面

- 光盘装系统和U盘装系统有什么区别吗?

- Opencv之读取yuv420P

- R_Studio模拟学生成绩对数据简单分析

- easydatasource能删除吗_面试官:能跟我说一下rm删除文件之后,空间都发生了什么吗?

- efi文件错误服务器崩溃,[转自百度]关于系统安装时候弹出提示winload.efi文件损坏...

- Google 2018 更新内容

- Zookeeper的事务--Transaction

- 中国新中产家庭“清洁观”:能躺着不站着,能靠科技不靠手

- php5.6安装zendopcache加速

- oracle 11g duplicate database基于备份复制数据库(四)

- 已解决Excel无法打开文件test.xIsx“,因为文件格式或文件扩展名无效。请确定文件未损坏,并且文件扩展名与文件的格式匹配。

- python中\r 的意义

- Springboot实战项目---从需求分析到项目部署一站式开发,给简历添加一点色彩

- IAR修改工程名方法

- Visual Studio技巧之打造拥有自己标识的代码模板

- VScode神仙插件,程序员必备

热门文章

- Redis设置外网可访问

- centos7.1 RabbitMQ安装配置

- python blp模型 估计_第三章 BLP模型(Bell-La Padula模型) | 学步园

- c语言递归求塔移动次数,【C语言】Hanoi(汉诺)塔问题,求移动盘子的步骤(递归法)...

- 苹果状态栏HTML,CSS3实现苹果电脑的DOCK菜单栏_html/css_WEB-ITnose

- java.util.timezone_java.util.TimeZone.getTimeZone()

- thinkphp5调用shell脚本_thinkphp5.x全版本任意代码执行getshell

- Java可以跨平台的原因

- 大牛整理:java去掉字符串中的逗号

- python【Opencv计算机视觉库】opencv模块cv2常用函数用法(全)