深度学习之神经网络核心原理与算法-caffekeras框架图片分类

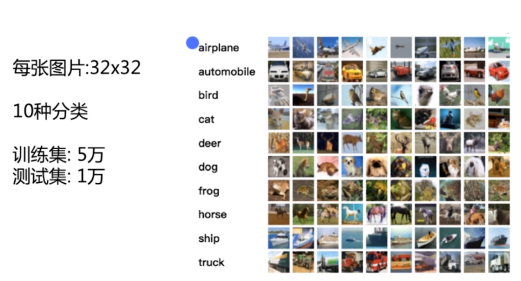

之前我们在使用cnn做图片分类的时候使用了CIFAR-10数据集

其他框架对于CIFAR-10的图片分类是怎么做的

来与TensorFlow做对比。

Caffe Keras

安装

官方安装文档:

https://github.com/IraAI/caffe-gpu-installation

https://github.com/BVLC/caffe/tree/windows

windows下安装gpu加速版的caffe

mark

使用的数据集依然是CIFAR-10,使用的也依然是卷积神经网络。查看有什么不同点和相同点。

十种分类。

准备数据

把图片转成leveldb格式,对图片做均值。

mark

里面是一个官方给出来的例子,如何使用caffe 对cifar10做分类。

caffe-master/examples/cifar10/create_cifar10.sh

是一个bash脚本: 作用是转换cifar数据到 into leveldb format.

定义了两个目录变量和数据类型

EXAMPLE=examples/cifar10 DATA=data/cifar10 DBTYPE=lmdb

删除指定目录下的文件

echo "Creating $DBTYPE..."rm -rf $EXAMPLE/cifar10_train_$DBTYPE $EXAMPLE/cifar10_test_$DBTYPE

调用了convert_cifar_data.bin 二进制文件。 指定参数,就可以下载,解压,格式化。

计算图片的均值。compute_image_mean 输入参数 backend: 数据类型。

计算均值,保存到mean.binaryproto文件中

将数据转换为lmdb格式,保存到磁盘中。

计算image文件的均值。保存。

这里用到的两个命令是c++编写的,也可以阅读源代码变成python脚本。

网上也有这个数据脚本的python实现代码

http://research.beenfrog.com/code/2015/05/04/write-leveldb-lmdb-using-python.html

就是根据c++代码改写的。这两个数据格式都是键值对的格式。

训练模型

caffe-master/examples/cifar10/train_quick.sh

#!/usr/bin/env shset -eTOOLS=./build/tools

定义一个存放的目录

调用tools目录下的caffe 主程序。

$TOOLS/caffe train \--solver=examples/cifar10/cifar10_quick_solver.prototxt $@

第一个参数指定训练,第二个参数指定模型

cifar10_quick_solver.prototxt

超参数和模型的结构定义与描述。

# The train/test net protocol buffer definitionnet: "examples/cifar10/cifar10_quick_train_test.prototxt"

网络结构:

caffe-master/examples/cifar10/cifar10_quick_train_test.prototxt

我们在使用TensorFlow时是使用python脚本定义的网络结构。有多少层什么的。

caffe使用一个描述文件来描述。

第二次的时候从第一次的模型快照处继续运行。

# reduce learning rate by factor of 10 after 8 epochs$TOOLS/caffe train \--solver=examples/cifar10/cifar10_quick_solver_lr1.prototxt \--snapshot=examples/cifar10/cifar10_quick_iter_4000.solverstate $@

两次的变化只是学习率不同。

模型的描述文件

mark

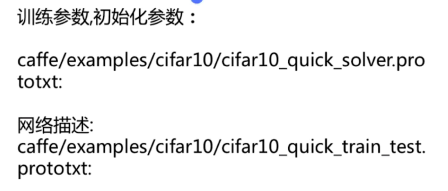

训练参数,初始化参数: 网络描述

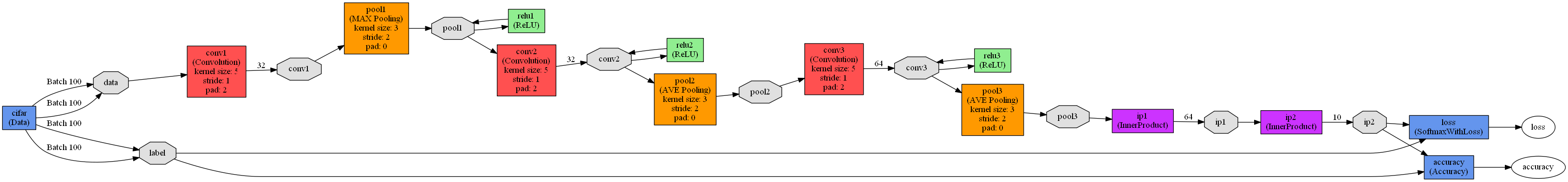

caffe中有方法可以将模型的描述文件打印成图表

caffe-master/examples/cifar10/cifar10_quick_train_test.prototxt

http://ethereon.github.io/netscope/#/editor

mark

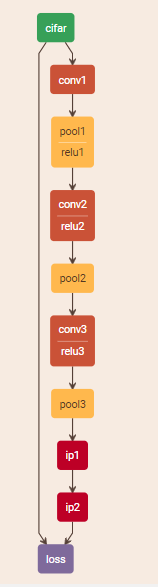

第一层是数据层。卷积层 池层 卷积层 池层 全连接 激励函数。 softmax

本地版本:

https://graphviz.gitlab.io/_pages/Download/Download_windows.html# 下载Graphvizpip install pydot

python draw_net.py C:\Users\mtian\PycharmProjects\NeuralNetworksGetStarted\caffe-master\examples\cifar10\cifar10_quick_train_test.prototxt ./cifar.png

运行的画图py文件,位于caffe python下。

三个参数: 1. 网络模型的ProtoTXT文件 2. 保存的图片路径 3. 从左到右。

–rankdir=x , x 有四种选项,分别是LR, RL, TB, BT 。

画图报错:

Traceback (most recent call last):File "draw_net.py", line 9, in <module> import caffe.drawFile "C:\software\caffe\python\caffe\draw.py", line 31, in <module>pydot_find_graphviz = pydot.graphviz.find_graphviz AttributeError: module 'pydot_ng' has no attribute 'graphviz'

查看这个文件可以看到里面写着解决方案

pip install pydot-plustry: # Try to load pydotplusimport pydotplus as pydot

给这个描述文件起一个名字

name: "CIFAR10_quick"

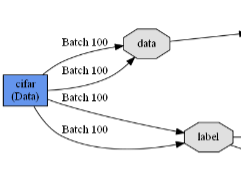

定义每一层,名字,类型,top有两个一个是data 一个是label。数据层的top有两个

layer {name: "cifar"type: "Data"top: "data"top: "label"

mark

训练阶段调用这一层

include { phase: TRAIN}

图片的均值文件所放的路径。

transform_param { mean_file: "examples/cifar10/mean.binaryproto"}

图片的训练数据路径,batchsize的大小。训练数据存储的方式

data_param { source: "examples/cifar10/cifar10_train_lmdb"batch_size: 100backend: LMDB}

接下来又定义了一层

layer {name: "cifar"type: "Data"top: "data"top: "label"include {phase: TEST}transform_param {mean_file: "examples/cifar10/mean.binaryproto"}data_param {source: "examples/cifar10/cifar10_test_lmdb"batch_size: 100backend: LMDB}

}

跟上一层一模一样,只不过指定了阶段是TEST

测试集入口和训练集入口

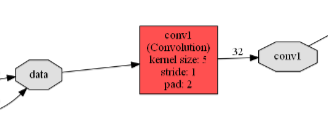

卷积层

layer { name: "conv1"type: "Convolution"bottom: "data"top: "conv1"param {lr_mult: 1} param { lr_mult: 2} convolution_param { num_output: 32pad: 2kernel_size: 5stride: 1weight_filler {type: "gaussian"std: 0.0001} bias_filler { type: "constant"}}

}

起个名字,类型卷积层。bottom是data也就是上一层的名字。上一层的top对应下一层的bottom

top是conv1

mark

指定了一下w和b的学习率。以及卷积层的相关参数

总共有多少个output的feature map

padding 过滤器大小 步长

w的初始化方式: 高斯 方差

b的初始化方式: 类型

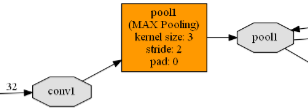

池层

layer { name: "pool1"type: "Pooling"bottom: "conv1"top: "pool1"pooling_param {pool: MAXkernel_size: 3stride: 2}

}

类型池层。 bottom是conv1 top是pool1

mark

池层的参数: 取最大值的pool(或均值)

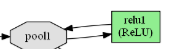

池层出来的结果过relu 激励函数。它的bottom和top是一个

mark

把数据过完relu之后又返回pool1.

定义第二个卷积层。relu层。池层。 卷积层。 全连接层

计算test上的准确率,计算loss值。使用的类型softmax

mark

caffe的官方网站上就介绍了这些data loss

数据layers 卷积层。可以看到input output

http://caffe.berkeleyvision.org/tutorial/

给你一个sample如何定义一个卷积。每个参数的意思。

Solver 定义你所使用的优化方式。

Loss 定义损失。

keras是怎样做的

keras比theano 或者TensorFlow写代码简洁很多。

中文文档:

https://keras-cn.readthedocs.io/en/latest/

上手keras。源代码工程中。

7-3 keras-master/examples/cifar10_cnn.py

引入一些我们工程需要的包

from __future__ import print_functionimport kerasfrom keras.datasets import cifar10from keras.preprocessing.image import ImageDataGeneratorfrom keras.models import Sequentialfrom keras.layers import Dense, Dropout, Activation, Flattenfrom keras.layers import Conv2D, MaxPooling2Dimport os

batch_size = 32num_classes = 10epochs = 100data_augmentation = Truenum_predictions = 20save_dir = os.path.join(os.getcwd(), 'saved_models') model_name = 'keras_cifar10_trained_model.h5'

定义网络训练所需要的超参数

# The data, split between train and test sets:(x_train, y_train), (x_test, y_test) = cifar10.load_data()

读取数据分为训练数据,测试数据。

model = Sequential()

model.add(Conv2D(32, (3, 3), padding='same',input_shape=x_train.shape[1:]))

model.add(Activation('relu'))

model.add(Conv2D(32, (3, 3)))

model.add(Activation('relu'))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Dropout(0.25))model.add(Conv2D(64, (3, 3), padding='same'))

model.add(Activation('relu'))

model.add(Conv2D(64, (3, 3)))

model.add(Activation('relu'))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Dropout(0.25))model.add(Flatten())

model.add(Dense(512))

model.add(Activation('relu'))

model.add(Dropout(0.5))

model.add(Dense(num_classes))

model.add(Activation('softmax'))

我们要把网络结构层加入到sequential中

官方文档中有激励函数的说明。Flatten展开成1维的。

过最后一个全连接层的时候,总共有10类。

keras是一个高层次的封装。简单的网络结构。

# initiate RMSprop optimizeropt = keras.optimizers.rmsprop(lr=0.0001, decay=1e-6)

告诉我们的模型使用的是什么损失函数

# Let's train the model using RMSpropmodel.compile(loss='categorical_crossentropy',optimizer=opt,metrics=['accuracy'])

模型训练fit,以前我们是训练多少轮,每轮里面有多少个batch

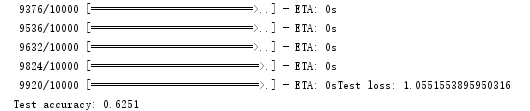

model.fit(x_train, y_train,batch_size=batch_size,epochs=epochs,validation_data=(x_test, y_test),shuffle=True)

注明验证数据集是什么。是否需要打乱。

keras是基于theano和TensorFlow之上的。

更改后端。厦门叉车价格是多少

keras代码简洁。caffe使用文件配置模型描述。

mark

课程总结

神经元 激励函数 神经网络 神经网络中的梯度下降 前向传播 反向更新

随机梯度下降 简单版本神经网络

提高神经网络的学习效率: 并行计算 梯度消失问题 归一化

参数初始化 正则化 学习率 Dropout 交叉熵

简单版本的前馈神经网络 增加代码提高学习效率

卷积神经网络 全连接神经网络对比 卷积核 卷积层(参数)

池化层(池化层参数) 典型的卷积神经网络 如何使用卷积神经网络做图片识别

softmax层 theano实现卷积神经网络

TensorFlow框架 线性回归 TensorBoard

手写数字识别 图片分类(cnn) 单gpu 多gpu

其他两个框架与TensorFlow对比。caffe keras

神经网络的算法和原理有初步的了解。

rnn神经网络原理 与 应用 游戏ai

卷积神经网络做图像风格变化。 人脸识别。

转载于:https://www.cnblogs.com/xyou/p/9353118.html

深度学习之神经网络核心原理与算法-caffekeras框架图片分类相关推荐

- 前馈神经网络——深度学习之神经网络核心原理与算法

五月两场 | NVIDIA DLI 深度学习入门课程 5月19日/5月26日一天密集式学习 快速带你入门阅读全文> 正文共7165个字,85张图,预计阅读时间35分钟. 因上几次读者反映,公式 ...

- 11- 深度学习之神经网络核心原理与算法-卷积核典型的CNN网络

典型的CNN网络 VGG16 mark 卷积核,池化层,卷积网络使用的激励函数. 目前市面上比较新的网络,由于计算能力的提升变得越来越复杂. 不再出现典型的纯粹的全连接网络,卷积网络的独有特点,而是把 ...

- 15- 深度学习之神经网络核心原理与算法-多gpu实现CNN图片分类

使用TensorFlow中的卷积神经网络CNN对于图片进行分类. 简介 CIFAR-10 每张图片: (32,32) 六万张 mark 十种分类 训练集: 五万张 测试集: 一万张 汽车 手机 鸟 猫 ...

- 零基础入门深度学习(3) - 神经网络和反向传播算法

无论即将到来的是大数据时代还是人工智能时代,亦或是传统行业使用人工智能在云上处理大数据的时代,作为一个有理想有追求的程序员,不懂深度学习(Deep Learning)这个超热的技术,会不会感觉马上就o ...

- 深度学习(4) - 神经网络和反向传播算法

神经元 神经元和感知器本质上是一样的,只不过我们说感知器的时候,它的激活函数是阶跃函数:而当我们说神经元时,激活函数往往选择为sigmoid函数或tanh函数.如下图所示: 计算一个神经元的输出的方法 ...

- 【深度学习】(5) 简单网络,案例:服装图片分类,附python完整代码

1. 数据获取 使用系统内部的服装数据集构建神经网络.首先导入需要的库文件,x和y中保存训练集的图像和目标.x_test和y_test中保存测试集需要的图像和目标.(x, y)及(x_test, y_ ...

- 深度学习总结:DQN原理,算法及pytorch方式实现

文章目录 Q-learning原理图 Q-learning算法描述: pytorch实现: Q-network实现: DQN实现: 2个Q-network,其中一个为target Q-network: ...

- 基于react-redux深度学习智能神经网络匹配飞行航线算法系统,让包机变得更加高效与智能

高定出行成潮流,搭乘私人飞机没有你想象得那么贵! 坐飞机已经成为一种令人习以为常的出行方式,但是其实除了乘坐各大航空公司提供的飞行服务外,有条件的朋友们还可以尝试 -- 私人包机. 在旅游出行上,乘坐 ...

- 01.神经网络和深度学习 W2.神经网络基础(作业:逻辑回归 图片识别)

文章目录 编程题 1 1. numpy 基本函数 1.1 编写 sigmoid 函数 1.2 编写 sigmoid 函数的导数 1.3 reshape操作 1.4 标准化 1.5 广播机制 2. 向量 ...

最新文章

- Repeater 嵌套 Repeater

- ReentrantLock锁

- C03-Java同步实践加强班第5周上机任务

- 函数的返回值可以不用赋值_C语言学习|函数的应用《一》

- 2020年生活服务业新业态和新职业从业报告

- Java SQL解析引擎简介

- 美国纽约拟将电话亭变WiFi热点

- 浅析 Go IO 的知识框架

- modbus地址扫描_西门子PLC通信编程MODBUS通信举例

- VC运行库修复安装一键安装

- 文献笔记(9)(2019ISSCC)

- micropython esp8266 红外控制小车

- 新税码不显示或者税码被人隐藏,发票校验不显示

- 眼见不为“实”,人们更信任人工智能合成的假脸

- Android 11.0 任务栏中清除掉播放器的进程,状态栏仍有音乐播放器状态问题的解决

- 小学五年级上册计算机教案新疆,新疆青少年出版社 陕西人民教育出版社 信息技术五年级上册教案...

- 冰点服务器内的客户端显示脱机,冰点还原精灵DeepFreeze企业版控制台中不显示客户端...

- 防止浏览器窗口太小,设置最小宽度

- vue中生成条形码,以及条形码的所有参数

- 埃隆马斯克:每周工作100小时才能赶超别人

热门文章

- java8的stream特性_Java8新特性介绍:Stream API

- web服务器php配置实例,配置 Web 服务器提供 PHP 服务

- Java集合之一—HashMap

- html设计有项目的页面,HTML+CSS项目开发经验总结(推荐)

- 计算机培训营,计算机学院举办科创训练营第三期培训

- 倒计时_考研倒计时30天,拼了

- 华为笔记本没有网线口_3599元起,华为台式机MateStation B515上架:R5 4600G

- python操作库_python操作数据库

- 玩游戏学python的网站_娱教于乐!四大游戏类编程网站,学Python再也不枯燥无味了...

- java 爬虫_Java爬虫可以非常溜