《深度学习导论及案例分析》一2.5概率有向图模型

####本节书摘来自华章出版社《深度学习导论及案例分析》一书中的第2章,第2.5节,作者李玉鑑 张婷,更多章节内容可以访问云栖社区“华章计算机”公众号查看。

2.5概率有向图模型

如果一组随机变量中存在因果关系,那么常常可以建立一个概率有向图模型来紧凑、自然地表达它们的联合概率分布。概率有向图模型又称为贝叶斯网络(Bayesian network)、贝叶斯模型(Bayesian model)、信念网络(belief network),是一种通过有向无圈图来表示随机变量及其条件依赖关系的概率图模型。

贝叶斯网络B是一个以随机变量为顶点,以边为条件依赖关系的有向无圈图G=(V,E),其联合概率分布可以进行如下因子分解:

PB(X1,…,XN)=∏Ni=1P(XiPaG(Xi))(2.55)

其中单个因子P(XiPaG=(Xi))称为条件概率分布(conditional probability distribution,CPD)或局部概率模型。这个因子分解的表达式也称为贝叶斯网的链式法则。例如,根据该法则,图2.1所示的贝叶斯网络的联合概率分布可以分解如下:

PB(X1,…,X7)=∏7i=1P(XiPaG(Xi))=P(X1)P(X2X1)P(X3X2)P(X4X3)P(X5)P(X6X2,X5)P(X7X6)(2.56)

可以证明,贝叶斯网络的联合概率分布满足局部条件独立性(local conditional independencies)[104]。也就是说,一个贝叶斯网络的任意节点X与其所有非后代节点都条件独立于其父节点集,即

X⊥NonDescG(X)PaG(X)(2.57)

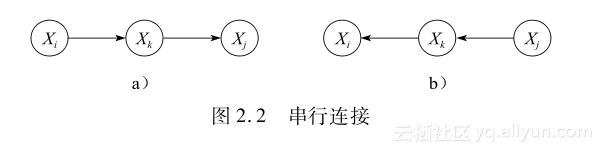

在一个贝叶斯网络中,任意一条由三个变量构成的迹XiXkXj,可能存在下面三种连接方式:

1)串行连接(serial connection)或链(chain),如图2.2所示。根据公式(2.55),图2.2a相应的联合分布为

PB(Xi,Xk,Xj)=P(Xi)P(XkXi)P(XjXk)(2.58)

因此,在给定Xk的条件下,Xi和Xj的联合概率为

PB(Xi,XjXk)=P(Xi)P(XkXi)P(Xi,Xk)P(XjXk)P(Xk)=P(XiXk)P(XjXk)(2.59)

这说明,在串行连接的情况下,Xi⊥XjXk。

注意,图2.2b为串行连接的另一种情况,有关推导是类似的。图2.2a的串行连接又称为Xi到Xj的因果路径,图2.2b的串行连接则又称为Xi到Xj的证据路径。

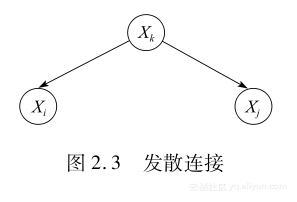

2)发散连接(diverging connection)或叉口(fork),表示Xi和Xj有共同的原因,如图2.3所示。根据公式(2.55),相应的联合分布为

PB(Xi,Xk,Xj)=P(Xk)P(XiXk)P(XjXk)(2.60)

因此,在给定Xk的条件下,Xi和Xj的联合概率为

PB(Xi,XjXk)=P(Xi,Xj,Xk)P(Xk)=P(XiXk)P(XjXk)(2.61)

这说明,在发散连接的情况下,Xi⊥XjXk。

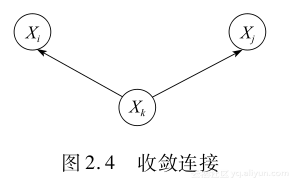

3)收敛连接(converging connection),又称倒叉口(inverted fork)、碰撞(collider)、v结构(vstructure),表示Xi和Xj有共同的效果,如图2.4所示。根据公式(2.55),相应的联合分布为

PB(Xi,Xk,Xj)=P(Xi)P(Xj)P(XkXi,Xj)(2.62)

∑xk∈val(Xk)P(Xk=xkXi,Xj)=1(2.63)

PB(Xi,Xj)=P(Xi)P(Xj)(2.64)

因此,变量Xi和Xj是先验独立的,即Xi⊥Xj。

但是,在给定Xk或其后代的条件下,Xi和Xj并不一定独立,也就是说可能有

PB(Xi,XjXk)≠P(XiXk)P(XjXk)(2.65)

这说明,在收敛连接的情况下,未必Xi⊥XjXk。

根据上述分析,在串行连接Xi→Xk→Xj和Xi←Xk←Xj以及发散连接Xi←Xk→Xj中,只有未观察到中心变量Xk时,Xi和Xj之间才可能产生有效的相互影响,否则它们就是相互独立的。而在收敛连接Xi→Xk←Xj中,只有观察到中心变量Xk时,Xi和Xj之间才可能产生有效的相互影响,否则它们就是相互独立的。在一个贝叶斯网络中,如果两个随机变量X和Y可能通过一条迹产生有效的相互影响,X和Y就不会是相互独立的,这条迹则称为有效迹。

在给定观测变量集Z的条件下,贝叶斯网络B的一条迹X1…Xn称为有效迹,如果对其中任意的收敛连接Xi-1→Xi←Xi+1都有Xi∈Z或DescB(Xi)∩Z≠,且该迹上的其他节点都不在Z中。

如果X、Y、Z是贝叶斯网络B的三个互不相交的节点子集,且在给定Z的条件下,对任意节点X∈X和Y∈Y之间都不存在有效迹,那么称X和Y在给定Z时是d分离(dseparation)的,或被Z d分离[105]。其中Z称为分离子集。d分离定理为:如果X与Y被Z d分离,那么在给定Z的条件下,X和Y一定是相互独立的[105]。这种条件独立性X⊥YZ称为贝叶斯网络的全局马尔可夫独立性(global Markov independencies)。

在图2.1中,如果令X={X1,X2},Y={X3,X4,X7},Z={X2,X6},那么可以验证X和Y被Z d分离。显然,在给定Z时,X和Y是相互独立的,即X⊥YZ。

此外,如果利用v结构的贝叶斯网来表达因果模型,有时可能出现解释消除(explaining away)现象。解释消除是指本来相互独立的多个原因在给定观察结果时,可能不再相互独立,而是变得相互依赖、相互影响,甚至一种原因的出现几乎可以排除另一种原因出现的可能。例如,一座高楼倒塌可能有两种本来相互独立的原因:自然地震或恐怖袭击。可是,在看到9•11美国世贸大厦被飞机撞击倒塌的视频之后,恐怖袭击便成为美国世贸大厦倒塌的直接解释,而这种解释几乎完全排除了自然地震作为解释的可能性。解释消除只是因果间推理(intercausal reasoning)的一个特例,而因果间推理在人类的推理中是非常普遍的模型。

下面通过一个具体例子说明解释消除现象。如图2.5所示,

用一个v结构的贝叶斯网络表示电池和燃料情况对油表的影响。这个贝叶斯网络由三个二值节点构成,分别是电池节点B(battery)、燃料节点F(fuel)、油表节点G(gauge)。B代表电池是否有电,B=1表示有电,B=0表示没电。F表示燃料(汽油)的情况,F=1表示油箱是满的,F=0表示油箱是空的。G表示油表的指示情况,G=1表示油表刻度指示油箱是满的,G=0表示油表刻度指示油箱为空。

假设已经知道了这个模型的有关概率为:p(B=1)=0.9,p(F=1)=0.9,p(G=1B=1,F=1)=0.8,p(G=1B=1,F=0)=0.2,p(G=1B=0,F=1)=0.2,p(G=1B=0,F=0)=0.1。

根据油表贝叶斯网络的结构,有:

p(B,F,G)=p(B)p(F)p(GB,F)(2.66)

于是,可以计算在观测到油表指示油箱为空的情况下,油箱确实空着的概率如下:

p(F=0G=0)=p(G=0F=0)p(F=0)p(G=0)(2.67)

其中,

p(G=0)=∑B∈{0,1}∑F∈{0,1}p(G=0B,F)p(B)p(F)(2.68)p(G=0F=0)=∑B∈{0,1}p(G=0B,F=0)p(B)(2.69)

因此,

p(F=0G=0)=p(G=0F=0)p(F=0)p(G=0)0.257(2.70)p(F=0G=0)=0.257>p(F=0)=0.1(2.71)

从以上结果可知,在观测到油表指示为空的情况下,油箱真为空的概率会比没有任何观测的情况大很多,这符合油表的常理作用。如果进一步考虑更复杂的情况,计算在同时观测到油表指示为空和油表的电池没电的情况下,油箱真为空的概率,那么不难通过公式推导得到:

p(F=0G=0,B=0)=p(G=0B=0,F=0)p(F=0)∑F∈{0,1}p(G=0B=0,F)0.111(2.72)

综合公式(2.43)和公式(2.44)这两种情况,可以得到如下不等式:

p(F=0)=0.1<p(F=0G=0,B=0)=0.111<p(F=0G=0)=0.257(2.73

)```

《深度学习导论及案例分析》一2.5概率有向图模型相关推荐

- 《深度学习导论及案例分析》一2.11概率图模型的推理

本节书摘来自华章出版社<深度学习导论及案例分析>一书中的第2章,第2.11节,作者李玉鑑 张婷,更多章节内容可以访问云栖社区"华章计算机"公众号查看. 2.11概率图模 ...

- 免费教材丨第56期:《深度学习导论及案例分析》、《谷歌黑板报-数学之美》

小编说 离春节更近了! 本期教材 本期为大家发放的教材为:<深度学习导论及案例分析>.<谷歌黑板报-数学之美>两本书,大家可以根据自己的需要阅读哦! < ...

- 《深度学习导论及案例分析》一导读

PREFACE 前言 "深度学习"一词大家已经不陌生了,随着在不同领域取得了超越其他方法的成功,深度学习在学术界和工业界掀起了一次神经网络发展史上的新浪潮.运用深度学习解决实际问题 ...

- 深度学习之LSTM案例分析(三)

#背景 来自GitHub上<tensorflow_cookbook>[https://github.com/nfmcclure/tensorflow_cookbook/tree/maste ...

- 深度学习在工业推荐如何work?Netflix这篇论文「深度学习推荐系统Netflix案例分析」阐述DL在RS的优劣与经验教训...

来源:专知 深度学习在推荐系统中如何发挥作用是一个重要的问题.最近来自Netflix的文章详细阐述了这一点指出:在建模用户物品交互方面,深度学习相比传统基线方法并无太大优势,而对于异质特征的表示融入深 ...

- 深度学习之LSTM案例分析(二)

#背景 来自GitHub上<tensorflow_cookbook>[https://github.com/nfmcclure/tensorflow_cookbook/tree/maste ...

- 深度学习导论(2)深度学习案例:回归问题

深度学习导论(2)深度学习案例:回归问题 问题分析 优化方法 代码 采样数据 计算误差 计算梯度 梯度更新 main函数 结果输出 这篇文章将介绍深度学习的小案例:回归问题的问题分析.优化以及实现代码 ...

- 深度学习导论(4)神经网络基础

深度学习导论(4)神经网络基础 一. 训练深度学习模型的步骤 二. 线性层(或叫全链接层)(Linear layer(dense or fully connected layers)) 1. 定义一个 ...

- 深度学习导论(3)PyTorch基础

深度学习导论(3)PyTorch基础 一. Tensor-Pytorch基础数据结构 二. Tensor索引及操作 1. Tensor索引类型 2. Tensor基础操作 3. 数值类型 4. 数值类 ...

- MIT 深度学习导论来啦!附视频下载

点击我爱计算机视觉标星,更快获取CVML新技术 相信很多同学读过MIT的<算法导论>(Introduction to Algorithms)这本书,虽称"导论",但其内 ...

最新文章

- LinearLayout (线性布局)的分析

- 一文告诉你,为什么要研究JVM原理

- 机器人组团到城市打工,第一站果然是赛博朋克城

- 201602021344_《Javascript柯里化uncurrying()(将内置方法独立成为一个通用方法)》

- 区块链BaaS云服务(17)纸贵科技DID分布式身份标识

- 为什么计算机的编码那么多,为什么中国剩余定理可用于计算机编码?

- flink的datastream中的closewith与反馈环(feed stream)的意思

- js将canvas保存成图片并下载

- java 的转义字符,在正则表达式中应用

- Oracle笔记 五、创建表、约束、视图、索引、序列、同义词、表空间

- Java开发中遇到具有挑战的事_170道Java工程师面试题,你敢挑战吗?

- php对象、面向对象

- 二十年后我发明了保姆机器人作文_【赏学堂】苹果五级作文班优秀作品赏析——温睿哲二十年后回故乡...

- 开启 TLS 1.3 加密协议,极速 HTTPS 体验

- jsp html在线编辑器,JSP实用教程之简易页面编辑器的实现方法(附源码)

- 编译原理第三章词法分析知识点思维导图版

- ubuntu记录pdf手写笔记: 数位板(硬件)+xournal(软件)

- ImageAI 学习

- Excel怎么合并单元格

- 空间命名的定义及使用:using namespace std 的用法详解