前向传播和反向传播(举例说明)

假设神经网络结构如下图所示:有2个输入单元;隐含层为2个神经元;输出层也是2个神经元,隐含层和输出层各有1个偏置。

为了直观,这里初始化权重和偏置量,得到如下效果:

----前向传播----

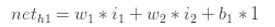

隐含层神经元h1的输入:

代入数据可得:

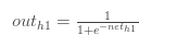

假设激励函数用logistic函数,计算得隐含层神经元h1的输出:

同样的方法,可以得到隐含层神经元h2的输出为:

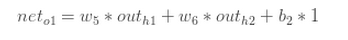

对输出层神经元重复这个过程,使用隐藏层神经元的输出作为输入。这样输出层神经元O1的输出为:

代入数据:

输出层神经元O1的输出:

同样的方法,可以得到输出层神经元O2的输出为:

----统计误差----

假如误差公式为:

如上图,O1的原始输出为0.01,而神经网络的输出为0.75136507,则其误差为:

同理可得,O2的误差为:

这样,总的误差为:

----反向传播----

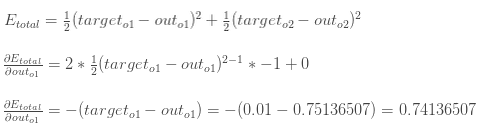

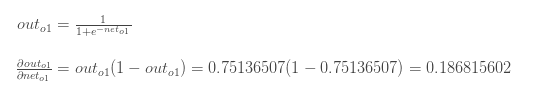

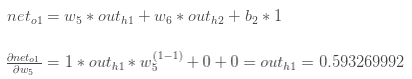

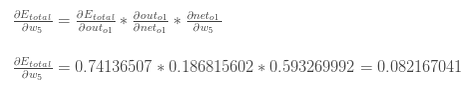

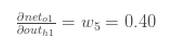

对于w5,想知道其改变对总误差有多少影响,得求偏导:

根据链式法则:

在这个过程中,需要弄清楚每一个部分。

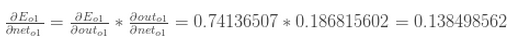

首先:

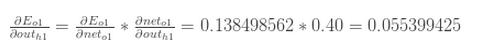

其次:

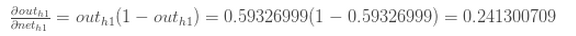

最后:

把以上三部分相乘,得到:

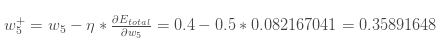

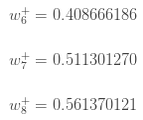

根据梯度下降原理,从当前的权重减去这个值(假设学习率为0.5),得:

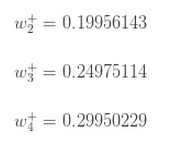

同理,可以得到:

这样,输出层的所以权值就都更新了(先不管偏置),接下来看隐含层:

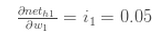

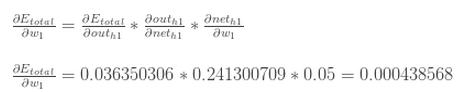

对w1求偏导:

用图表来描述上述链式法则求导的路径:

接下来,又是一部分一部分的计算:

>>>>>>>> 1

上式中,第一部分前边已经计算过了:

第二部分中,因为:

所以:

两部分相乘,得:

>>>>>>>> 2

>>>>>>>> 3

>>>>>>>> 4

这样对W1的偏导就出来了:

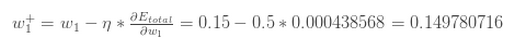

更新权值:

同理得到:

最后,更新了所有的权重! 当最初前馈传播时输入为0.05和0.1,网络上的误差是0.298371109。 在第一轮反向传播之后,总误差现在下降到0.291027924。 它可能看起来不太多,但是在重复此过程10,000次之后。例如,错误倾斜到0.000035085。

在这一点上,当前馈输入为0.05和0.1时,两个输出神经元产生0.015912196(相对于目标为0.01)和0.984065734(相对于目标为0.99)。

前向传播和反向传播(举例说明)相关推荐

- 3.3 前向传播与反向传播-机器学习笔记-斯坦福吴恩达教授

前向传播与反向传播 前向传播过程(Forward Propagation) 神经网络每层都包含有若干神经元,层间的神经元通过权值矩阵 ΘlΘ^lΘl 连接.一次信息传递过程可以如下描述: 第 j 层神 ...

- 003-神经网络基础-最优化,前向传播,反向传播

最优化: 包括前向传播和反向传播 前向传播: 由w和x到损失函数loss的过程叫做前向传播 反向传播: 根据梯度下降的概念,找到最优的w的过程叫做反向传播. 做一件什么事情呢? 根据前向传播的w得到的 ...

- 花书+吴恩达深度学习(十三)卷积神经网络 CNN 之运算过程(前向传播、反向传播)

目录 0. 前言 1. 单层卷积网络 2. 各参数维度 3. CNN 前向传播反向传播 如果这篇文章对你有一点小小的帮助,请给个关注,点个赞喔~我会非常开心的~ 花书+吴恩达深度学习(十)卷积神经网络 ...

- 深度学习基础笔记——前向传播与反向传播

相关申明及相关参考: 体系学习地址 主要学习笔记地址 由于是文章阅读整合,依据个人情况标注排版, 不确定算不算转载,主要学习围绕AI浩的五万字总结,深度学习基础 如有侵权,请联系删除. 1前向传播与反 ...

- 神经网络的前向传播与反向传播

神经网络的前向传播和反向传播 相信一开始,大家可能都对神经网络的前向传播和反向传播很头疼,我之前也是一样,后来慢慢懂了,现在深感知识传递的重要性.因此现在我就把我的一点点对两者的理解表达一下,希望能帮 ...

- 神经网络理解:前向传播与反向传播

文章目录 参考资料 神经网络 前向传播 1. 输入层->隐含层 2. 隐含层->输出层 反向传播 1. 计算总误差 2. 隐藏层与输出层之间的权重更新 3. 输入层与隐藏层之间的权重更新 ...

- 对于CNN卷积神经网络的前向传播和反向传播的理解

对于CNN卷积神经网络的前向传播和反向传播的理解 前向传播示意图: 咋一看这张图,作为初学者可能会不知所云( ̄ω ̄=)?但是想要很好的理解前向传播的原理,我们得从这张图细说. 文章目录 对于CNN ...

- (二十四) 手推BP神经网络的前向传播和反向传播

手推BP神经网络的前向传播和反向传播 一.基本术语 1.监督学习与非监督学习 Supervised Learning有监督式学习: 输入的数据被称为训练数据,一个模型需要通过一个训练过程,在这个过程中 ...

- 神经网络前向传播和反向传播公式推导(公式+图解)

以如下的预测是否是猫的双层神经网络为例进行公式推导: 符号注解: n_x : 输入特征的数量 n_h : 隐藏层的节点数量 n_y : 输出层的节点数量 m : 样本数量 W :权重矩阵 b :偏置 ...

- 前向传播、反向传播(后向传播)、梯度下降、导数、链式法则

日萌社 人工智能AI:Keras PyTorch MXNet TensorFlow PaddlePaddle 深度学习实战(不定时更新) 2.4 神经网络最优化过程 2.4.1 最优化(Optimiz ...

最新文章

- Column 'Column Name' does not belong to table Table

- MVC系列——一个异常消息传递引发的思考

- kafka删除队列_没想到 Kafka 还会这样问,学会这些带你轻松搞定大厂面试!

- endnote 参考文献加序号_Endnote教程|页码缩写

- u-boot与bootloader及其区别

- python grid函数_(转)Python Tkinter Grid布局管理器详解

- Intellij插件之JRebel

- 【设计模式】第五章 责任链模式

- Realme XT发布会PPT曝光:后置6400万四摄+骁龙712

- 网恋奔现发现对方长得很好看是什么样的体验?

- 【Javascript Demo】图片瀑布流实现

- 记一次centos 7.3下的steam安装(该“STEAM”软件为美国valve开发的游戏平台)

- vcm驱动芯片原理_手机摄像头VCM音圈马达,原理、结构

- centos 7.6安装WeADMIN ITOSS步骤

- matlab教程黄金分割,Matlab程序设计在黄金分割法教学中的应用

- python进阶day13

- 基于Web的电子商务解决方案(1)(转)

- 实验c语言程序数据类型,C语言编程实验.doc

- java 面向对象编程之二

- css compressor java_javascript/css压缩工具---yuicompressor使用方法

热门文章

- 半年TeamLeader总结

- 原生js html insert,原生js添加节点appendChild、insertBefore

- 西普CTF-最低位的亲吻

- Java,张丘建《算经》中提出“百鸡问题”:鸡翁一值钱五,鸡母一值钱三,鸡雏三值钱一。百钱买百鸡,问鸡翁、母、雏各几何?

- hyperf redis哨兵连接池 读写分离

- jQuery checkbox 选中事件小案例.

- Escript氨基酸对比图怎么看_太神奇!看完了这8张NBA对比图发现,真的可以有一模一样的动作...

- 最个性创意的圣诞礼物 忆恋拼图

- CSS计算 CSS运算 calc函数的使用方法

- Python-opencv 实现图片的镜像翻转