word2vec -- 负采样 -- skip-gram

我以前写过一篇关于word2vec的文章,说实话,写的一坨,我决定以后写博客认认真真的去写。

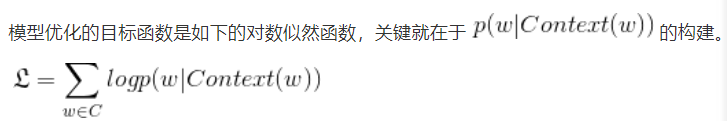

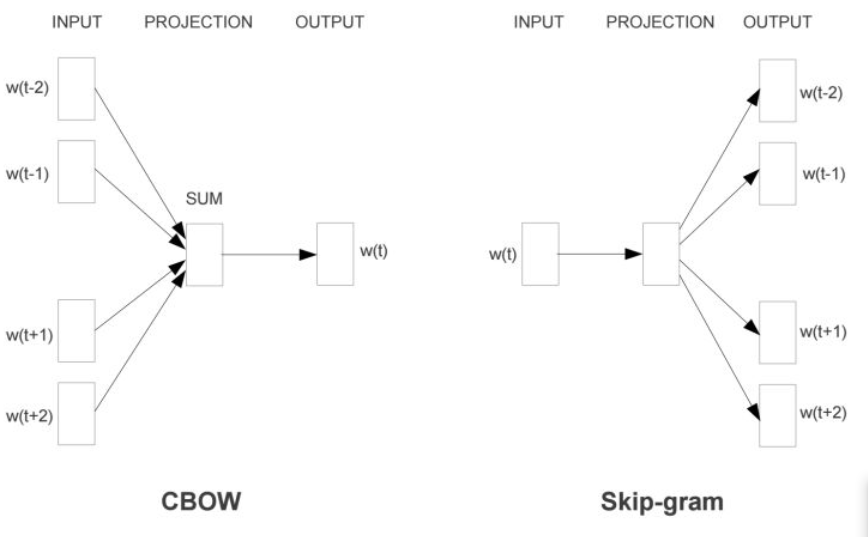

我的博客来自于网上各位前辈的资料的整理,这位这位和这位翻译的让我对word2vec有了深入的理解。word2vec有两种模型,一个是skip-gram,一个是cbow。这两个模型应该是在一起讲的。cbow是输入词向量求平均,二skip-gram输入只有一个,不要求平均。首先说一点,cbow和skip-gram的目标函数,下图是cbow的,skip-gram反过来而已

词向量基础

词向量很早以前就有了。最早的词向量成为one-hot representation,它使用的词向量维度大小为整个词汇表的大小,对于词汇表中每个具体的词,对应位置置为1,其余位置为0。例如,我们得到一个为2000大小的词汇表,“dog”的词序为3,那么它的词向量表示为(0,0,1,0,...,0)。是不是感觉这样很蠢,只是将改词所在的位置表示出来,而其余位置都没有啥意义,占用存储空间。如果上千万大小的词汇表,一个词就需要上千万的位置,将会导致维度灾难。

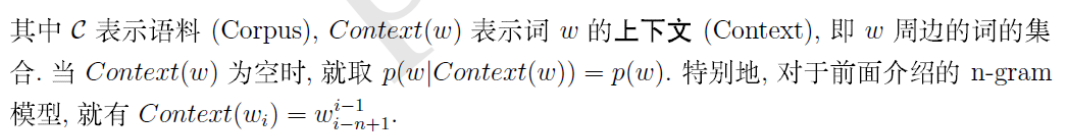

于是,人们搞出一个Distributed representation,它的思路是通过训练,将每个词都映射到一个较短的词向量上,所有的词向量就构成了向量空间,进而可以用统计学的方法研究词和词之间的关系。比如谷歌用google news训练的词向量,维度为300,一般维度自己指定。

上图仅仅展示了一个词汇表中词向量的一部分,可以看出“Man”这个词和“Woman”这个词在“Gender”所占的比重还是很大的,在其他属性占的比重小。当然实际上,我们并不能对词向量的每一个维度做很好的解释。

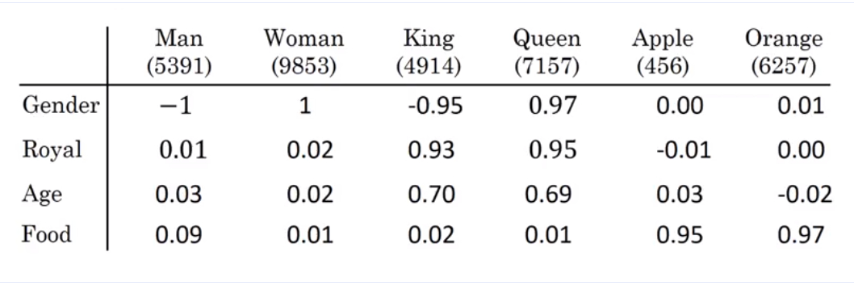

使用t-SNE算法对词向量进行非线性降维,可得到下面映射结果:

可以看到同一类的词,基本上聚集在了一起。例如,给定对应关系“man”对“woman”,要求机器类比出“King”对应的词汇,可发现词向量存在数学关系“Man - Woman = King - Queen”

第一部分

模型

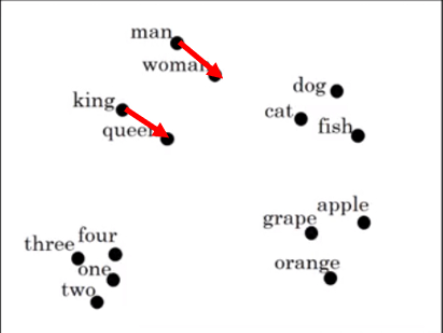

在word2vec模型中,主要有Skip-Gram和CBOW两种模型。CBOW是给定上下文,来预测input word,而Skip-Gram是给定input word来预测上下文。

我暂时文章没怎么看懂,就看懂了最后一篇翻译的,所以暂时只写skip-gram。

Skip-Gram实际上分为了两个部分,第一部分为建立模型,第二部分为通过模型获取嵌入词向量。word2vec的整个建模过程实际上与自编码器(auto-encoder)相似,即先基于训练数据构建一个神经网络,当这个模型训练号以后,我们并不会用这个训练好的模型处理新的任务,我们需要的是这个模型通过训练所学到的参数,如隐层的权值矩阵-----这些权重在word2vec中实际上就是我们试图学习的“word vectors(词向量)”。基于训练数据建模的过程,我们给它取一个名字叫“Fake Task”,意味着建模不是最终目的。

上面提到的这种方法实际上会在无监督特征学习(unsupervised feature learning)中见到,最常见的是自编码器(auto-enconder):通过在隐层将输入进行编码压缩,继而在输出层将数据解码回复到初始状态,训练完成后,我们将会去掉输出层,只保留隐层。(ps:让我想起了生成对抗网络)

The Fake Task

“fake task”就是构建网络,但只要训练数据得到的隐层。它的完整过程如下:

假如我们有一个句子“The fox jumps over the lazy dog”。

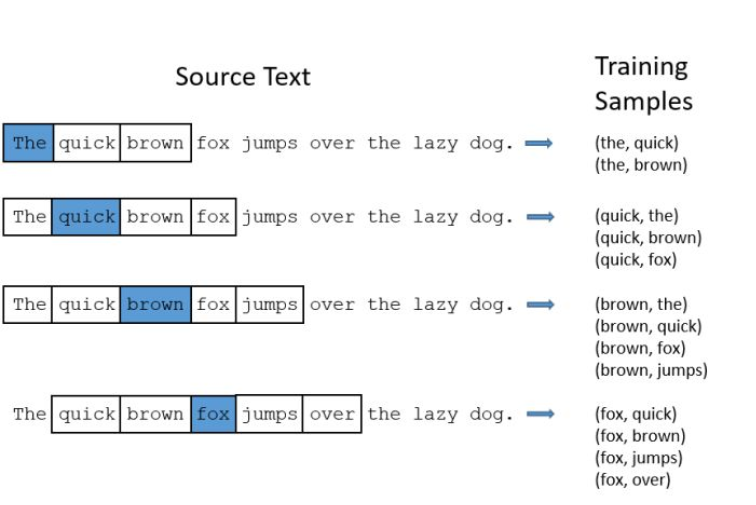

- 首先我们选取句子中的一个词作为输入词(实际训练过程中,是依次将句子中的每个词作为输入词构建训练对的),例如选取“fox”作为input word;

- 有了input word后,我们再定义一个叫skip_window的参数,它代表我们从当前input word的一侧选取词的数量。如果设置skip_window = 2,那么我们最终获得窗口中的词(包括input word在内)就是['The', 'fox', 'jumps', 'over']。那么整个窗口大小span =

= 4。另外一个参数叫num_skips,它代表我们选取多少个不同的词作为我们的output word,当skip_window = 2,num_skips = 2时,我们将会得到两组(input word,output word)形式的训练数据,即('fox', 'jumps'),('fox', 'the')

- 神经网络基于这些训练数据将会输出一个概率分布,这个概率代表着我们词典中的每个词是output word的可能性。例如,上面我们得到两组数据。我们先用一组数据('fox', 'jumps')来训练神经网络,那么模型通过前面学习这个训练样本,会告诉我们词汇表中其他单词的概率大小和“jumps”的概率大小。

模型的输出概率代表着我们的词典中每个词有多大可能跟input word同时出现。例如,我们向神经网络模型中输入一个单词“Soviet”,那么最终模型的输出概率中,像“Union”,“Russia”这些相关词的概率远远高于“dog”,“love”这些非相关词的概率。

我们将通过给神经网络输入文本中成对的单词来训练它完成上面所说的概率计算。下面的图给出了一个完整的例子。我们选定句子“The quick brown fox jumps over lazy dog”,设定窗口大小为2(skip_window = 2)。下图中,蓝色代表input_word,方框内代表位于窗口内的单词。

模型细节

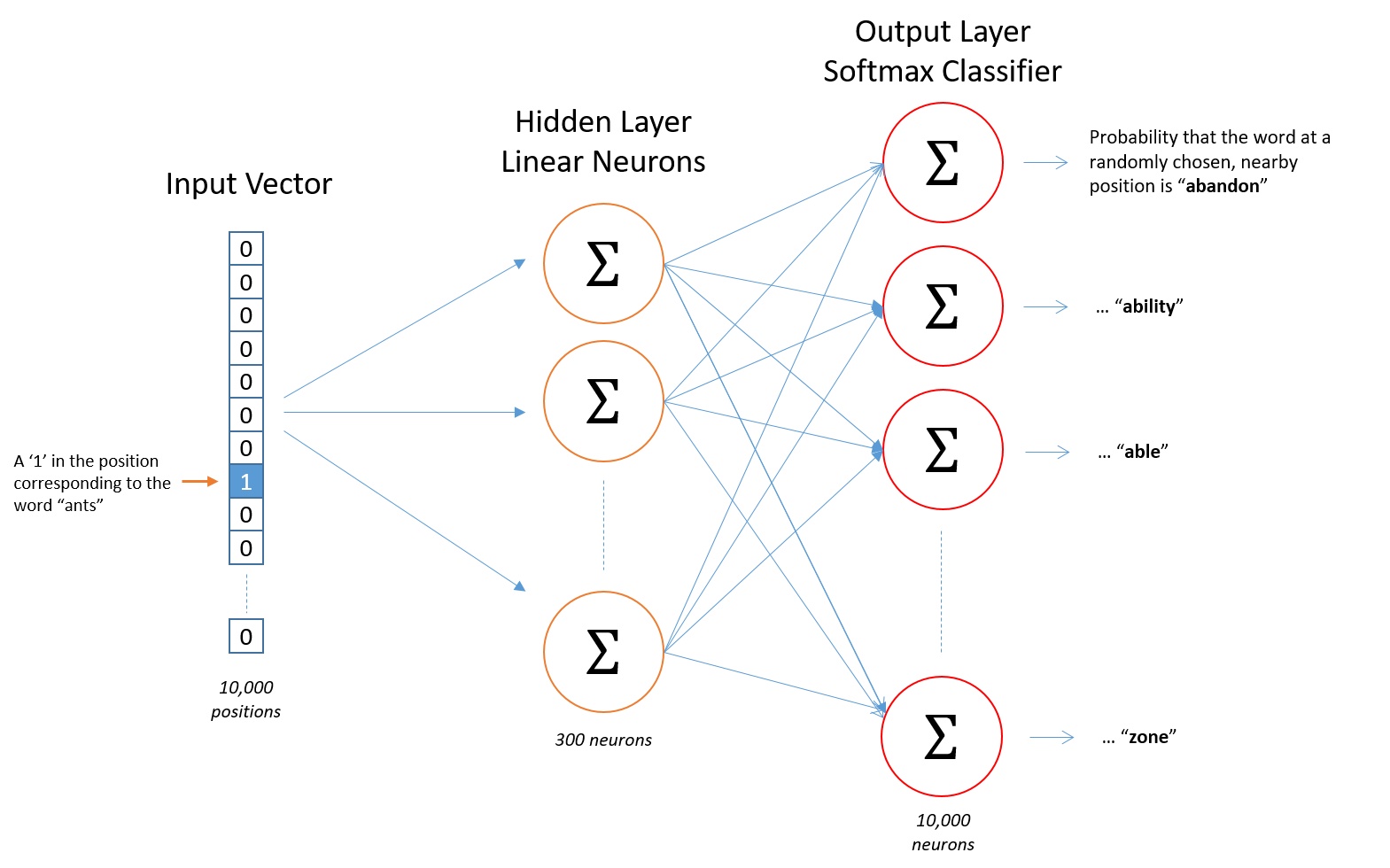

首先,神经网络只能接受数值输入,所以我们必须将单词进行one-hot编码,上面我们介绍的词向量发挥作用了。假设我们在训练数据中只能取出10000个不重复的单词作为词汇表,那么我们对每个单词编码都是的向量。在上面的例子中,如果“** The dog barked at the mailman**”,按照简单的情况,每个单词在词汇表的位置为1,2,3,4,5,6,那么这6个单词将会被编码成

维度的向量,为了表示方便,我只写出前2个

模型的输入是10000为的向量,那么输出也是10000维(词汇表的大小)向量,它包含了10000个概率,每一个概率代表着当前词是输入样本中output word的概率大小。如下图,神经网络架构:

隐层不使用任何激活函数,但是输出层用来softmax

第二部分

上面结尾我们说输出层用softmax,但是要知道,如果真的用softmax来算,计算量大的惊人。所以可以用这三个方法来减少计算量:

- 将常见的单词组合(word pairs)或者词组作为单个“words”来使用。

- 对高频词进行抽样来减少训练样本的个数

- 最后最重要的一点,就是“nagative sampling”方法,这样每个训练样本只会更新一小部分模型权重,从而降低计算负担。

其他的我不想讲,原作者博客中有,我想讲讲nagative sampling(负采样)。不同于原本每个训练样本更新所有的权重,负采样每次让一个训练样本仅仅更新一部分的权重,这样就好降低梯度下降过程中的计算量。

当我们用训练样本(input word:"fox", output word:"quick")来训练我们的神经网络时,“fox”和“quick”都是经过one-hot编码的。如果我们的vocabulary大小为10000时,在输出层,我们希望“quick”单词那个位置输出1,其余都是0。这些其余我们期望输出0的位置所对应的单词我们成为“negative” word。

当使用负采样时,我们将随机选择一小部分的negative words(比如选5个negative words)来更新对应的权重。我们也会对我们的positive word进行权重更新(上面的例子指的是"quick")。

- 在论文中,作者指出指出对于小规模数据集,选择5-20个negative words会比较好,对于大规模数据集可以仅选择2-5个negative words。

回忆一下我们的隐层-输出层拥有300 x 10000的权重矩阵。如果使用了负采样的方法我们仅仅去更新我们的positive word-“quick”的和我们选择的其他5个negative words的结点对应的权重,共计6个输出神经元,相当于每次只更新300 6 = 1800个权重。对于3百万的权重来说,相当于只计算了0.06%的权重,这样计算效率就大幅度提高。

写到这里,其实还有很多东西没说明白。但这个主题说大了,我暂时先搁置着,等研究透了再来修改增加。

word2vec -- 负采样 -- skip-gram相关推荐

- 【NLP】word2vec负采样

一.理解负采样之前,需要先回顾一下word2vec的训练流程: 1.初始化一个embedding权重矩阵W1(N*D)→2.根据输入单词直接挑出W1矩阵中对应的行向量→3.相加并求平均得一个向量(1* ...

- NLP-词向量(Word Embedding)-2013:Word2vec模型(CBOW、Skip-Gram)【对NNLM的简化】【层次Softmax、负采样、重采样】【静态表示;无法解决一词多义】

一.文本的表示方法 (Representation) 文本是一种非结构化的数据信息,是不可以直接被计算的.因为文本不能够直接被模型计算,所以需要将其转化为向量. 文本表示的作用就是将这些非结构化的信息 ...

- 《自然语言处理学习之路》02 词向量模型Word2Vec,CBOW,Skip Gram

本文主要是学习参考莫烦老师的教学,对老师课程的学习,记忆笔记. 原文链接 文章目录 书山有路勤为径,学海无涯苦作舟. 零.吃水不忘挖井人 一.计算机如何实现对于词语的理解 1.1 万物数字化 1.2 ...

- python word2vec skipgram 负采样_word2vec中的负采样

word2vec中的负采样 发布时间:2018-08-23 10:11, 浏览次数:991 , 标签: word vec 1. Hierarchical Softmax的缺点与改进 在讲基于Negat ...

- word2vec中的负采样问题

在word2vec中最先使用的是softmax函数,由于softmax函数需要在分母上遍历每个单词,在归一化时计算成本高:而且在计算损失函数时,center word 与context word之间最 ...

- 深度学习 - 41.Word2vec、EGES 负采样实现 By Keras

目录 一.引言 二.实现思路 1.样本构建 2.Word2vec 架构 3.EGES 架构 4.基于 NEG 的 Word2vec 架构 三.Keras 实现 Word2vec 1.样本构建 2.模型 ...

- 背景区域为负样本什么意思_词向量-skipgram与负采样

大纲: 1. onehot vs 分布式表示 2. 分布式表示的全局泛化能力 3. how to learn word2vec - intuition 4. SkipGram 5. SkipGram ...

- NLP《词汇表示方法(四)负采样》

一:负采样 在CBOW和Skip-Gram模型中,最后输出的都是词汇的one-hot向量,假如我们的词汇表的数量是10000,嵌入空间的维度是300,再假设此时是以Skip-Gram模型只预测cont ...

- 自然语言处理 —— 2.7负采样

word2vec的一个缺点是softmax计算起来很慢,这一节中,你会看到一个改善过的学习问题叫做负采样.它能做到与你之前看到的skip-gram模型相似的事情,但是用了一个更加有效的学习算法.Iwa ...

最新文章

- Maven学习(一)——Maven入门

- linux信号使用,linux信号使用注意事项

- 数据库MYSQL学习系列一

- ObjectStateManager 中已存在具有同一键的对象。ObjectStateManager 无法跟踪具有相同键的多个对象...

- FragmentStack

- 《如何搭建小微企业风控模型》第七节 准入规则节选

- java导出word的几种方式

- 类的继承与派生的基础学习

- MUI框架-01-介绍-创建项目-简单页面

- C程序10 自由落体

- Windows server 2008 安装Hyper-V

- 微信小程序页面跳转失效原因

- 了解软件工程与计算机科学的联系与区别

- html 下拉图片列表,图片、表单、下拉选项

- unity3d中如何将Hierarchy中的物体批量拖到Inspector中的数组中?

- p2p命令行方式连线其他陪测设备(Ubuntu+其他设备(PC,手机))

- Capture ORCAD CIS导出原理库OLB文件

- OSChina 周日乱弹 —— 不要让父亲带小孩

- AutoLeaders控制组——邓斐熙

- XP系统70个小技巧