数据库(DataBase)

MySQL

简介

数据库

数据库:DataBase,简称 DB,存储和管理数据的仓库

数据库的优势:

- 可以持久化存储数据

- 方便存储和管理数据

- 使用了统一的方式操作数据库 SQL

数据库、数据表、数据的关系介绍:

数据库

- 用于存储和管理数据的仓库

- 一个库中可以包含多个数据表

数据表

- 数据库最重要的组成部分之一

- 由纵向的列和横向的行组成(类似 excel 表格)

- 可以指定列名、数据类型、约束等

- 一个表中可以存储多条数据

数据:想要永久化存储的数据

参考视频:https://www.bilibili.com/video/BV1zJ411M7TB

参考专栏:https://time.geekbang.org/column/intro/139

参考书籍:https://book.douban.com/subject/35231266/

MySQL

MySQL 数据库是一个最流行的关系型数据库管理系统之一,关系型数据库是将数据保存在不同的数据表中,而且表与表之间可以有关联关系,提高了灵活性

缺点:数据存储在磁盘中,导致读写性能差,而且数据关系复杂,扩展性差

MySQL 所使用的 SQL 语句是用于访问数据库最常用的标准化语言

MySQL 配置:

MySQL 安装:https://www.jianshu.com/p/ba48f1e386f0

MySQL 配置:

修改 MySQL 默认字符集:安装 MySQL 之后第一件事就是修改字符集编码

vim /etc/mysql/my.cnf添加如下内容: [mysqld] character-set-server=utf8 collation-server=utf8_general_ci[client] default-character-set=utf8启动 MySQL 服务:

systemctl start/restart mysql登录 MySQL:

mysql -u root -p 敲回车,输入密码 初始密码查看:cat /var/log/mysqld.log 在root@localhost: 后面的就是初始密码查看默认字符集命令:

SHOW VARIABLES LIKE 'char%';修改MySQL登录密码:

set global validate_password_policy=0; set global validate_password_length=1;set password=password('密码');授予远程连接权限(MySQL 内输入):

-- 授权 grant all privileges on *.* to 'root' @'%' identified by '密码'; -- 刷新 flush privileges;

修改 MySQL 绑定 IP:

cd /etc/mysql/mysql.conf.d sudo chmod 666 mysqld.cnf vim mysqld.cnf # bind-address = 127.0.0.1注释该行关闭 Linux 防火墙

systemctl stop firewalld.service # 放行3306端口

体系架构

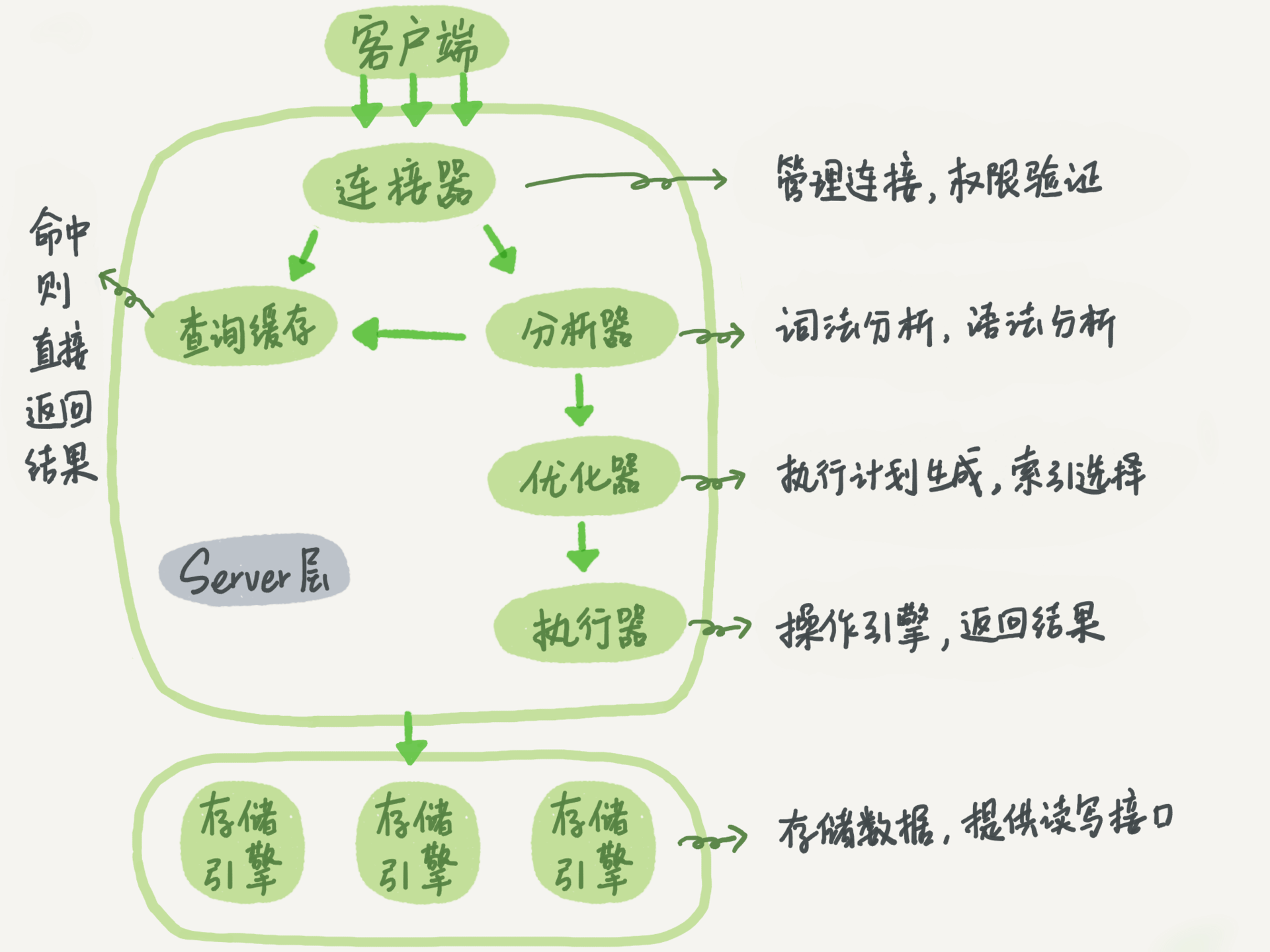

整体架构

体系结构详解:

- 第一层:网络连接层

- 一些客户端和链接服务,包含本地 Socket 通信和大多数基于客户端/服务端工具实现的 TCP/IP 通信,主要完成一些类似于连接处理、授权认证、及相关的安全方案

- 在该层上引入了连接池 Connection Pool 的概念,管理缓冲用户连接,线程处理等需要缓存的需求

- 在该层上实现基于 SSL 的安全链接,服务器也会为安全接入的每个客户端验证它所具有的操作权限

- 第二层:核心服务层

- 查询缓存、分析器、优化器、执行器等,涵盖 MySQL 的大多数核心服务功能,所有的内置函数(日期、数学、加密函数等)

- Management Serveices & Utilities:系统管理和控制工具,备份、安全、复制、集群等

- SQL Interface:接受用户的 SQL 命令,并且返回用户需要查询的结果

- Parser:SQL 语句分析器

- Optimizer:查询优化器

- Caches & Buffers:查询缓存,服务器会查询内部的缓存,如果缓存空间足够大,可以在大量读操作的环境中提升系统性能

- 所有跨存储引擎的功能在这一层实现,如存储过程、触发器、视图等

- 在该层服务器会解析查询并创建相应的内部解析树,并对其完成相应的优化如确定表的查询顺序,是否利用索引等, 最后生成相应的执行操作

- MySQL 中服务器层不管理事务,事务是由存储引擎实现的

- 查询缓存、分析器、优化器、执行器等,涵盖 MySQL 的大多数核心服务功能,所有的内置函数(日期、数学、加密函数等)

- 第三层:存储引擎层

- Pluggable Storage Engines:存储引擎接口,MySQL 区别于其他数据库的重要特点就是其存储引擎的架构模式是插件式的(存储引擎是基于表的,而不是数据库)

- 存储引擎真正的负责了 MySQL 中数据的存储和提取,服务器通过 API 和存储引擎进行通信

- 不同的存储引擎具有不同的功能,共用一个 Server 层,可以根据开发的需要,来选取合适的存储引擎

- 第四层:系统文件层

- 数据存储层,主要是将数据存储在文件系统之上,并完成与存储引擎的交互

- File System:文件系统,保存配置文件、数据文件、日志文件、错误文件、二进制文件等

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-4dZiI4tu-1686862213557)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-体系结构.png)]

建立连接

连接器

池化技术:对于访问数据库来说,建立连接的代价是比较昂贵的,因为每个连接对应一个用来交互的线程,频繁的创建关闭连接比较耗费资源,有必要建立数据库连接池,以提高访问的性能

连接建立 TCP 以后需要做权限验证,验证成功后可以进行执行 SQL。如果这时管理员账号对这个用户的权限做了修改,也不会影响已经存在连接的权限,只有再新建的连接才会使用新的权限设置

MySQL 服务器可以同时和多个客户端进行交互,所以要保证每个连接会话的隔离性(事务机制部分详解)

整体的执行流程:

权限信息

grant 语句会同时修改数据表和内存,判断权限的时候使用的是内存数据

flush privileges 语句本身会用数据表(磁盘)的数据重建一份内存权限数据,所以在权限数据可能存在不一致的情况下使用,这种不一致往往是由于直接用 DML 语句操作系统权限表导致的,所以尽量不要使用这类语句

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-eFKOGaNl-1686862213559)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-权限范围.png)]

连接状态

客户端如果长时间没有操作,连接器就会自动断开,时间是由参数 wait_timeout 控制的,默认值是 8 小时。如果在连接被断开之后,客户端再次发送请求的话,就会收到一个错误提醒:Lost connection to MySQL server during query

数据库里面,长连接是指连接成功后,如果客户端持续有请求,则一直使用同一个连接;短连接则是指每次执行完很少的几次查询就断开连接,下次查询再重新建立一个

为了减少连接的创建,推荐使用长连接,但是过多的长连接会造成 OOM,解决方案:

定期断开长连接,使用一段时间,或者程序里面判断执行过一个占用内存的大查询后,断开连接,之后要查询再重连

KILL CONNECTION idMySQL 5.7 版本,可以在每次执行一个比较大的操作后,通过执行 mysql_reset_connection 来重新初始化连接资源,这个过程不需要重连和重新做权限验证,但是会将连接恢复到刚刚创建完时的状态

SHOW PROCESSLIST:查看当前 MySQL 在进行的线程,可以实时地查看 SQL 的执行情况,其中的 Command 列显示为 Sleep 的这一行,就表示现在系统里面有一个空闲连接

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-jHeIFPGJ-1686862213559)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-SHOW_PROCESSLIST命令.png)]

| 参数 | 含义 |

|---|---|

| ID | 用户登录 mysql 时系统分配的 connection_id,可以使用函数 connection_id() 查看 |

| User | 显示当前用户,如果不是 root,这个命令就只显示用户权限范围的 sql 语句 |

| Host | 显示这个语句是从哪个 ip 的哪个端口上发的,可以用来跟踪出现问题语句的用户 |

| db | 显示这个进程目前连接的是哪个数据库 |

| Command | 显示当前连接的执行的命令,一般取值为休眠 Sleep、查询 Query、连接 Connect 等 |

| Time | 显示这个状态持续的时间,单位是秒 |

| State | 显示使用当前连接的 sql 语句的状态,以查询为例,需要经过 copying to tmp table、sorting result、sending data等状态才可以完成 |

| Info | 显示执行的 sql 语句,是判断问题语句的一个重要依据 |

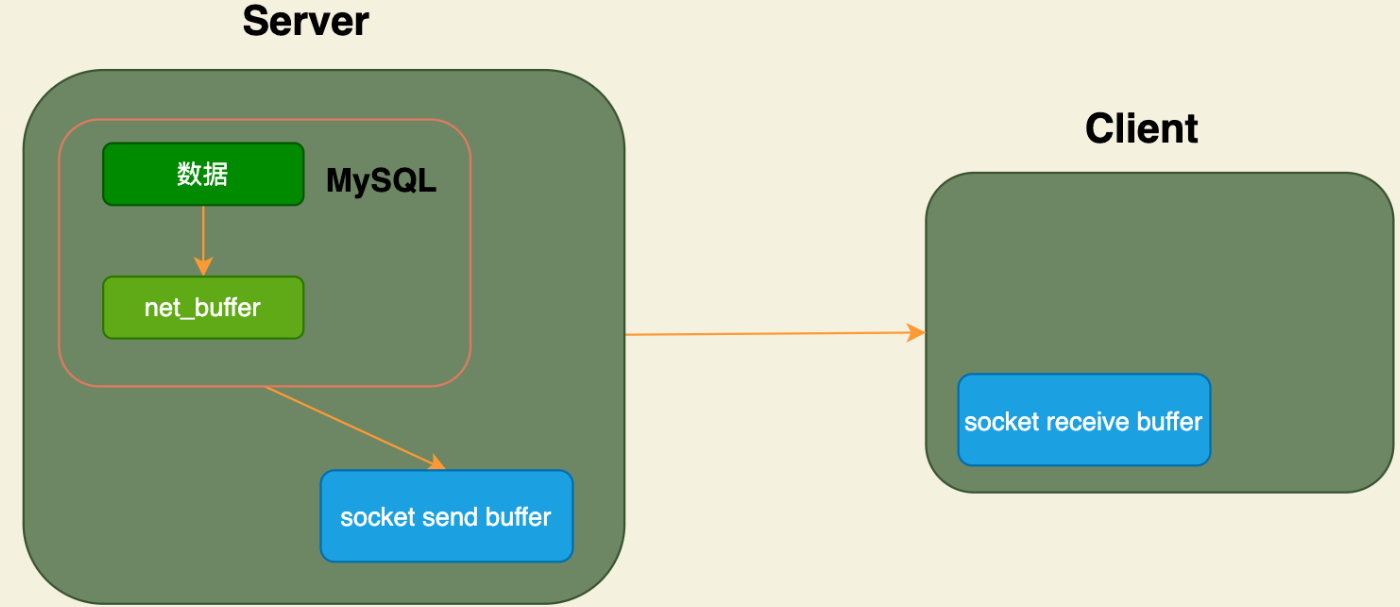

Sending data 状态表示 MySQL 线程开始访问数据行并把结果返回给客户端,而不仅仅只是返回给客户端,是处于执行器过程中的任意阶段。由于在 Sending data 状态下,MySQL 线程需要做大量磁盘读取操作,所以是整个查询中耗时最长的状态

执行流程

查询缓存

工作流程

当执行完全相同的 SQL 语句的时候,服务器就会直接从缓存中读取结果,当数据被修改,之前的缓存会失效,修改比较频繁的表不适合做查询缓存

查询过程:

- 客户端发送一条查询给服务器

- 服务器先会检查查询缓存,如果命中了缓存,则立即返回存储在缓存中的结果(一般是 K-V 键值对),否则进入下一阶段

- 分析器进行 SQL 分析,再由优化器生成对应的执行计划

- 执行器根据优化器生成的执行计划,调用存储引擎的 API 来执行查询

- 将结果返回给客户端

大多数情况下不建议使用查询缓存,因为查询缓存往往弊大于利

- 查询缓存的失效非常频繁,只要有对一个表的更新,这个表上所有的查询缓存都会被清空。因此很可能费力地把结果存起来,还没使用就被一个更新全清空了,对于更新压力大的数据库来说,查询缓存的命中率会非常低

- 除非业务就是有一张静态表,很长时间才会更新一次,比如一个系统配置表,那这张表上的查询才适合使用查询缓存

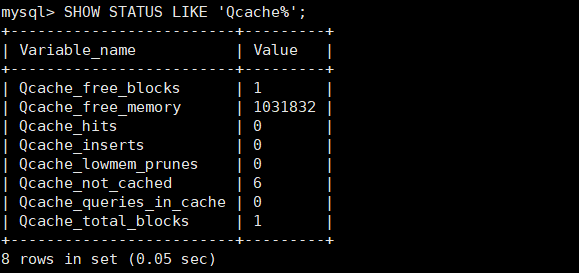

缓存配置

查看当前 MySQL 数据库是否支持查询缓存:

SHOW VARIABLES LIKE 'have_query_cache'; -- YES查看当前 MySQL 是否开启了查询缓存:

SHOW VARIABLES LIKE 'query_cache_type'; -- OFF参数说明:

OFF 或 0:查询缓存功能关闭

ON 或 1:查询缓存功能打开,查询结果符合缓存条件即会缓存,否则不予缓存;可以显式指定 SQL_NO_CACHE 不予缓存

DEMAND 或 2:查询缓存功能按需进行,显式指定 SQL_CACHE 的 SELECT 语句才缓存,其它不予缓存

SELECT SQL_CACHE id, name FROM customer; -- SQL_CACHE:查询结果可缓存 SELECT SQL_NO_CACHE id, name FROM customer;-- SQL_NO_CACHE:不使用查询缓存

查看查询缓存的占用大小:

SHOW VARIABLES LIKE 'query_cache_size';-- 单位是字节 1048576 / 1024 = 1024 = 1KB查看查询缓存的状态变量:

SHOW STATUS LIKE 'Qcache%';

参数 含义 Qcache_free_blocks 查询缓存中的可用内存块数 Qcache_free_memory 查询缓存的可用内存量 Qcache_hits 查询缓存命中数 Qcache_inserts 添加到查询缓存的查询数 Qcache_lowmen_prunes 由于内存不足而从查询缓存中删除的查询数 Qcache_not_cached 非缓存查询的数量(由于 query_cache_type 设置而无法缓存或未缓存) Qcache_queries_in_cache 查询缓存中注册的查询数 Qcache_total_blocks 查询缓存中的块总数 配置 my.cnf:

sudo chmod 666 /etc/mysql/my.cnf vim my.cnf # mysqld中配置缓存 query_cache_type=1重启服务既可生效,执行 SQL 语句进行验证 ,执行一条比较耗时的 SQL 语句,然后再多执行几次,查看后面几次的执行时间;获取通过查看查询缓存的缓存命中数,来判定是否走查询缓存

缓存失效

查询缓存失效的情况:

SQL 语句不一致,要想命中查询缓存,查询的 SQL 语句必须一致,因为缓存中 key 是查询的语句,value 是查询结构

select count(*) from tb_item; Select count(*) from tb_item; -- 不走缓存,首字母不一致当查询语句中有一些不确定查询时,则不会缓存,比如:now()、current_date()、curdate()、curtime()、rand()、uuid()、user()、database()

SELECT * FROM tb_item WHERE updatetime < NOW() LIMIT 1; SELECT USER(); SELECT DATABASE();不使用任何表查询语句:

SELECT 'A';查询 mysql、information_schema、performance_schema 等系统表时,不走查询缓存:

SELECT * FROM information_schema.engines;在跨存储引擎的存储过程、触发器或存储函数的主体内执行的查询,缓存失效

如果表更改,则使用该表的所有高速缓存查询都将变为无效并从高速缓存中删除,包括使用 MERGE 映射到已更改表的表的查询,比如:INSERT、UPDATE、DELETE、ALTER TABLE、DROP TABLE、DROP DATABASE

分析器

没有命中查询缓存,就开始了 SQL 的真正执行,分析器会对 SQL 语句做解析

SELECT * FROM t WHERE id = 1;

解析器:处理语法和解析查询,生成一课对应的解析树

- 先做词法分析,输入的是由多个字符串和空格组成的一条 SQL 语句,MySQL 需要识别出里面的字符串分别是什么代表什么。从输入的 select 这个关键字识别出来这是一个查询语句;把字符串 t 识别成 表名 t,把字符串 id 识别成列 id

- 然后做语法分析,根据词法分析的结果,语法分析器会根据语法规则,判断你输入的这个 SQL 语句是否满足 MySQL 语法。如果语句不对,就会收到

You have an error in your SQL syntax的错误提醒

预处理器:进一步检查解析树的合法性,比如数据表和数据列是否存在、别名是否有歧义等

优化器

成本分析

优化器是在表里面有多个索引的时候,决定使用哪个索引;或者在一个语句有多表关联(join)的时候,决定各个表的连接顺序

- 根据搜索条件找出所有可能的使用的索引

- 成本分析,执行成本由 I/O 成本和 CPU 成本组成,计算全表扫描和使用不同索引执行 SQL 的代价

- 找到一个最优的执行方案,用最小的代价去执行语句

在数据库里面,扫描行数是影响执行代价的因素之一,扫描的行数越少意味着访问磁盘的次数越少,消耗的 CPU 资源越少,优化器还会结合是否使用临时表、是否排序等因素进行综合判断

统计数据

MySQL 中保存着两种统计数据:

- innodb_table_stats 存储了表的统计数据,每一条记录对应着一个表的统计数据

- innodb_index_stats 存储了索引的统计数据,每一条记录对应着一个索引的一个统计项的数据

MySQL 在真正执行语句之前,并不能精确地知道满足条件的记录有多少条,只能根据统计信息来估算记录,统计信息就是索引的区分度,一个索引上不同的值的个数(比如性别只能是男女,就是 2 ),称之为基数(cardinality),基数越大说明区分度越好

通过采样统计来获取基数,InnoDB 默认会选择 N 个数据页,统计这些页面上的不同值得到一个平均值,然后乘以这个索引的页面数,就得到了这个索引的基数

在 MySQL 中,有两种存储统计数据的方式,可以通过设置参数 innodb_stats_persistent 的值来选择:

- ON:表示统计信息会持久化存储(默认),采样页数 N 默认为 20,可以通过

innodb_stats_persistent_sample_pages指定,页数越多统计的数据越准确,但消耗的资源更大 - OFF:表示统计信息只存储在内存,采样页数 N 默认为 8,也可以通过系统变量设置(不推荐,每次重新计算浪费资源)

数据表是会持续更新的,两种统计信息的更新方式:

- 设置

innodb_stats_auto_recalc为 1,当发生变动的记录数量超过表大小的 10% 时,自动触发重新计算,不过是异步进行 - 调用

ANALYZE TABLE t手动更新统计信息,只对信息做重新统计(不是重建表),没有修改数据,这个过程中加了 MDL 读锁并且是同步进行,所以会暂时阻塞系统

EXPLAIN 执行计划在优化器阶段生成,如果 explain 的结果预估的 rows 值跟实际情况差距比较大,可以执行 analyze 命令重新修正信息

错选索引

采样统计本身是估算数据,或者 SQL 语句中的字段选择有问题时,可能导致 MySQL 没有选择正确的执行索引

解决方法:

采用 force index 强行选择一个索引

SELECT * FROM user FORCE INDEX(name) WHERE NAME='seazean';可以考虑修改 SQL 语句,引导 MySQL 使用期望的索引

新建一个更合适的索引,来提供给优化器做选择,或删掉误用的索引

执行器

开始执行的时候,要先判断一下当前连接对表有没有执行查询的权限,如果没有就会返回没有权限的错误,在工程实现上,如果命中查询缓存,会在查询缓存返回结果的时候,做权限验证。如果有权限,就打开表继续执行,执行器就会根据表的引擎定义,去使用这个引擎提供的接口

引擎层

Server 层和存储引擎层的交互是以记录为单位的,存储引擎会将单条记录返回给 Server 层做进一步处理,并不是直接返回所有的记录

工作流程:

- 首先根据二级索引选择扫描范围,获取第一条符合二级索引条件的记录,进行回表查询,将聚簇索引的记录返回 Server 层,由 Server 判断记录是否符合要求

- 然后在二级索引上继续扫描下一个符合条件的记录

推荐阅读:https://mp.weixin.qq.com/s/YZ-LckObephrP1f15mzHpA

终止流程

终止语句

终止线程中正在执行的语句:

KILL QUERY thread_id

KILL 不是马上终止的意思,而是告诉执行线程这条语句已经不需要继续执行,可以开始执行停止的逻辑(类似于打断)。因为对表做增删改查操作,会在表上加 MDL 读锁,如果线程被 KILL 时就直接终止,那这个 MDL 读锁就没机会被释放了

命令 KILL QUERYthread_id_A 的执行流程:

- 把 session A 的运行状态改成 THD::KILL_QUERY(将变量 killed 赋值为 THD::KILL_QUERY)

- 给 session A 的执行线程发一个信号,让 session A 来处理这个 THD::KILL_QUERY 状态

会话处于等待状态(锁阻塞),必须满足是一个可以被唤醒的等待,必须有机会去判断线程的状态,如果不满足就会造成 KILL 失败

典型场景:innodb_thread_concurrency 为 2,代表并发线程上限数设置为 2

- session A 执行事务,session B 执行事务,达到线程上限;此时 session C 执行事务会阻塞等待,session D 执行 kill query C 无效

- C 的逻辑是每 10 毫秒判断是否可以进入 InnoDB 执行,如果不行就调用 nanosleep 函数进入 sleep 状态,没有去判断线程状态

补充:执行 Ctrl+C 的时候,是 MySQL 客户端另外启动一个连接,然后发送一个 KILL QUERY 命令

终止连接

断开线程的连接:

KILL CONNECTION id

断开连接后执行 SHOW PROCESSLIST 命令,如果这条语句的 Command 列显示 Killed,代表线程的状态是 KILL_CONNECTION,说明这个线程有语句正在执行,当前状态是停止语句执行中,终止逻辑耗时较长

- 超大事务执行期间被 KILL,这时回滚操作需要对事务执行期间生成的所有新数据版本做回收操作,耗时很长

- 大查询回滚,如果查询过程中生成了比较大的临时文件,删除临时文件可能需要等待 IO 资源,导致耗时较长

- DDL 命令执行到最后阶段被 KILL,需要删除中间过程的临时文件,也可能受 IO 资源影响耗时较久

总结:KILL CONNECTION 本质上只是把客户端的 SQL 连接断开,后面的终止流程还是要走 KILL QUERY

一个事务被 KILL 之后,持续处于回滚状态,不应该强行重启整个 MySQL 进程,应该等待事务自己执行完成,因为重启后依然继续做回滚操作的逻辑

常用工具

mysql

mysql 不是指 mysql 服务,而是指 mysql 的客户端工具

mysql [options] [database]

- -u --user=name:指定用户名

- -p --password[=name]:指定密码

- -h --host=name:指定服务器IP或域名

- -P --port=#:指定连接端口

- -e --execute=name:执行SQL语句并退出,在控制台执行SQL语句,而不用连接到数据库执行

示例:

mysql -h 127.0.0.1 -P 3306 -u root -p

mysql -uroot -p2143 db01 -e "select * from tb_book";

admin

mysqladmin 是一个执行管理操作的客户端程序,用来检查服务器的配置和当前状态、创建并删除数据库等

通过 mysqladmin --help 指令查看帮助文档

mysqladmin -uroot -p2143 create 'test01';

binlog

服务器生成的日志文件以二进制格式保存,如果需要检查这些文本,就要使用 mysqlbinlog 日志管理工具

mysqlbinlog [options] log-files1 log-files2 ...

-d --database=name:指定数据库名称,只列出指定的数据库相关操作

-o --offset=#:忽略掉日志中的前 n 行命令。

-r --result-file=name:将输出的文本格式日志输出到指定文件。

-s --short-form:显示简单格式,省略掉一些信息。

–start-datatime=date1 --stop-datetime=date2:指定日期间隔内的所有日志

–start-position=pos1 --stop-position=pos2:指定位置间隔内的所有日志

dump

命令介绍

mysqldump 客户端工具用来备份数据库或在不同数据库之间进行数据迁移,备份内容包含创建表,及插入表的 SQL 语句

mysqldump [options] db_name [tables]

mysqldump [options] --database/-B db1 [db2 db3...]

mysqldump [options] --all-databases/-A

连接选项:

- -u --user=name:指定用户名

- -p --password[=name]:指定密码

- -h --host=name:指定服务器 IP 或域名

- -P --port=#:指定连接端口

输出内容选项:

- –add-drop-database:在每个数据库创建语句前加上 Drop database 语句

- –add-drop-table:在每个表创建语句前加上 Drop table 语句 , 默认开启,不开启 (–skip-add-drop-table)

- -n --no-create-db:不包含数据库的创建语句

- -t --no-create-info:不包含数据表的创建语句

- -d --no-data:不包含数据

- -T, --tab=name:自动生成两个文件:一个 .sql 文件,创建表结构的语句;一个 .txt 文件,数据文件,相当于 select into outfile

示例:

mysqldump -uroot -p2143 db01 tb_book --add-drop-database --add-drop-table > a

mysqldump -uroot -p2143 -T /tmp test city

数据备份

命令行方式:

- 备份命令:mysqldump -u root -p 数据库名称 > 文件保存路径

- 恢复

- 登录MySQL数据库:

mysql -u root p - 删除已经备份的数据库

- 重新创建与备份数据库名称相同的数据库

- 使用该数据库

- 导入文件执行:

source 备份文件全路径

- 登录MySQL数据库:

更多方式参考:https://time.geekbang.org/column/article/81925

图形化界面:

备份

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Rh5dfWIi-1686862213560)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/图形化界面备份.png)]

恢复

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-wQUK9jtg-1686862213560)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/图形化界面恢复.png)]

import

mysqlimport 是客户端数据导入工具,用来导入mysqldump 加 -T 参数后导出的文本文件

mysqlimport [options] db_name textfile1 [textfile2...]

示例:

mysqlimport -uroot -p2143 test /tmp/city.txt

导入 sql 文件,可以使用 MySQL 中的 source 指令 :

source 文件全路径

show

mysqlshow 客户端对象查找工具,用来很快地查找存在哪些数据库、数据库中的表、表中的列或者索引

mysqlshow [options] [db_name [table_name [col_name]]]

–count:显示数据库及表的统计信息(数据库,表 均可以不指定)

-i:显示指定数据库或者指定表的状态信息

示例:

#查询每个数据库的表的数量及表中记录的数量

mysqlshow -uroot -p1234 --count

#查询test库中每个表中的字段书,及行数

mysqlshow -uroot -p1234 test --count

#查询test库中book表的详细情况

mysqlshow -uroot -p1234 test book --count

单表操作

SQL

SQL

- Structured Query Language:结构化查询语言

- 定义了操作所有关系型数据库的规则,每种数据库操作的方式可能会存在不一样的地方,称为“方言”

SQL 通用语法

- SQL 语句可以单行或多行书写,以分号结尾。

- 可使用空格和缩进来增强语句的可读性。

- MySQL 数据库的 SQL 语句不区分大小写,关键字建议使用大写。

- 数据库的注释:

- 单行注释:-- 注释内容 #注释内容(MySQL 特有)

- 多行注释:/* 注释内容 */

SQL 分类

DDL(Data Definition Language)数据定义语言

- 用来定义数据库对象:数据库,表,列等。关键字:create、drop,、alter 等

DML(Data Manipulation Language)数据操作语言

- 用来对数据库中表的数据进行增删改。关键字:insert、delete、update 等

DQL(Data Query Language)数据查询语言

- 用来查询数据库中表的记录(数据)。关键字:select、where 等

DCL(Data Control Language)数据控制语言

- 用来定义数据库的访问权限和安全级别,及创建用户。关键字:grant, revoke等

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-C1bG3xD5-1686862213561)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-SQL分类.png)]

DDL

数据库

R(Retrieve):查询

查询所有数据库:

SHOW DATABASES;查询某个数据库的创建语句

SHOW CREATE DATABASE 数据库名称; -- 标准语法SHOW CREATE DATABASE mysql; -- 查看mysql数据库的创建格式

C(Create):创建

创建数据库

CREATE DATABASE 数据库名称;-- 标准语法CREATE DATABASE db1; -- 创建db1数据库创建数据库(判断,如果不存在则创建)

CREATE DATABASE IF NOT EXISTS 数据库名称;创建数据库,并指定字符集

CREATE DATABASE 数据库名称 CHARACTER SET 字符集名称;例如:创建db4数据库、如果不存在则创建,指定字符集为gbk

-- 创建db4数据库、如果不存在则创建,指定字符集为gbk CREATE DATABASE IF NOT EXISTS db4 CHARACTER SET gbk;-- 查看db4数据库的字符集 SHOW CREATE DATABASE db4;

U(Update):修改

修改数据库的字符集

ALTER DATABASE 数据库名称 CHARACTER SET 字符集名称;常用字符集:

--查询所有支持的字符集 SHOW CHARSET; --查看所有支持的校对规则 SHOW COLLATION;-- 字符集: utf8,latinI,GBK,,GBK是utf8的子集 -- 校对规则: ci 大小定不敏感,cs或bin大小写敏感

D(Delete):删除

删除数据库:

DROP DATABASE 数据库名称;删除数据库(判断,如果存在则删除):

DROP DATABASE IF EXISTS 数据库名称;

使用数据库:

查询当前正在使用的数据库名称

SELECT DATABASE();使用数据库

USE 数据库名称; -- 标准语法 USE db4; -- 使用db4数据库

数据表

R(Retrieve):查询

查询数据库中所有的数据表

USE mysql;-- 使用mysql数据库SHOW TABLES;-- 查询库中所有的表查询表结构

DESC 表名;

- 查询表字符集```mysql SHOW TABLE STATUS FROM 库名 LIKE '表名';C(Create):创建

创建数据表

CREATE TABLE 表名(列名1 数据类型1,列名2 数据类型2,....列名n 数据类型n ); -- 注意:最后一列,不需要加逗号复制表

CREATE TABLE 表名 LIKE 被复制的表名; -- 标准语法CREATE TABLE product2 LIKE product; -- 复制product表到product2表数据类型

数据类型 说明 INT 整数类型 DOUBLE 小数类型 DATE 日期,只包含年月日:yyyy-MM-dd DATETIME 日期,包含年月日时分秒:yyyy-MM-dd HH:mm:ss TIMESTAMP 时间戳类型,包含年月日时分秒:yyyy-MM-dd HH:mm:ss

如果不给这个字段赋值或赋值为 NULL,则默认使用当前的系统时间CHAR 字符串,定长类型 VARCHAR 字符串,变长类型

name varchar(20) 代表姓名最大 20 个字符:zhangsan 8 个字符,张三 2 个字符INT(n):n 代表位数- 3:int(9)显示结果为 000000010

- 3:int(3)显示结果为 010

varchar(n):n 表示的是字符数例如:

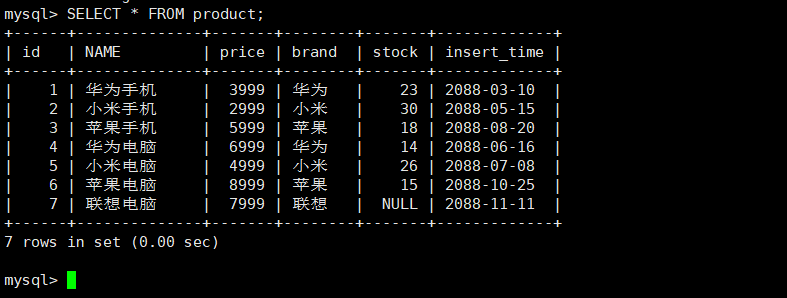

-- 使用db3数据库 USE db3;-- 创建一个product商品表 CREATE TABLE product(id INT, -- 商品编号NAME VARCHAR(30), -- 商品名称price DOUBLE, -- 商品价格stock INT, -- 商品库存insert_time DATE -- 上架时间 );

U(Update):修改

修改表名

ALTER TABLE 表名 RENAME TO 新的表名;修改表的字符集

ALTER TABLE 表名 CHARACTER SET 字符集名称;

- 添加一列```mysql ALTER TABLE 表名 ADD 列名 数据类型;修改列数据类型

ALTER TABLE 表名 MODIFY 列名 新数据类型;修改列名称和数据类型

ALTER TABLE 表名 CHANGE 列名 新列名 新数据类型;删除列

ALTER TABLE 表名 DROP 列名;

D(Delete):删除

删除数据表

DROP TABLE 表名;删除数据表(判断,如果存在则删除)

DROP TABLE IF EXISTS 表名;

DML

INSERT

新增表数据

新增格式 1:给指定列添加数据

INSERT INTO 表名(列名1,列名2...) VALUES (值1,值2...);新增格式 2:默认给全部列添加数据

INSERT INTO 表名 VALUES (值1,值2,值3,...);新增格式 3:批量添加数据

-- 给指定列批量添加数据 INSERT INTO 表名(列名1,列名2,...) VALUES (值1,值2,...),(值1,值2,...)...;-- 默认给所有列批量添加数据 INSERT INTO 表名 VALUES (值1,值2,值3,...),(值1,值2,值3,...)...;

字符串拼接

CONCAT(string1,string2,'',...)注意事项

- 列名和值的数量以及数据类型要对应

- 除了数字类型,其他数据类型的数据都需要加引号(单引双引都可以,推荐单引)

UPDATE

修改表数据语法

标准语法

UPDATE 表名 SET 列名1 = 值1,列名2 = 值2,... [where 条件];修改电视的价格为1800、库存为36

UPDATE product SET price=1800,stock=36 WHERE NAME='电视'; SELECT * FROM product;-- 查看所有商品信息

注意事项

- 修改语句中必须加条件

- 如果不加条件,则将所有数据都修改

DELETE

删除表数据语法

DELETE FROM 表名 [WHERE 条件];注意事项

- 删除语句中必须加条件

- 如果不加条件,则将所有数据删除

DQL

查询语法

数据库查询遵循条件在前的原则

SELECT DISTINCT<select list>

FROM<left_table> <join_type>

JOIN<right_table> ON <join_condition> -- 连接查询在多表查询部分详解

WHERE<where_condition>

GROUP BY<group_by_list>

HAVING<having_condition>

ORDER BY<order_by_condition>

LIMIT<limit_params>

执行顺序:

FROM <left_table>ON <join_condition><join_type> JOIN <right_table>WHERE <where_condition>GROUP BY <group_by_list>HAVING <having_condition>SELECT DISTINCT <select list>ORDER BY <order_by_condition>LIMIT <limit_params>

查询全部

查询全部的表数据

-- 标准语法 SELECT * FROM 表名;-- 查询product表所有数据(常用) SELECT * FROM product;查询指定字段的表数据

SELECT 列名1,列名2,... FROM 表名;去除重复查询:只有值全部重复的才可以去除,需要创建临时表辅助查询

SELECT DISTINCT 列名1,列名2,... FROM 表名;计算列的值(四则运算)

SELECT 列名1 运算符(+ - * /) 列名2 FROM 表名;/*如果某一列值为null,可以进行替换ifnull(表达式1,表达式2)表达式1:想替换的列表达式2:想替换的值*/例如:

-- 查询商品名称和库存,库存数量在原有基础上加10 SELECT NAME,stock+10 FROM product;-- 查询商品名称和库存,库存数量在原有基础上加10。进行null值判断 SELECT NAME,IFNULL(stock,0)+10 FROM product;起别名

SELECT 列名1,列名2,... AS 别名 FROM 表名;例如:

-- 查询商品名称和库存,库存数量在原有基础上加10。进行null值判断,起别名为getSum,AS可以省略。 SELECT NAME,IFNULL(stock,0)+10 AS getsum FROM product; SELECT NAME,IFNULL(stock,0)+10 getsum FROM product;

条件查询

条件查询语法

SELECT 列名 FROM 表名 WHERE 条件;条件分类

符号 功能 > 大于 < 小于 >= 大于等于 <= 小于等于 = 等于 <> 或 != 不等于 BETWEEN … AND … 在某个范围之内(都包含) IN(…) 多选一 LIKE 模糊查询:_单个任意字符、%任意个字符、[] 匹配集合内的字符

LIKE '[^AB]%':不以 A 和 B 开头的任意文本IS NULL 是NULL IS NOT NULL 不是NULL AND 或 && 并且 OR 或 || 或者 NOT 或 ! 非,不是 UNION 对两个结果集进行并集操作并进行去重,同时进行默认规则的排序 UNION ALL 对两个结果集进行并集操作不进行去重,不进行排序 例如:

-- 查询库存大于20的商品信息 SELECT * FROM product WHERE stock > 20;-- 查询品牌为华为的商品信息 SELECT * FROM product WHERE brand='华为';-- 查询金额在4000 ~ 6000之间的商品信息 SELECT * FROM product WHERE price >= 4000 AND price <= 6000; SELECT * FROM product WHERE price BETWEEN 4000 AND 6000;-- 查询库存为14、30、23的商品信息 SELECT * FROM product WHERE stock=14 OR stock=30 OR stock=23; SELECT * FROM product WHERE stock IN(14,30,23);-- 查询库存为null的商品信息 SELECT * FROM product WHERE stock IS NULL; -- 查询库存不为null的商品信息 SELECT * FROM product WHERE stock IS NOT NULL;-- 查询名称以'小米'为开头的商品信息 SELECT * FROM product WHERE NAME LIKE '小米%';-- 查询名称第二个字是'为'的商品信息 SELECT * FROM product WHERE NAME LIKE '_为%';-- 查询名称为四个字符的商品信息 4个下划线 SELECT * FROM product WHERE NAME LIKE '____';-- 查询名称中包含电脑的商品信息 SELECT * FROM product WHERE NAME LIKE '%电脑%';

函数查询

聚合函数

聚合函数:将一列数据作为一个整体,进行纵向的计算

聚合函数语法

SELECT 函数名(列名) FROM 表名 [WHERE 条件]聚合函数分类

函数名 功能 COUNT(列名) 统计数量(一般选用不为 null 的列) MAX(列名) 最大值 MIN(列名) 最小值 SUM(列名) 求和 AVG(列名) 平均值(会忽略 null 行) 例如

-- 计算product表中总记录条数 7 SELECT COUNT(*) FROM product;-- 获取最高价格 SELECT MAX(price) FROM product; -- 获取最高价格的商品名称 SELECT NAME,price FROM product WHERE price = (SELECT MAX(price) FROM product);-- 获取最低库存 SELECT MIN(stock) FROM product; -- 获取最低库存的商品名称 SELECT NAME,stock FROM product WHERE stock = (SELECT MIN(stock) FROM product);-- 获取总库存数量 SELECT SUM(stock) FROM product; -- 获取品牌为小米的平均商品价格 SELECT AVG(price) FROM product WHERE brand='小米';

文本函数

CONCAT():用于连接两个字段

SELECT CONCAT(TRIM(col1), '(', TRIM(col2), ')') AS concat_col FROM mytable

-- 许多数据库会使用空格把一个值填充为列宽,连接的结果出现一些不必要的空格,使用TRIM()可以去除首尾空格

| 函数名称 | 作 用 |

|---|---|

| LENGTH | 计算字符串长度函数,返回字符串的字节长度 |

| CONCAT | 合并字符串函数,返回结果为连接参数产生的字符串,参数可以使一个或多个 |

| INSERT | 替换字符串函数 |

| LOWER | 将字符串中的字母转换为小写 |

| UPPER | 将字符串中的字母转换为大写 |

| LEFT | 从左侧字截取符串,返回字符串左边的若干个字符 |

| RIGHT | 从右侧字截取符串,返回字符串右边的若干个字符 |

| TRIM | 删除字符串左右两侧的空格 |

| REPLACE | 字符串替换函数,返回替换后的新字符串 |

| SUBSTRING | 截取字符串,返回从指定位置开始的指定长度的字符换 |

| REVERSE | 字符串反转(逆序)函数,返回与原始字符串顺序相反的字符串 |

数字函数

| 函数名称 | 作 用 |

|---|---|

| ABS | 求绝对值 |

| SQRT | 求二次方根 |

| MOD | 求余数 |

| CEIL 和 CEILING | 两个函数功能相同,都是返回不小于参数的最小整数,即向上取整 |

| FLOOR | 向下取整,返回值转化为一个BIGINT |

| RAND | 生成一个0~1之间的随机数,传入整数参数是,用来产生重复序列 |

| ROUND | 对所传参数进行四舍五入 |

| SIGN | 返回参数的符号 |

| POW 和 POWER | 两个函数的功能相同,都是所传参数的次方的结果值 |

| SIN | 求正弦值 |

| ASIN | 求反正弦值,与函数 SIN 互为反函数 |

| COS | 求余弦值 |

| ACOS | 求反余弦值,与函数 COS 互为反函数 |

| TAN | 求正切值 |

| ATAN | 求反正切值,与函数 TAN 互为反函数 |

| COT | 求余切值 |

日期函数

| 函数名称 | 作 用 |

|---|---|

| CURDATE 和 CURRENT_DATE | 两个函数作用相同,返回当前系统的日期值 |

| CURTIME 和 CURRENT_TIME | 两个函数作用相同,返回当前系统的时间值 |

| NOW 和 SYSDATE | 两个函数作用相同,返回当前系统的日期和时间值 |

| MONTH | 获取指定日期中的月份 |

| MONTHNAME | 获取指定日期中的月份英文名称 |

| DAYNAME | 获取指定曰期对应的星期几的英文名称 |

| DAYOFWEEK | 获取指定日期对应的一周的索引位置值 |

| WEEK | 获取指定日期是一年中的第几周,返回值的范围是否为 0〜52 或 1〜53 |

| DAYOFYEAR | 获取指定曰期是一年中的第几天,返回值范围是1~366 |

| DAYOFMONTH | 获取指定日期是一个月中是第几天,返回值范围是1~31 |

| YEAR | 获取年份,返回值范围是 1970〜2069 |

| TIME_TO_SEC | 将时间参数转换为秒数 |

| SEC_TO_TIME | 将秒数转换为时间,与TIME_TO_SEC 互为反函数 |

| DATE_ADD 和 ADDDATE | 两个函数功能相同,都是向日期添加指定的时间间隔 |

| DATE_SUB 和 SUBDATE | 两个函数功能相同,都是向日期减去指定的时间间隔 |

| ADDTIME | 时间加法运算,在原始时间上添加指定的时间 |

| SUBTIME | 时间减法运算,在原始时间上减去指定的时间 |

| DATEDIFF | 获取两个日期之间间隔,返回参数 1 减去参数 2 的值 |

| DATE_FORMAT | 格式化指定的日期,根据参数返回指定格式的值 |

| WEEKDAY | 获取指定日期在一周内的对应的工作日索引 |

正则查询

正则表达式(Regular Expression)是指一个用来描述或者匹配一系列符合某个句法规则的字符串的单个字符串

SELECT * FROM emp WHERE name REGEXP '^T'; -- 匹配以T开头的name值

SELECT * FROM emp WHERE name REGEXP '2$'; -- 匹配以2结尾的name值

SELECT * FROM emp WHERE name REGEXP '[uvw]';-- 匹配包含 uvw 的name值

| 符号 | 含义 |

|---|---|

| ^ | 在字符串开始处进行匹配 |

| $ | 在字符串末尾处进行匹配 |

| . | 匹配任意单个字符, 包括换行符 |

| […] | 匹配出括号内的任意字符 |

| [^…] | 匹配不出括号内的任意字符 |

| a* | 匹配零个或者多个a(包括空串) |

| a+ | 匹配一个或者多个a(不包括空串) |

| a? | 匹配零个或者一个a |

| a1|a2 | 匹配a1或a2 |

| a(m) | 匹配m个a |

| a(m,) | 至少匹配m个a |

| a(m,n) | 匹配m个a 到 n个a |

| a(,n) | 匹配0到n个a |

| (…) | 将模式元素组成单一元素 |

排序查询

排序查询语法

SELECT 列名 FROM 表名 [WHERE 条件] ORDER BY 列名1 排序方式1,列名2 排序方式2;排序方式

ASC:升序 DESC:降序注意:多个排序条件,当前边的条件值一样时,才会判断第二条件

例如

-- 按照库存升序排序 SELECT * FROM product ORDER BY stock ASC;-- 查询名称中包含手机的商品信息。按照金额降序排序 SELECT * FROM product WHERE NAME LIKE '%手机%' ORDER BY price DESC;-- 按照金额升序排序,如果金额相同,按照库存降序排列 SELECT * FROM product ORDER BY price ASC,stock DESC;

分组查询

分组查询会进行去重

分组查询语法

SELECT 列名 FROM 表名 [WHERE 条件] GROUP BY 分组列名 [HAVING 分组后条件过滤] [ORDER BY 排序列名 排序方式];WHERE 过滤行,HAVING 过滤分组,行过滤应当先于分组过滤

分组规定:

- GROUP BY 子句出现在 WHERE 子句之后,ORDER BY 子句之前

- NULL 的行会单独分为一组

- 大多数 SQL 实现不支持 GROUP BY 列具有可变长度的数据类型

例如

-- 按照品牌分组,获取每组商品的总金额 SELECT brand,SUM(price) FROM product GROUP BY brand;-- 对金额大于4000元的商品,按照品牌分组,获取每组商品的总金额 SELECT brand,SUM(price) FROM product WHERE price > 4000 GROUP BY brand;-- 对金额大于4000元的商品,按照品牌分组,获取每组商品的总金额,只显示总金额大于7000元的 SELECT brand,SUM(price) AS getSum FROM product WHERE price > 4000 GROUP BY brand HAVING getSum > 7000;-- 对金额大于4000元的商品,按照品牌分组,获取每组商品的总金额,只显示总金额大于7000元的、并按照总金额的降序排列 SELECT brand,SUM(price) AS getSum FROM product WHERE price > 4000 GROUP BY brand HAVING getSum > 7000 ORDER BY getSum DESC;

分页查询

分页查询语法

SELECT 列名 FROM 表名 [WHERE 条件] GROUP BY 分组列名 [HAVING 分组后条件过滤] [ORDER BY 排序列名 排序方式] LIMIT 开始索引,查询条数;公式:开始索引 = (当前页码-1) * 每页显示的条数

例如

SELECT * FROM product LIMIT 0,2; -- 第一页 开始索引=(1-1) * 2 SELECT * FROM product LIMIT 2,2; -- 第二页 开始索引=(2-1) * 2 SELECT * FROM product LIMIT 4,2; -- 第三页 开始索引=(3-1) * 2 SELECT * FROM product LIMIT 6,2; -- 第四页 开始索引=(4-1) * 2[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-piVOy5sJ-1686862213561)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-DQL分页查询图解.png)]

多表操作

约束分类

约束介绍

约束:对表中的数据进行限定,保证数据的正确性、有效性、完整性

约束的分类:

| 约束 | 说明 |

|---|---|

| PRIMARY KEY | 主键约束 |

| PRIMARY KEY AUTO_INCREMENT | 主键、自动增长 |

| UNIQUE | 唯一约束 |

| NOT NULL | 非空约束 |

| FOREIGN KEY | 外键约束 |

| FOREIGN KEY ON UPDATE CASCADE | 外键级联更新 |

| FOREIGN KEY ON DELETE CASCADE | 外键级联删除 |

主键约束

主键约束特点:

- 主键约束默认包含非空和唯一两个功能

- 一张表只能有一个主键

- 主键一般用于表中数据的唯一标识

建表时添加主键约束

CREATE TABLE 表名(列名 数据类型 PRIMARY KEY,列名 数据类型,... );删除主键约束

ALTER TABLE 表名 DROP PRIMARY KEY;建表后单独添加主键约束

ALTER TABLE 表名 MODIFY 列名 数据类型 PRIMARY KEY;例如

-- 创建student表 CREATE TABLE student(id INT PRIMARY KEY -- 给id添加主键约束 );-- 添加数据 INSERT INTO student VALUES (1),(2); -- 主键默认唯一,添加重复数据,会报错 INSERT INTO student VALUES (2); -- 主键默认非空,不能添加null的数据 INSERT INTO student VALUES (NULL);

主键自增

主键自增约束可以为空,并自动增长。删除某条数据不影响自增的下一个数值,依然按照前一个值自增

建表时添加主键自增约束

CREATE TABLE 表名(列名 数据类型 PRIMARY KEY AUTO_INCREMENT,列名 数据类型,... );删除主键自增约束

ALTER TABLE 表名 MODIFY 列名 数据类型;建表后单独添加主键自增约束

ALTER TABLE 表名 MODIFY 列名 数据类型 AUTO_INCREMENT;例如

-- 创建student2表 CREATE TABLE student2(id INT PRIMARY KEY AUTO_INCREMENT -- 给id添加主键自增约束 );-- 添加数据 INSERT INTO student2 VALUES (1),(2); -- 添加null值,会自动增长 INSERT INTO student2 VALUES (NULL),(NULL);-- 3,4

唯一约束

唯一约束:约束不能有重复的数据

建表时添加唯一约束

CREATE TABLE 表名(列名 数据类型 UNIQUE,列名 数据类型,... );删除唯一约束

ALTER TABLE 表名 DROP INDEX 列名;建表后单独添加唯一约束

ALTER TABLE 表名 MODIFY 列名 数据类型 UNIQUE;

非空约束

建表时添加非空约束

CREATE TABLE 表名(列名 数据类型 NOT NULL,列名 数据类型,... );删除非空约束

ALTER TABLE 表名 MODIFY 列名 数据类型;建表后单独添加非空约束

ALTER TABLE 表名 MODIFY 列名 数据类型 NOT NULL;

外键约束

外键约束:让表和表之间产生关系,从而保证数据的准确性

建表时添加外键约束

CREATE TABLE 表名(列名 数据类型 约束,...CONSTRAINT 外键名 FOREIGN KEY (本表外键列名) REFERENCES 主表名(主表主键列名) );删除外键约束

ALTER TABLE 表名 DROP FOREIGN KEY 外键名;建表后单独添加外键约束

ALTER TABLE 表名 ADD CONSTRAINT 外键名 FOREIGN KEY (本表外键列名) REFERENCES 主表名(主表主键列名);例如

-- 创建user用户表 CREATE TABLE USER(id INT PRIMARY KEY AUTO_INCREMENT, -- idname VARCHAR(20) NOT NULL -- 姓名 ); -- 添加用户数据 INSERT INTO USER VALUES (NULL,'张三'),(NULL,'李四'),(NULL,'王五');-- 创建orderlist订单表 CREATE TABLE orderlist(id INT PRIMARY KEY AUTO_INCREMENT, -- idnumber VARCHAR(20) NOT NULL, -- 订单编号uid INT, -- 订单所属用户CONSTRAINT ou_fk1 FOREIGN KEY (uid) REFERENCES USER(id) -- 添加外键约束 ); -- 添加订单数据 INSERT INTO orderlist VALUES (NULL,'hm001',1),(NULL,'hm002',1), (NULL,'hm003',2),(NULL,'hm004',2), (NULL,'hm005',3),(NULL,'hm006',3);-- 添加一个订单,但是没有所属用户。无法添加 INSERT INTO orderlist VALUES (NULL,'hm007',8); -- 删除王五这个用户,但是订单表中王五还有很多个订单呢。无法删除 DELETE FROM USER WHERE NAME='王五';

外键级联

级联操作:当把主表中的数据进行删除或更新时,从表中有关联的数据的相应操作,包括 RESTRICT、CASCADE、SET NULL 和 NO ACTION

RESTRICT 和 NO ACTION相同, 是指限制在子表有关联记录的情况下, 父表不能更新

CASCADE 表示父表在更新或者删除时,更新或者删除子表对应的记录

SET NULL 则表示父表在更新或者删除的时候,子表的对应字段被SET NULL

级联操作:

添加级联更新

ALTER TABLE 表名 ADD CONSTRAINT 外键名 FOREIGN KEY (本表外键列名) REFERENCES 主表名(主表主键列名) ON UPDATE [CASCADE | RESTRICT | SET NULL];添加级联删除

ALTER TABLE 表名 ADD CONSTRAINT 外键名 FOREIGN KEY (本表外键列名) REFERENCES 主表名(主表主键列名) ON DELETE CASCADE;同时添加级联更新和级联删除

ALTER TABLE 表名 ADD CONSTRAINT 外键名 FOREIGN KEY (本表外键列名) REFERENCES 主表名(主表主键列名) ON UPDATE CASCADE ON DELETE CASCADE;

多表设计

一对一

多表:有多张数据表,而表与表之间有一定的关联关系,通过外键约束实现,分为一对一、一对多、多对多三类

举例:人和身份证

实现原则:在任意一个表建立外键,去关联另外一个表的主键

-- 创建person表

CREATE TABLE person(id INT PRIMARY KEY AUTO_INCREMENT, -- 主键idNAME VARCHAR(20) -- 姓名

);

-- 添加数据

INSERT INTO person VALUES (NULL,'张三'),(NULL,'李四');-- 创建card表

CREATE TABLE card(id INT PRIMARY KEY AUTO_INCREMENT, -- 主键idnumber VARCHAR(20) UNIQUE NOT NULL, -- 身份证号pid INT UNIQUE, -- 外键列CONSTRAINT cp_fk1 FOREIGN KEY (pid) REFERENCES person(id)

);

-- 添加数据

INSERT INTO card VALUES (NULL,'12345',1),(NULL,'56789',2);

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-wBlATlgY-1686862213562)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/多表设计一对一.png)]

一对多

举例:用户和订单、商品分类和商品

实现原则:在多的一方,建立外键约束,来关联一的一方主键

-- 创建user表

CREATE TABLE USER(id INT PRIMARY KEY AUTO_INCREMENT, -- 主键idNAME VARCHAR(20) -- 姓名

);

-- 添加数据

INSERT INTO USER VALUES (NULL,'张三'),(NULL,'李四');-- 创建orderlist表

CREATE TABLE orderlist(id INT PRIMARY KEY AUTO_INCREMENT, -- 主键idnumber VARCHAR(20), -- 订单编号uid INT, -- 外键列CONSTRAINT ou_fk1 FOREIGN KEY (uid) REFERENCES USER(id)

);

-- 添加数据

INSERT INTO orderlist VALUES (NULL,'hm001',1),(NULL,'hm002',1),(NULL,'hm003',2),(NULL,'hm004',2);

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-sKxDKHR5-1686862213563)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/多表设计一对多.png)]

多对多

举例:学生和课程。一个学生可以选择多个课程,一个课程也可以被多个学生选择

实现原则:借助第三张表中间表,中间表至少包含两个列,这两个列作为中间表的外键,分别关联两张表的主键

-- 创建student表

CREATE TABLE student(id INT PRIMARY KEY AUTO_INCREMENT, -- 主键idNAME VARCHAR(20) -- 学生姓名

);

-- 添加数据

INSERT INTO student VALUES (NULL,'张三'),(NULL,'李四');-- 创建course表

CREATE TABLE course(id INT PRIMARY KEY AUTO_INCREMENT, -- 主键idNAME VARCHAR(10) -- 课程名称

);

-- 添加数据

INSERT INTO course VALUES (NULL,'语文'),(NULL,'数学');-- 创建中间表

CREATE TABLE stu_course(id INT PRIMARY KEY AUTO_INCREMENT, -- 主键idsid INT, -- 用于和student表中的id进行外键关联cid INT, -- 用于和course表中的id进行外键关联CONSTRAINT sc_fk1 FOREIGN KEY (sid) REFERENCES student(id), -- 添加外键约束CONSTRAINT sc_fk2 FOREIGN KEY (cid) REFERENCES course(id) -- 添加外键约束

);

-- 添加数据

INSERT INTO stu_course VALUES (NULL,1,1),(NULL,1,2),(NULL,2,1),(NULL,2,2);

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-4awrgwGs-1686862213563)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/多表设计多对多.png)]

连接查询

内外连接

内连接

连接查询的是两张表有交集的部分数据,两张表分为驱动表和被驱动表,如果结果集中的每条记录都是两个表相互匹配的组合,则称这样的结果集为笛卡尔积

内连接查询,若驱动表中的记录在被驱动表中找不到匹配的记录时,则该记录不会加到最后的结果集

显式内连接:

SELECT 列名 FROM 表名1 [INNER] JOIN 表名2 ON 条件;隐式内连接:内连接中 WHERE 子句和 ON 子句是等价的

SELECT 列名 FROM 表名1,表名2 WHERE 条件;

STRAIGHT_JOIN与 JOIN 类似,只不过左表始终在右表之前读取,只适用于内连接

外连接

外连接查询,若驱动表中的记录在被驱动表中找不到匹配的记录时,则该记录也会加到最后的结果集,只是对于被驱动表中不匹配过滤条件的记录,各个字段使用 NULL 填充

应用实例:查学生成绩,也想展示出缺考的人的成绩

左外连接:选择左侧的表为驱动表,查询左表的全部数据,和左右两张表有交集部分的数据

SELECT 列名 FROM 表名1 LEFT [OUTER] JOIN 表名2 ON 条件;右外连接:选择右侧的表为驱动表,查询右表的全部数据,和左右两张表有交集部分的数据

SELECT 列名 FROM 表名1 RIGHT [OUTER] JOIN 表名2 ON 条件;

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-esfDYBH2-1686862213563)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-JOIN查询图.png)]

关联查询

自关联查询:同一张表中有数据关联,可以多次查询这同一个表

数据准备

-- 创建员工表 CREATE TABLE employee(id INT PRIMARY KEY AUTO_INCREMENT, -- 员工编号NAME VARCHAR(20), -- 员工姓名mgr INT, -- 上级编号salary DOUBLE -- 员工工资 ); -- 添加数据 INSERT INTO employee VALUES (1001,'孙悟空',1005,9000.00),..,(1009,'宋江',NULL,16000.00);[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-3lRk2qa0-1686862213564)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/自关联查询数据准备.png)]

数据查询

-- 查询所有员工的姓名及其直接上级的姓名,没有上级的员工也需要查询 /* 分析员工信息 employee表条件:employee.mgr = employee.id查询左表的全部数据,和左右两张表有交集部分数据,左外连接 */ SELECTe1.id,e1.name,e1.mgr,e2.id,e2.name FROMemployee e1 LEFT OUTER JOINemployee e2 ONe1.mgr = e2.id;查询结果

id name mgr id name 1001 孙悟空 1005 1005 唐僧 1002 猪八戒 1005 1005 唐僧 1003 沙和尚 1005 1005 唐僧 1004 小白龙 1005 1005 唐僧 1005 唐僧 NULL NULL NULL 1006 武松 1009 1009 宋江 1007 李逵 1009 1009 宋江 1008 林冲 1009 1009 宋江 1009 宋江 NULL NULL NULL

连接原理

Index Nested-Loop Join 算法:查询驱动表得到数据集,然后根据数据集中的每一条记录的关联字段再分别到被驱动表中查找匹配(走索引),所以驱动表只需要访问一次,被驱动表要访问多次

MySQL 将查询驱动表后得到的记录成为驱动表的扇出,连接查询的成本:单次访问驱动表的成本 + 扇出值 * 单次访问被驱动表的成本,优化器会选择成本最小的表连接顺序(确定谁是驱动表,谁是被驱动表)生成执行计划,进行连接查询,优化方式:

- 减少驱动表的扇出(让数据量小的表来做驱动表)

- 降低访问被驱动表的成本

说明:STRAIGHT_JOIN 是查一条驱动表,然后根据关联字段去查被驱动表,要访问多次驱动表,所以需要优化为 INL 算法

Block Nested-Loop Join 算法:一种空间换时间的优化方式,基于块的循环连接,执行连接查询前申请一块固定大小的内存作为连接缓冲区 Join Buffer,先把若干条驱动表中的扇出暂存在缓冲区,每一条被驱动表中的记录一次性的与 Buffer 中多条记录进行匹配(扫描全部数据,一条一条的匹配),因为是在内存中完成,所以速度快,并且降低了 I/O 成本

Join Buffer 可以通过参数 join_buffer_size 进行配置,默认大小是 256 KB

在成本分析时,对于很多张表的连接查询,连接顺序有非常多,MySQL 如果挨着进行遍历计算成本,会消耗很多资源

提前结束某种连接顺序的成本评估:维护一个全局变量记录当前成本最小的连接方式,如果一种顺序只计算了一部分就已经超过了最小成本,可以提前结束计算

系统变量 optimizer_search_depth:如果连接表的个数小于该变量,就继续穷举分析每一种连接数量,反之只对数量与 depth 值相同的表进行分析,该值越大成本分析的越精确

系统变量 optimizer_prune_level:控制启发式规则的启用,这些规则就是根据以往经验指定的,不满足规则的连接顺序不分析成本

连接优化

BKA

Batched Key Access 算法是对 NLJ 算法的优化,在读取被驱动表的记录时使用顺序 IO,Extra 信息中会有 Batched Key Access 信息

使用 BKA 的表的 JOIN 过程如下:

- 连接驱动表将满足条件的记录放入 Join Buffer,并将两表连接的字段放入一个 DYNAMIC_ARRAY ranges 中

- 在进行表的过接过程中,会将 ranges 相关的信息传入 Buffer 中,进行被驱动表主建的查找及排序操作

- 调用步骤 2 中产生的有序主建,顺序读取被驱动表的数据

- 当缓冲区的数据被读完后,会重复进行步骤 2、3,直到记录被读取完

使用 BKA 优化需要设进行设置:

SET optimizer_switch='mrr=on,mrr_cost_based=off,batched_key_access=on';

说明:前两个参数的作用是启用 MRR,因为 BKA 算法的优化要依赖于 MRR(系统优化 → 内存优化 → Read 详解)

BNL

问题

BNL 即 Block Nested-Loop Join 算法,由于要访问多次被驱动表,会产生两个问题:

Join 语句多次扫描一个冷表,并且语句执行时间小于 1 秒,就会在再次扫描冷表时,把冷表的数据页移到 LRU 链表头部,导致热数据被淘汰,影响业务的正常运行

这种情况冷表的数据量要小于整个 Buffer Pool 的 old 区域,能够完全放入 old 区,才会再次被读时加到 young,否则读取下一段时就已经把上一段淘汰

Join 语句在循环读磁盘和淘汰内存页,进入 old 区域的数据页很可能在 1 秒之内就被淘汰,就会导致 MySQL 实例的 Buffer Pool 在这段时间内 young 区域的数据页没有被合理地淘汰

大表 Join 操作虽然对 IO 有影响,但是在语句执行结束后对 IO 的影响随之结束。但是对 Buffer Pool 的影响就是持续性的,需要依靠后续的查询请求慢慢恢复内存命中率

优化

将 BNL 算法转成 BKA 算法,优化方向:

- 在被驱动表上建索引,这样就可以根据索引进行顺序 IO

- 使用临时表,在临时表上建立索引,将被驱动表和临时表进行连接查询

驱动表 t1,被驱动表 t2,使用临时表的工作流程:

- 把表 t1 中满足条件的数据放在临时表 tmp_t 中

- 给临时表 tmp_t 的关联字段加上索引,使用 BKA 算法

- 让表 t2 和 tmp_t 做 Join 操作(临时表是被驱动表)

补充:MySQL 8.0 支持 hash join,join_buffer 维护的不再是一个无序数组,而是一个哈希表,查询效率更高,执行效率比临时表更高

嵌套查询

查询分类

查询语句中嵌套了查询语句,将嵌套查询称为子查询,FROM 子句后面的子查询的结果集称为派生表

根据结果分类:

结果是单行单列:可以将查询的结果作为另一条语句的查询条件,使用运算符判断

SELECT 列名 FROM 表名 WHERE 列名=(SELECT 列名/聚合函数(列名) FROM 表名 [WHERE 条件]);结果是多行单列:可以作为条件,使用运算符 IN 或 NOT IN 进行判断

SELECT 列名 FROM 表名 WHERE 列名 [NOT] IN (SELECT 列名 FROM 表名 [WHERE 条件]);结果是多行多列:查询的结果可以作为一张虚拟表参与查询

SELECT 列名 FROM 表名 [别名],(SELECT 列名 FROM 表名 [WHERE 条件]) [别名] [WHERE 条件];-- 查询订单表orderlist中id大于4的订单信息和所属用户USER信息 SELECT * FROM USER u,(SELECT * FROM orderlist WHERE id>4) o WHERE u.id=o.uid;

相关性分类:

- 不相关子查询:子查询不依赖外层查询的值,可以单独运行出结果

- 相关子查询:子查询的执行需要依赖外层查询的值

查询优化

不相关子查询的结果集会被写入一个临时表,并且在写入时去重,该过程称为物化,存储结果集的临时表称为物化表

系统变量 tmp_table_size 或者 max_heap_table_size 为表的最值

- 小于系统变量时,内存中可以保存,会为建立基于内存的 MEMORY 存储引擎的临时表,并建立哈希索引

- 大于任意一个系统变量时,物化表会使用基于磁盘的 InnoDB 存储引擎来保存结果集中的记录,索引类型为 B+ 树

物化后,嵌套查询就相当于外层查询的表和物化表进行内连接查询,然后经过优化器选择成本最小的表连接顺序执行查询

子查询物化会产生建立临时表的成本,但是将子查询转化为连接查询可以充分发挥优化器的作用,所以引入:半连接

- t1 和 t2 表进行半连接,对于 t1 表中的某条记录,只需要关心在 t2 表中是否存在,而不需要关心有多少条记录与之匹配,最终结果集只保留 t1 的记录

- 半连接只是执行子查询的一种方式,MySQL 并没有提供面向用户的半连接语法

参考书籍:https://book.douban.com/subject/35231266/

联合查询

UNION 是取这两个子查询结果的并集,并进行去重,同时进行默认规则的排序(union 是行加起来,join 是列加起来)

UNION ALL 是对两个结果集进行并集操作不进行去重,不进行排序

(select 1000 as f) union (select id from t1 order by id desc limit 2); #t1表中包含id 为 1-1000 的数据

语句的执行流程:

- 创建一个内存临时表,这个临时表只有一个整型字段 f,并且 f 是主键字段

- 执行第一个子查询,得到 1000 这个值,并存入临时表中

- 执行第二个子查询,拿到第一行 id=1000,试图插入临时表中,但由于 1000 这个值已经存在于临时表了,违反了唯一性约束,所以插入失败,然后继续执行

- 取到第二行 id=999,插入临时表成功

- 从临时表中按行取出数据,返回结果并删除临时表,结果中包含两行数据分别是 1000 和 999

查询练习

数据准备:

-- 创建db4数据库

CREATE DATABASE db4;

-- 使用db4数据库

USE db4;-- 创建user表

CREATE TABLE USER(id INT PRIMARY KEY AUTO_INCREMENT, -- 用户idNAME VARCHAR(20), -- 用户姓名age INT -- 用户年龄

);-- 订单表

CREATE TABLE orderlist(id INT PRIMARY KEY AUTO_INCREMENT, -- 订单idnumber VARCHAR(30), -- 订单编号uid INT, -- 外键字段CONSTRAINT ou_fk1 FOREIGN KEY (uid) REFERENCES USER(id)

);-- 商品分类表

CREATE TABLE category(id INT PRIMARY KEY AUTO_INCREMENT, -- 商品分类idNAME VARCHAR(10) -- 商品分类名称

);-- 商品表

CREATE TABLE product(id INT PRIMARY KEY AUTO_INCREMENT, -- 商品idNAME VARCHAR(30), -- 商品名称cid INT, -- 外键字段CONSTRAINT cp_fk1 FOREIGN KEY (cid) REFERENCES category(id)

);-- 中间表

CREATE TABLE us_pro(upid INT PRIMARY KEY AUTO_INCREMENT, -- 中间表iduid INT, -- 外键字段。需要和用户表的主键产生关联pid INT, -- 外键字段。需要和商品表的主键产生关联CONSTRAINT up_fk1 FOREIGN KEY (uid) REFERENCES USER(id),CONSTRAINT up_fk2 FOREIGN KEY (pid) REFERENCES product(id)

);

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-xaGbiuaG-1686862213564)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/多表练习架构设计.png)]

数据查询:

查询用户的编号、姓名、年龄、订单编号

数据:用户的编号、姓名、年龄在 user 表,订单编号在 orderlist 表

条件:user.id = orderlist.uid

SELECTu.*,o.number FROMUSER u,orderlist o WHEREu.id = o.uid;查询所有的用户,显示用户的编号、姓名、年龄、订单编号。

SELECTu.*,o.number FROMUSER u LEFT OUTER JOINorderlist o ONu.id = o.uid;查询用户年龄大于 23 岁的信息,显示用户的编号、姓名、年龄、订单编号

SELECTu.*,o.number FROMUSER u,orderlist o WHEREu.id = o.uidANDu.age > 23;SELECTu.*,o.number FROM(SELECT * FROM USER WHERE age > 23) u,-- 嵌套查询orderlist o WHEREu.id = o.uid;查询张三和李四用户的信息,显示用户的编号、姓名、年龄、订单编号。

SELECTu.*,o.number FROMUSER u,orderlist o WHEREu.id=o.uidANDu.name IN ('张三','李四');查询所有的用户和该用户能查看的所有的商品,显示用户的编号、姓名、年龄、商品名称

数据:用户的编号、姓名、年龄在 user 表,商品名称在 product 表,中间表 us_pro

条件:us_pro.uid = user.id AND us_pro.pid = product.id

SELECTu.id,u.name,u.age,p.name FROMUSER u,product p,us_pro up WHEREup.uid = u.idANDup.pid=p.id;查询张三和李四这两个用户可以看到的商品,显示用户的编号、姓名、年龄、商品名称。

SELECTu.id,u.name,u.age,p.name FROMUSER u,product p,us_pro up WHEREup.uid=u.idANDup.pid=p.idANDu.name IN ('张三','李四');

高级结构

视图

基本介绍

视图概念:视图是一种虚拟存在的数据表,这个虚拟的表并不在数据库中实际存在

本质:将一条 SELECT 查询语句的结果封装到了一个虚拟表中,所以在创建视图的时候,工作重心要放在这条 SELECT 查询语句上

作用:将一些比较复杂的查询语句的结果,封装到一个虚拟表中,再有相同查询需求时,直接查询该虚拟表

优点:

简单:使用视图的用户不需要关心表的结构、关联条件和筛选条件,因为虚拟表中已经是过滤好的结果集

安全:使用视图的用户只能访问查询的结果集,对表的权限管理并不能限制到某个行某个列

数据独立,一旦视图的结构确定,可以屏蔽表结构变化对用户的影响,源表增加列对视图没有影响;源表修改列名,则可以通过修改视图来解决,不会造成对访问者的影响

视图创建

创建视图

CREATE [OR REPLACE] VIEW 视图名称 [(列名列表)] AS 查询语句 [WITH [CASCADED | LOCAL] CHECK OPTION];WITH [CASCADED | LOCAL] CHECK OPTION决定了是否允许更新数据使记录不再满足视图的条件:- LOCAL:只要满足本视图的条件就可以更新

- CASCADED:必须满足所有针对该视图的所有视图的条件才可以更新, 默认值

例如

-- 数据准备 city id NAME cid 1 深圳 1 2 上海 1 3 纽约 2 4 莫斯科 3-- 数据准备 country id NAME 1 中国 2 美国 3 俄罗斯-- 创建city_country视图,保存城市和国家的信息(使用指定列名) CREATE VIEW city_country (city_id,city_name,country_name) ASSELECTc1.id,c1.name,c2.nameFROMcity c1,country c2WHEREc1.cid=c2.id;

视图查询

查询所有数据表,视图也会查询出来

SHOW TABLES; SHOW TABLE STATUS [\G];查询视图

SELECT * FROM 视图名称;查询某个视图创建

SHOW CREATE VIEW 视图名称;

视图修改

视图表数据修改,会自动修改源表中的数据,因为更新的是视图中的基表中的数据

修改视图表中的数据

UPDATE 视图名称 SET 列名 = 值 WHERE 条件;修改视图的结构

ALTER [ALGORITHM = {UNDEFINED | MERGE | TEMPTABLE}] VIEW 视图名称 [(列名列表)] AS 查询语句 [WITH [CASCADED | LOCAL] CHECK OPTION]-- 将视图中的country_name修改为name ALTER VIEW city_country (city_id,city_name,name) ASSELECTc1.id,c1.name,c2.nameFROMcity c1,country c2WHEREc1.cid=c2.id;

视图删除

删除视图

DROP VIEW 视图名称;如果存在则删除

DROP VIEW IF EXISTS 视图名称;

存储过程

基本介绍

存储过程和函数:存储过程和函数是事先经过编译并存储在数据库中的一段 SQL 语句的集合

存储过程和函数的好处:

- 提高代码的复用性

- 减少数据在数据库和应用服务器之间的传输,提高传输效率

- 减少代码层面的业务处理

- 一次编译永久有效

存储过程和函数的区别:

- 存储函数必须有返回值

- 存储过程可以没有返回值

基本操作

DELIMITER:

DELIMITER 关键字用来声明 sql 语句的分隔符,告诉 MySQL 该段命令已经结束

MySQL 语句默认的分隔符是分号,但是有时需要一条功能 sql 语句中包含分号,但是并不作为结束标识,这时使用 DELIMITER 来指定分隔符:

DELIMITER 分隔符

存储过程的创建调用查看和删除:

创建存储过程

-- 修改分隔符为$ DELIMITER $-- 标准语法 CREATE PROCEDURE 存储过程名称(参数...) BEGINsql语句; END$-- 修改分隔符为分号 DELIMITER ;调用存储过程

CALL 存储过程名称(实际参数);查看存储过程

SELECT * FROM mysql.proc WHERE db='数据库名称';删除存储过程

DROP PROCEDURE [IF EXISTS] 存储过程名称;

练习:

数据准备

id NAME age gender score 1 张三 23 男 95 2 李四 24 男 98 3 王五 25 女 100 4 赵六 26 女 90创建 stu_group() 存储过程,封装分组查询总成绩,并按照总成绩升序排序的功能

DELIMITER $CREATE PROCEDURE stu_group() BEGINSELECT gender,SUM(score) getSum FROM student GROUP BY gender ORDER BY getSum ASC; END$DELIMITER ;-- 调用存储过程 CALL stu_group(); -- 删除存储过程 DROP PROCEDURE IF EXISTS stu_group;

存储语法

变量使用

存储过程是可以进行编程的,意味着可以使用变量、表达式、条件控制语句等,来完成比较复杂的功能

定义变量:DECLARE 定义的是局部变量,只能用在 BEGIN END 范围之内

DECLARE 变量名 数据类型 [DEFAULT 默认值];变量的赋值

SET 变量名 = 变量值; SELECT 列名 INTO 变量名 FROM 表名 [WHERE 条件];数据准备:表 student

id NAME age gender score 1 张三 23 男 95 2 李四 24 男 98 3 王五 25 女 100 4 赵六 26 女 90定义两个 int 变量,用于存储男女同学的总分数

DELIMITER $ CREATE PROCEDURE pro_test3() BEGIN-- 定义两个变量DECLARE men,women INT;-- 查询男同学的总分数,为men赋值SELECT SUM(score) INTO men FROM student WHERE gender='男';-- 查询女同学的总分数,为women赋值SELECT SUM(score) INTO women FROM student WHERE gender='女';-- 使用变量SELECT men,women; END$ DELIMITER ; -- 调用存储过程 CALL pro_test3();

IF语句

if 语句标准语法

IF 判断条件1 THEN 执行的sql语句1; [ELSEIF 判断条件2 THEN 执行的sql语句2;] ... [ELSE 执行的sql语句n;] END IF;数据准备:表 student

id NAME age gender score 1 张三 23 男 95 2 李四 24 男 98 3 王五 25 女 100 4 赵六 26 女 90根据总成绩判断:全班 380 分及以上学习优秀、320 ~ 380 学习良好、320 以下学习一般

DELIMITER $ CREATE PROCEDURE pro_test4() BEGINDECLARE total INT; -- 定义总分数变量DECLARE description VARCHAR(10); -- 定义分数描述变量SELECT SUM(score) INTO total FROM student; -- 为总分数变量赋值-- 判断总分数IF total >= 380 THENSET description = '学习优秀';ELSEIF total >=320 AND total < 380 THENSET description = '学习良好';ELSESET description = '学习一般';END IF; END$ DELIMITER ; -- 调用pro_test4存储过程 CALL pro_test4();

参数传递

参数传递的语法

IN:代表输入参数,需要由调用者传递实际数据,默认的

OUT:代表输出参数,该参数可以作为返回值

INOUT:代表既可以作为输入参数,也可以作为输出参数DELIMITER $-- 标准语法 CREATE PROCEDURE 存储过程名称([IN|OUT|INOUT] 参数名 数据类型) BEGIN执行的sql语句; END$DELIMITER ;输入总成绩变量,代表学生总成绩,输出分数描述变量,代表学生总成绩的描述

DELIMITER $CREATE PROCEDURE pro_test6(IN total INT, OUT description VARCHAR(10)) BEGIN-- 判断总分数IF total >= 380 THEN SET description = '学习优秀';ELSEIF total >= 320 AND total < 380 THEN SET description = '学习不错';ELSE SET description = '学习一般';END IF; END$DELIMITER ; -- 调用pro_test6存储过程 CALL pro_test6(310,@description); CALL pro_test6((SELECT SUM(score) FROM student), @description); -- 查询总成绩描述 SELECT @description;查看参数方法

- @变量名 : 用户会话变量,代表整个会话过程他都是有作用的,类似于全局变量

- @@变量名 : 系统变量

CASE

标准语法 1

CASE 表达式WHEN 值1 THEN 执行sql语句1;[WHEN 值2 THEN 执行sql语句2;]...[ELSE 执行sql语句n;] END CASE;标准语法 2

sCASEWHEN 判断条件1 THEN 执行sql语句1;[WHEN 判断条件2 THEN 执行sql语句2;]...[ELSE 执行sql语句n;] END CASE;演示

DELIMITER $ CREATE PROCEDURE pro_test7(IN total INT) BEGIN-- 定义变量DECLARE description VARCHAR(10);-- 使用case判断CASEWHEN total >= 380 THENSET description = '学习优秀';WHEN total >= 320 AND total < 380 THENSET description = '学习不错';ELSE SET description = '学习一般';END CASE;-- 查询分数描述信息SELECT description; END$ DELIMITER ; -- 调用pro_test7存储过程 CALL pro_test7(390); CALL pro_test7((SELECT SUM(score) FROM student));

WHILE

while 循环语法

WHILE 条件判断语句 DO循环体语句;条件控制语句; END WHILE;计算 1~100 之间的偶数和

DELIMITER $ CREATE PROCEDURE pro_test6() BEGIN-- 定义求和变量DECLARE result INT DEFAULT 0;-- 定义初始化变量DECLARE num INT DEFAULT 1;-- while循环WHILE num <= 100 DOIF num % 2 = 0 THENSET result = result + num;END IF;SET num = num + 1;END WHILE;-- 查询求和结果SELECT result; END$ DELIMITER ;-- 调用pro_test6存储过程 CALL pro_test6();

REPEAT

repeat 循环标准语法

初始化语句; REPEAT循环体语句;条件控制语句;UNTIL 条件判断语句 END REPEAT;计算 1~10 之间的和

DELIMITER $ CREATE PROCEDURE pro_test9() BEGIN-- 定义求和变量DECLARE result INT DEFAULT 0;-- 定义初始化变量DECLARE num INT DEFAULT 1;-- repeat循环REPEAT-- 累加SET result = result + num;-- 让num+1SET num = num + 1;-- 停止循环UNTIL num > 10END REPEAT;-- 查询求和结果SELECT result; END$DELIMITER ; -- 调用pro_test9存储过程 CALL pro_test9();

LOOP

LOOP 实现简单的循环,退出循环的条件需要使用其他的语句定义,通常可以使用 LEAVE 语句实现,如果不加退出循环的语句,那么就变成了死循环

loop 循环标准语法

[循环名称:] LOOP条件判断语句[LEAVE 循环名称;]循环体语句;条件控制语句; END LOOP 循环名称;计算 1~10 之间的和

DELIMITER $ CREATE PROCEDURE pro_test10() BEGIN-- 定义求和变量DECLARE result INT DEFAULT 0;-- 定义初始化变量DECLARE num INT DEFAULT 1;-- loop循环l:LOOP-- 条件成立,停止循环IF num > 10 THENLEAVE l;END IF;-- 累加SET result = result + num;-- 让num+1SET num = num + 1;END LOOP l;-- 查询求和结果SELECT result; END$ DELIMITER ; -- 调用pro_test10存储过程 CALL pro_test10();

游标

游标是用来存储查询结果集的数据类型,在存储过程和函数中可以使用光标对结果集进行循环的处理

- 游标可以遍历返回的多行结果,每次拿到一整行数据

- 简单来说游标就类似于集合的迭代器遍历

- MySQL 中的游标只能用在存储过程和函数中

游标的语法

创建游标

DECLARE 游标名称 CURSOR FOR 查询sql语句;打开游标

OPEN 游标名称;使用游标获取数据

FETCH 游标名称 INTO 变量名1,变量名2,...;关闭游标

CLOSE 游标名称;Mysql 通过一个 Error handler 声明来判断指针是否到尾部,并且必须和创建游标的 SQL 语句声明在一起:

DECLARE EXIT HANDLER FOR NOT FOUND (do some action,一般是设置标志变量)

游标的基本使用

数据准备:表 student

id NAME age gender score 1 张三 23 男 95 2 李四 24 男 98 3 王五 25 女 100 4 赵六 26 女 90创建 stu_score 表

CREATE TABLE stu_score(id INT PRIMARY KEY AUTO_INCREMENT,score INT );将student表中所有的成绩保存到stu_score表中

DELIMITER $CREATE PROCEDURE pro_test12() BEGIN-- 定义成绩变量DECLARE s_score INT;-- 定义标记变量DECLARE flag INT DEFAULT 0;-- 创建游标,查询所有学生成绩数据DECLARE stu_result CURSOR FOR SELECT score FROM student;-- 游标结束后,将标记变量改为1 这两个必须声明在一起DECLARE EXIT HANDLER FOR NOT FOUND SET flag = 1;-- 开启游标OPEN stu_result;-- 循环使用游标REPEAT-- 使用游标,遍历结果,拿到数据FETCH stu_result INTO s_score;-- 将数据保存到stu_score表中INSERT INTO stu_score VALUES (NULL,s_score);UNTIL flag=1END REPEAT;-- 关闭游标CLOSE stu_result; END$DELIMITER ;-- 调用pro_test12存储过程 CALL pro_test12(); -- 查询stu_score表 SELECT * FROM stu_score;

存储函数

存储函数和存储过程是非常相似的,存储函数可以做的事情,存储过程也可以做到

存储函数有返回值,存储过程没有返回值(参数的 out 其实也相当于是返回数据了)

创建存储函数

DELIMITER $ -- 标准语法 CREATE FUNCTION 函数名称(参数 数据类型) RETURNS 返回值类型 BEGIN执行的sql语句;RETURN 结果; END$DELIMITER ;调用存储函数,因为有返回值,所以使用 SELECT 调用

SELECT 函数名称(实际参数);删除存储函数

DROP FUNCTION 函数名称;定义存储函数,获取学生表中成绩大于95分的学生数量

DELIMITER $ CREATE FUNCTION fun_test() RETURN INT BEGIN-- 定义统计变量DECLARE result INT;-- 查询成绩大于95分的学生数量,给统计变量赋值SELECT COUNT(score) INTO result FROM student WHERE score > 95;-- 返回统计结果SELECT result; END DELIMITER ; -- 调用fun_test存储函数 SELECT fun_test();

触发器

基本介绍

触发器是与表有关的数据库对象,在 insert/update/delete 之前或之后触发并执行触发器中定义的 SQL 语句

- 触发器的这种特性可以协助应用在数据库端确保数据的完整性 、日志记录 、数据校验等操作

- 使用别名 NEW 和 OLD 来引用触发器中发生变化的记录内容,这与其他的数据库是相似的

- 现在触发器还只支持行级触发,不支持语句级触发

| 触发器类型 | OLD的含义 | NEW的含义 |

|---|---|---|

| INSERT 型触发器 | 无 (因为插入前状态无数据) | NEW 表示将要或者已经新增的数据 |

| UPDATE 型触发器 | OLD 表示修改之前的数据 | NEW 表示将要或已经修改后的数据 |

| DELETE 型触发器 | OLD 表示将要或者已经删除的数据 | 无 (因为删除后状态无数据) |

基本操作

创建触发器

DELIMITER $CREATE TRIGGER 触发器名称 BEFORE|AFTER INSERT|UPDATE|DELETE ON 表名 [FOR EACH ROW] -- 行级触发器 BEGIN触发器要执行的功能; END$DELIMITER ;查看触发器的状态、语法等信息

SHOW TRIGGERS;删除触发器,如果没有指定 schema_name,默认为当前数据库

DROP TRIGGER [schema_name.]trigger_name;

触发演示

通过触发器记录账户表的数据变更日志。包含:增加、修改、删除

数据准备

-- 创建db9数据库 CREATE DATABASE db9; -- 使用db9数据库 USE db9;-- 创建账户表account CREATE TABLE account(id INT PRIMARY KEY AUTO_INCREMENT, -- 账户idNAME VARCHAR(20), -- 姓名money DOUBLE -- 余额 ); -- 添加数据 INSERT INTO account VALUES (NULL,'张三',1000),(NULL,'李四',2000);-- 创建日志表account_log CREATE TABLE account_log(id INT PRIMARY KEY AUTO_INCREMENT, -- 日志idoperation VARCHAR(20), -- 操作类型 (insert update delete)operation_time DATETIME, -- 操作时间operation_id INT, -- 操作表的idoperation_params VARCHAR(200) -- 操作参数 );创建 INSERT 型触发器

DELIMITER $CREATE TRIGGER account_insert AFTER INSERT ON account FOR EACH ROW BEGININSERT INTO account_log VALUES (NULL,'INSERT',NOW(),new.id,CONCAT('插入后{id=',new.id,',name=',new.name,',money=',new.money,'}')); END$DELIMITER ;-- 向account表添加记录 INSERT INTO account VALUES (NULL,'王五',3000);-- 查询日志表 SELECT * FROM account_log; /* id operation operation_time operation_id operation_params 1 INSERT 2021-01-26 19:51:11 3 插入后{id=3,name=王五money=2000} */创建 UPDATE 型触发器

DELIMITER $CREATE TRIGGER account_update AFTER UPDATE ON account FOR EACH ROW BEGININSERT INTO account_log VALUES (NULL,'UPDATE',NOW(),new.id,CONCAT('修改前{id=',old.id,',name=',old.name,',money=',old.money,'}','修改后{id=',new.id,',name=',new.name,',money=',new.money,'}')); END$DELIMITER ;-- 修改account表 UPDATE account SET money=3500 WHERE id=3;-- 查询日志表 SELECT * FROM account_log; /* id operation operation_time operation_id operation_params 2 UPDATE 2021-01-26 19:58:54 2 更新前{id=2,name=李四money=1000}更新后{id=2,name=李四money=200} */创建 DELETE 型触发器

DELIMITER $CREATE TRIGGER account_delete AFTER DELETE ON account FOR EACH ROW BEGININSERT INTO account_log VALUES (NULL,'DELETE',NOW(),old.id,CONCAT('删除前{id=',old.id,',name=',old.name,',money=',old.money,'}')); END$DELIMITER ;-- 删除account表数据 DELETE FROM account WHERE id=3;-- 查询日志表 SELECT * FROM account_log; /* id operation operation_time operation_id operation_params 3 DELETE 2021-01-26 20:02:48 3 删除前{id=3,name=王五money=2000} */

存储引擎

基本介绍

对比其他数据库,MySQL 的架构可以在不同场景应用并发挥良好作用,主要体现在存储引擎,插件式的存储引擎架构将查询处理和其他的系统任务以及数据的存储提取分离,可以针对不同的存储需求可以选择最优的存储引擎

存储引擎的介绍:

- MySQL 数据库使用不同的机制存取表文件 , 机制的差别在于不同的存储方式、索引技巧、锁定水平等不同的功能和能力,在 MySQL 中,将这些不同的技术及配套的功能称为存储引擎

- Oracle、SqlServer 等数据库只有一种存储引擎,MySQL 提供了插件式的存储引擎架构,所以 MySQL 存在多种存储引擎 , 就会让数据库采取了不同的处理数据的方式和扩展功能

- 在关系型数据库中数据的存储是以表的形式存进行,所以存储引擎也称为表类型(存储和操作此表的类型)

- 通过选择不同的引擎,能够获取最佳的方案, 也能够获得额外的速度或者功能,提高程序的整体效果。

MySQL 支持的存储引擎:

- MySQL 支持的引擎包括:InnoDB、MyISAM、MEMORY、Archive、Federate、CSV、BLACKHOLE 等

- MySQL5.5 之前的默认存储引擎是 MyISAM,5.5 之后就改为了 InnoDB

引擎对比

MyISAM 存储引擎:

- 特点:不支持事务和外键,读取速度快,节约资源

- 应用场景:适用于读多写少的场景,对事务的完整性要求不高,比如一些数仓、离线数据、支付宝的年度总结之类的场景,业务进行只读操作,查询起来会更快

- 存储方式:

- 每个 MyISAM 在磁盘上存储成 3 个文件,其文件名都和表名相同,拓展名不同

- 表的定义保存在 .frm 文件,表数据保存在 .MYD (MYData) 文件中,索引保存在 .MYI (MYIndex) 文件中

InnoDB 存储引擎:(MySQL5.5 版本后默认的存储引擎)

- 特点:支持事务和外键操作,支持并发控制。对比 MyISAM 的存储引擎,InnoDB 写的处理效率差一些,并且会占用更多的磁盘空间以保留数据和索引

- 应用场景:对事务的完整性有比较高的要求,在并发条件下要求数据的一致性,读写频繁的操作

- 存储方式:

- 使用共享表空间存储, 这种方式创建的表的表结构保存在 .frm 文件中, 数据和索引保存在 innodb_data_home_dir 和 innodb_data_file_path 定义的表空间中,可以是多个文件

- 使用多表空间存储,创建的表的表结构存在 .frm 文件中,每个表的数据和索引单独保存在 .ibd 中

MEMORY 存储引擎:

- 特点:每个 MEMORY 表实际对应一个磁盘文件 ,该文件中只存储表的结构,表数据保存在内存中,且默认使用 HASH 索引,所以数据默认就是无序的,但是在需要快速定位记录可以提供更快的访问,服务一旦关闭,表中的数据就会丢失,存储不安全

- 应用场景:缓存型存储引擎,通常用于更新不太频繁的小表,用以快速得到访问结果

- 存储方式:表结构保存在 .frm 中

MERGE 存储引擎:

特点:

- 是一组 MyISAM 表的组合,这些 MyISAM 表必须结构完全相同,通过将不同的表分布在多个磁盘上

- MERGE 表本身并没有存储数据,对 MERGE 类型的表可以进行查询、更新、删除操作,这些操作实际上是对内部的 MyISAM 表进行的

应用场景:将一系列等同的 MyISAM 表以逻辑方式组合在一起,并作为一个对象引用他们,适合做数据仓库

操作方式:

- 插入操作是通过 INSERT_METHOD 子句定义插入的表,使用 FIRST 或 LAST 值使得插入操作被相应地作用在第一或者最后一个表上;不定义这个子句或者定义为 NO,表示不能对 MERGE 表执行插入操作

- 对 MERGE 表进行 DROP 操作,但是这个操作只是删除 MERGE 表的定义,对内部的表是没有任何影响的

CREATE TABLE order_1( )ENGINE = MyISAM DEFAULT CHARSET=utf8;CREATE TABLE order_2( )ENGINE = MyISAM DEFAULT CHARSET=utf8;CREATE TABLE order_all(-- 结构与MyISAM表相同 )ENGINE = MERGE UNION = (order_1,order_2) INSERT_METHOD=LAST DEFAULT CHARSET=utf8;

| 特性 | MyISAM | InnoDB | MEMORY |

|---|---|---|---|

| 存储限制 | 有(平台对文件系统大小的限制) | 64TB | 有(平台的内存限制) |

| 事务安全 | 不支持 | 支持 | 不支持 |

| 锁机制 | 表锁 | 表锁/行锁 | 表锁 |

| B+Tree 索引 | 支持 | 支持 | 支持 |

| 哈希索引 | 不支持 | 不支持 | 支持 |

| 全文索引 | 支持 | 支持 | 不支持 |

| 集群索引 | 不支持 | 支持 | 不支持 |

| 数据索引 | 不支持 | 支持 | 支持 |

| 数据缓存 | 不支持 | 支持 | N/A |

| 索引缓存 | 支持 | 支持 | N/A |

| 数据可压缩 | 支持 | 不支持 | 不支持 |

| 空间使用 | 低 | 高 | N/A |

| 内存使用 | 低 | 高 | 中等 |

| 批量插入速度 | 高 | 低 | 高 |

| 外键 | 不支持 | 支持 | 不支持 |

只读场景 MyISAM 比 InnoDB 更快:

- 底层存储结构有差别,MyISAM 是非聚簇索引,叶子节点保存的是数据的具体地址,不用回表查询

- InnoDB 每次查询需要维护 MVCC 版本状态,保证并发状态下的读写冲突问题

引擎操作

查询数据库支持的存储引擎

SHOW ENGINES; SHOW VARIABLES LIKE '%storage_engine%'; -- 查看Mysql数据库默认的存储引擎查询某个数据库中所有数据表的存储引擎

SHOW TABLE STATUS FROM 数据库名称;查询某个数据库中某个数据表的存储引擎

SHOW TABLE STATUS FROM 数据库名称 WHERE NAME = '数据表名称';创建数据表,指定存储引擎

CREATE TABLE 表名(列名,数据类型,... )ENGINE = 引擎名称;修改数据表的存储引擎

ALTER TABLE 表名 ENGINE = 引擎名称;

索引机制

索引介绍

基本介绍

MySQL 官方对索引的定义为:索引(index)是帮助 MySQL 高效获取数据的一种数据结构,**本质是排好序的快速查找数据结构。**在表数据之外,数据库系统还维护着满足特定查找算法的数据结构,这些数据结构以某种方式指向数据, 这样就可以在这些数据结构上实现高级查找算法,这种数据结构就是索引

索引是在存储引擎层实现的,所以并没有统一的索引标准,即不同存储引擎的索引的工作方式并不一样

索引使用:一张数据表,用于保存数据;一个索引配置文件,用于保存索引;每个索引都指向了某一个数据

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-9nO70O1F-1686862213565)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-索引的介绍.png)]

左边是数据表,一共有两列七条记录,最左边的是数据记录的物理地址(注意逻辑上相邻的记录在磁盘上也并不是一定物理相邻的)。为了加快 Col2 的查找,可以维护一个右边所示的二叉查找树,每个节点分别包含索引键值和一个指向对应数据的物理地址的指针,这样就可以运用二叉查找快速获取到相应数据

索引的优点:

- 类似于书籍的目录索引,提高数据检索的效率,降低数据库的 IO 成本

- 通过索引列对数据进行排序,降低数据排序的成本,降低 CPU 的消耗

索引的缺点:

- 一般来说索引本身也很大,不可能全部存储在内存中,因此索引往往以索引文件的形式存储在磁盘上

- 虽然索引大大提高了查询效率,同时却也降低更新表的速度。对表进行 INSERT、UPDATE、DELETE 操作,MySQL 不仅要保存数据,还要保存一下索引文件每次更新添加了索引列的字段,还会调整因为更新所带来的键值变化后的索引信息,但是更新数据也需要先从数据库中获取,索引加快了获取速度,所以可以相互抵消一下。

- 索引会影响到 WHERE 的查询条件和排序 ORDER BY 两大功能

索引分类

索引一般的分类如下:

功能分类

- 主键索引:一种特殊的唯一索引,不允许有空值,一般在建表时同时创建主键索引

- 单列索引:一个索引只包含单个列,一个表可以有多个单列索引(普通索引)

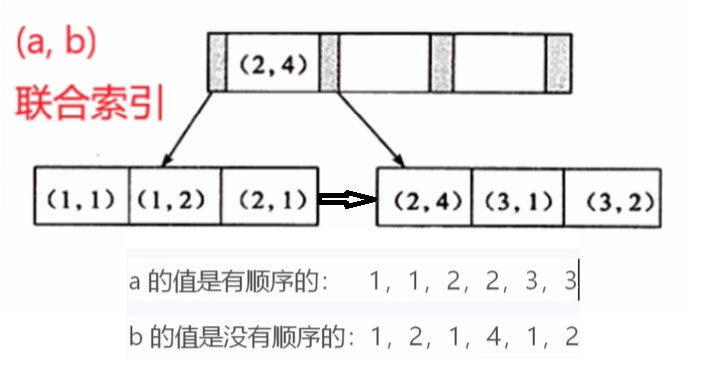

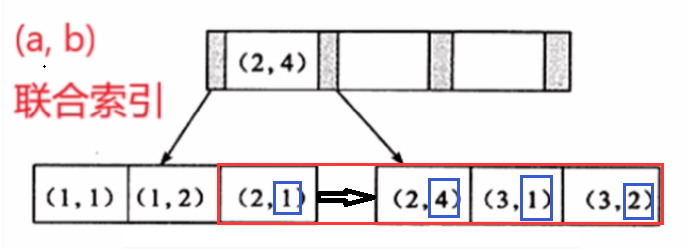

- 联合索引:顾名思义,就是将单列索引进行组合

- 唯一索引:索引列的值必须唯一,允许有空值,如果是联合索引,则列值组合必须唯一

- NULL 值可以出现多次,因为两个 NULL 比较的结果既不相等,也不不等,结果仍然是未知

- 可以声明不允许存储 NULL 值的非空唯一索引

- 外键索引:只有 InnoDB 引擎支持外键索引,用来保证数据的一致性、完整性和实现级联操作

结构分类

- BTree 索引:MySQL 使用最频繁的一个索引数据结构,是 InnoDB 和 MyISAM 存储引擎默认的索引类型,底层基于 B+Tree

- Hash 索引:MySQL中 Memory 存储引擎默认支持的索引类型

- R-tree 索引(空间索引):空间索引是 MyISAM 引擎的一个特殊索引类型,主要用于地理空间数据类型

- Full-text 索引(全文索引):快速匹配全部文档的方式。MyISAM 支持, InnoDB 不支持 FULLTEXT 类型的索引,但是 InnoDB 可以使用 sphinx 插件支持全文索引,MEMORY 引擎不支持

索引 InnoDB MyISAM Memory BTREE 支持 支持 支持 HASH 不支持 不支持 支持 R-tree 不支持 支持 不支持 Full-text 5.6 版本之后支持 支持 不支持

联合索引图示:根据身高年龄建立的组合索引(height、age)

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-eouAm64u-1686862213566)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-组合索引图.png)]

索引操作

索引在创建表的时候可以同时创建, 也可以随时增加新的索引

创建索引:如果一个表中有一列是主键,那么会默认为其创建主键索引(主键列不需要单独创建索引)

CREATE [UNIQUE|FULLTEXT] INDEX 索引名称 [USING 索引类型] ON 表名(列名...); -- 索引类型默认是 B+TREE查看索引

SHOW INDEX FROM 表名;添加索引

-- 单列索引 ALTER TABLE 表名 ADD INDEX 索引名称(列名);-- 组合索引 ALTER TABLE 表名 ADD INDEX 索引名称(列名1,列名2,...);-- 主键索引 ALTER TABLE 表名 ADD PRIMARY KEY(主键列名); -- 外键索引(添加外键约束,就是外键索引) ALTER TABLE 表名 ADD CONSTRAINT 外键名 FOREIGN KEY (本表外键列名) REFERENCES 主表名(主键列名);-- 唯一索引 ALTER TABLE 表名 ADD UNIQUE 索引名称(列名);-- 全文索引(mysql只支持文本类型) ALTER TABLE 表名 ADD FULLTEXT 索引名称(列名);删除索引

DROP INDEX 索引名称 ON 表名;案例练习

数据准备:student

id NAME age score 1 张三 23 99 2 李四 24 95 3 王五 25 98 4 赵六 26 97索引操作:

-- 为student表中姓名列创建一个普通索引 CREATE INDEX idx_name ON student(NAME);-- 为student表中年龄列创建一个唯一索引 CREATE UNIQUE INDEX idx_age ON student(age);

聚簇索引

索引对比

聚簇索引是一种数据存储方式,并不是一种单独的索引类型

聚簇索引的叶子节点存放的是主键值和数据行,支持覆盖索引

非聚簇索引的叶子节点存放的是主键值或指向数据行的指针(由存储引擎决定)

在 Innodb 下主键索引是聚簇索引,在 MyISAM 下主键索引是非聚簇索引

Innodb

聚簇索引

在 Innodb 存储引擎,B+ 树索引可以分为聚簇索引(也称聚集索引、clustered index)和辅助索引(也称非聚簇索引或二级索引、secondary index、non-clustered index)

InnoDB 中,聚簇索引是按照每张表的主键构造一颗 B+ 树,叶子节点中存放的就是整张表的数据,将聚簇索引的叶子节点称为数据页

- 这个特性决定了数据也是索引的一部分,所以一张表只能有一个聚簇索引

- 辅助索引的存在不影响聚簇索引中数据的组织,所以一张表可以有多个辅助索引

聚簇索引的优点:

- 数据访问更快,聚簇索引将索引和数据保存在同一个 B+ 树中,因此从聚簇索引中获取数据比非聚簇索引更快

- 聚簇索引对于主键的排序查找和范围查找速度非常快

聚簇索引的缺点:

插入速度严重依赖于插入顺序,按照主键的顺序(递增)插入是最快的方式,否则将会出现页分裂,严重影响性能,所以对于 InnoDB 表,一般都会定义一个自增的 ID 列为主键

更新主键的代价很高,将会导致被更新的行移动,所以对于 InnoDB 表,一般定义主键为不可更新

二级索引访问需要两次索引查找,第一次找到主键值,第二次根据主键值找到行数据

辅助索引

在聚簇索引之上创建的索引称之为辅助索引,非聚簇索引都是辅助索引,像复合索引、前缀索引、唯一索引等

辅助索引叶子节点存储的是主键值,而不是数据的物理地址,所以访问数据需要二次查找,推荐使用覆盖索引,可以减少回表查询

检索过程:辅助索引找到主键值,再通过聚簇索引(二分)找到数据页,最后通过数据页中的 Page Directory(二分)找到对应的数据分组,遍历组内所所有的数据找到数据行

补充:无索引走全表查询,查到数据页后和上述步骤一致

索引实现

InnoDB 使用 B+Tree 作为索引结构,并且 InnoDB 一定有索引

主键索引:

在 InnoDB 中,表数据文件本身就是按 B+Tree 组织的一个索引结构,这个索引的 key 是数据表的主键,叶子节点 data 域保存了完整的数据记录

InnoDB 的表数据文件通过主键聚集数据,如果没有定义主键,会选择非空唯一索引代替,如果也没有这样的列,MySQL 会自动为 InnoDB 表生成一个隐含字段 row_id 作为主键,这个字段长度为 6 个字节,类型为长整形

辅助索引:

InnoDB 的所有辅助索引(二级索引)都引用主键作为 data 域

InnoDB 表是基于聚簇索引建立的,因此 InnoDB 的索引能提供一种非常快速的主键查找性能。不过辅助索引也会包含主键列,所以不建议使用过长的字段作为主键,过长的主索引会令辅助索引变得过大

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-xMLe13Cs-1686862213566)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-InnoDB聚簇和辅助索引结构.png)]

MyISAM

非聚簇

MyISAM 的主键索引使用的是非聚簇索引,索引文件和数据文件是分离的,索引文件仅保存数据的地址

- 主键索引 B+ 树的节点存储了主键,辅助键索引 B+ 树存储了辅助键,表数据存储在独立的地方,这两颗 B+ 树的叶子节点都使用一个地址指向真正的表数据,对于表数据来说,这两个键没有任何差别

- 由于索引树是独立的,通过辅助索引检索无需回表查询访问主键的索引树

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-1tdf2QrK-1686862213567)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-聚簇索引和辅助索引检锁数据图.jpg)]

索引实现

MyISAM 的索引方式也叫做非聚集的,之所以这么称呼是为了与 InnoDB 的聚集索引区分

主键索引:MyISAM 引擎使用 B+Tree 作为索引结构,叶节点的 data 域存放的是数据记录的地址

辅助索引:MyISAM 中主索引和辅助索引(Secondary key)在结构上没有任何区别,只是主索引要求 key 是唯一的,而辅助索引的 key 可以重复

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-QfQ8VvjM-1686862213567)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-MyISAM主键和辅助索引结构.png)]

参考文章:https://blog.csdn.net/lm1060891265/article/details/81482136

索引结构

数据页

文件系统的最小单元是块(block),一个块的大小是 4K,系统从磁盘读取数据到内存时是以磁盘块为基本单位的,位于同一个磁盘块中的数据会被一次性读取出来,而不是需要什么取什么

InnoDB 存储引擎中有页(Page)的概念,页是 MySQL 磁盘管理的最小单位

- InnoDB 存储引擎中默认每个页的大小为 16KB,索引中一个节点就是一个数据页,所以会一次性读取 16KB 的数据到内存

- InnoDB 引擎将若干个地址连接磁盘块,以此来达到页的大小 16KB

- 在查询数据时如果一个页中的每条数据都能有助于定位数据记录的位置,这将会减少磁盘 I/O 次数,提高查询效率

超过 16KB 的一条记录,主键索引页只会存储部分数据和指向溢出页的指针,剩余数据都会分散存储在溢出页中

数据页物理结构,从上到下:

- File Header:上一页和下一页的指针、该页的类型(索引页、数据页、日志页等)、校验和、LSN(最近一次修改当前页面时的系统 lsn 值,事务持久性部分详解)等信息

- Page Header:记录状态信息

- Infimum + Supremum:当前页的最小记录和最大记录(头尾指针),Infimum 所在分组只有一条记录,Supremum 所在分组可以有 1 ~ 8 条记录,剩余的分组可以有 4 ~ 8 条记录

- User Records:存储数据的记录

- Free Space:尚未使用的存储空间

- Page Directory:分组的目录,可以通过目录快速定位(二分法)数据的分组

- File Trailer:检验和字段,在刷脏过程中,页首和页尾的校验和一致才能说明页面刷新成功,二者不同说明刷新期间发生了错误;LSN 字段,也是用来校验页面的完整性

数据页中包含数据行,数据的存储是基于数据行的,数据行有 next_record 属性指向下一个行数据,所以是可以遍历的,但是一组数据至多 8 个行,通过 Page Directory 先定位到组,然后遍历获取所需的数据行即可

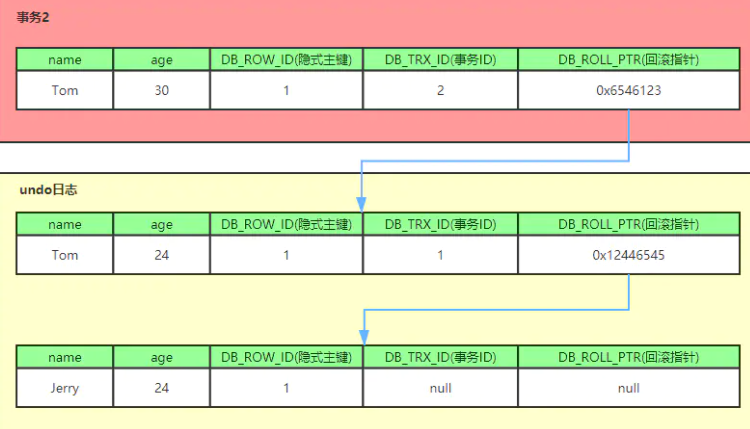

数据行中有三个隐藏字段:trx_id、roll_pointer、row_id(在事务章节会详细介绍它们的作用)

BTree

BTree 的索引类型是基于 B+Tree 树型数据结构的,B+Tree 又是 BTree 数据结构的变种,用在数据库和操作系统中的文件系统,特点是能够保持数据稳定有序

BTree 又叫多路平衡搜索树,一颗 m 叉的 BTree 特性如下:

- 树中每个节点最多包含 m 个孩子

- 除根节点与叶子节点外,每个节点至少有 [ceil(m/2)] 个孩子

- 若根节点不是叶子节点,则至少有两个孩子

- 所有的叶子节点都在同一层

- 每个非叶子节点由 n 个 key 与 n+1 个指针组成,其中 [ceil(m/2)-1] <= n <= m-1

5 叉,key 的数量 [ceil(m/2)-1] <= n <= m-1 为 2 <= n <=4 ,当 n>4 时中间节点分裂到父节点,两边节点分裂

插入 C N G A H E K Q M F W L T Z D P R X Y S 数据的工作流程:

插入前 4 个字母 C N G A

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-1SpcPROj-1686862213568)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-BTree工作流程1.png)]

插入 H,n>4,中间元素 G 字母向上分裂到新的节点

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-IljUpHlF-1686862213568)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-BTree工作流程2.png)]

插入 E、K、Q 不需要分裂

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Y70sTEwQ-1686862213569)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-BTree工作流程3.png)]

插入 M,中间元素 M 字母向上分裂到父节点 G

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-4TEgt4PC-1686862213569)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-BTree工作流程4.png)]

插入 F,W,L,T 不需要分裂

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-gF9C2Ioy-1686862213570)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-BTree工作流程5.png)]

插入 Z,中间元素 T 向上分裂到父节点中

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-I8fR59tE-1686862213570)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-BTree工作流程6.png)]

插入 D,中间元素 D 向上分裂到父节点中,然后插入 P,R,X,Y 不需要分裂

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-G9q09J6Y-1686862213570)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-BTree工作流程7.png)]

最后插入 S,NPQR 节点 n>5,中间节点 Q 向上分裂,但分裂后父节点 DGMT 的 n>5,中间节点 M 向上分裂

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-C8VcangS-1686862213571)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-BTree工作流程8.png)]

BTree 树就已经构建完成了,BTree 树和二叉树相比, 查询数据的效率更高, 因为对于相同的数据量来说,BTree 的层级结构比二叉树少,所以搜索速度快

BTree 结构的数据可以让系统高效的找到数据所在的磁盘块,定义一条记录为一个二元组 [key, data] ,key 为记录的键值,对应表中的主键值,data 为一行记录中除主键外的数据。对于不同的记录,key 值互不相同,BTree 中的每个节点根据实际情况可以包含大量的关键字信息和分支

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-9KA9E00q-1686862213571)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/索引的原理1.png)]

缺点:当进行范围查找时会出现回旋查找

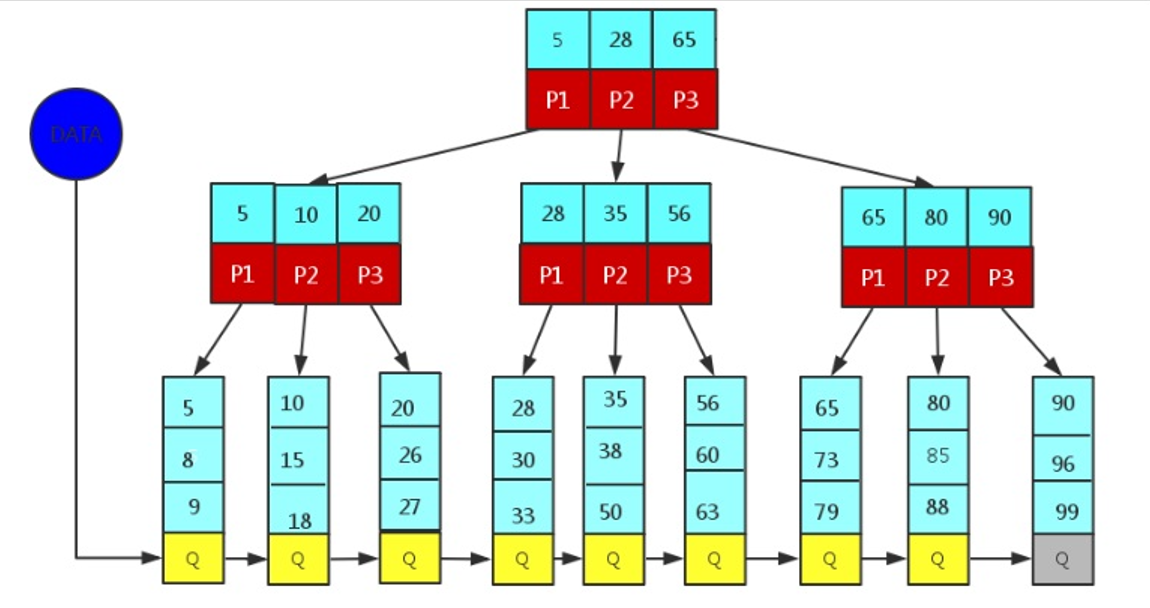

B+Tree

数据结构

BTree 数据结构中每个节点中不仅包含数据的 key 值,还有 data 值。磁盘中每一页的存储空间是有限的,如果 data 数据较大时将会导致每个节点(即一个页)能存储的 key 的数量很小,当存储的数据量很大时同样会导致 B-Tree 的深度较大,增大查询时的磁盘 I/O 次数,进而影响查询效率,所以引入 B+Tree

B+Tree 为 BTree 的变种,B+Tree 与 BTree 的区别为:

- n 叉 B+Tree 最多含有 n 个 key(哈希值),而 BTree 最多含有 n-1 个 key

- 所有非叶子节点只存储键值 key 信息,只进行数据索引,使每个非叶子节点所能保存的关键字大大增加

- 所有数据都存储在叶子节点,所以每次数据查询的次数都一样

- 叶子节点按照 key 大小顺序排列,左边结尾数据都会保存右边节点开始数据的指针,形成一个链表

- 所有节点中的 key 在叶子节点中也存在(比如 5),key 允许重复,B 树不同节点不存在重复的 key

B* 树:是 B+ 树的变体,在 B+ 树的非根和非叶子结点再增加指向兄弟的指针

优化结构

MySQL 索引数据结构对经典的 B+Tree 进行了优化,在原 B+Tree 的基础上,增加一个指向相邻叶子节点的链表指针,就形成了带有顺序指针的 B+Tree,提高区间访问的性能,防止回旋查找

区间访问的意思是访问索引为 5 - 15 的数据,可以直接根据相邻节点的指针遍历

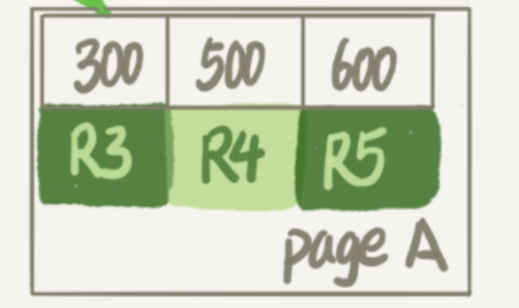

B+ 树的叶子节点是数据页(page),一个页里面可以存多个数据行

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-mDStam8w-1686862213572)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/索引的原理2.png)]

通常在 B+Tree 上有两个头指针,一个指向根节点,另一个指向关键字最小的叶子节点,而且所有叶子节点(即数据节点)之间是一种链式环结构。可以对 B+Tree 进行两种查找运算:

- 有范围:对于主键的范围查找和分页查找

- 有顺序:从根节点开始,进行随机查找,顺序查找

InnoDB 中每个数据页的大小默认是 16KB,

- 索引行:一般表的主键类型为 INT(4 字节)或 BIGINT(8 字节),指针大小在 InnoDB 中设置为 6 字节节,也就是说一个页大概存储 16KB/(8B+6B)=1K 个键值(估值)。则一个深度为 3 的 B+Tree 索引可以维护

10^3 * 10^3 * 10^3 = 10亿条记录 - 数据行:一行数据的大小可能是 1k,一个数据页可以存储 16 行

实际情况中每个节点可能不能填充满,因此在数据库中,B+Tree 的高度一般都在 2-4 层。MySQL 的 InnoDB 存储引擎在设计时是将根节点常驻内存的,也就是说查找某一键值的行记录时最多只需要 1~3 次磁盘 I/O 操作

B+Tree 优点:提高查询速度,减少磁盘的 IO 次数,树形结构较小

索引维护

B+ 树为了保持索引的有序性,在插入新值的时候需要做相应的维护

每个索引中每个块存储在磁盘页中,可能会出现以下两种情况:

- 如果所在的数据页已经满了,这时候需要申请一个新的数据页,然后挪动部分数据过去,这个过程称为页分裂,原本放在一个页的数据现在分到两个页中,降低了空间利用率

- 当相邻两个页由于删除了数据,利用率很低之后,会将数据页做页合并,合并的过程可以认为是分裂过程的逆过程

- 这两个情况都是由 B+ 树的结构决定的

一般选用数据小的字段做索引,字段长度越小,普通索引的叶子节点就越小,普通索引占用的空间也就越小

自增主键的插入数据模式,可以让主键索引尽量地保持递增顺序插入,不涉及到挪动其他记录,避免了页分裂,页分裂的目的就是保证后一个数据页中的所有行主键值比前一个数据页中主键值大

参考文章:https://developer.aliyun.com/article/919861

设计原则

索引的设计可以遵循一些已有的原则,创建索引的时候请尽量考虑符合这些原则,便于提升索引的使用效率

创建索引时的原则:

- 对查询频次较高,且数据量比较大的表建立索引

- 使用唯一索引,区分度越高,使用索引的效率越高

- 索引字段的选择,最佳候选列应当从 where 子句的条件中提取,使用覆盖索引

- 使用短索引,索引创建之后也是使用硬盘来存储的,因此提升索引访问的 I/O 效率,也可以提升总体的访问效率。假如构成索引的字段总长度比较短,那么在给定大小的存储块内可以存储更多的索引值,相应的可以有效的提升 MySQL 访问索引的 I/O 效率

- 索引可以有效的提升查询数据的效率,但索引数量不是多多益善,索引越多,维护索引的代价越高。对于插入、更新、删除等 DML 操作比较频繁的表来说,索引过多,会引入相当高的维护代价,降低 DML 操作的效率,增加相应操作的时间消耗;另外索引过多的话,MySQL 也会犯选择困难病,虽然最终仍然会找到一个可用的索引,但提高了选择的代价

MySQL 建立联合索引时会遵守最左前缀匹配原则,即最左优先,在检索数据时从联合索引的最左边开始匹配

N 个列组合而成的组合索引,相当于创建了 N 个索引,如果查询时 where 句中使用了组成该索引的前几个字段,那么这条查询 SQL 可以利用组合索引来提升查询效率

-- 对name、address、phone列建一个联合索引 ALTER TABLE user ADD INDEX index_three(name,address,phone); -- 查询语句执行时会依照最左前缀匹配原则,检索时分别会使用索引进行数据匹配。 (name,address,phone) (name,address) (name,phone) -- 只有name字段走了索引 (name)-- 索引的字段可以是任意顺序的,优化器会帮助我们调整顺序,下面的SQL语句可以命中索引 SELECT * FROM user WHERE address = '北京' AND phone = '12345' AND name = '张三';-- 如果联合索引中最左边的列不包含在条件查询中,SQL语句就不会命中索引,比如: SELECT * FROM user WHERE address = '北京' AND phone = '12345';

哪些情况不要建立索引:

- 记录太少的表

- 经常增删改的表

- 频繁更新的字段不适合创建索引

- where 条件里用不到的字段不创建索引

索引优化

覆盖索引

覆盖索引:包含所有满足查询需要的数据的索引(SELECT 后面的字段刚好是索引字段),可以利用该索引返回 SELECT 列表的字段,而不必根据索引去聚簇索引上读取数据文件

回表查询:要查找的字段不在非主键索引树上时,需要通过叶子节点的主键值去主键索引上获取对应的行数据

使用覆盖索引,防止回表查询:

表 user 主键为 id,普通索引为 age,查询语句:

SELECT * FROM user WHERE age = 30;查询过程:先通过普通索引 age=30 定位到主键值 id=1,再通过聚集索引 id=1 定位到行记录数据,需要两次扫描 B+ 树

使用覆盖索引:

DROP INDEX idx_age ON user; CREATE INDEX idx_age_name ON user(age,name); SELECT id,age FROM user WHERE age = 30;在一棵索引树上就能获取查询所需的数据,无需回表速度更快

使用覆盖索引,要注意 SELECT 列表中只取出需要的列,不可用 SELECT *,所有字段一起做索引会导致索引文件过大,查询性能下降

索引下推

索引条件下推优化(Index Condition Pushdown,ICP)是 MySQL5.6 添加,可以在索引遍历过程中,对索引中包含的字段先做判断,直接过滤掉不满足条件的记录,减少回表次数

索引下推充分利用了索引中的数据,在查询出整行数据之前过滤掉无效的数据,再去主键索引树上查找

不使用索引下推优化时存储引擎通过索引检索到数据,然后回表查询记录返回给 Server 层,服务器判断数据是否符合条件

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-NtvaWMX1-1686862213572)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-不使用索引下推.png)]

使用索引下推优化时,如果存在某些被索引的列的判断条件时,由存储引擎在索引遍历的过程中判断数据是否符合传递的条件,将符合条件的数据进行回表,检索出来返回给服务器,由此减少 IO 次数

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-wsz0Y2xs-1686862213572)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-使用索引下推.png)]

适用条件:

- 需要存储引擎将索引中的数据与条件进行判断(所以条件列必须都在同一个索引中),所以优化是基于存储引擎的,只有特定引擎可以使用,适用于 InnoDB 和 MyISAM

- 存储引擎没有调用跨存储引擎的能力,跨存储引擎的功能有存储过程、触发器、视图,所以调用这些功能的不可以进行索引下推优化

- 对于 InnoDB 引擎只适用于二级索引,InnoDB 的聚簇索引会将整行数据读到缓冲区,不再需要去回表查询了

工作过程:用户表 user,(name, age) 是联合索引

SELECT * FROM user WHERE name LIKE '张%' AND age = 10; -- 头部模糊匹配会造成索引失效

优化前:在非主键索引树上找到满足第一个条件的行,然后通过叶子节点记录的主键值再回到主键索引树上查找到对应的行数据,再对比 AND 后的条件是否符合,符合返回数据,需要 4 次回表

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-G9bLn0N8-1686862213573)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-索引下推优化1.png)]

优化后:检查索引中存储的列信息是否符合索引条件,然后交由存储引擎用剩余的判断条件判断此行数据是否符合要求,不满足条件的不去读取表中的数据,满足下推条件的就根据主键值进行回表查询,2 次回表

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-UEKlrQNK-1686862213573)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-索引下推优化2.png)]

当使用 EXPLAIN 进行分析时,如果使用了索引条件下推,Extra 会显示 Using index condition

参考文章:https://blog.csdn.net/sinat_29774479/article/details/103470244

参考文章:https://time.geekbang.org/column/article/69636

前缀索引

当要索引的列字符很多时,索引会变大变慢,可以只索引列开始的部分字符串,节约索引空间,提高索引效率

注意:使用前缀索引就系统就忽略覆盖索引对查询性能的优化了

优化原则:降低重复的索引值

比如地区表:

area gdp code

chinaShanghai 100 aaa

chinaDalian 200 bbb

usaNewYork 300 ccc

chinaFuxin 400 ddd

chinaBeijing 500 eee

发现 area 字段很多都是以 china 开头的,那么如果以前 1-5 位字符做前缀索引就会出现大量索引值重复的情况,索引值重复性越低,查询效率也就越高,所以需要建立前 6 位字符的索引:

CREATE INDEX idx_area ON table_name(area(7));

场景:存储身份证

- 直接创建完整索引,这样可能比较占用空间

- 创建前缀索引,节省空间,但会增加查询扫描次数,并且不能使用覆盖索引

- 倒序存储,再创建前缀索引,用于绕过字符串本身前缀的区分度不够的问题(前 6 位相同的很多)

- 创建 hash 字段索引,查询性能稳定,有额外的存储和计算消耗,跟第三种方式一样,都不支持范围扫描

索引合并

使用多个索引来完成一次查询的执行方法叫做索引合并 index merge

Intersection 索引合并:

SELECT * FROM table_test WHERE key1 = 'a' AND key3 = 'b'; # key1 和 key3 列都是单列索引、二级索引从不同索引中扫描到的记录的 id 值取交集(相同 id),然后执行回表操作,要求从每个二级索引获取到的记录都是按照主键值排序

Union 索引合并:

SELECT * FROM table_test WHERE key1 = 'a' OR key3 = 'b';从不同索引中扫描到的记录的 id 值取并集,然后执行回表操作,要求从每个二级索引获取到的记录都是按照主键值排序

Sort-Union 索引合并

SELECT * FROM table_test WHERE key1 < 'a' OR key3 > 'b';先将从不同索引中扫描到的记录的主键值进行排序,再按照 Union 索引合并的方式进行查询

索引合并算法的效率并不好,通过将其中的一个索引改成联合索引会优化效率

系统优化

表优化

分区表

基本介绍

分区表是将大表的数据按分区字段分成许多小的子集,建立一个以 ftime 年份为分区的表:

CREATE TABLE `t` (`ftime` datetime NOT NULL,`c` int(11) DEFAULT NULL,KEY (`ftime`)

) ENGINE=InnoDB DEFAULT CHARSET=latin1

PARTITION BY RANGE (YEAR(ftime))

(PARTITION p_2017 VALUES LESS THAN (2017) ENGINE = InnoDB,PARTITION p_2018 VALUES LESS THAN (2018) ENGINE = InnoDB,PARTITION p_2019 VALUES LESS THAN (2019) ENGINE = InnoDB,PARTITION p_others VALUES LESS THAN MAXVALUE ENGINE = InnoDB);

INSERT INTO t VALUES('2017-4-1',1),('2018-4-1',1);-- 这两行记录分别落在 p_2018 和 p_2019 这两个分区上

这个表包含了一个.frm 文件和 4 个.ibd 文件,每个分区对应一个.ibd 文件

- 对于引擎层来说,这是 4 个表,针对每个分区表的操作不会相互影响

- 对于 Server 层来说,这是 1 个表

分区策略

打开表行为:第一次访问一个分区表时,MySQL 需要把所有的分区都访问一遍,如果分区表的数量很多,超过了 open_files_limit 参数(默认值 1024),那么就会在访问这个表时打开所有的文件,导致打开表文件的个数超过了上限而报错

通用分区策略:MyISAM 分区表使用的分区策略,每次访问分区都由 Server 层控制,在文件管理、表管理的实现上很粗糙,因此有比较严重的性能问题

本地分区策略:从 MySQL 5.7.9 开始,InnoDB 引擎内部自己管理打开分区的行为,InnoDB 引擎打开文件超过 innodb_open_files 时就会关掉一些之前打开的文件,所以即使分区个数大于 open_files_limit,也不会报错

从 MySQL 8.0 版本开始,就不允许创建 MyISAM 分区表,只允许创建已经实现了本地分区策略的引擎,目前只有 InnoDB 和 NDB 这两个引擎支持了本地分区策略

Server 层

从 Server 层看一个分区表就只是一个表

Session A:

SELECT * FROM t WHERE ftime = '2018-4-1';Session B:

ALTER TABLE t TRUNCATE PARTITION p_2017; -- blocked

现象:Session B 只操作 p_2017 分区,但是由于 Session A 持有整个表 t 的 MDL 读锁,就导致 B 的 ALTER 语句获取 MDL 写锁阻塞

分区表的特点:

- 第一次访问的时候需要访问所有分区

- 在 Server 层认为这是同一张表,因此所有分区共用同一个 MDL 锁

- 在引擎层认为这是不同的表,因此 MDL 锁之后的执行过程,会根据分区表规则,只访问需要的分区

应用场景

分区表的优点:

对业务透明,相对于用户分表来说,使用分区表的业务代码更简洁

分区表可以很方便的清理历史数据。按照时间分区的分区表,就可以直接通过

alter table t drop partition这个语法直接删除分区文件,从而删掉过期的历史数据,与使用 drop 语句删除数据相比,优势是速度快、对系统影响小

使用分区表,不建议创建太多的分区,注意事项:

- 分区并不是越细越好,单表或者单分区的数据一千万行,只要没有特别大的索引,对于现在的硬件能力来说都已经是小表

- 分区不要提前预留太多,在使用之前预先创建即可。比如是按月分区,每年年底时再把下一年度的 12 个新分区创建上即可,并且对于没有数据的历史分区,要及时的 drop 掉

参考文档:https://time.geekbang.org/column/article/82560

临时表

基本介绍

临时表分为内部临时表和用户临时表

内部临时表:系统执行 SQL 语句优化时产生的表,例如 Join 连接查询、去重查询等

用户临时表:用户主动创建的临时表

CREATE TEMPORARY TABLE temp_t like table_1;

临时表可以是内存表,也可以是磁盘表(多表操作 → 嵌套查询章节提及)

- 内存表指的是使用 Memory 引擎的表,建立哈希索引,建表语法是

create table … engine=memory,这种表的数据都保存在内存里,系统重启时会被清空,但是表结构还在 - 磁盘表是使用 InnoDB 引擎或者 MyISAM 引擎的临时表,建立 B+ 树索引,写数据的时候是写到磁盘上的

临时表的特点:

- 一个临时表只能被创建它的 session 访问,对其他线程不可见,所以不同 session 的临时表是可以重名的

- 临时表可以与普通表同名,会话内有同名的临时表和普通表时,执行 show create 语句以及增删改查语句访问的都是临时表

- show tables 命令不显示临时表

- 数据库发生异常重启不需要担心数据删除问题,临时表会自动回收

重名原理

执行创建临时表的 SQL:

create temporary table temp_t(id int primary key)engine=innodb;

MySQL 给 InnoDB 表创建一个 frm 文件保存表结构定义,在 ibd 保存表数据。frm 文件放在临时文件目录下,文件名的后缀是 .frm,前缀是 #sql{进程 id}_{线程 id}_ 序列号,使用 select @@tmpdir 命令,来显示实例的临时文件目录

MySQL 维护数据表,除了物理磁盘上的文件外,内存里也有一套机制区别不同的表,每个表都对应一个 table_def_key

- 一个普通表的 table_def_key 的值是由

库名 + 表名得到的,所以如果在同一个库下创建两个同名的普通表,创建第二个表的过程中就会发现 table_def_key 已经存在了 - 对于临时表,table_def_key 在

库名 + 表名基础上,又加入了server_id + thread_id,所以不同线程之间,临时表可以重名

实现原理:每个线程都维护了自己的临时表链表,每次 session 内操作表时,先遍历链表,检查是否有这个名字的临时表,如果有就优先操作临时表,如果没有再操作普通表;在 session 结束时对链表里的每个临时表,执行 DROP TEMPORARY TABLE + 表名 操作

执行 rename table 语句无法修改临时表,因为会按照 库名 / 表名.frm 的规则去磁盘找文件,但是临时表文件名的规则是 #sql{进程 id}_{线程 id}_ 序列号.frm,因此会报找不到文件名的错误

主备复制

创建临时表的语句会传到备库执行,因此备库的同步线程就会创建这个临时表。主库在线程退出时会自动删除临时表,但备库同步线程是持续在运行的并不会退出,所以这时就需要在主库上再写一个 DROP TEMPORARY TABLE 传给备库执行

binlog 日志写入规则:

- binlog_format=row,跟临时表有关的语句就不会记录到 binlog

- binlog_format=statment/mixed,binlog 中才会记录临时表的操作,也就会记录

DROP TEMPORARY TABLE这条命令

主库上不同的线程创建同名的临时表是不冲突的,但是备库只有一个执行线程,所以 MySQL 在记录 binlog 时会把主库执行这个语句的线程 id 写到 binlog 中,在备库的应用线程就可以获取执行每个语句的主库线程 id,并利用这个线程 id 来构造临时表的 table_def_key

- session A 的临时表 t1,在备库的 table_def_key 就是:

库名 + t1 +“M 的 serverid" + "session A 的 thread_id” - session B 的临时表 t1,在备库的 table_def_key 就是 :

库名 + t1 +"M 的 serverid" + "session B 的 thread_id"

MySQL 在记录 binlog 的时不论是 create table 还是 alter table 语句都是原样记录,但是如果执行 drop table,系统记录 binlog 就会被服务端改写

DROP TABLE `t_normal` /* generated by server */

跨库查询

分库分表系统的跨库查询使用临时表不用担心线程之间的重名冲突,分库分表就是要把一个逻辑上的大表分散到不同的数据库实例上

比如将一个大表 ht,按照字段 f,拆分成 1024 个分表,分布到 32 个数据库实例上,一般情况下都有一个中间层 proxy 解析 SQL 语句,通过分库规则通过分表规则(比如 N%1024)确定将这条语句路由到哪个分表做查询

select v from ht where f=N;

如果这个表上还有另外一个索引 k,并且查询语句:

select v from ht where k >= M order by t_modified desc limit 100;

查询条件里面没有用到分区字段 f,只能到所有的分区中去查找满足条件的所有行,然后统一做 order by 操作,两种方式:

- 在 proxy 层的进程代码中实现排序,拿到分库的数据以后,直接在内存中参与计算,但是对 proxy 端的压力比较大,很容易出现内存不够用和 CPU 瓶颈问题

- 把各个分库拿到的数据,汇总到一个 MySQL 实例的一个表中,然后在这个汇总实例上做逻辑操作,执行流程:

- 在汇总库上创建一个临时表 temp_ht,表里包含三个字段 v、k、t_modified

- 在各个分库执行:

select v,k,t_modified from ht_x where k >= M order by t_modified desc limit 100 - 把分库执行的结果插入到 temp_ht 表中

- 在临时表上执行:

select v from temp_ht order by t_modified desc limit 100

优化步骤

执行频率

MySQL 客户端连接成功后,查询服务器状态信息:

SHOW [SESSION|GLOBAL] STATUS LIKE '';

-- SESSION: 显示当前会话连接的统计结果,默认参数

-- GLOBAL: 显示自数据库上次启动至今的统计结果

查看 SQL 执行频率:

SHOW STATUS LIKE 'Com_____';Com_xxx 表示每种语句执行的次数

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-1bfKXSrp-1686862213574)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-SQL语句执行频率.png)]

查询 SQL 语句影响的行数:

SHOW STATUS LIKE 'Innodb_rows_%';[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-WLO6urJK-1686862213574)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-SQL语句影响的行数.png)]

Com_xxxx:这些参数对于所有存储引擎的表操作都会进行累计

Innodb_xxxx:这几个参数只是针对 InnoDB 存储引擎的,累加的算法也略有不同

| 参数 | 含义 |

|---|---|

| Com_select | 执行 SELECT 操作的次数,一次查询只累加 1 |

| Com_insert | 执行 INSERT 操作的次数,对于批量插入的 INSERT 操作,只累加一次 |

| Com_update | 执行 UPDATE 操作的次数 |

| Com_delete | 执行 DELETE 操作的次数 |

| Innodb_rows_read | 执行 SELECT 查询返回的行数 |

| Innodb_rows_inserted | 执行 INSERT 操作插入的行数 |

| Innodb_rows_updated | 执行 UPDATE 操作更新的行数 |

| Innodb_rows_deleted | 执行 DELETE 操作删除的行数 |

| Connections | 试图连接 MySQL 服务器的次数 |

| Uptime | 服务器工作时间 |

| Slow_queries | 慢查询的次数 |

定位低效

SQL 执行慢有两种情况:

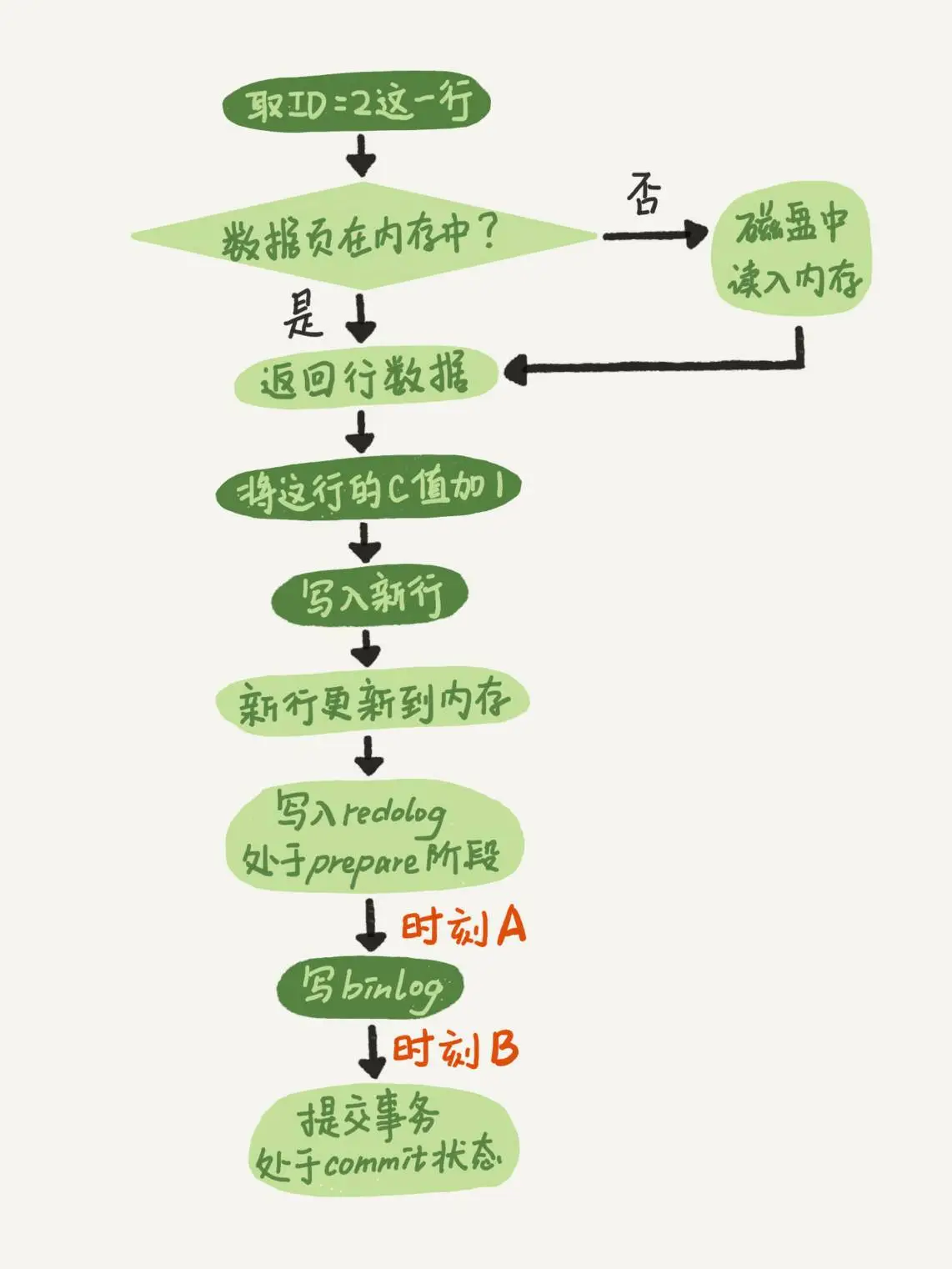

- 偶尔慢:DB 在刷新脏页(学完事务就懂了)

- redo log 写满了

- 内存不够用,要从 LRU 链表中淘汰

- MySQL 认为系统空闲的时候

- MySQL 关闭时

- 一直慢的原因:索引没有设计好、SQL 语句没写好、MySQL 选错了索引

通过以下两种方式定位执行效率较低的 SQL 语句

慢日志查询: 慢查询日志在查询结束以后才记录,执行效率出现问题时查询日志并不能定位问题

配置文件修改:修改 .cnf 文件

vim /etc/mysql/my.cnf,重启 MySQL 服务器slow_query_log=ON slow_query_log_file=/usr/local/mysql/var/localhost-slow.log long_query_time=1 #记录超过long_query_time秒的SQL语句的日志 log-queries-not-using-indexes = 1使用命令配置:

mysql> SET slow_query_log=ON; mysql> SET GLOBAL slow_query_log=ON;查看是否配置成功:

SHOW VARIABLES LIKE '%query%'SHOW PROCESSLIST:实时查看当前 MySQL 在进行的连接线程,包括线程的状态、是否锁表、SQL 的执行情况,同时对一些锁表操作进行优化

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-kYY7BRwB-1686862213575)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-SHOW_PROCESSLIST命令.png)]

EXPLAIN

执行计划

通过 EXPLAIN 命令获取执行 SQL 语句的信息,包括在 SELECT 语句执行过程中如何连接和连接的顺序,执行计划在优化器优化完成后、执行器之前生成,然后执行器会调用存储引擎检索数据

查询 SQL 语句的执行计划:

EXPLAIN SELECT * FROM table_1 WHERE id = 1;

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-SsWh5vLm-1686862213575)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-explain查询SQL语句的执行计划.png)]

| 字段 | 含义 |

|---|---|

| id | SELECT 的序列号 |

| select_type | 表示 SELECT 的类型 |

| table | 访问数据库中表名称,有时可能是简称或者临时表名称(<table_name>) |

| type | 表示表的连接类型 |

| possible_keys | 表示查询时,可能使用的索引 |

| key | 表示实际使用的索引 |

| key_len | 索引字段的长度 |

| ref | 表示与索引列进行等值匹配的对象,常数、某个列、函数等,type 必须在(range, const] 之间,左闭右开 |

| rows | 扫描出的行数,表示 MySQL 根据表统计信息及索引选用情况,估算的找到所需的记录扫描的行数 |

| filtered | 条件过滤的行百分比,单表查询没意义,用于连接查询中对驱动表的扇出进行过滤,查询优化器预测所有扇出值满足剩余查询条件的百分比,相乘以后表示多表查询中还要对被驱动执行查询的次数 |

| extra | 执行情况的说明和描述 |

MySQL 执行计划的局限:

- 只是计划,不是执行 SQL 语句,可以随着底层优化器输入的更改而更改

- EXPLAIN 不会告诉显示关于触发器、存储过程的信息对查询的影响情况, 不考虑各种 Cache

- EXPLAIN 不能显示 MySQL 在执行查询时的动态,因为执行计划在执行查询之前生成

- EXPALIN 只能解释 SELECT 操作,其他操作要重写为 SELECT 后查看执行计划

- EXPLAIN PLAN 显示的是在解释语句时数据库将如何运行 SQL 语句,由于执行环境和 EXPLAIN PLAN 环境的不同,此计划可能与 SQL 语句实际的执行计划不同,部分统计信息是估算的,并非精确值

SHOW WARINGS:在使用 EXPALIN 命令后执行该语句,可以查询与执行计划相关的拓展信息,展示出 Level、Code、Message 三个字段,当 Code 为 1003 时,Message 字段展示的信息类似于将查询语句重写后的信息,但是不是等价,不能执行复制过来运行

环境准备:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-kFkwk0ku-1686862213576)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-执行计划环境准备.png)]

id

id 代表 SQL 执行的顺序的标识,每个 SELECT 关键字对应一个唯一 id,所以在同一个 SELECT 关键字中的表的 id 都是相同的。SELECT 后的 FROM 可以跟随多个表,每个表都会对应一条记录,这些记录的 id 都是相同的,

id 相同时,执行顺序由上至下。连接查询的执行计划,记录的 id 值都是相同的,出现在前面的表为驱动表,后面为被驱动表

EXPLAIN SELECT * FROM t_role r, t_user u, user_role ur WHERE r.id = ur.role_id AND u.id = ur.user_id ;[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-WrXkFKWQ-1686862213576)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-explain之id相同.png)]

id 不同时,id 值越大优先级越高,越先被执行

EXPLAIN SELECT * FROM t_role WHERE id = (SELECT role_id FROM user_role WHERE user_id = (SELECT id FROM t_user WHERE username = 'stu1'))[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-llQtaIgO-1686862213576)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-explain之id不同.png)]

id 有相同也有不同时,id 相同的可以认为是一组,从上往下顺序执行;在所有的组中,id 的值越大的组,优先级越高,越先执行

EXPLAIN SELECT * FROM t_role r , (SELECT * FROM user_role ur WHERE ur.`user_id` = '2') a WHERE r.id = a.role_id ;[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-q3fYpQMI-1686862213577)(https://seazean.oss-cn-beijing.aliyuncs.com/img/DB/MySQL-explain之id相同和不同.png)]

id 为 NULL 时代表的是临时表

select

表示查询中每个 select 子句的类型(简单 OR 复杂)

| select_type | 含义 |

|---|---|

| SIMPLE | 简单的 SELECT 查询,查询中不包含子查询或者 UNION |

| PRIMARY | 查询中若包含任何复杂的子查询,最外层(也就是最左侧)查询标记为该标识 |

| UNION | 对于 UNION 或者 UNION ALL 的复杂查询,除了最左侧的查询,其余的小查询都是 UNION |

| UNION RESULT | UNION 需要使用临时表进行去重,临时表的是 UNION RESULT |

| DEPENDENT UNION | 对于 UNION 或者 UNION ALL 的复杂查询,如果各个小查询都依赖外层查询,是相关子查询,除了最左侧的小查询为 DEPENDENT SUBQUERY,其余都是 DEPENDENT UNION |

| SUBQUERY | 子查询不是相关子查询,该子查询第一个 SELECT 代表的查询就是这种类型,会进行物化(该子查询只需要执行一次) |

| DEPENDENT SUBQUERY | 子查询是相关子查询,该子查询第一个 SELECT 代表的查询就是这种类型,不会物化(该子查询需要执行多次) |

| DERIVED | 在 FROM 列表中包含的子查询,被标记为 DERIVED(衍生),也就是生成物化派生表的这个子查询 |

| MATERIALIZED | 将子查询物化后与与外层进行连接查询,生成物化表的子查询 |

子查询为 DERIVED:SELECT * FROM (SELECT key1 FROM t1) AS derived_1 WHERE key1 > 10

子查询为 MATERIALIZED:SELECT * FROM t1 WHERE key1 IN (SELECT key1 FROM t2)

type

对表的访问方式,表示 MySQL 在表中找到所需行的方式,又称访问类型

| type | 含义 |

|---|---|

| ALL | 全表扫描,如果是 InnoDB 引擎是扫描聚簇索引 |

| index | 可以使用覆盖索引,但需要扫描全部索引 |

| range | 索引范围扫描,常见于 between、<、> 等的查询 |

| index_subquery | 子查询可以普通索引,则子查询的 type 为 index_subquery |

| unique_subquery | 子查询可以使用主键或唯一二级索引,则子查询的 type 为 index_subquery |

| index_merge | 索引合并 |

| ref_or_null | 非唯一性索引(普通二级索引)并且可以存储 NULL,进行等值匹配 |

| ref | 非唯一性索引与常量等值匹配 |

| eq_ref | 唯一性索引(主键或不存储 NULL 的唯一二级索引)进行等值匹配,如果二级索引是联合索引,那么所有联合的列都要进行等值匹配 |

| const | 通过主键或者唯一二级索引与常量进行等值匹配 |

| system | system 是 const 类型的特例,当查询的表只有一条记录的情况下,使用 system |

| NULL | MySQL 在优化过程中分解语句,执行时甚至不用访问表或索引 |

从上到下,性能从差到好,一般来说需要保证查询至少达到 range 级别, 最好达到 ref

key

possible_keys:

- 指出 MySQL 能使用哪个索引在表中找到记录,查询涉及到的字段上若存在索引,则该索引将被列出,但不一定被查询使用

- 如果该列是 NULL,则没有相关的索引

key:

- 显示 MySQL 在查询中实际使用的索引,若没有使用索引,显示为 NULL

- 查询中若使用了覆盖索引,则该索引可能出现在 key 列表,不出现在 possible_keys

key_len: