大脑神经图_我们的大脑如何理解图

大脑神经图

To learn from something, we first have to understand it. With AI, this isn’t always so easy.

要从中学习,我们首先必须了解它。 使用AI,这并不总是那么容易。

Our brain can learn just about any information, no matter how simple or complex. But what makes data “complex”?

无论多么简单或复杂,我们的大脑都可以学习任何信息。 但是,什么使数据“复杂”呢?

563,490 is larger than 5, but about as simple: a integer on a numeric scale (a scalar, if you will).

563,490大于5,但大约很简单:数字刻度上的整数(如果可以,则为标量)。

How about a graph?

图怎么样?

As it grows, a social network becomes arbitrarily complex. Adding more nodes isn’t too convoluted, but each node can have any number of connections (and some connections are weightier than others.

随着社交网络的发展,它变得任意复杂。 添加更多的节点并不太复杂,但是每个节点可以具有任意数量的连接(某些连接比其他连接更重要。

There’s no “hard” limit to how many people you can know — it’s arbitrary, uncertain.

您可以认识多少人没有“硬性”限制-它是任意的,不确定的。

Why does this matter for AI?

为什么这对AI很重要?

深奥的编码 (Esoteric Encoding)

To feed data into a machine learning model, we have to convert the bits into a format the computer can work with — bits.

为了将数据输入到机器学习模型中,我们必须将位转换为计算机可以使用的格式-位。

If you’re predicting temperatures based on daily readings, scalars are easy. If you want a cat-recognizing convolutional neural network, you can convert each cat picture to a 3d array of scalars, one for each pixel’s RGB level.

如果您要根据日常读数预测温度,则标量很容易。 如果需要猫识别的卷积神经网络,则可以将每张猫图片转换为3d标量数组,每个像素的RGB级别对应一个。

But graphs? You could say that the dimensionality of the data increases, which is a quick recipe to crash any unassuming scikit model unprepared for such hardships.

但是图呢? 您可以说数据的维数增加了,这是使没有准备好应对这种困难的任何假定的scikit模型崩溃的快速方法。

Yet ML researchers have been hard at work for a good while now, working with graphs as input data. One way is looking at the Adjacency Matrix:

但是,机器学习研究人员已经努力工作了好一阵子,将图作为输入数据。 一种方法是查看邻接矩阵:

A sparse matrix can be constructed by filling “1” where nodes connect to other nodes. Note the diagonal symmetry — compression/simplification can be applied for storage efficiency.

可以通过在节点连接到其他节点的位置填充“ 1”来构造稀疏矩阵。 请注意,对角线对称-压缩/简化可以提高存储效率。

Plenty of neural nets accept matrices as input data. But if the graph adds a node, the dimensionality increases, and your carefully constructed TensorFlow model will stop and complain about shape mismatches.There are, of course, other solutions.

大量的神经网络接受矩阵作为输入数据。 但是,如果图形添加一个节点,则维数会增加,并且精心构建的TensorFlow模型将停止并抱怨形状不匹配,当然还有其他解决方案。

I enjoyed Michael Larionov’s detailed explanation of graph-input neural networks — graph convolutional layers, especially, have opened up new doors in modeling complicated graph networks.

我喜欢Michael Larionov对图输入神经网络的详细解释 -特别是图卷积层为建模复杂的图网络打开了新的大门。

I’ve been writing mostly about Hierarchical Temporal Memory networks these days, however, which is what brought me to the beautiful and vexing plane of graphs.

这些天来,我主要是在撰写有关分层时间记忆网络的文章,这使我进入了图的美丽而令人烦恼的平面。

生物网络 (Biological Networks)

HTM nets are a new architecture of neural network modeled to more closely represent the arrangements of neurons in the neocortex. Specifically, the neocortical columns that seem to do most of our thinking. “Mimic the form, mimic the function”.

HTM网络是一种新的神经网络架构,其建模旨在更紧密地表示新皮质中神经元的排列。 具体来说,新皮质柱似乎在影响我们的大部分工作。 “模仿形式,模仿功能”。

Our real neurons are binary — they fire, or they don’t — and interconnected enough to learn patterns with excitation and inhibition.

我们真正的神经元是二进制的,它们会发射或不发射,并且相互连接足以学习激发和抑制的模式。

Instead of long, fully-connected layers like traditional neural networks, the computational machinery of HTM systems are interconnected at all levels.

HTM系统的计算设备在各个层次上都相互连接,而不是像传统的神经网络那样漫长而完全连接的层。

The Temporal Memory, for example, is a 3D “block” of columns filled with neurons — akin to the nodes in fully connected NNs.

例如,时间记忆是充满神经元的列的3D“块”,类似于完全连接的NN中的节点。

But neurons at the bottom “layer” can have connections to neurons in the top layer of other columns — not just the following layer.

但是底层“层”的神经元可以与其他列顶层的神经元建立连接,而不仅仅是下一层。

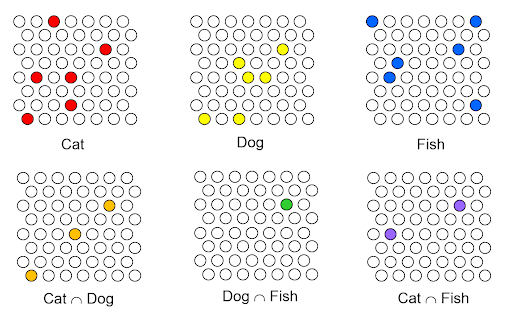

The trick behind it all is the Sparse Distributed Representation, a binary array where ~2% of bits are 1.

所有这些背后的技巧都是稀疏分布式表示,这是一个二进制数组,其中〜2%的位为1。

Now back to the main issue: it’s not so tough to turn “42” into an SDR. Matt explains the concept of scalar encoding quite eloquently. Even words can be encoded, if you have a large enough corpus to teach the HTM word co-occurrence.

现在回到主要问题:将“ 42”转换为SDR并不困难。 Matt 非常雄辩地解释了标量编码的概念 。 如果您有足够大的语料库来教HTM单词共现,则即使单词也可以编码 。

But once again: graphs.

但是再一次: 图形。

A series of scalars isn’t too tough to deal with, so couldn’t we just use the graph’s adjacency matrix? But what if the graph later adds more nodes — the dimensions increase. Arbitrary complexity is tough to convert to a fixed-size SDR.

一系列标量并不难处理,因此我们不能仅使用图形的邻接矩阵吗? 但是,如果该图以后添加了更多的节点,那么尺寸会增加。 任意复杂度很难转换为固定大小的SDR。

I’ve read some great ideas for domain specific tasks, but a “general” graph encoder would take some intense research and wicked programming skill. In the search for a reliable graph encoding strategy, I decided to approach the question with HTM’s defining logic: question the biological roots of how we came to understand the data structure itself.

我已经阅读了一些针对领域特定任务的好主意,但是“通用”图形编码器将需要一些深入的研究和邪恶的编程技巧。 在寻求可靠的图形编码策略时,我决定使用HTM的定义逻辑来解决这个问题:质疑我们如何理解数据结构本身的生物学根源。

进化图 (Evolutionary Graphs)

A chimp can look at an apple, and know that “this is indeed an apple”. Macaques hear the cry of a leopard and understand “existential threat”. Koko the gorilla learned a very functional degree of sign language.

黑猩猩可以看着一个苹果,并且知道“这确实是一个苹果”。 猕猴听到豹子的叫声,并理解“存在的威胁”。 大猩猩科科学习了非常实用的手语。

But how do we understand graphs?My theory is that we don’t — at least, not all at once.

但是我们如何理解图呢? 我的理论是, 我们不会-至少不是一次全部。

I asked myself: Where do graphs occur in nature? Trees, roots, certainly — but perhaps something else more innate, more crucial to being human?

我问自己:图在自然界中何处出现? 树木,树根当然可以,但是也许其他与生俱来,对人类至关重要的东西呢?

As we evolved from early primates, proto-humans were social creatures. We eventually became complex enough to be called “tribal”.

随着我们从早期的灵长类动物进化而来,原始人类是社交动物。 我们最终变得复杂到足以被称为“部落”。

Our ability to work together is what allowed us to come this far. Socialization built civilization.

我们的合作能力使我们走到了这一步。 社会化建设了文明。

So the most fundamental network — the proto-graph — is simply a social network. A family, band, tribe, village, any collective noun for a group of mutually interacting primates.

因此,最基本的网络-原型-仅仅是一个社交网络。 家庭,乐队,部落,村庄,是一组相互交互的灵长类动物的任何集合名词。

Think about your entire extended social network — conjure up an idea of all the people you “know” for about 15 seconds. Sort of difficult to picture the whole graph, right?

考虑一下您整个扩展的社交网络-让您“认识”的所有人员在大约15秒钟内产生一个想法。 很难描绘出整个图形,对不对?

Now think of one of your friends. You can clearly visualize their face, your memories and feelings associated with them.

现在想想你的一位朋友。 您可以清楚地看到他们的脸,与他们相关的回忆和感觉。

Now think of another friend. There’s a good chance you thought of someone connected to the first person.

现在想想另一个朋友。 您很有可能想到某个人与第一人称联系。

You subconsciously “primed” that thought with neuronal excitation and inhibition; the cells in your brain that know “friend_1” have plenty of synapses connected to “friend_2” because you know that both of them are connected in real life.Your understanding of their relationship is reflected in your brain’s architecture.

您通过神经元的激发和抑制来下意识地“激发”了这种思想。 您大脑中知道“ friend_1”的细胞具有与“ friend_2”相关的大量突触,因为您知道它们在现实生活中都是相互连接的。您对它们之间关系的理解反映在大脑的结构中。

By thinking of people you know and thinking of people they know (that you also know), you can traverse your social network graph like a mental pathfinding algorithm.

通过思考您认识的人和思考他们认识的人(您也认识),您可以像思维寻路算法那样遍历社交网络图。

But what I keep noticing is that it’s terribly hard to ‘understand’ the entire graph all at once.

但是,我一直注意到的是,这是非常难以“理解”整个图形的一次 。

元结构知识 (Meta-Structural Knowledge)

I reckon that we can’t picture our entire social network at once for the same reason we can’t simultaneously read every word on a page. The task is too complex, and humans really aren’t great multitaskers. We need to focus on individual pieces to put together any larger puzzle.

我认为,由于无法同时读取页面上的每个单词的原因,我们无法一次描绘整个社交网络。 任务太复杂了, 人类真的不是出色的多任务处理者 。 我们需要集中精力于各个部分,以解决任何更大的难题。

You build your social network piece by piece as you live — continuous learning. HTMs also do this, and are similarly able to learn patterns between data, associating sequential inputs with each other like humans can.

您可以逐步建立自己的社交网络-持续学习。 HTM也可以做到这一点,并且类似地能够学习数据之间的模式,从而像人类一样将顺序输入彼此关联。

Leading back to the search for a general graph → SDR encoder: If humans don’t “learn” an entire graph all at once, why should an HTM system try to?

回到寻找普通图形的搜索→SDR编码器:如果人类没有一次“学习”整个图形,那么HTM系统为什么要尝试?

In my (quite limited) understanding of neuronal circuitry, graphs appear to be ‘meta-structures’ — interlinked “units” of knowledge, connected concepts or objects that are learned sequentially.

在我(非常有限)对神经元电路的理解中,图似乎是“元结构 ”,即知识,相互联系的概念或顺序学习的对象的相互联系的“单元”。

To understand a graph, your brain builds a graph with its own cells & synapses.

要理解图,您的大脑会用自己的细胞和突触来构建图。

Mimic the form, mimic the function.

模仿形式,模仿功能。

搜索继续 (The Search Continues)

I can’t help but wonder — is there a maximum “size” of knowledge, a set limit on how big an idea we can learn at any given moment?

我忍不住想知道-是否有最大的知识“规模”,对我们在任何特定时刻可以学到的想法有一个设定的限制?

When working through a hard task — learning a complex new concept, which in itself could be a hierarchy of interdependent elements — we learn pieces in rapid succession and do our best to put it together. To assemble a graph of knowledge.

在完成一项艰巨的任务时(学习一个复杂的新概念,它本身可能是一个相互依赖的元素的层次结构),我们会快速连续地学习各个方面,并尽力将其组合在一起。 组装知识图。

In the case of machine learning, one Temporal Memory system might be overtasked by a complex graph. The two solutions would then be to feed the one model each piece of the graph (similar to a graph convolutional layer scanning certain sections at a time) in order, or to assemble several HTMs connected horizontally. The latter method is similar to how many clusters of neurons across different cortical columns are involved in a complex task like object recognition.

在机器学习的情况下,一个临时记忆系统可能会因复杂的图形而超负荷工作。 然后,两种解决方案将是按顺序向每张图馈入一个模型(类似于一次扫描某些部分的图卷积层),或者组装水平连接的多个HTM。 后一种方法类似于跨不同皮层列的神经元簇涉及诸如对象识别之类的复杂任务。

At any rate, direct conversion of graphs to SDRs is a fantastic idea to chase. Much of the brain’s exact workings are still secrets, but there’s likely to be some strange, elegant meta-structural principles at work.

无论如何,将图形直接转换为SDR都是一个绝妙的主意。 大脑的许多确切工作原理仍是秘密,但工作中可能会有一些奇怪,优雅的元结构原理。

翻译自: https://medium.com/swlh/how-does-our-brain-understand-graphs-4064c3b7140d

大脑神经图

http://www.taodudu.cc/news/show-6811469.html

相关文章:

- VMware存储栈那点儿事儿

- 数据存储加密和传输加密_将时间存储网络应用于加密预测

- 基因组测序揭示柳树中性染色体的重复翻转使其永保年轻

- VMware vSphere 5.1 群集深入解析(二十五)- 关联性

- vsphere DRS高级设置之规则

- 10.Wordpress启用远程redis

- 上下山平均速度,平均速率问题求解程序

- 求两数平均值

- 求数列的和及平均值

- 行测之等距离平均速度问题

- 10-244 6-1 查询PC的平均速度

- 使用加速度传感器与GPS位移求速度

- 求百米运动员的平均速度

- Unity 求物体平均位置和刚体平均速度

- 数学小课堂:无穷小(平均速度和瞬间速度的关系)

- C语言——计算时间差、求平均值

- 如何从CDN加载jQuery?

- Edge_Computing_Vision_and_Challenges

- On Mobile Edge Caching 1

- Microsoft Edge功能测评

- 将macast的投屏web端渲染改为edge浏览器打开

- 【论文阅读】YOLO-X:Exceeding YOLO Series in 2021

- java65535 was_jsp文件过大,is exceeding 65535 bytes limit

- 《YOLOX: Exceeding YOLO Series in 2021》阅读

- 我懵了,居然还有学校还在教 Java 的 Swing

- VR拆装(HTC vive Pro开发)——3、项目开始前的预先知识

- python开发文档下载_python开发

- 打字练习感悟

- 打字初级练习

- 蓝鲸Influxdb节点迁移

大脑神经图_我们的大脑如何理解图相关推荐

- 谷歌自动重建了完整果蝇大脑神经图:40万亿像素,可在线交互,用了数千块TPU...

乾明 发自 凹非寺 量子位 报道 | 公众号 QbitAI 研究大脑神经网络,又有新进展. 谷歌AI发布博客文章宣布最新研究成果: 用Flood-Filling网络和Local Realignmen ...

- 神经形态网络——大脑神经图论文阅读笔记【1】

这个故事始于 文章 "Learning function from structure in neuromorphic networks" \quad\quad 首先我们把摘要的翻 ...

- 婴儿大脑MRI图谱集

大家好,这里是 "茗创科技" .茗创科技专注于脑科学数据处理,涵盖(EEG/ERP, fMRI,结构像,DTI,ASL, ,FNIRS)等,欢迎留言讨论及转发推荐,也欢迎了解茗创科 ...

- 大脑皮层由神经组织构成,大脑神经网络结构图片

1.组成大脑皮层的主要结构是什么,可以接说一下吗 大脑皮层是由6层神经细胞组成的.在进化中,它由下层到上层依次生成,从而这些不同层次结构的功能也不尽相同.在功能上,它们被分为3个级区:初级区.次级区和 ...

- 大脑神经网络图高清,大脑神经网络图片

人脑记忆区分布图是怎样的? 这种有序性就是我们思想中的规则.我们的大脑是靠这些规则(因果关系)理解和解释事物的.如果事物结构的有序性与我们大脑的思维结构不兼容,我们就无法理解或暂时不能理解它们,因为我 ...

- 大脑神经中枢分布图结构,大脑神经网络结构图片

人脑记忆区分布图是怎样的? 这种有序性就是我们思想中的规则.我们的大脑是靠这些规则(因果关系)理解和解释事物的.如果事物结构的有序性与我们大脑的思维结构不兼容,我们就无法理解或暂时不能理解它们,因为我 ...

- idea火箭_火箭的大脑

idea火箭 Two ideas from computer science have intrigued me for a long time: neural networks and evolut ...

- 科学家即将揭示人类大脑神经网络结构的奥秘

来源:今日头条 人类即将迎来了解大脑神经网络结构神秘世界的曙光! 哈佛大学神经科学家和谷歌工程师,发布了第一张人类大脑部分的神经网络连接图,大约针头大小的人类大脑组织用重金属染色,切成 5,000,并 ...

- 人类大脑神经如何进化?寄生虫充当了隐形设计师

来源:网易科技 自人类诞生以来,寄生虫就从未停止过与我们的相爱相杀,它们不仅改变了某些人类的进化方向和行为,甚至也影响了大脑神经的进化方式,充当着隐形设计师的角色. 美国新墨西哥大学心理学家马可·德尔 ...

最新文章

- jittor和pytorch生成网络对比之cogan

- swift_014(Swift 的控制流)

- css 自动换行_前端必备!20个CSS小技巧

- java创建请求拦截器_80.简单Retrofit+RxJava+日志拦截器结合使用

- 自定义消息编码绑定实现

- CUDA学习(三)之使用GPU进行两个数组相加

- Win7和win10下python3和python2同时安装并解决pip共存问题

- BurpSuite Pro 2021.2 最新版本

- iPad PPT演示录屏踩坑及后续ffmpeg处理

- 智能插座常用的两种通信协议——WIFI和ZigBee

- 我的世界服务器如何开无限小号,实操神技能,微信能“无限”开小号?

- [PAT A1013]Battle Over Cities

- RealSense 图形识别之路 2.0

- Google Play 上架全流程_2022年谷歌应用商店上架流程

- 安装程序包的语言不受系统支持的解决方法

- 【Cesium】添加polygon边界线

- 教你在线翻译PDF文档的方法

- VUE渲染富文本编辑器内容

- Android格子视图的另外一种实现方式之Images3LinearLayout(9宫格/九宫格)

- HttpClient 连接超时重试处理