python输出古诗词_python爬虫——爬取古诗词

一. 概要

1.通过python爬虫循环爬取古诗词网站唐诗宋词

2.落地到本地数据库

二. 页面分析

首先通过firedebug进行页面定位:

其次源码定位:

最终生成lxml etree定位div标签源码:

# 通过 lxml进行页面分析

response = etree.HTML(data)

# div层定位

for row in response.xpath('//div[@class="left"]/div[@class="sons"]'):

# 标题定位

title = row.xpath('div[@class="cont"]/p/a/b/text()')[0] if row.xpath('div[@class="cont"]/p/a/b/text()') else ''

# 朝代定位

dynasty = row.xpath('div[@class="cont"]/p[@class="source"]//text()')[0] if row.xpath('div[@class="cont"]/p[@class="source"]//text()') else ''

# 诗人定位

author = row.xpath('div[@class="cont"]/p[@class="source"]//text()')[-1] if row.xpath('div[@class="cont"]/p[@class="source"]//text()') else ''

# 内容定位

content = ''.join(row.xpath('div[@class="cont"]/div[@class="contson"]//text()')).replace(' ', '').replace('\n', '') if row.xpath('div[@class="cont"]/div[@class="contson"]//text()') else ''

# 标签定位

tag = ','.join(row.xpath('div[@class="tag"]/a/text()')) if row.xpath('div[@class="tag"]/a/text()') else ''

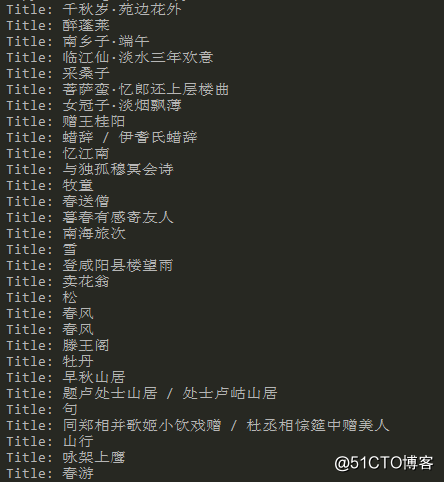

三. 执行结果

四. 脚本源码

#!/usr/bin/env python

# -*- coding: utf-8 -*-

'''

@Date : 2017/12/21 11:12

@Author : kaiqing.huang

@File : shigeSpider.py

'''

from utils import MySpider, MongoBase

from datetime import date

from lxml import etree

import sys

class shigeSpider():

def __init__(self):

self.db = MongoBase()

self.spider = MySpider()

def download(self, url):

self.domain = url.split('/')[2]

data = self.spider.get(url)

if data:

self.parse(data)

def parse(self, data):

response = etree.HTML(data)

for row in response.xpath('//div[@class="left"]/div[@class="sons"]'):

title = row.xpath('div[@class="cont"]/p/a/b/text()')[0] if row.xpath('div[@class="cont"]/p/a/b/text()') else ''

dynasty = row.xpath('div[@class="cont"]/p[@class="source"]//text()')[0] if row.xpath('div[@class="cont"]/p[@class="source"]//text()') else ''

author = row.xpath('div[@class="cont"]/p[@class="source"]//text()')[-1] if row.xpath('div[@class="cont"]/p[@class="source"]//text()') else ''

content = ''.join(row.xpath('div[@class="cont"]/div[@class="contson"]//text()')).replace(' ', '').replace('\n', '') if row.xpath('div[@class="cont"]/div[@class="contson"]//text()') else ''

tag = ','.join(row.xpath('div[@class="tag"]/a/text()')) if row.xpath('div[@class="tag"]/a/text()') else ''

self.db.add_new_row('shigeSpider', { 'title': title, 'dynasty': dynasty, 'author': author, 'content': content, 'tag': tag, 'createTime': str(date.today()) })

print 'Title: {}'.format(title)

if response.xpath('//div[@class="pages"]/a/@href'):

self.download('http://' + self.domain + response.xpath('//div[@class="pages"]/a/@href')[-1])

if __name__ == '__main__':

sys.setrecursionlimit(100000)

url = 'http://so.gushiwen.org/type.aspx'

do = shigeSpider()

do.download(url)

python输出古诗词_python爬虫——爬取古诗词相关推荐

- python输出古诗词_python爬虫——爬取古诗名句

一. 概要 1.通过python爬虫循环爬取古诗词网站古诗名句 2.落地到本地数据库 二. 页面分析 首先通过firedebug进行页面定位: 其次源码定位: 最终生成lxml etree定位div标 ...

- python xpath循环_Python爬虫 爬取北京二手房数据

点击蓝字"python教程"关注我们哟! 前言 Python现在非常火,语法简单而且功能强大,很多同学都想学Python!所以小的给各位看官们准备了高价值Python学习视频教程及 ...

- python搞笑教程_python爬虫- 爬取幽默笑话网站,带你一起笑翻天

importrequestsimportthreadpoolimporttimeimportos,sysimportrefrom lxml importetreefrom lxml.html impo ...

- python爬虫爬取古诗词内容,并存入mysql

python爬虫爬取古诗词内容,并存入mysql 爬取结果展示: 代码如下: from urllib import request import re,os import pymysql import ...

- python爬虫——爬取古诗词

一:需求 1.通过python爬虫循环爬取古诗词网站唐诗宋词 2.保存爬下来的诗词与url 二:效果截图 三:代码实现 import requests from lxml import etree i ...

- python爬虫爬取古诗词实例补充讲解之获取注释和译文

对这个网站的具体每首诗,如果想获取它的注释和译文,要怎么实现. 比如: https://so.gushiwen.org/shiwenv_30a67e5c53be.aspx 这首诗,直接进去后,注释和译 ...

- python爬虫提取人名_python爬虫—爬取英文名以及正则表达式的介绍

python爬虫-爬取英文名以及正则表达式的介绍 爬取英文名: 一. 爬虫模块详细设计 (1)整体思路 对于本次爬取英文名数据的爬虫实现,我的思路是先将A-Z所有英文名的连接爬取出来,保存在一个csv ...

- python跑一亿次循环_python爬虫爬取微博评论

原标题:python爬虫爬取微博评论 python爬虫是程序员们一定会掌握的知识,练习python爬虫时,很多人会选择爬取微博练手.python爬虫微博根据微博存在于不同媒介上,所爬取的难度有差异,无 ...

- python爬虫网页中的图片_Python爬虫爬取一个网页上的图片地址实例代码

本文实例主要是实现爬取一个网页上的图片地址,具体如下. 读取一个网页的源代码: import urllib.request def getHtml(url): html=urllib.request. ...

最新文章

- postgresql 获取所有表名、字段名、字段类型、注释

- 15件事造就有理想的程序员

- XML文件转换成字符串互相转换操作

- spark sql 上个月_Spark学习之路 (十八)SparkSQL简单使用

- html选中后当前变色,JS代码实现表格选中后变色操作有哪些代码?

- 57、Design Support Library 介绍及环境搭建

- 进入大厂的面试经验详细总结(P7 拿 offer)

- 【图像融合】基于matlab对比度和结构提取多模态解剖图像融合【含Matlab源码 1539期】

- 【2019银川网络赛A:】Maximum Element In A Stack(动态求栈中最大值)

- 供应链金融业务基础模式、实施路径、服务对象深度解析

- 学计算机用华硕电脑,适合大学生使用的最佳笔记本电脑推荐,华硕 ZenBook UX330UA...

- 【调剂】2020年西安建筑科技大学考研调剂信息(含接收专业)

- 关于阿里云与mangoDB的关系,以及uni-app基于阿里云打包H5以及app的讲解及注意事项

- VUE中自定义步骤条

- excel----检验

- CDA-Community Data Access规则

- live555源代码分析与代码下载链接

- ubuntu13.04(pear 8) 几个比较好用的软件

- html大二实训大作业:蛋糕甜品网站设计——棕色蛋糕甜品店网页设计(4页) HTML+CSS+JavaScript HTML5期末大作业 web网页设计制作成品

- [轻笔记]容器内终端使用代理(about apollo)