用深度学习keras的cnn做图像识别分类,准确率达97%

Keras是一个简约,高度模块化的神经网络库。

可以很容易和快速实现原型(通过总模块化,极简主义,和可扩展性)

同时支持卷积网络(vision)和复发性的网络(序列数据)。以及两者的组合。

无缝地运行在CPU和GPU上。

keras的资源库网址为https://github.com/fchollet/keras

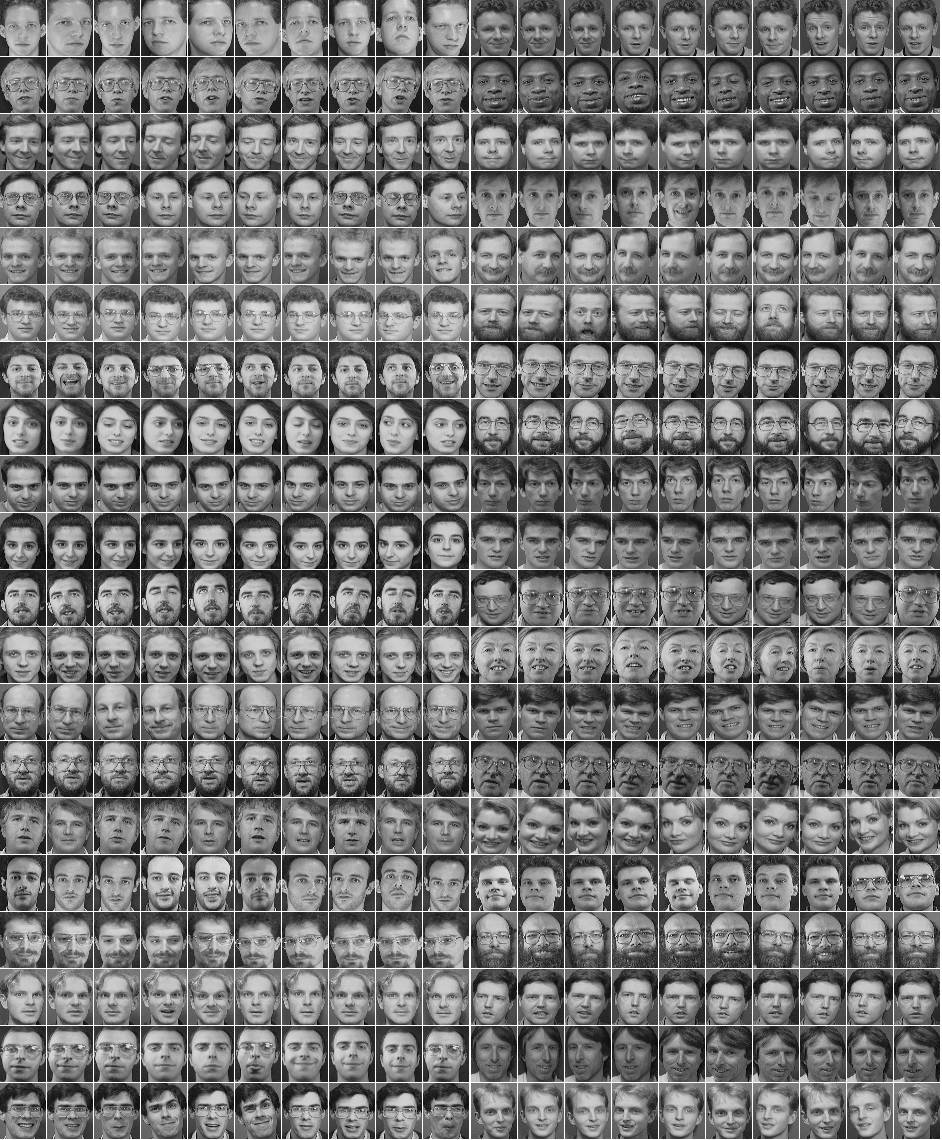

olivettifaces人脸数据库介绍

Olivetti Faces是纽约大学的一个比较小的人脸库,由 40个人的400张图片构成,即每个人的人脸图片为10张。每张图片的灰度级为8位,每个像素的灰度大小位于0-255之间,每张图片大小为64×64。 如下图,这个图片大小是1140942,一共有2020张人脸,故每张人脸大小是(1140/20)(942/20)即5747=2679:

预处理模块

使用了PIL(Python Imaging Library)模块,是Python平台事实上的图像处理标准库。

预处理流程是:打开文件-》归一化-》将图片转为数据集-》生成label-》使用pickle序列化数据集

numpy.ndarray.flatten函数的功能是将一个矩阵平铺为向量

from PIL import Image

import numpy

import cPickle

img = Image.open('G:dataolivettifaces.gif')

# numpy supports conversion from image to ndarray and normalization by dividing 255

# 1140 * 942 ndarray

img_ndarray = numpy.asarray(img, dtype='float64') / 255

# create numpy array of 400*2679

img_rows, img_cols = 57, 47

face_data = numpy.empty((400, img_rows*img_cols))

# convert 1140*942 ndarray to 400*2679 matrix

for row in range(20):

for col in range(20):

face_data[row*20+col] = numpy.ndarray.flatten(img_ndarray[row*img_rows:(row+1)*img_rows, col*img_cols:(col+1)*img_cols])

# create label

face_label = numpy.empty(400, dtype=int)

for i in range(400):

face_label[i] = i / 10

# pickling file

f = open('G:dataolivettifaces.pkl','wb')

# store data and label as a tuple

cPickle.dump((face_data,face_label), f)

f.close()

分类模型

程序参考了官方示例:https://github.com/fchollet/keras/blob/master/examples/mnist_cnn.py

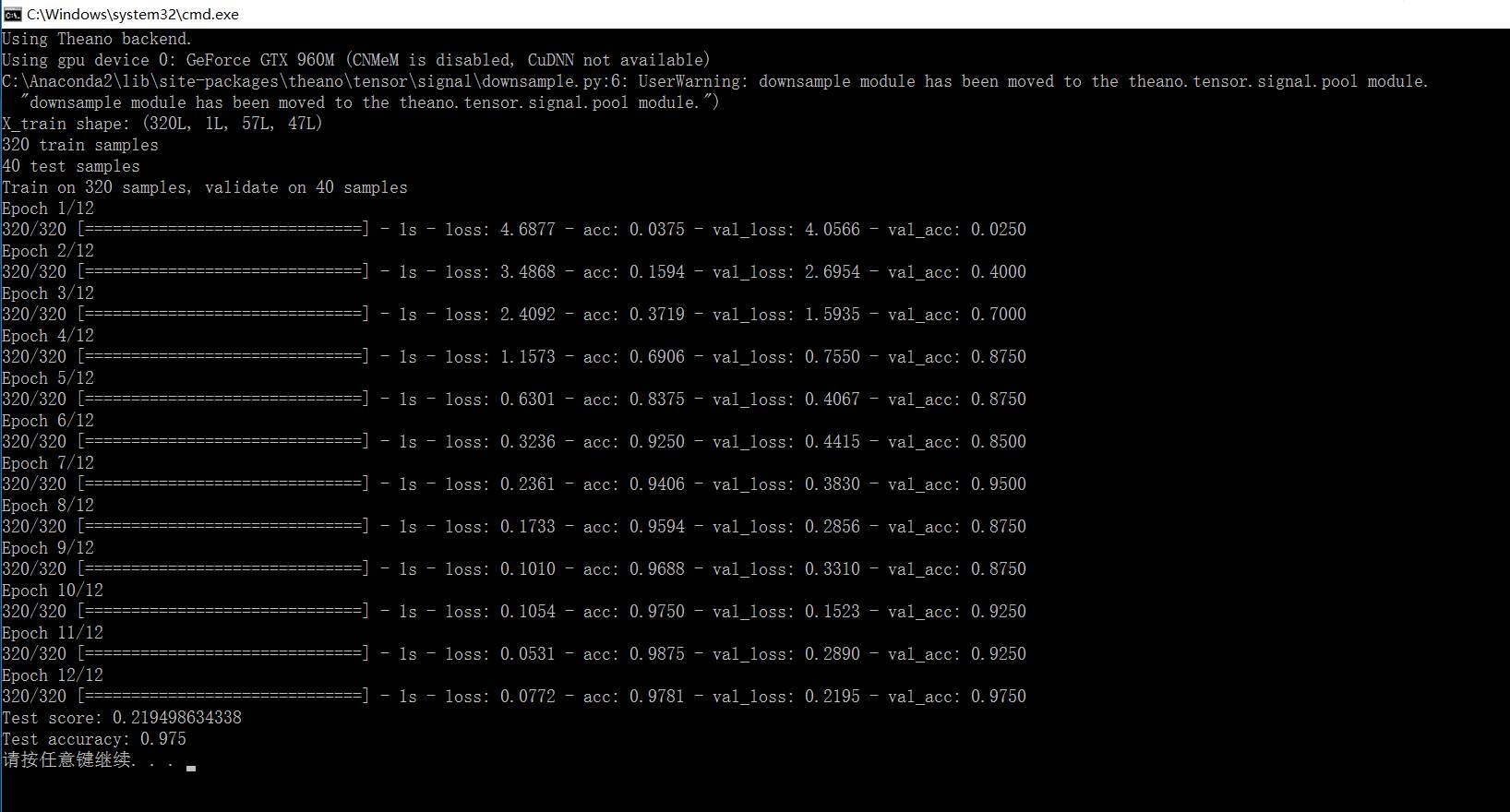

一共有40个类,每个类10个样本,共400个样本。其中320个样本用于训练,40个用于验证,剩下40个测试

注意给第一层指定input_shape,如果是MLP,代码为:

model = Sequential()

# Dense(64) is a fully-connected layer with 64 hidden units.

# in the first layer, you must specify the expected input data shape:

# here, 20-dimensional vectors.

model.add(Dense(64, input_dim=20, init='uniform'))

后面可以不指定Dense的input shape

from __future__ import print_function

import numpy as np

import cPickle

np.random.seed(1337) # for reproducibililty

from keras.datasets import mnist

from keras.models import Sequential

from keras.layers.core import Dense, Dropout, Activation, Flatten

from keras.layers.convolutional import Convolution2D, MaxPooling2D

from keras.utils import np_utils

# split data into train,vavlid and test

# train:320

# valid:40

# test:40

def split_data(fname):

f = open(fname, 'rb')

face_data,face_label = cPickle.load(f)

X_train = np.empty((320, img_rows * img_cols))

Y_train = np.empty(320, dtype=int)

X_valid = np.empty((40, img_rows* img_cols))

Y_valid = np.empty(40, dtype=int)

X_test = np.empty((40, img_rows* img_cols))

Y_test = np.empty(40, dtype=int)

for i in range(40):

X_train[i*8:(i+1)*8,:] = face_data[i*10:i*10+8,:]

Y_train[i*8:(i+1)*8] = face_label[i*10:i*10+8]

X_valid[i] = face_data[i*10+8,:]

Y_valid[i] = face_label[i*10+8]

X_test[i] = face_data[i*10+9,:]

Y_test[i] = face_label[i*10+9]

return (X_train, Y_train, X_valid, Y_valid, X_test, Y_test)

if __name__=='__main__':

batch_size = 10

nb_classes = 40

nb_epoch = 12

# input image dimensions

img_rows, img_cols = 57, 47

# number of convolutional filters to use

nb_filters = 32

# size of pooling area for max pooling

nb_pool = 2

# convolution kernel size

nb_conv = 3

(X_train, Y_train, X_valid, Y_valid, X_test, Y_test) = split_data('G:dataolivettifaces.pkl')

X_train = X_train.reshape(X_train.shape[0], 1, img_rows, img_cols)

X_test = X_test.reshape(X_test.shape[0], 1, img_rows, img_cols)

print('X_train shape:', X_train.shape)

print(X_train.shape[0], 'train samples')

print(X_test.shape[0], 'test samples')

# convert label to binary class matrix

Y_train = np_utils.to_categorical(Y_train, nb_classes)

Y_test = np_utils.to_categorical(Y_test, nb_classes)

model = Sequential()

# 32 convolution filters , the size of convolution kernel is 3 * 3

# border_mode can be 'valid' or 'full'

#‘valid’only apply filter to complete patches of the image.

# 'full' zero-pads image to multiple of filter shape to generate output of shape: image_shape + filter_shape - 1

# when used as the first layer, you should specify the shape of inputs

# the first number means the channel of an input image, 1 stands for grayscale imgs, 3 for RGB imgs

model.add(Convolution2D(nb_filters, nb_conv, nb_conv,

border_mode='valid',

input_shape=(1, img_rows, img_cols)))

# use rectifier linear units : max(0.0, x)

model.add(Activation('relu'))

# second convolution layer with 32 filters of size 3*3

model.add(Convolution2D(nb_filters, nb_conv, nb_conv))

model.add(Activation('relu'))

# max pooling layer, pool size is 2 * 2

model.add(MaxPooling2D(pool_size=(nb_pool, nb_pool)))

# drop out of max-pooling layer , drop out rate is 0.25

model.add(Dropout(0.25))

# flatten inputs from 2d to 1d

model.add(Flatten())

# add fully connected layer with 128 hidden units

model.add(Dense(128))

model.add(Activation('relu'))

model.add(Dropout(0.5))

# output layer with softmax

model.add(Dense(nb_classes))

model.add(Activation('softmax'))

# use cross-entropy cost and adadelta to optimize params

model.compile(loss='categorical_crossentropy', optimizer='adadelta')

# train model with bath_size =10, epoch=12

# set verbose=1 to show train info

model.fit(X_train, Y_train, batch_size=batch_size, nb_epoch=nb_epoch,

show_accuracy=True, verbose=1, validation_data=(X_test, Y_test))

# evaluate on test set

score = model.evaluate(X_test, Y_test, show_accuracy=True, verbose=0)

print('Test score:', score[0])

print('Test accuracy:', score[1])

结果:

准确率有97%

via : http://www.cnblogs.com/wacc/p/5341654.htm

用深度学习keras的cnn做图像识别分类,准确率达97%相关推荐

- 【PyTorch】深度学习实践之CNN高级篇——实现复杂网络

本文目录 1. 串行的网络结构 2. GoogLeNet 2.1 结构分析 2.2 代码实现 2.3 结果 3. ResNet 3.1 网络分析 3.2 代码实现 3.3 结果 课后练习1:阅读并实现 ...

- 深度学习 | MATLAB实现CNN卷积神经网络结构及参数概述

深度学习 | MATLAB实现CNN卷积神经网络结构及参数概述 目录 深度学习 | MATLAB实现CNN卷积神经网络结构及参数概述 基本介绍 模型描述 训练过程 计算函数 参考资料 基本介绍 卷积神 ...

- 利用深度学习(Keras)进行癫痫分类-Python案例

目录 癫痫介绍 数据集 Keras深度学习案例 本分享为脑机学习者Rose整理发表于公众号:脑机接口社区 QQ交流群:903290195 癫痫介绍 癫痫,即俗称"羊癫风",是由多种 ...

- 如何将深度学习与你正在做的事情相结合?

作者 | 李嘉璇 文章来源Gitchat,AI科技大本营合作发布 前言 人工智能是目前各行各业最火热的技术,如果说前两年是『互联网+』,那么这两年一定是『AI+』,利用深度学习的技术,给各行各业赋能, ...

- 深度学习分析--TextCNN算法原理及分类实现

深度学习算法背景 人工智能发展历史 随着算力提高以及深度学习的应用,近几年算法发展很快 应用场景 计算机视觉 用于车牌识别和面部识别等的应用. 信息检索 用于诸如搜索引擎的应用 - 包括文本搜索和图像 ...

- 手把手教程:零基础使用MATLAB完成基于深度学习U-Net模型的遥感影像分类

背景: 很多初入深度学习的学生都会遇到各种环境配置问题,环境搭建不好模型就跑不了,所以这是限制新手的一大难点,MATLAB具有成熟的运行环境,无需配置,这点对于想跑通一个深度学习模型的新手是非常有利的 ...

- 阅读笔记3:基于深度学习的运动想象脑电信号分类算法研究

1.论文信息 题目:基于深度学习的运动想象脑电信号分类算法研究 作者佟歌 单位:哈尔滨工程大学控制科学与工程 发表时间:201803 2.笔记 2.1 脑电信号采集及预处理 2.1.1脑电信号分析方法 ...

- 一文让你完全弄懂逻辑回归和分类问题实战《繁凡的深度学习笔记》第 3 章 分类问题与信息论基础(上)(DL笔记整理系列)

好吧,只好拆分为上下两篇发布了>_< 终于肝出来了,今天就是除夕夜了,祝大家新快乐!^q^ <繁凡的深度学习笔记>第 3 章 分类问题与信息论基础 (上)(逻辑回归.Softm ...

- DeepEye:一个基于深度学习的程序化交易识别与分类方法

DeepEye:一个基于深度学习的程序化交易识别与分类方法 徐广斌,张伟 上海证券交易所资本市场研究所,上海 200120 上海证券交易所产品创新中心,上海 200120 摘要:基于沪市A股交 ...

最新文章

- 【渝粤教育】电大中专Office办公软件 (2)作业 题库

- 【youcans 的 OpenCV 例程 200 篇】105. 湍流模糊退化模型

- 剑指offer:二叉搜索树的第k个结点(中序遍历)

- java窗口小程序atm_简单的小程序实现ATM机操作

- 随笔:《向死而生》---我修的死亡学分

- iOS----创建静态库

- Android修改读写速度,Android 通过adb测试机器读写速度(rk)

- SQL Server报表——小白开发笔记

- 给Java程序猿们推荐一些值得一看的好书

- 《Photoshop CS3专家讲堂视频教程》(个人收集)

- Ubuntu下快速安装jdk、tomcat、mysql和Redis

- linux sed尾行符号,用sed流编辑器处理特殊符号

- 河北源达靠谱吗?股市如战场,可靠的选股软件很关键

- 年已过,新的一年如何过?

- 使用Google时区API显示任何城市的实时本地时间

- Linux入门——1、Linux的安装(Ubuntu)

- Dao,Service,Controller层作用

- 【ol-cesium】OpenLayers与Cesium的二三维联动

- Acer 4750 安装黑苹果_傻瓜式一键黑苹果安装

- FocalLoss原理通俗解释及其二分类和多分类场景下的原理与实现

热门文章

- Linux Deploy:在Android上部署Linux

- 小小知识点(三十七)OFDM和OFDMA的区别以及OFDMA与SC-FDMA的区别

- Python使用逻辑回归提示FutureWarning: Default solver will be changed to ‘lbfgs‘ in 0.22. Specify a solver to

- Scrapy 2.6 Items 数据项定义、加载、传输使用指南

- SyntaxError: (unicode error) ‘utf-8‘ codec can‘t decode byte 0xca in position 0: invalid continuati

- 从键盘输入一个字符串并输出

- 前端 - html2canvas 截图显示空白

- 对于连接Excel时“外部表不是预期的格式”错误的处理

- 怎么用命令远程重启服务器,使用命令行重启Windows服务器的方法

- java画图板之平面山水画(一)