Binary classification - 聊聊评价指标的那些事儿【实战篇】

分类问题就像披着羊皮的狼,看起来天真无害用起来天雷滚滚。比如在建模前你思考过下面的问题么?

- 你的分类模型输出的概率只是用来做样本间的相对排序,还是概率本身?

- 你的训练数据本身分布如何是否存在Imbalanced Sample?

要是您都想到了拜拜?。要是有1各您感兴趣的问题,那就接着往下看吧。本来是想先回顾一下各个分类问题中可能用到的metric,但是又觉得读的人可能觉得无聊,就分成了两章。要是有的指标断片了就来这里回忆一下: 回忆篇

问题1 Rank or Probability?

分类问题可以根据对输出形式的要求分成两类

- 一种我们只关心排序。比如电商场景下,用户是否会回购某商品,我们更关心用户回购商品A的概率是否高于用户回购商品B的概率,然后把回购概率更高的商品放在推荐列表前面。这时分类问题其实是用来排序的。--样本间的相对排序比较比绝对概率更重要

- 另一种我们关心概率。比如现在大家都在谈增长,我们想知道一个用户明天在app活跃的概率,只知道用户A比用户B活跃的概率高并不够,我们需要明确知道用户A活跃的概率,究竟是90%还是50%,这样才能对高/低于特定概率的用户进行一定(促活/唤醒)操作。这时分类问题是对真实概率的估计 --样本的绝对概率需要接近真实概率,并且天极稳定

有人会问,上述两种需求究竟对解决一个二分类问题有什么影响? 答案是损失函数/评价指标

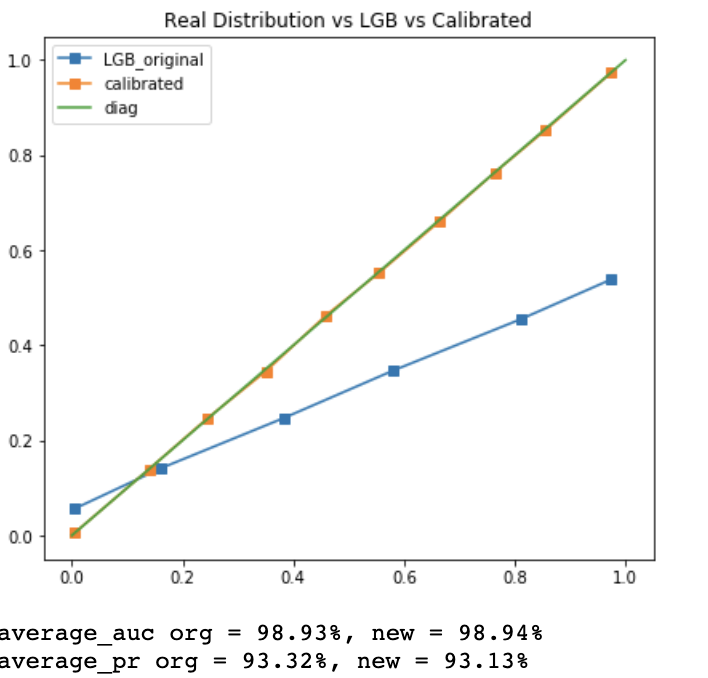

让我们来看一个直观的例子,下图我们尝试用LightGBM解决一个二分类问题,我们选择的拟合指标是最大化AUC。

X轴是预测概率,Y轴是真实概率,蓝线是LGB的预测结果,绿线对应真实概率=预测概率。为什么模型的AUC高达98.93%(这里还有ImbalancedSample的影响,让我们先忽略这一点),但是预测概率和真实概率却差到了姥姥家。

让我们对预测概率再做一层处理,黄线可以简单理解为我们对LGB的预测结果做了一层映射 \(\hat{p} \to f(\hat{p})\),这时校准后的预测概率和真实概率基本一致了。但是有趣的是校准后的预测概率AUC = 98.94%和原始预测基本没差别?!

Duang Duang Duang!敲黑板!AUC是对相对概率排序的检验!其实只要用心(我学AUC的时候一定没用心>_<)看一下AUC的计算方式就会发现,AUC只关心给定各个阈值,把样本按照预测概率分成0/1,并计算正负样本预测的准确率。

举个最夏天的例子,两个瓜一个甜一个不甜,我们训练一个西瓜模型来预测它们甜(1)/不甜(0)。

模型1: 甜的瓜预测概率是0.8,不甜的瓜预测概率是0.1,

模型2: 甜的瓜预测概率是0.51,不甜的瓜预测概率是0.49

两个模型的AUC是相同的,因为它们都完美对两个瓜进行了分类。

所以当使用最大化AUC作为损失函数时,当正负样本的预测准确率不再提高,模型就会停止学习。这时模型的预测概率并不是对真实概率的拟合。那如何才能得到对真实概率的预测? 答案是logloss/cros-entropy

\[ \begin{align} L &= \sum_{i=1}^N y_i * log(p_i) + (1-y_i) *log(1-p_i)\\ \end{align} \]

我们可以从两个角度来理解为什么logloss是对真实概率的估计

从极大似然估计的角度

logloss可以由极大似然函数取对数得到,最小化logloss对应的最大化似然函数。\(p_i\)是对\(p(y_i=1)\)的估计

\[ argmax_p \prod_{i=1}^N {p_i}^{y_i} * {(1-p_i)}^{1-y_i} \]从信息论的角度

不熟悉信息论的同学看这里 Intro to Information Theory

logloss也叫cross-entropy(交叉熵),用来衡量两个分布的相似程度。

交叉熵本身可以分解为P本身的信息熵+分布P和分布q之间的距离。这里P是样本的真实分布信息,信息熵一定。所以最小化交叉熵就变成了最小化分布p和q之间的距离,也就是样本分布和模型估计间的距离,如下

\[ \begin{align} crossentropy &= H(p,q)\\ &= -\sum_{c=1}^C p(c) * log(q(c))\\ & = - \sum_{c=1}^C p(c) * log(p(c)) + \sum_{c=1}^C p(c)[log(p(c) - log(q(c)))] \\ &= H(p) + KL(p||q)\\ \end{align} \]

乍一看会觉得交叉熵和logloss长的不像一家人。因为在训练模型时分布p是从训练样本的分布中抽象得到的。二分类问题中C=2, 让我们把上述交叉熵再推一步

\[ \begin{align} H(p,q) &= p *log(q) + (1-p) *log(1-q) \\ p& = \sum_{i=1}^N I(y_i=1)/N \\ H(p,q) &= \frac{1}{N} \sum_i I(y_i=1) *log(q)+ I(y_i=0) *log(1-q) \\ \end{align} \]

所以下次解决分类问题,如果你的目标是计算对真实概率的估计的话,别选错指标哟�

兴趣卡片- 预测概率校准

其实黄线用了Isotonic Regression来校准预测概率。是一种事后将预测概率根据真实概率进行校准的方法。感兴趣的可以看一下Reference里面的材料1,2。原理并不复杂,但在分析特定算法,尤其是boosting,bagging类的集合算法为什么使用loggloss对概率估计依旧会有偏的部分蛮有趣的

问题2 Imbalanced Sample ?

正负样本分布不均大概是分类问题中最常遇到的问题。正确解决Imbalane问题需要注意的并不只是评价指标,往往还要注意采样和训练集测试集的划分。但这里我们只讨论在解决样本分布不均的问题时,我们应该选择什么指标来评价模型表现。让我们挨个来剔除不好用的指标。

举个极端的例子,100个样本里只有1个正样本

Accuracy

这种情况下即便我们全部预测为负,我们的准确率依旧高达99%。所以Accuracy只适用于正负样本均匀分布的情况,因为它把正负样本的预测准确率柔和在一起看了。

AUC

AUC是fpr和tpr(recall)组成的ROC的曲线下面积。还记得我们在【回忆篇】里面说过fpr,tpr是分别衡量在正负样本上的准确率的。

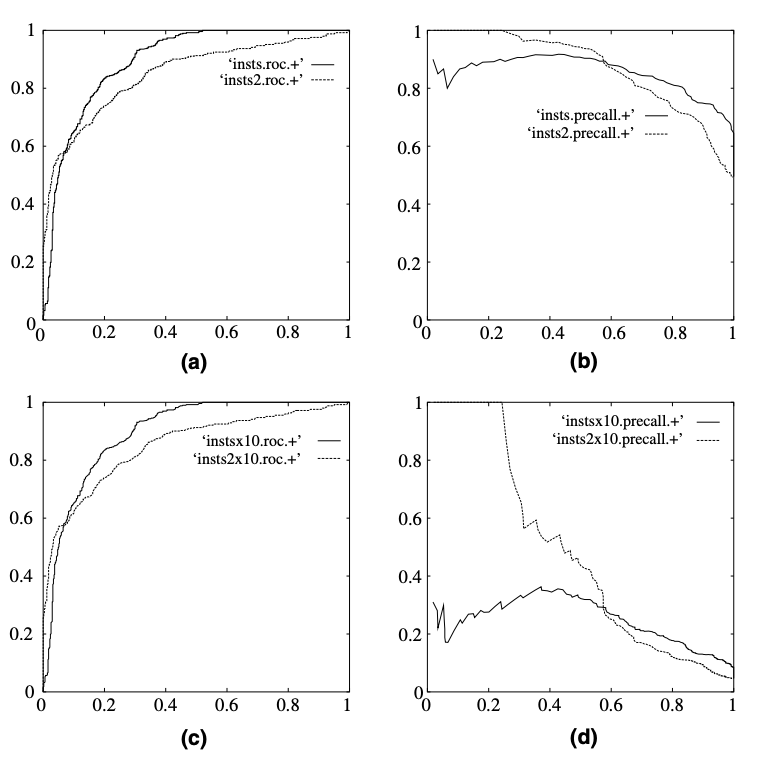

而fpr和tpr之间的trade-off,在正样本占比很小的情况下,这种trad-off会被样本量更大的一方主导。所以当正样本占比很小的时候,AUC往往会看起来过于优秀。

但就像硬币的正反面一样,从另一个角度看这也是AUC的优点,就是AUC本身不会很大的受到样本实际分布的影响,相同的模型相同的样本,你把正样本downsample /upsample 1倍,AUC不会有很大的改变。

下图来自An introduction to ROC analysis, 上面的AUC和PR是正负样本1:1的预测表现,下面是1:10的表现。我们会发现AUC基本没有变化,但是precision-recall发生了剧烈变化。

AP/AUCPR

AP是recall和precision组成的PR的曲线下面积。这里recall和precision分别从真实分布和预测分布两个角度衡量了对正样本的预测准确率。说到这里已经有人反应过来了。是的这一对trade-off指标都是针对正样本的,在计算中没有用到True negative.所以当你的数据集存在Imbalance的时候,AP一般会是更好的选择。

...你还遇到过啥问题嘞?欢迎留言

Reference

- https://www.kaggle.com/residentmaio/notes-on-classification-probability-calibration/

- Pedro G. Fonseca and Hugo D. Lopes. Calibration of Machine Learning Classifiers for Probability of Default Modelling

- https://en.wikipedia.org/wiki/Confusion_matrix

- Tom Fawcett,An introduction to ROC analysis

转载于:https://www.cnblogs.com/gogoSandy/p/11123688.html

Binary classification - 聊聊评价指标的那些事儿【实战篇】相关推荐

- Binary classification - 聊聊评价指标的那些事儿【回忆篇】

在解决分类问题的时候,可以选择的评价指标简直不要太多.但基本可以分成两2大类,我们今分别来说道说道 基于一个概率阈值判断在该阈值下预测的准确率 衡量模型整体表现(在各个阈值下)的评价指标 在说指标之前 ...

- R语言临床预测模型的评价指标与验证指标实战:净重新分类指数NRI(Net Reclassification Index, NRI)

R语言临床预测模型的评价指标与验证指标实战:净重新分类指数NRI(Net Classification Index, NRI) #净重新分类指数NRI

- R语言临床预测模型的评价指标与验证指标实战:综合判别改善指数IDI(Integrated Discrimination Improvement, IDI)

R语言临床预测模型的评价指标与验证指标实战:综合判别改善指数IDI(Integrated Discrimination Improvement, IDI) 目录

- R语言临床预测模型的评价指标与验证指标实战:C-index指标计算

R语言临床预测模型的评价指标与验证指标实战:C-index指标计算 目录 R语言临床预测模型的评价指标与验证指标实战:C-index指标计算

- R语言临床预测模型的评价指标与验证指标实战:自定义的净重新分类指数NRI(Net Reclassification Index, NRI)函数

R语言临床预测模型的评价指标与验证指标实战:自定义的净重新分类指数NRI(Net Reclassification Index, NRI)函数 目录

- R语言临床预测模型的评价指标与验证指标实战:自定义的综合判别改善指标(Integrated Discrimination Improvement, IDI)函数

R语言临床预测模型的评价指标与验证指标实战:自定义的综合判别改善指标(Integrated Discrimination Improvement, IDI)函数 目录

- wsl ubuntu拒绝访问_一起聊聊WSL的那些事儿(下)

前文回顾:一起聊聊WSL的那些事儿(上) 文件系统 在WSL这个feature刚出来的时候,很多人都抢着装上了这个特性,包括笔者的同学们都争先恐后的体验这个特性,不过最后都成了黑子,因为大家发现Fil ...

- Keras-6 IMDB, a binary classification example

Classifying movie reviews: IMDB, a binary classification example 这个例子整理自<Deep Learning with Pytho ...

- 人脸验证与二分类(Face verification and binary classification)

来源:Coursera吴恩达深度学习课程 听着五月天的<仓颉>,五月的每一天都是五月天. 三元组损失(Triplet loss)是一个学习人脸识别卷积网络参数的好方法,还有其他学习参数的方 ...

最新文章

- matlab 台风数据插值,matlab画台风轨迹图小tip

- python文件的后缀名-python文件后缀是什么

- nRF5 SDK for Mesh(一) 介绍和下载源码

- 是vans_硬核复刻,就服VANS棋盘格

- hive 导出json格式 文件_hive中创建hive-json格式的表及查询

- 在Window10下基于Anaconda安装Tensorflow以及Keras并基于Spyder进行验证

- C++函数重载与引用的较好的练习实例

- 视频画中画效果,拖动进度条可以seek到相应视频帧显示

- java substring 实例_JAVA中截取字符串substring用法

- linux那条命令可以装中文,Linux下的中文显示和支持常见问题解答

- NCBI基本引物设计、(初学者)

- 数字图像处理实验六--图像复原

- flink-sqlclient报错

- 老泪纵横!伴随数代人成长的中国经典动画

- 集合、群、环、域、空间简介

- 27、什么是DOM和BOM

- [Unity Mirror] 自定义角色生成

- 支付宝信用卡还款攻略:这样操作仍可以免手续费!

- echarts问题整理之多条基准线设置

- Latex编辑数学符号和希腊字母的方法

热门文章

- 求矩形中心点坐标编程c语言,c语言编程序求矩形面积 我是新手,很多不懂,初学...

- 链表游戏:CVE-2017-10661之完全利用

- Android Gradle Plugin 源码阅读与编译

- Hyperledger Fabric 1.0 实战开发系列 第一课 系统环境搭建

- 带通 带阻滤波器 幅频响应_二阶有源带通滤波器设计

- JZOJ 5602. 【NOI2018模拟3.26】Cti JZOJ 5057. 【GDSOI2017模拟4.13】炮塔

- mathematica 可编辑pdf_Mathematica学习笔记[1]

- 算法解读--递归(二)

- 电脑组装与维护教程_小白不会装机?教你如何自己组装一台电脑。装机图文教程...

- 2020-07-01 CVPR2020 表示学习论文讨论(2) 笔记