利用Hog特征和SVM分类器进行行人检测

1、HOG特征:

方向梯度直方图(Histogram of Oriented Gradient, HOG)特征是一种在计算机视觉和图像处理中用来进行物体检测的特征描述子。它通过计算和统计图像局部区域的梯度方向直方图来构成特征。Hog特征结合SVM分类器已经被广泛应用于图像识别中,尤其在行人检测中获得了极大的成功。需要提醒的是,HOG+SVM进行行人检测的方法是法国研究人员Dalal在2005的CVPR上提出的,而如今虽然有很多行人检测算法不断提出,但基本都是以HOG+SVM的思路为主。

(1)主要思想:

在一副图像中,局部目标的表象和形状(appearance and shape)能够被梯度或边缘的方向密度分布很好地描述。(本质:梯度的统计信息,而梯度主要存在于边缘的地方)。

(2)具体的实现方法是:

首先将图像分成小的连通区域,我们把它叫细胞单元。然后采集细胞单元中各像素点的梯度的或边缘的方向直方图。最后把这些直方图组合起来就可以构成特征描述器。

(3)提高性能:

把这些局部直方图在图像的更大的范围内(我们把它叫区间或block)进行对比度归一化(contrast-normalized),所采用的方法是:先计算各直方图在这个区间(block)中的密度,然后根据这个密度对区间中的各个细胞单元做归一化。通过这个归一化后,能对光照变化和阴影获得更好的效果。

(4)优点:

与其他的特征描述方法相比,HOG有很多优点。首先,由于HOG是在图像的局部方格单元上操作,所以它对图像几何的和光学的形变都能保持很好的不变性,这两种形变只会出现在更大的空间领域上。其次,在粗的空域抽样、精细的方向抽样以及较强的局部光学归一化等条件下,只要行人大体上能够保持直立的姿势,可以容许行人有一些细微的肢体动作,这些细微的动作可以被忽略而不影响检测效果。因此HOG特征是特别适合于做图像中的人体检测的。

2、HOG特征提取算法的实现过程:

大概过程:

HOG特征提取方法就是将一个image(你要检测的目标或者扫描窗口):

1)灰度化(将图像看做一个x,y,z(灰度)的三维图像);

2)采用Gamma校正法对输入图像进行颜色空间的标准化(归一化);目的是调节图像的对比度,降低图像局部的阴影和光照变化所造成的影响,同时可以抑制噪音的干扰;

3)计算图像每个像素的梯度(包括大小和方向);主要是为了捕获轮廓信息,同时进一步弱化光照的干扰。

4)将图像划分成小cells(例如6*6像素/cell);

5)统计每个cell的梯度直方图(不同梯度的个数),即可形成每个cell的descriptor;

6)将每几个cell组成一个block(例如3*3个cell/block),一个block内所有cell的特征descriptor串联起来便得到该block的HOG特征descriptor。

7)将图像image内的所有block的HOG特征descriptor串联起来就可以得到该image(你要检测的目标)的HOG特征descriptor了。这个就是最终的可供分类使用的特征向量了。

具体每一步的详细过程如下:

(1)标准化gamma空间和颜色空间

为了减少光照因素的影响,首先需要将整个图像进行规范化(归一化)。在图像的纹理强度中,局部的表层曝光贡献的比重较大,所以,这种压缩处理能够有效地降低图像局部的阴影和光照变化。因为颜色信息作用不大,通常先转化为灰度图;

Gamma压缩公式:

比如可以取Gamma=1/2;

(2)计算图像梯度

计算图像横坐标和纵坐标方向的梯度,并据此计算每个像素位置的梯度方向值;求导操作不仅能够捕获轮廓,人影和一些纹理信息,还能进一步弱化光照的影响。

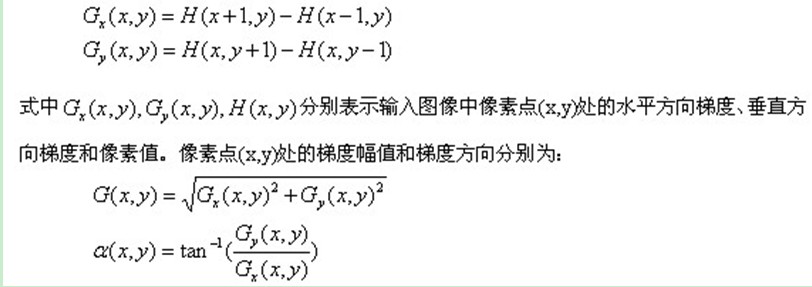

图像中像素点(x,y)的梯度为:

最常用的方法是:首先用[-1,0,1]梯度算子对原图像做卷积运算,得到x方向(水平方向,以向右为正方向)的梯度分量gradscalx,然后用[1,0,-1]T梯度算子对原图像做卷积运算,得到y方向(竖直方向,以向上为正方向)的梯度分量gradscaly。然后再用以上公式计算该像素点的梯度大小和方向。

(3)为每个细胞单元构建梯度方向直方图

第三步的目的是为局部图像区域提供一个编码,同时能够保持对图像中人体对象的姿势和外观的弱敏感性。

我们将图像分成若干个“单元格cell”,例如每个cell为6*6个像素。假设我们采用9个bin的直方图来统计这6*6个像素的梯度信息。也就是将cell的梯度方向360度分成9个方向块,如图所示:例如:如果这个像素的梯度方向是20-40度,直方图第2个bin的计数就加一,这样,对cell内每个像素用梯度方向在直方图中进行加权投影(映射到固定的角度范围),就可以得到这个cell的梯度方向直方图了,就是该cell对应的9维特征向量(因为有9个bin)。

像素梯度方向用到了,那么梯度大小呢?梯度大小就是作为投影的权值的。例如说:这个像素的梯度方向是20-40度,然后它的梯度大小是2(假设啊),那么直方图第2个bin的计数就不是加一了,而是加二(假设啊)。

细胞单元可以是矩形的(rectangular),也可以是星形的(radial)。

(4)把细胞单元组合成大的块(block),块内归一化梯度直方图

由于局部光照的变化以及前景-背景对比度的变化,使得梯度强度的变化范围非常大。这就需要对梯度强度做归一化。归一化能够进一步地对光照、阴影和边缘进行压缩。

作者采取的办法是:把各个细胞单元组合成大的、空间上连通的区间(blocks)。这样,一个block内所有cell的特征向量串联起来便得到该block的HOG特征。这些区间是互有重叠的,这就意味着:每一个单元格的特征会以不同的结果多次出现在最后的特征向量中。我们将归一化之后的块描述符(向量)就称之为HOG描述符。

区间有两个主要的几何形状——矩形区间(R-HOG)和环形区间(C-HOG)。R-HOG区间大体上是一些方形的格子,它可以有三个参数来表征:每个区间中细胞单元的数目、每个细胞单元中像素点的数目、每个细胞的直方图通道数目。

例如:行人检测的最佳参数设置是:3×3细胞/区间、6×6像素/细胞、9个直方图通道。则一块的特征数为:3*3*9;

(5)收集HOG特征

最后一步就是将检测窗口中所有重叠的块进行HOG特征的收集,并将它们结合成最终的特征向量供分类使用。

(6)那么一个图像的HOG特征维数是多少呢?

顺便做个总结:Dalal提出的Hog特征提取的过程:把样本图像分割为若干个像素的单元(cell),把梯度方向平均划分为9个区间(bin),在每个单元里面对所有像素的梯度方向在各个方向区间进行直方图统计,得到一个9维的特征向量,每相邻的4个单元构成一个块(block),把一个块内的特征向量联起来得到36维的特征向量,用块对样本图像进行扫描,扫描步长为一个单元。最后将所有块的特征串联起来,就得到了人体的特征。例如,对于64*128的图像而言,每8*8的像素组成一个cell,每2*2个cell组成一个块,因为每个cell有9个特征,所以每个块内有4*9=36个特征,以8个像素为步长,那么,水平方向将有7个扫描窗口,垂直方向将有15个扫描窗口。也就是说,64*128的图片,总共有36*7*15=3780个特征。

HOG维数,16×16像素组成的block,8x8像素的cell

注释:

行人检测HOG+SVM

总体思路:

1、提取正负样本hog特征

2、投入svm分类器训练,得到model

3、由model生成检测子

4、利用检测子检测负样本,得到hardexample

5、提取hardexample的hog特征并结合第一步中的特征一起投入训练,得到最终检测子。

深入研究hog算法原理:

一、hog概述

hog是05年一位nb的博士提出来的,论文链接 http://wenku.baidu.com/view/676f2351f01dc281e53af0b2.html

终于到10月了,终于可以松一口气了,整理一下hog的算法流程。

之前介绍过Hog特征(http://blog.csdn.net/carson2005/article/details/7782726),也介绍过SVM分类器(http://blog.csdn.net/carson2005/article/details/6453502 );而本文的目的在于介绍利用Hog特征和SVM分类器来进行行人检测。

在2005年CVPR上,来自法国的研究人员Navneet Dalal 和Bill Triggs提出利用Hog进行特征提取,利用线性SVM作为分类器,从而实现行人检测。而这两位也通过大量的测试发现,Hog+SVM是速度和效果综合平衡性能较好的一种行人检测方法。后来,虽然很多研究人员也提出了很多改进的行人检测算法,但基本都以该算法为基础框架。因此,Hog+SVM也成为一个里程表式的算法被写入到OpenCV中。在OpenCV2.0之后的版本,都有Hog特征描述算子的API,而至于SVM,早在OpenCV1.0版本就已经集成进去了;OpenCV虽然提供了Hog和SVM的API,也提供了行人检测的sample,遗憾的是,OpenCV并没有提供样本训练的sample。这也就意味着,很多人只能用OpenCV自带的已经训练好的分类器来进行行人检测。然而,OpenCV自带的分类器是利用Navneet Dalal和Bill Triggs提供的样本进行训练的,不见得能适用于你的应用场合。因此,针对你的特定应用场景,很有必要进行重新训练得到适合你的分类器。本文的目的,正在于此。

重新训练行人检测的流程:

(1)准备训练样本集合;包括正样本集和负样本集;根据机器学习的基础知识我们知道,要利用机器学习算法进行样本训练,从而得到一个性能优良的分类器,训练样本应该是无限多的,而且训练样本应该覆盖实际应用过程中可能发生的各种情况。(很多朋友,用10来个正样本,10来个负样本进行训练,之后,就进行测试,发现效果没有想象中的那么好,就开始发牢骚,抱怨。。。对于这些人,我只能抱歉的说,对于机器学习、模式识别的认识,你还处于没有入门的阶段);实际应用过程中,训练样本不可能无限多,但无论如何,三五千个正样本,三五千个负样本,应该不是什么难事吧?(如果连这个都做不到,建议你别搞机器学习,模式识别了;训练素材都没有,怎么让机器学习到足够的信息呢?)

(2)收集到足够的训练样本之后,你需要手动裁剪样本。例如,你想用Hog+SVM来对商业步行街的监控画面中进行行人检测,那么,你就应该用收集到的训练样本集合,手动裁剪画面中的行人(可以写个简单程序,只需要鼠标框选一下,就将框选区域保存下来)。

(3)裁剪得到训练样本之后,将所有正样本放在一个文件夹中;将所有负样本放在另一个文件夹中;并将所有训练样本缩放到同样的尺寸大小。OpenCV自带的例子在训练时,就是将样本缩放为64*128进行训练的;

(4)提取所有正样本的Hog特征;

(5)提取所有负样本的Hog特征;

(6)对所有正负样本赋予样本标签;例如,所有正样本标记为1,所有负样本标记为0;

(7)将正负样本的Hog特征,正负样本的标签,都输入到SVM中进行训练;Dalal在论文中考虑到速度问题,建议采用线性SVM进行训练。这里,不妨也采用线性SVM;

(8)SVM训练之后,将结果保存为文本文件。

(9)线性SVM进行训练之后得到的文本文件里面,有一个数组,叫做support vector,还有一个数组,叫做alpha,有一个浮点数,叫做rho;将alpha矩阵同support vector相乘,注意,alpha*supportVector,将得到一个列向量。之后,再该列向量的最后添加一个元素rho。如此,变得到了一个分类器,利用该分类器,直接替换opencv中行人检测默认的那个分类器(cv::HOGDescriptor::setSVMDetector()),就可以利用你的训练样本训练出来的分类器进行行人检测了。

下面给出样本训练的参考代码:

- class Mysvm: public CvSVM

- {

- public:

- int get_alpha_count()

- {

- return this->sv_total;

- }

- int get_sv_dim()

- {

- return this->var_all;

- }

- int get_sv_count()

- {

- return this->decision_func->sv_count;

- }

- double* get_alpha()

- {

- return this->decision_func->alpha;

- }

- float** get_sv()

- {

- return this->sv;

- }

- float get_rho()

- {

- return this->decision_func->rho;

- }

- };

- void Train()

- {

- char classifierSavePath[256] = "c:/pedestrianDetect-peopleFlow.txt";

- string positivePath = "E:\\pictures\\train1\\pos\\";

- string negativePath = "E:\\pictures\\train1\\neg\\";

- int positiveSampleCount = 4900;

- int negativeSampleCount = 6192;

- int totalSampleCount = positiveSampleCount + negativeSampleCount;

- cout<<"//"<<endl;

- cout<<"totalSampleCount: "<<totalSampleCount<<endl;

- cout<<"positiveSampleCount: "<<positiveSampleCount<<endl;

- cout<<"negativeSampleCount: "<<negativeSampleCount<<endl;

- CvMat *sampleFeaturesMat = cvCreateMat(totalSampleCount , 1764, CV_32FC1);

- //64*128的训练样本,该矩阵将是totalSample*3780,64*64的训练样本,该矩阵将是totalSample*1764

- cvSetZero(sampleFeaturesMat);

- CvMat *sampleLabelMat = cvCreateMat(totalSampleCount, 1, CV_32FC1);//样本标识

- cvSetZero(sampleLabelMat);

- cout<<"************************************************************"<<endl;

- cout<<"start to training positive samples..."<<endl;

- char positiveImgName[256];

- string path;

- for(int i=0; i<positiveSampleCount; i++)

- {

- memset(positiveImgName, '\0', 256*sizeof(char));

- sprintf(positiveImgName, "%d.jpg", i);

- int len = strlen(positiveImgName);

- string tempStr = positiveImgName;

- path = positivePath + tempStr;

- cv::Mat img = cv::imread(path);

- if( img.data == NULL )

- {

- cout<<"positive image sample load error: "<<i<<" "<<path<<endl;

- system("pause");

- continue;

- }

- cv::HOGDescriptor hog(cv::Size(64,64), cv::Size(16,16), cv::Size(8,8), cv::Size(8,8), 9);

- vector<float> featureVec;

- hog.compute(img, featureVec, cv::Size(8,8));

- int featureVecSize = featureVec.size();

- for (int j=0; j<featureVecSize; j++)

- {

- CV_MAT_ELEM( *sampleFeaturesMat, float, i, j ) = featureVec[j];

- }

- sampleLabelMat->data.fl[i] = 1;

- }

- cout<<"end of training for positive samples..."<<endl;

- cout<<"*********************************************************"<<endl;

- cout<<"start to train negative samples..."<<endl;

- char negativeImgName[256];

- for (int i=0; i<negativeSampleCount; i++)

- {

- memset(negativeImgName, '\0', 256*sizeof(char));

- sprintf(negativeImgName, "%d.jpg", i);

- path = negativePath + negativeImgName;

- cv::Mat img = cv::imread(path);

- if(img.data == NULL)

- {

- cout<<"negative image sample load error: "<<path<<endl;

- continue;

- }

- cv::HOGDescriptor hog(cv::Size(64,64), cv::Size(16,16), cv::Size(8,8), cv::Size(8,8), 9);

- vector<float> featureVec;

- hog.compute(img,featureVec,cv::Size(8,8));//计算HOG特征

- int featureVecSize = featureVec.size();

- for ( int j=0; j<featureVecSize; j ++)

- {

- CV_MAT_ELEM( *sampleFeaturesMat, float, i + positiveSampleCount, j ) = featureVec[ j ];

- }

- sampleLabelMat->data.fl[ i + positiveSampleCount ] = -1;

- }

- cout<<"end of training for negative samples..."<<endl;

- cout<<"********************************************************"<<endl;

- cout<<"start to train for SVM classifier..."<<endl;

- CvSVMParams params;

- params.svm_type = CvSVM::C_SVC;

- params.kernel_type = CvSVM::LINEAR;

- params.term_crit = cvTermCriteria(CV_TERMCRIT_ITER, 1000, FLT_EPSILON);

- params.C = 0.01;

- Mysvm svm;

- svm.train( sampleFeaturesMat, sampleLabelMat, NULL, NULL, params ); //用SVM线性分类器训练

- svm.save(classifierSavePath);

- cvReleaseMat(&sampleFeaturesMat);

- cvReleaseMat(&sampleLabelMat);

- int supportVectorSize = svm.get_support_vector_count();

- cout<<"support vector size of SVM:"<<supportVectorSize<<endl;

- cout<<"************************ end of training for SVM ******************"<<endl;

- CvMat *sv,*alp,*re;//所有样本特征向量

- sv = cvCreateMat(supportVectorSize , 1764, CV_32FC1);

- alp = cvCreateMat(1 , supportVectorSize, CV_32FC1);

- re = cvCreateMat(1 , 1764, CV_32FC1);

- CvMat *res = cvCreateMat(1 , 1, CV_32FC1);

- cvSetZero(sv);

- cvSetZero(re);

- for(int i=0; i<supportVectorSize; i++)

- {

- memcpy( (float*)(sv->data.fl+i*1764), svm.get_support_vector(i), 1764*sizeof(float));

- }

- double* alphaArr = svm.get_alpha();

- int alphaCount = svm.get_alpha_count();

- for(int i=0; i<supportVectorSize; i++)

- {

- alp->data.fl[i] = alphaArr[i];

- }

- cvMatMul(alp, sv, re);

- int posCount = 0;

- for (int i=0; i<1764; i++)

- {

- re->data.fl[i] *= -1;

- }

- FILE* fp = fopen("c:/hogSVMDetector-peopleFlow.txt","wb");

- if( NULL == fp )

- {

- return 1;

- }

- for(int i=0; i<1764; i++)

- {

- fprintf(fp,"%f \n",re->data.fl[i]);

- }

- float rho = svm.get_rho();

- fprintf(fp, "%f", rho);

- cout<<"c:/hogSVMDetector.txt 保存完毕"<<endl;//保存HOG能识别的分类器

- fclose(fp);

- return 1;

- }

接着,再给出利用训练好的分类器进行行人检测的参考代码:

- void Detect()

- {

- CvCapture* cap = cvCreateFileCapture("E:\\02.avi");

- if (!cap)

- {

- cout<<"avi file load error..."<<endl;

- system("pause");

- exit(-1);

- }

- vector<float> x;

- ifstream fileIn("c:/hogSVMDetector-peopleFlow.txt", ios::in);

- float val = 0.0f;

- while(!fileIn.eof())

- {

- fileIn>>val;

- x.push_back(val);

- }

- fileIn.close();

- vector<cv::Rect> found;

- cv::HOGDescriptor hog(cv::Size(64,64), cv::Size(16,16), cv::Size(8,8), cv::Size(8,8), 9);

- hog.setSVMDetector(x);

- IplImage* img = NULL;

- cvNamedWindow("img", 0);

- while(img=cvQueryFrame(cap))

- {

- hog.detectMultiScale(img, found, 0, cv::Size(8,8), cv::Size(32,32), 1.05, 2);

- if (found.size() > 0)

- {

- for (int i=0; i<found.size(); i++)

- {

- CvRect tempRect = cvRect(found[i].x, found[i].y, found[i].width, found[i].height);

- cvRectangle(img, cvPoint(tempRect.x,tempRect.y),

- cvPoint(tempRect.x+tempRect.width,tempRect.y+tempRect.height),CV_RGB(255,0,0), 2);

- }

- }

- }

- cvReleaseCapture(&cap);

- }

利用Hog特征和SVM分类器进行行人检测相关推荐

- 基于HSV+HOG特征和SVM的人脸口罩检测算法

基于HSV+HOG特征和SVM的人脸口罩检测算法 基于python语言编写,使用retinaface检测人脸和定位五个特征点,利用特征点进一步定位口鼻区域,提取该区域的HSV特征和HOG特征,使用SV ...

- HOG人体特征提取+SVM分类器训练进行人体检测

1.HOG特征: 方向梯度直方图(Histogram of Oriented Gradient, HOG)特征是一种在计算机视觉和图像处理中用来进行物体检测的特征描述子.它通过计算和统计图像局部区域的 ...

- 利用HOG特征进行人体检测--简述

1.HOG特征: 方向梯度直方图(Histogram of Oriented Gradient, HOG)特征是一种在计算机视觉和图像处理中用来进行物体检测的特征描述子.它通过计算和统计图像局部区域的 ...

- OpenCV对图片数据集提取HOG特征并用SVM进行识别

OpenCV对图片数据集提取HOG特征并用SVM进行识别 代码编程环境 设置图片大小源代码 提取HOG源代码 SVM识别源代码 实验结果 代码编程环境 Windows系统: OpenCV3.4.1: ...

- OpenCV中基于Haar特征和级联分类器的人脸检测

使用机器学习的方法进行人脸检测的第一步需要训练人脸分类器,这是一个耗时耗力的过程,需要收集大量的正负样本,并且样本质量的好坏对结果影响巨大,如果样本没有处理好,再优秀的机器学习分类算法都是零. 今年3 ...

- OpenCV中基于Haar特征和级联分类器的人脸检测(三)

使用机器学习的方法进行人脸检测的第一步需要训练人脸分类器,这是一个耗时耗力的过程,需要收集大量的正负样本,并且样本质量的好坏对结果影响巨大,如果样本没有处理好,再优秀的机器学习分类算法都是零. 今年3 ...

- OpenCV3特征提取与目标检测之HOG(二)——使用官方的行人分类器实现行人检测

一.概述 前面看到如何使用HOG去提取一张图像的中的局部目标的特征,那么得到了这些特征之后,用来做什么,OpencCV的官方给了一个使用HOG进行行人检测的样例.所加载的分类器是官方已经训练好的,而O ...

- VS+Opencv3.3下用HOG+SVM实现INRIA行人检测

利用SVM训练一个分类器,用训练好的分类器对测试集里的数据进行检测. 这里是数据下载地址:INRIA行人数据集 点击页面下方的蓝色here即可下载. 下载完成之后,解压缩(为方便操作,建议放于项目目录 ...

- VS2017+Opencv4.2.0 用HOG+SVM实现INRIA行人检测 报错[ INFO:0] global

按照网上的代码用svm训练分类器 结果报错 [ INFO:0] global C:\build\master_winpack-build-win64-vc14\opencv\modules\core\ ...

最新文章

- C#中一些易混知识的比较

- 怎样在设计中添加FIFO宏模块

- Git 中 SSH key 生成步骤

- SAP UI5 oList.bindAggregation(item) will trigger odata request

- git reset后本地拉取_一份值得收藏的 Git 异常处理清单

- WPF开源项目:AIStudio.Wpf.AClient

- [蓝桥杯][算法提高VIP]扫雷-枚举

- 你胆敢在case后面不加break试试?

- 小米答题题库_拼多多果园答题题库74(每日更新)

- java像sql一样处理数据_像Excel一样使用SQL进行数据分析

- 如何在TypeScript/JavaScript项目里引入MD5校验和

- NPOI导出Excel示例

- 数学建模十大经典算法和常用算法

- 移动页面常用media尺寸

- Heterogeneous Graph Attention Network翻译

- 人工智能(7)---一文读懂人脸识别技术:商业应用、产品落地、核心技术、市场规模

- 吉林市一日游规格说明书

- 量子计算深化:大规模量子计算(相关论文108篇推荐)

- DM7.0在VM-中标麒麟NeoKylin虚拟机上安装

- Go设计模式--访客模式